Pandas之drop_duplicates:去除重复项方法

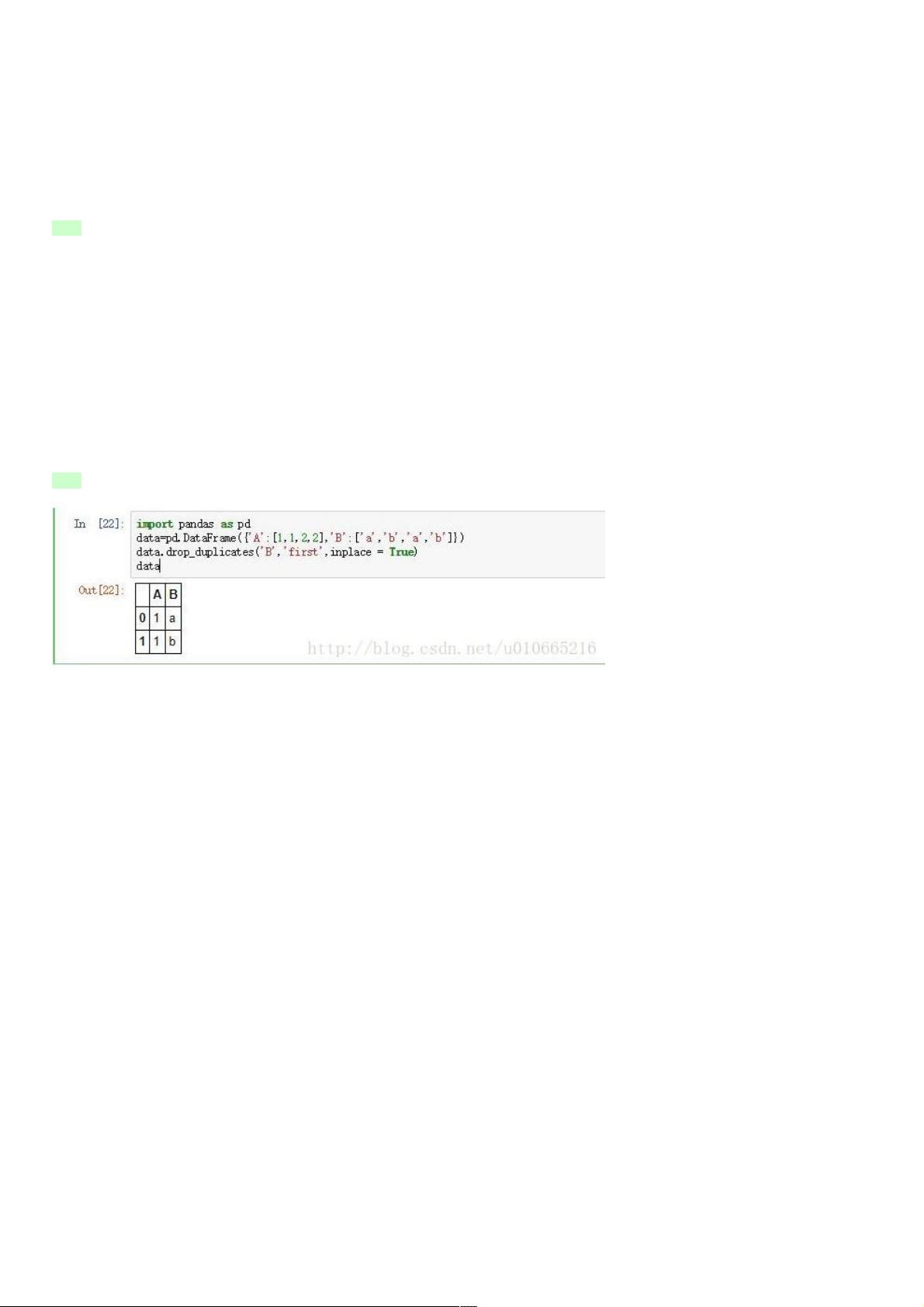

在数据分析和处理中,去除重复数据是常见的需求之一。Pandas库提供了非常方便的方法来帮助我们清除数据集中的重复项。在本次分享中,我们将详细探讨Pandas库中的`drop_duplicates`方法,以及它的应用场景和重要参数。 `drop_duplicates`方法是专为`DataFrame`格式的数据设计的,它允许我们从数据集中移除那些重复的行。该方法之所以重要,是因为重复数据会干扰数据分析的结果,比如在计算统计指标时会导致结果偏大。 `drop_duplicates`方法的一般形式为: ```python DataFrame.drop_duplicates(subset=None, keep='first', inplace=False) ``` 接下来,我们来逐一分析这个方法的关键参数。 `subset`参数是可选的,它指定了一个列名或者列名的序列,用于识别哪些列组合下的行是重复的。如果不指定,那么默认是所有列都被考虑。在一些情况下,我们可能只关心某几个字段的重复性,这时可以使用`subset`参数来指定这些列,从而实现基于特定列的去重操作。 `keep`参数用于控制在发现重复行时,要保留哪些行。它有三个可选值:`'first'`、`'last'`和`False`。`'first'`表示保留第一次出现的行,而后续的重复行则会被删除;`'last'`则是保留最后一次出现的行,其余重复的行会被移除;如果参数设置为`False`,则所有的重复行都会被移除,只保留唯一的行。 `inplace`参数是一个布尔值,默认为`False`。它决定了是直接在原数据集上进行修改,还是返回一个新的数据集(副本),而原数据集保持不变。当`inplace=False`时,方法会返回一个新的去重后的`DataFrame`,而原始的`DataFrame`不会受到影响;而当`inplace=True`时,则会直接修改原始的`DataFrame`。 在实践中,`drop_duplicates`方法的典型使用场景包括: 1. 数据清洗阶段:在数据预处理过程中,经常需要检查并去除数据中的重复行。这有助于确保后续分析的准确性。 2. 数据整合阶段:在合并多个数据集时,可能会产生重复的记录。通过`drop_duplicates`方法可以清理这些重复的记录,避免在数据分析时产生误差。 3. 在数据更新过程中:例如,在数据仓库中,当新数据覆盖旧数据时,有时会出现某些数据行被重复插入的情况。在这种情况下,可以使用`drop_duplicates`来去除重复项,保持数据的一致性。 为了更好地理解和运用`drop_duplicates`方法,我们可以举一个简单的例子: ```python import pandas as pd # 创建一个包含重复行的DataFrame df = pd.DataFrame({ 'A': [1, 1, 2, 2, 3], 'B': [4, 4, 5, 5, 6] }) # 使用drop_duplicates方法去重,默认保留第一次出现的行 df_unique = df.drop_duplicates() print(df_unique) ``` 输出结果将是: ``` A B *** *** *** ``` 通过这个例子可以看到,`drop_duplicates`方法去除了重复的行,只保留了第一次出现的行。 总结一下,Pandas的`drop_duplicates`方法是处理DataFrame中重复数据的强大工具。通过合理使用`subset`、`keep`和`inplace`参数,我们可以有效地对数据集进行去重处理,为数据分析提供准确可靠的数据基础。希望本次分享对大家在使用Pandas库时去除重复项方面有所帮助。

- 粉丝: 5

- 资源: 891

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 塑料检测23-YOLO(v5至v11)、COCO、CreateML、Paligemma、TFRecord、VOC数据集合集.rar

- Python圣诞节倒计时与节日活动管理系统

- 数据结构之哈希查找方法

- 系统DLL文件修复工具

- 塑料、玻璃、金属、纸张、木材检测36-YOLO(v5至v11)、COCO、CreateML、Paligemma、TFRecord、VOC数据集合集.rar

- Python新年庆典倒计时与节日活动智能管理助手

- Nosql期末复习资料

- 数据结构排序算法:插入排序、希尔排序、冒泡排序及快速排序算法

- 2011-2024年各省数字普惠金融指数数据.zip

- 计算机程序设计员三级(选择题)

信息提交成功

信息提交成功

- 1

- 2

前往页