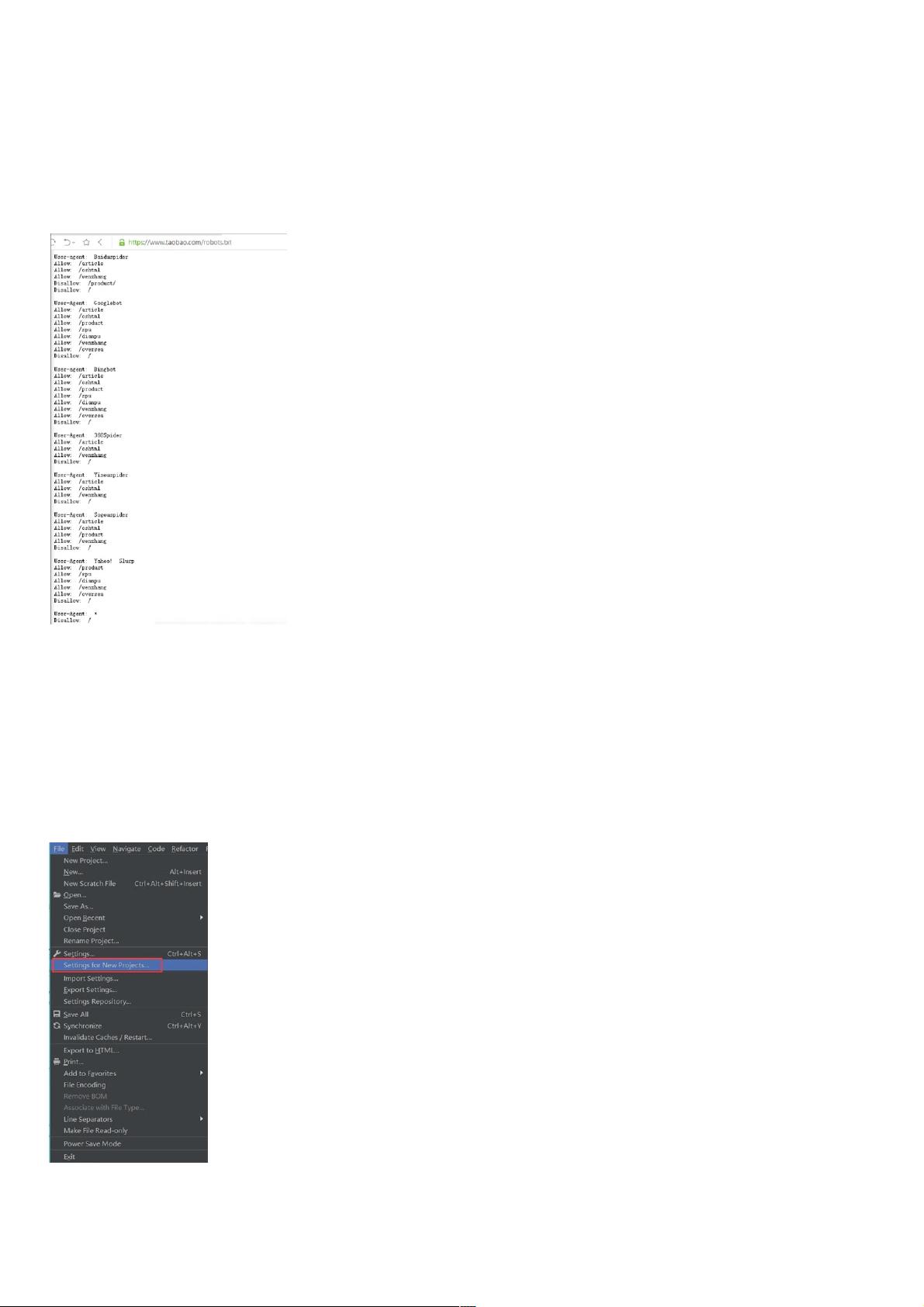

一、为什么使用Python进行网络爬虫? 由于Python语言十分简洁,使用起来又非常简单、易学,通过Python 进行编写就像使用英语进行写作一样。另外Python 在使用中十分方便,并不需要IDE,而仅仅通过sublime text 就能够对大部分的中小应用进行开发;除此之外Python 爬虫的框架功能十分强大,它的框架能够对网络数据进行爬取,还能对结构性的数据进行提取,经常用在数据的挖掘、历史数据的存储和信息的处理等程序内;Python网络的支持库和html的解析器功能十分强大,借助网络的支持库通过较少代码的编写,就能够进行网页的下载,且通过网页的解析库就能够对网页内各标签进行解析,和正 Python作为一门简洁、易学的语言,是网络爬虫领域的热门选择。其强大的框架,如Scrapy,使得数据抓取和处理变得高效。Python的网络支持库(如urllib和requests)和HTML解析器(如BeautifulSoup和lxml)使得开发者能够轻松地下载网页并解析其中的结构化数据。在编写爬虫时,往往不需要复杂的集成开发环境(IDE),简单的文本编辑器如Sublime Text就能胜任大部分工作。 在进行网络爬虫前,首先需要检查网站的`robots.txt`文件,这是一个指示爬虫哪些页面可以抓取,哪些不可以的协议。如果网站未设置此文件,理论上所有未加密的数据都可以爬取。但如果有`robots.txt`,则需要遵循其中的规定,例如淘宝网的例子,它指定了特定爬虫可以访问的路径,而其他未授权的爬虫则被禁止。 安装requests库是Python爬虫的基础步骤,通常在PyCharm中,可以通过项目设置的“Project Interpreter”添加并安装这个库。安装完成后,便可以利用requests库进行HTTP请求。requests库提供了get和post两种方法,分别对应HTTP的GET和POST请求。 GET请求是最常见的,通常用于获取资源或查询信息,其速度较快。POST请求则可以携带数据,常用于提交表单或更新信息。在确定请求方式后,可以构建相应的URL并调用requests.get()或requests.post()来获取网页内容。例如,通过requests.get()方法获取网页源代码,然后通过访问返回对象的.text属性来获取HTML文本。 在实际操作中,为了抓取特定数据,可能需要配合正则表达式对HTML内容进行匹配和提取。例如,查找特定新闻标题,可以在源代码中搜索标题,找到对应的请求对象和请求方式,然后在Python代码中模拟这个过程,从而获取所需数据。 Python爬虫教程涵盖了选择Python的原因、判断网站爬虫规则、安装和使用requests库、理解GET和POST请求以及如何使用它们来抓取数据。这些知识点构成了基础爬虫开发的核心技能,为数据挖掘、历史数据存储和信息处理提供了强大的工具。通过不断实践和学习,开发者可以进一步提升爬虫技术,应对更复杂的数据抓取任务。

- 粉丝: 7

- 资源: 971

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功

评论0