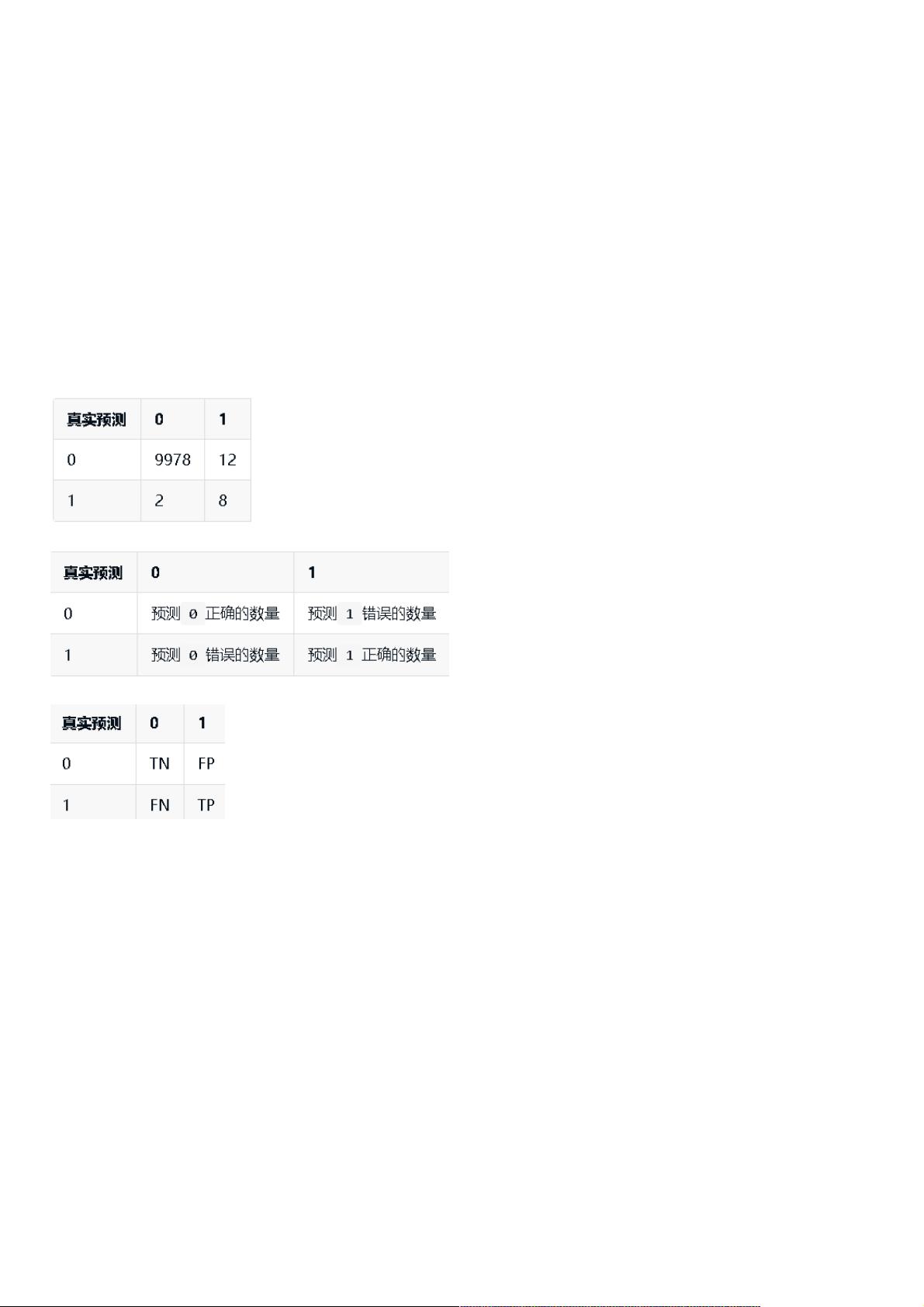

常见概念(2) 准确率的不足和混淆矩阵: 准确对越高就能说明模型的分类性能越好吗?举个例子,现在我开发了一套癌症检测系统,只要输入你的一些基本健康信息,就能预测出你现在是否患有癌症,并且分类的准确度为 0.999。这样的系统的预测性能好不好呢? 你可能会觉得,哇,这么高的准确度!这个系统肯定很牛逼!但是我们知道,一般年轻人患癌症的概率非常低,假设患癌症的概率为 0.001,那么其实我这个癌症检测系统只要一直输出您没有患癌症,准确度也可能能够达到 0.999。 假如现在有一个人本身已经患有癌症,但是他自己不知道自己患有癌症。这个时候用我的癌症检测系统检测发现他没有得癌症,那很显然我这个系统已经把 点代表 Negative。精准率关注的是模型预测为 Positive 的样本中真正为 Positive 的比例,而召回率关注的是所有真正为 Positive 的样本中被模型正确识别的比例。在某些情况下,提高精准率可能意味着牺牲召回率,反之亦然。比如,如果我们希望减少假阳性(FP),即减少健康的个体被误诊为癌症,那么可能会降低召回率,因为真正患病的人可能被错误地归类为健康。相反,如果我们注重捕捉所有的阳性病例,即确保所有患病的人都能被检测出来,可能会增加假阴性(FN),从而降低精准率。 在医学检测领域,精准率和召回率通常是重要的评估指标。精准率高意味着误诊率低,避免了不必要的恐慌和医疗资源浪费;召回率高意味着检测系统能够有效地找出大部分的患者,有助于早期诊断和治疗。在癌症检测的例子中,如果系统过于追求精准率,可能会导致一些实际的癌症患者被遗漏,延误治疗。而如果侧重于召回率,虽然可能会有更多健康个体被误判为癌症,但至少能确保大部分患者得到及时的医疗干预。 除了精准率和召回率,还有另一个重要的指标叫做 F1 分数,它是精准率和召回率的调和平均值,用于综合考虑两者的表现: \[ F1 = 2 \cdot \frac{Precision \times Recall}{Precision + Recall} \] F1 分数越高,说明模型在精准率和召回率之间取得了较好的平衡。在处理不平衡数据集时,F1 分数通常比单一的准确率更能反映模型的性能。 在实际应用中,我们还需要根据问题的具体需求来调整模型,比如通过调整分类阈值、使用不同的分类算法或者优化模型参数来改善精准率和召回率。同时,还可以探索其他评估指标,如查准率-查全率曲线(Precision-Recall Curve)、ROC 曲线(Receiver Operating Characteristic Curve)以及 AUC 值(Area Under the ROC Curve),这些都能提供更全面的模型性能评估。 总结来说,机器学习模型的评估不应只依赖准确率,尤其在面对不平衡数据集时。混淆矩阵、精准率、召回率和 F1 分数等指标提供了更为全面的性能评估视角,帮助我们理解模型在不同情况下的表现,进而优化模型以满足具体应用场景的需求。在Python中,我们可以利用numpy等库轻松实现这些指标的计算,以辅助模型的训练和调优。

- 粉丝: 5

- 资源: 922

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功

评论0