Apache Spark 源码的理解 Apache Spark 是一个用于大规模数据处理的开源框架,以其高效的内存计算和弹性容错性而闻名。Spark 提供了一个统一的数据处理平台,支持批处理、交互式查询、流处理和机器学习等多种计算模式。在本文中,我们将探讨 Spark 的核心概念,包括 RDD、依赖、计算模型、调度器以及存储管理等。 1. **RDD (Resilient Distributed Datasets)** RDD 是 Spark 最基本的数据抽象,代表了一组不可变、分区的记录集合。RDD 具有容错性,通过血统(lineage)来恢复丢失的数据。每个 RDD 可以通过转换操作(如 map、filter)从另一个 RDD 创建,并且可以被持久化到内存或磁盘以加速后续计算。 2. **内部结构与分区** RDD 分区是其内部数据的逻辑分组,每个分区可以在集群的不同节点上独立执行。分区有助于并行计算和数据本地性优化。 3. **依赖** RDD 之间的依赖关系定义了计算的执行顺序。常见的依赖类型有窄依赖(如 map)和宽依赖(如 shuffle)。窄依赖允许多个任务并行执行,而宽依赖需要等待所有前驱任务完成。 4. **转换操作的依赖图** 转换操作构建了一个有向无环图 (DAG),该图表示了计算任务的执行顺序。Spark 使用这个 DAG 来计划和调度工作。 5. **计算函数与优先位置** 用户自定义的函数可以应用于 RDD 上,这些函数在执行时会考虑数据的位置,以最大限度地提高数据本地性,减少网络传输。 6. **分区器** 分区器决定了 RDD 的分区策略,影响数据分布和并行计算的效率。默认的 HashPartitioner 基于对象的哈希值进行分区。 7. **持久化与检查点** Spark 支持将 RDD 持久化到内存或磁盘,以加快重用。检查点用于持久化整个计算 DAG,以简化故障恢复。 8. **调度器** Spark 的 DAG 调度器分为两部分:Stage 分割器和 Task Scheduler。Stage 是 DAG 中一组可以并行执行的任务,而 Task Scheduler 负责将任务分配给执行器。 9. **Shuffle 过程** Shuffle 是数据重新分布的过程,通常发生在宽依赖之后。它包括两个阶段:Shuffle 写,将数据分区写入磁盘;Shuffle 读,根据新的分区策略重新组合数据。 10. **存储管理** Spark 支持多种存储级别,如内存、磁盘和序列化。存储层负责管理数据的缓存和回收,以优化内存使用。 11. **通信层** Spark 使用 Tachyon 或 Alluxio 作为内存层的统一文件系统,同时利用 TCP/IP 实现节点间的通信。 12. **源码阅读** 阅读 Spark 源码可以帮助深入理解其内部工作机制。可以使用 IntelliJ IDEA 配合 Scala 插件,按照文档说明配置和编译 Spark 源码,然后进行调试和学习。 通过以上内容,我们可以看到 Spark 的设计思路是高效、容错和可扩展的。掌握这些知识点对于理解和优化 Spark 应用程序至关重要。同时,配合相关文献和资源,可以进一步提升对 Spark 的理解。

剩余58页未读,继续阅读

- 粉丝: 46

- 资源: 2

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

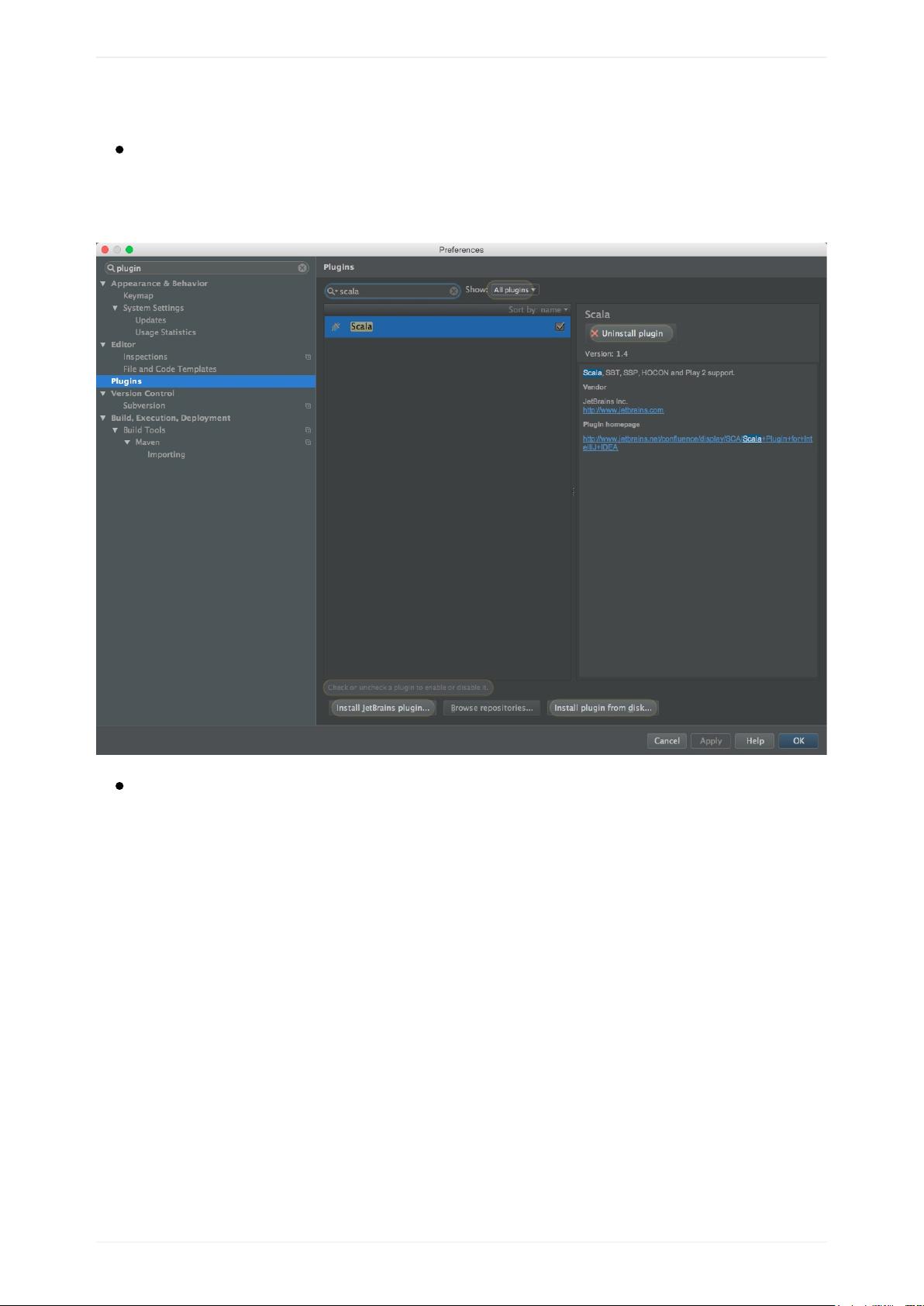

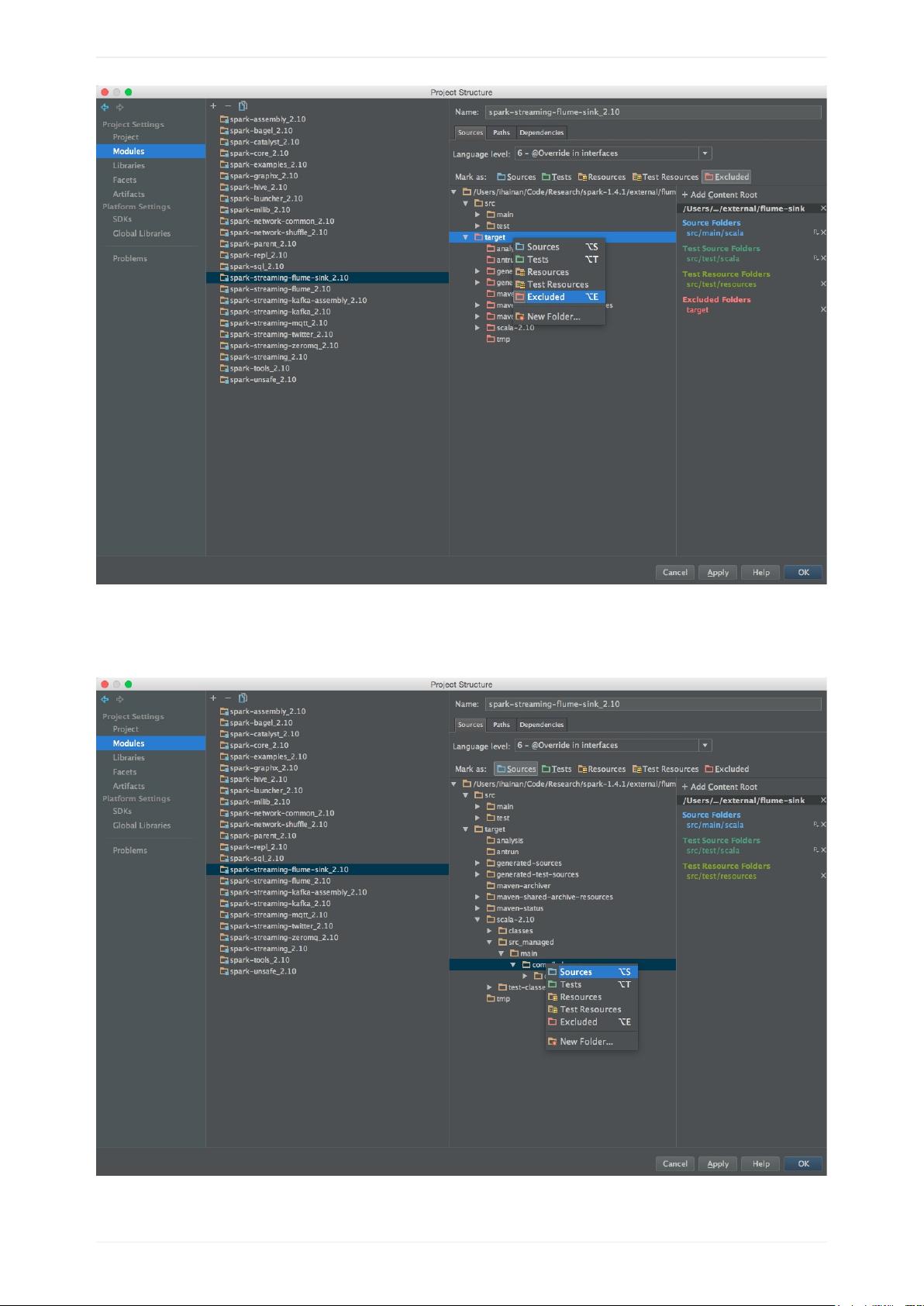

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- JKD-17安装包下载

- 毕业设计《基于SSM新生入校学校介绍网站(可升级SpringBoot)》+Java源码+文档说明+毕业论文

- CocosCreator源码资源H5小游戏源码大合集切积木见缝插口红记忆小游戏看图猜词2.0萝卜载兔子飞行16宫格翻牌匹配一笔连

- InteliMap AI Tilemap Generator 1.2.1.unitypackage

- (源码)基于Spring Boot和MyBatis Plus的学生选课系统.zip

- (源码)基于Arduino和Raspberry Pi的语音控制风扇系统.zip

- CocosCreator源码资源H5小游戏源码大合集激流勇进天天消消乐别踩白块线条生存打砖块射击保卫星球射击吃豆人开心消消乐俄罗

- (源码)基于Spring Boot和MyBatis的知识库管理系统.zip

- (源码)基于无线传输的实时数据通信验证系统.zip

- (源码)基于ESP32的Secret Box状态监控与管理系统.zip

信息提交成功

信息提交成功