Python使用Scrapy爬虫框架全站爬取图片并保存本地的实现代码

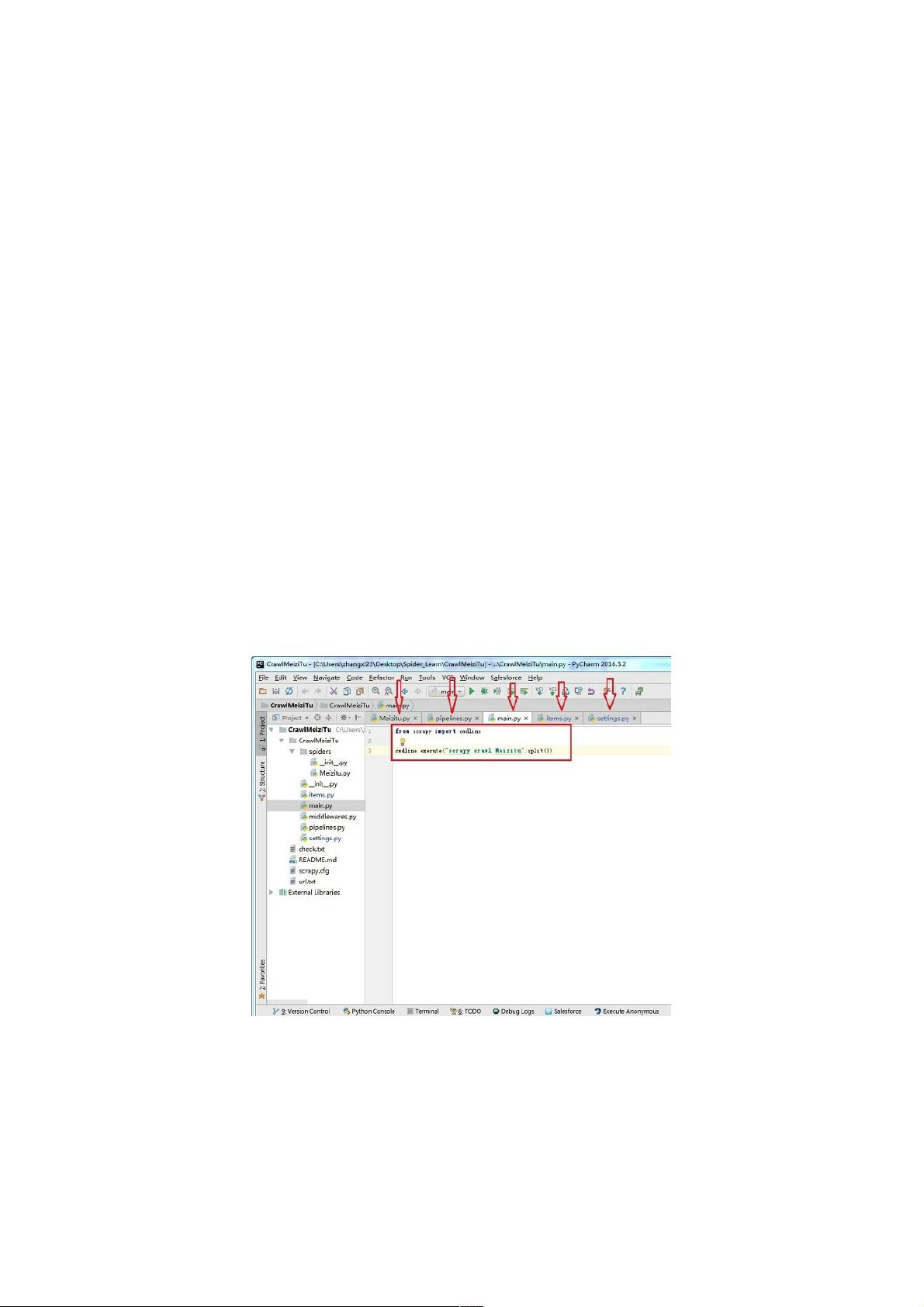

Python是目前非常流行的编程语言之一,尤其在数据科学、机器学习、自动化脚本等领域有着广泛的应用。而Scrapy是一个快速、高层次的网页爬取和网页抓取框架,用于抓取web站点并从页面中提取结构化的数据。它的设计是为了使开发者能快速、轻松地爬取网站数据,不用担心网络请求、数据解析、持久化存储等繁琐步骤。 在使用Scrapy进行全站图片爬取并保存至本地的具体操作中,需要注意以下几个关键步骤和知识点。 创建Scrapy项目。使用命令行工具,通过`scrapy startproject CrawlMeiziTu`命令创建一个新项目。这个命令会在当前目录下生成一个项目文件夹,包含项目的所有核心文件,比如`items.py`(定义爬取的数据模型)、`pipelines.py`(定义数据处理流程)、`settings.py`(项目配置)、`middlewares.py`(中间件配置)和`spiders`目录(存放爬虫脚本)。 在创建项目后,需要添加一个爬虫。使用`scrapy genspider Meizitu ***`命令来生成一个爬虫,它会创建一个名为`Meizitu.py`的文件。这个爬虫将用于爬取指定网站上的图片资源。 编辑`settings.py`文件是配置Scrapy项目的重点。需要设置`BOT_NAME`为项目名,`SPIDER_MODULES`指定爬虫模块的位置,`NEWSPIDER_MODULE`指定新爬虫的模块名,`ITEM_PIPELINES`用于定义数据处理的流程,比如设定图片保存的目录`IMAGES_STORE`。`DOWNLOAD_DELAY`是设置下载延迟时间,避免因爬虫速度过快而被网站封禁。`USER_AGENT`是模拟浏览器的用户代理字符串,`ROBOTSTXT_OBEY`遵循robots.txt文件的规定。 `items.py`中定义了爬取的数据结构,它包含多个字段,比如`title`、`url`、`tags`、`src`和`alt`,用于存储图片的标题、URL、标签、图片的链接和替代文本(alt属性)。 `pipelines.py`用于定义对爬取到的数据进行处理的方法。在实际的项目中,这个文件通常包含多个类,每一个类负责一部分数据的处理逻辑。例如,`CrawlmeizituPipeline`类中的`process_item`方法负责根据标题创建文件夹、保存图片等操作。它需要导入`os`和`requests`模块来操作文件系统和网络请求。其中`IMAGES_STORE`变量从设置中导入,表示图片保存的本地路径。 通过以上步骤,就可以完成使用Scrapy框架实现全站图片爬取和保存本地的整个流程。通过上述配置和编码,可以开发出一个功能强大的爬虫程序,用于从网站上抓取图片,然后保存到本地的指定路径中。 值得一提的是,虽然爬虫技术非常强大,但开发者需要遵守相关法律法规和网站的使用协议,在合法合规的范围内使用爬虫技术,避免对网站造成过大的访问压力或者侵犯版权等违法行为。

- 粉丝: 6

- 资源: 956

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜 信息提交成功

信息提交成功