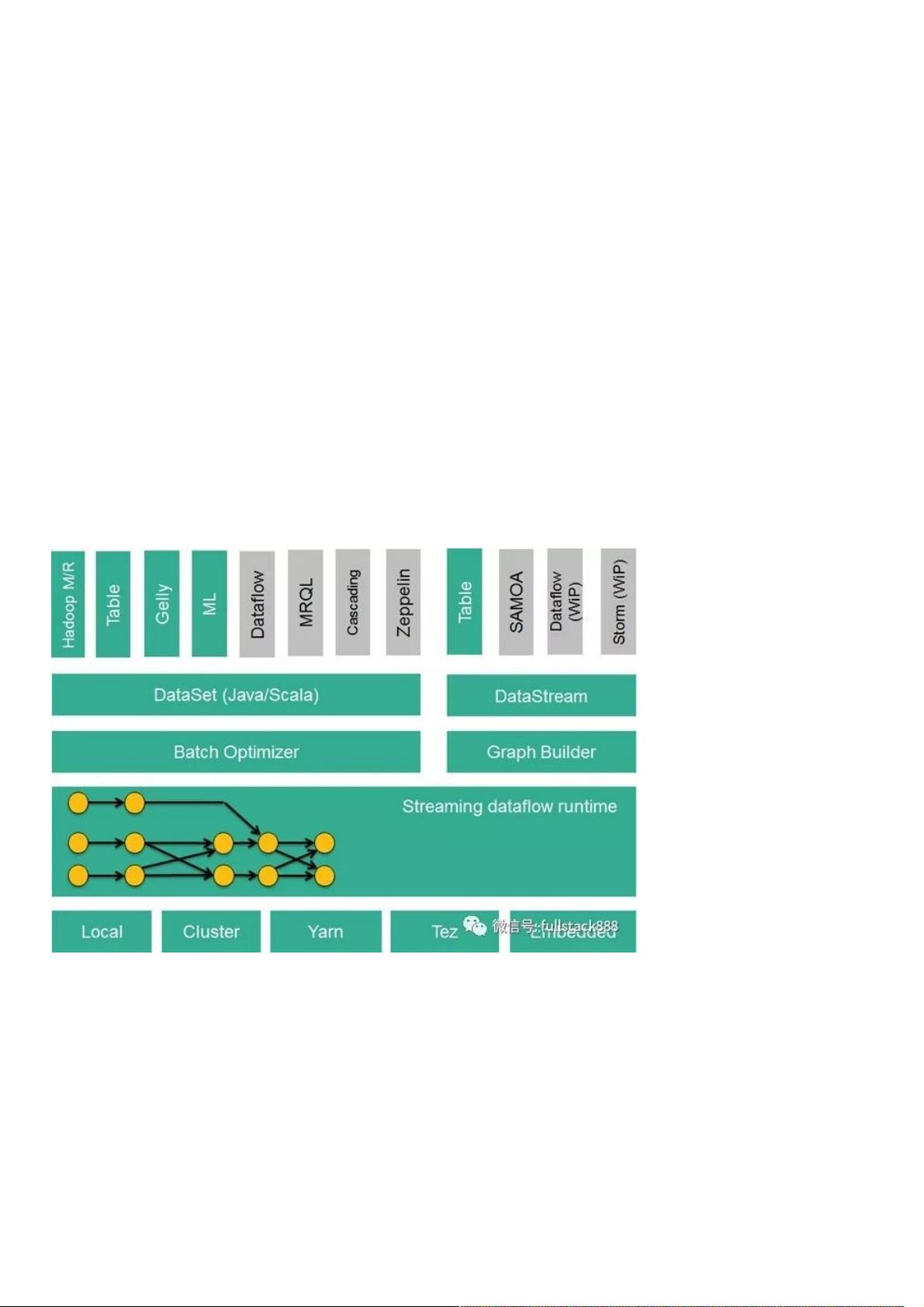

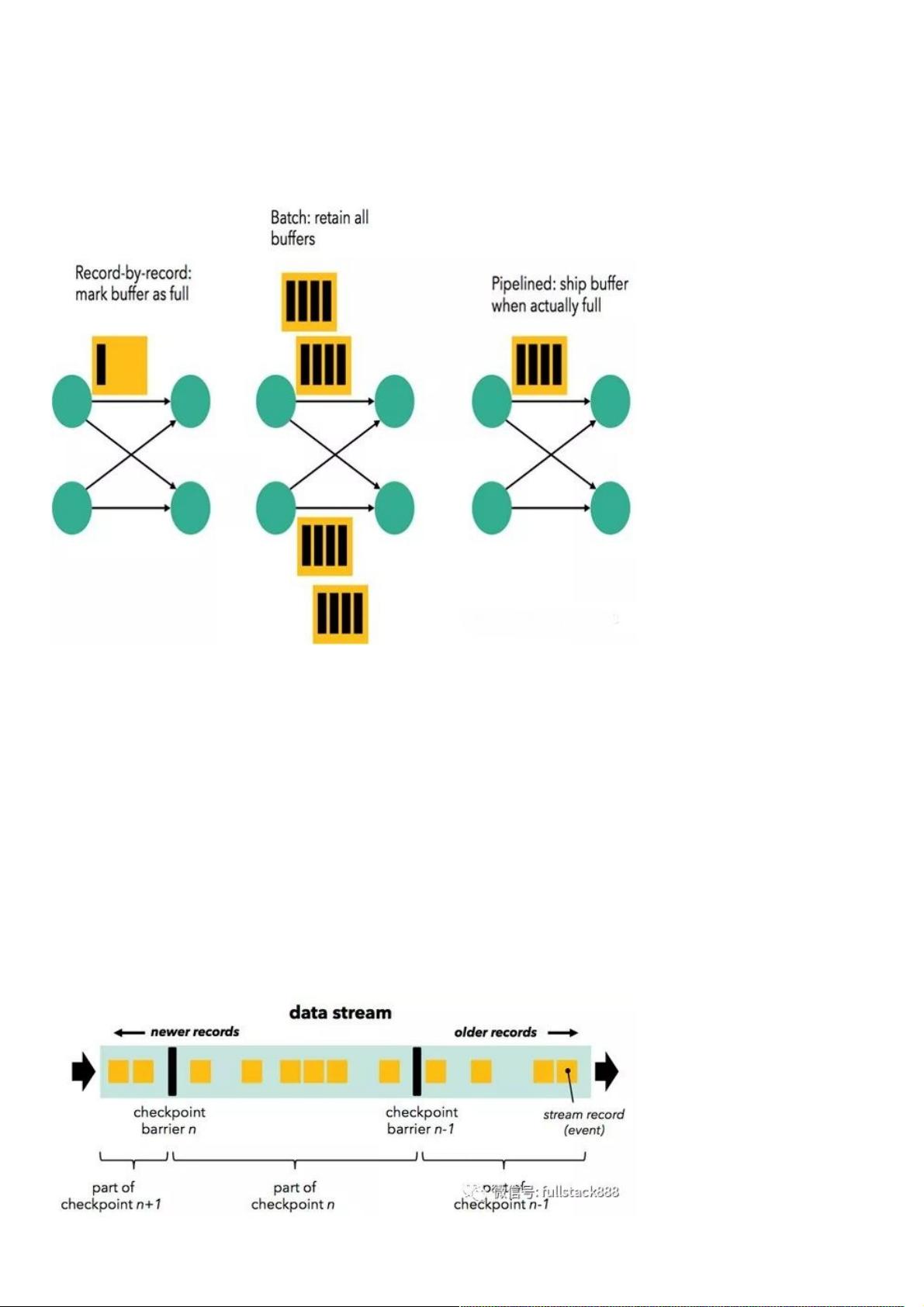

ApacheFlink(下简称Flink)项目是大数据处理领域最近冉冉升起的一颗新星,其不同于其他大数据项目的诸多特性吸引了越来越多人的关注。本文将深入分析Flink的一些关键技术与特性,希望能够帮助读者对Flink有更加深入的了解,对其他大数据系统开发者也能有所裨益。本文假设读者已对MapReduce、Spark及Storm等大数据处理框架有所了解,同时熟悉流处理与批处理的基本概念。 Flink核心是一个流式的数据流执行引擎,其针对数据流的分布式计算提供了数据分布、数据通信以及容错机制等功能。基于流执行引擎,Flink提供了诸多更高 Apache Flink是一个强大的开源大数据处理框架,以其独特的流处理能力及高效的批处理支持而备受瞩目。Flink的核心是一个流式数据流执行引擎,它能够处理不断流入的数据流,并且具备高度分布式计算的能力,包括数据分布、通信以及容错机制。 Flink提供了多种API来满足不同类型的计算需求。DataSet API用于批处理,它将静态数据转化为分布式数据集,支持对数据集进行各种操作,如过滤、转换、聚合等,同时兼容Java、Scala和Python。DataStream API则专门用于处理无界和有界数据流,提供对实时数据流的操作,同样支持Java和Scala。Table API是为结构化数据查询设计的,它允许用户以类似SQL的语法进行操作,适用于Java和Scala。Flink还拥有专用的库,如Flink ML用于机器学习任务,Gelly则用于图计算。 Flink的独特之处在于其统一的批处理与流处理模型。与传统的流处理系统(如Apache Storm)和批处理系统(如Apache Spark)相比,Flink的执行引擎可以灵活地在低延迟和高吞吐量之间切换。它通过缓存块的超时值来控制数据传输方式,实现从即时传输(类似流处理)到批量传输(类似批处理)的动态平衡,这使得Flink既能处理流式任务,又能胜任批处理任务,降低了用户的维护成本。 Flink的流处理容错机制是其稳定性的关键。当系统中某个节点失败时,Flink能够自动恢复,保证数据不丢失。它使用检查点和保存点策略来实现状态一致性。检查点定期保存整个计算图的状态,使得在故障发生时可以从最新的检查点恢复。保存点则允许用户在任何时间点创建一个可恢复的状态快照,为系统提供了更大的灵活性。这些机制确保了Flink在处理大规模数据流时的高可用性和数据一致性。 此外,Flink与Hadoop生态系统的集成也十分紧密,它可以无缝读取HDFS和HBase中的数据,使用Kafka作为数据源,甚至能重用MapReduce和Storm的代码,这大大增强了其在现有大数据环境中的适应性。 Apache Flink通过其先进的流处理引擎和统一的批处理模型,为大数据处理提供了一个高效、灵活且可靠的平台。它的API设计和容错机制使得开发者能够在实时流处理和批量数据分析之间自由切换,而无需担心性能和稳定性问题。无论是数据科学家、机器学习工程师还是大数据系统开发者,深入理解Flink的核心技术都将对他们的工作带来显著的助益。

剩余7页未读,继续阅读

- 粉丝: 6

- 资源: 957

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- C语言-leetcode题解之61-rotate-list.c

- C语言-leetcode题解之59-spiral-matrix-ii.c

- C语言-leetcode题解之58-length-of-last-word.c

- 计算机编程课程设计基础教程

- (源码)基于C语言的系统服务框架.zip

- (源码)基于Spring MVC和MyBatis的选课管理系统.zip

- (源码)基于ArcEngine的GIS数据处理系统.zip

- (源码)基于JavaFX和MySQL的医院挂号管理系统.zip

- (源码)基于IdentityServer4和Finbuckle.MultiTenant的多租户身份认证系统.zip

- (源码)基于Spring Boot和Vue3+ElementPlus的后台管理系统.zip

信息提交成功

信息提交成功

评论0