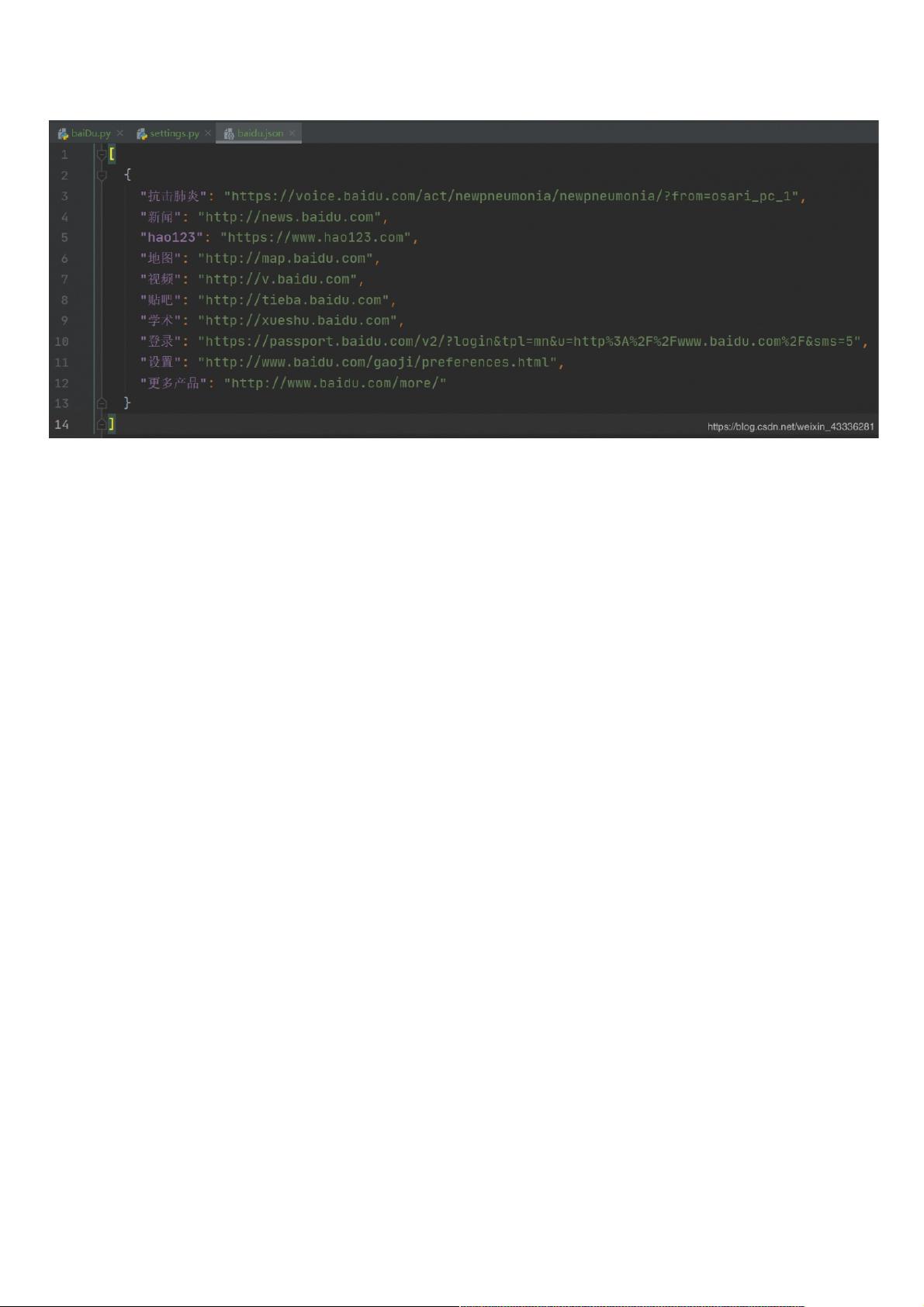

Hello,我是 Alex 007,为啥是007呢?因为叫 Alex 的人太多了,再加上每天007的生活,Alex 007就诞生了。 这几天一直在练车,只能在中间休息的时候写一写博客,可怜去年报的名到现在还没有拿到小本本,当然练车只是副技能,主技能还是coding,不断学习才能不被淘汰。 最近在学爬虫的 scrapy 框架,以前虽然拿 GoLang 玩过爬虫,可惜没有太深入,这次拿 Python 好好学一学。 学习爬虫过程中的代码都放在了GitHub上:https://github.com/koking0/Spider 小生才疏学浅,如有谬误,恭请指正。 文章目录一、初探 Scrapy1.Sc 【Scrapy 框架详解】 Scrapy 是一个强大的 Python Web 爬虫框架,它提供了高效的网页抓取和数据提取功能,适用于多种用途,包括数据挖掘、网站监控和自动化测试。Scrapy 的核心特性包括多线程爬取、中间件处理、请求/响应对象模型以及灵活的数据流处理。 **一、Scrapy 的安装** 安装 Scrapy 非常简单,只需要在命令行中运行以下 Python 的包管理工具 pip: ```bash pip install scrapy ``` 确保你的 Python 环境已经配置好,并且 pip 已经更新到最新版本。 **二、创建第一个 Scrapy 项目** 1. 通过命令行创建一个新的 Scrapy 项目: ```bash scrapy startproject my_first_spider ``` 这将在当前目录下创建一个名为 `my_first_spider` 的项目结构。 2. 接下来,进入项目目录: ```bash cd my_first_spider ``` 3. 创建一个爬虫: ```bash scrapy genspider example example.com ``` 这将生成一个名为 `example` 的爬虫,目标是 `example.com`。 4. 编辑 `spiders/example.py` 文件,定义爬虫逻辑,例如使用 `start_requests()` 方法定义起始 URL 和 `parse()` 方法解析响应。 **三、基本操作** **1. 持久化存储** - **基于终端指令的持久化存储**:可以使用 Scrapy 的命令行选项 `-o` 或 `-O` 将爬取的数据导出为 JSON、XML 或 CSV 文件。 - **基于管道的持久化存储**:自定义 `pipelines.py` 中的类,处理爬取到的数据,例如将数据存入数据库或进行清洗。 **2. 全站数据爬取与请求传参** - 使用 `scrapy.Request` 发送带有参数的 HTTP 请求,参数可以通过 `meta` 字典传递。 - `scrapy.spiders.CrawlSpider` 类允许定义规则(`rules`)来自动跟踪页面链接,实现全站爬取。 **3. 图片下载** Scrapy 内置了图片下载器中间件(`scrapy.pipelines.ImagesPipeline`),可以方便地下载网页上的图片并进行处理,如指定保存路径、大小限制等。 **四、Scrapy 的核心组件** - **Engine(引擎)**:负责调度请求和发送它们到下载器,同时接收下载器返回的响应,并将其发送到蜘蛛进行处理。 - **Downloader(下载器)**:负责获取网络上的数据,通常使用异步方式。 - **Spiders(蜘蛛)**:编写爬虫逻辑的地方,用于解析响应并生成新的请求。 - **Items(项目)**:定义要爬取的数据结构。 - **Pipelines(管道)**:处理蜘蛛返回的项,例如数据清洗、验证和存储。 - **Middleware(中间件)**:在请求/响应之间提供额外的处理逻辑。 在 Scrapy 中,数据流大致如下:引擎 → 下载器 → 蜘蛛 → 管道。这个过程中,中间件可以在每个阶段对数据进行预处理或后处理。 在实际使用中,Scrapy 提供了丰富的功能,如错误处理、速率限制、IP 换代理等。它还支持分布式爬虫,可以通过 Scrapy Cluster 或 Scrapy Cloud 扩展到多个机器上运行。 Scrapy 以其高效、模块化的设计,为开发者提供了强大而便捷的爬虫开发环境。不论你是初学者还是经验丰富的开发者,掌握 Scrapy 都能显著提升你的爬虫开发效率。

剩余6页未读,继续阅读

- 粉丝: 5

- 资源: 935

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 手套手势检测7-YOLO(v5至v11)、COCO、CreateML、Paligemma、TFRecord、VOC数据集合集.rar

- CentOS bridge 工具包 bridge-utils-1.6-1.33.x86-64.rpm

- 手势检测7-YOLO(v5至v11)、COCO、CreateML、Paligemma、TFRecord、VOC数据集合集.rar

- 基于python flask实现某瓣数据可视化数据分析平台

- awewq1132323

- 手写流程图检测31-YOLO(v5至v8)、COCO、CreateML、Darknet、Paligemma、TFRecord数据集合集.rar

- frida拦截微信小程序云托管API

- 肝脏及其肿瘤分割的 CT 数据集,已经切片成jpg数据,约2w张数据和mask

- 基于Java的网上教务评教管理系统的设计与实现.doc

- 2024圣诞节海外消费市场趋势及营销策略分析报告

信息提交成功

信息提交成功