Tensorflow

tf.reduction_indices

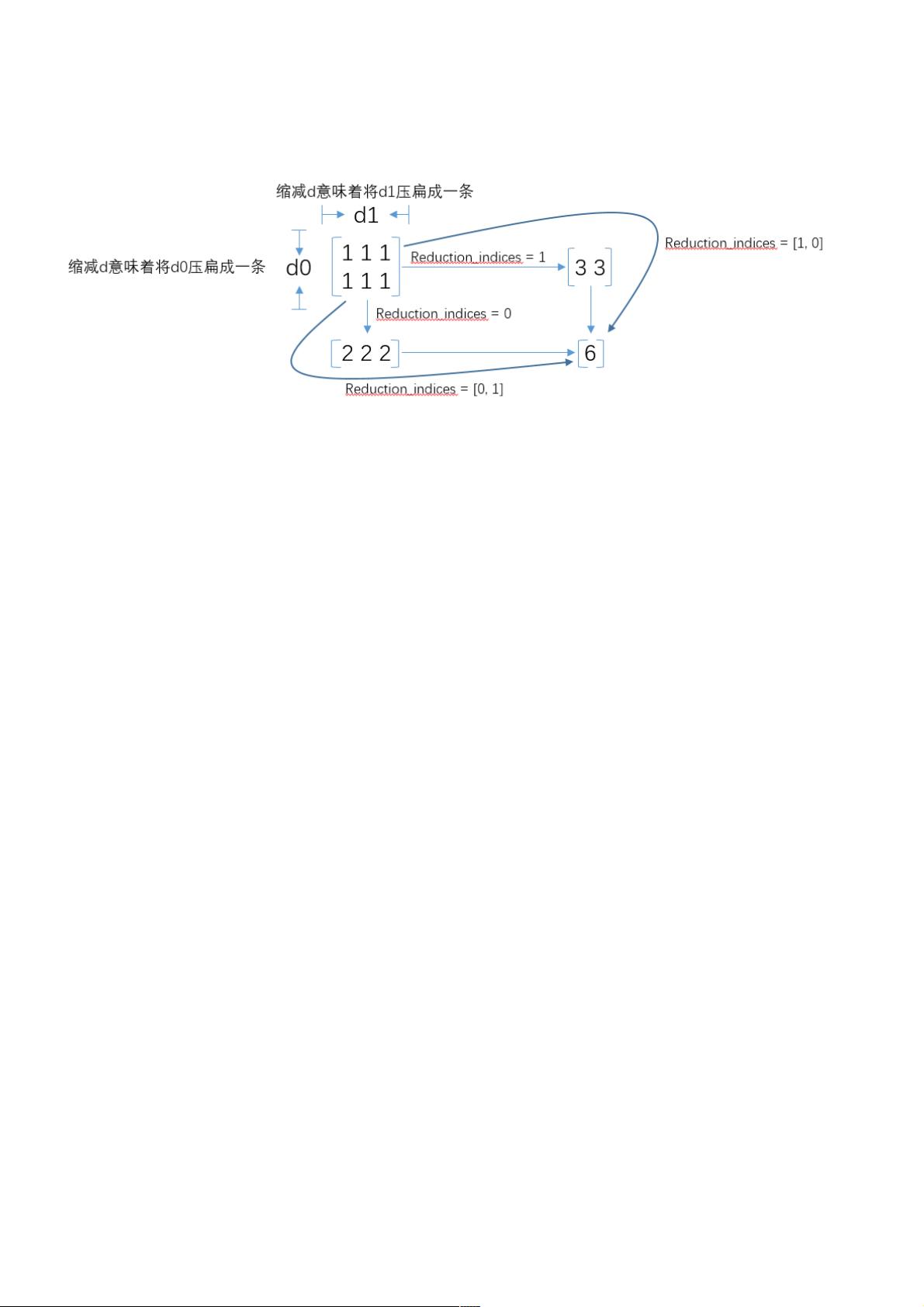

在tensorflow的使用中,经常会使用tf.reduce_mean,tf.reduce_sum等函数,在函数中,有一个reduction_indices参数,表示函数的处理维度,直接上

图,一目了然:

tf.control_dependencies()作用及用法作用及用法

在有些机器学习程序中我们想要指定某些操作执行的依赖关系,这时我们可以使用tf.control_dependencies()来实现。

control_dependencies(control_inputs)返回一个控制依赖的上下文管理器,使用with关键字可以让在这个上下文环境中的操作都在control_inputs 执

行。

with g.control_dependencies([a, b, c]):

# `d` and `e` will only run after `a`, `b`, and `c` have executed.

d = ...

e = ...

可以嵌套control_dependencies 使用:

with g.control_dependencies([a, b]):

# Ops constructed here run after `a` and `b`.

with g.control_dependencies([c, d]):

# Ops constructed here run after `a`, `b`, `c`, and `d`.

可以传入None 来消除依赖:

with g.control_dependencies([a, b]):

# Ops constructed here run after `a` and `b`.

with g.control_dependencies(None):

# Ops constructed here run normally, not waiting for either `a` or `b`.

with g.control_dependencies([c, d]):

# Ops constructed here run after `c` and `d`, also not waiting

# for either `a` or `b`.

# WRONG

def my_func(pred, tensor):

t = tf.matmul(tensor, tensor)

with tf.control_dependencies([pred]):

# The matmul op is created outside the context, so no control

# dependency will be added.

return t

# RIGHT

def my_func(pred, tensor):

with tf.control_dependencies([pred]):

# The matmul op is created in the context, so a control dependency

# will be added.

return tf.matmul(tensor, tensor)

tf.cond() 控制数据流向

TensorFlow流程控制之tf.identity

作者:爱弹ukulele的程序猿