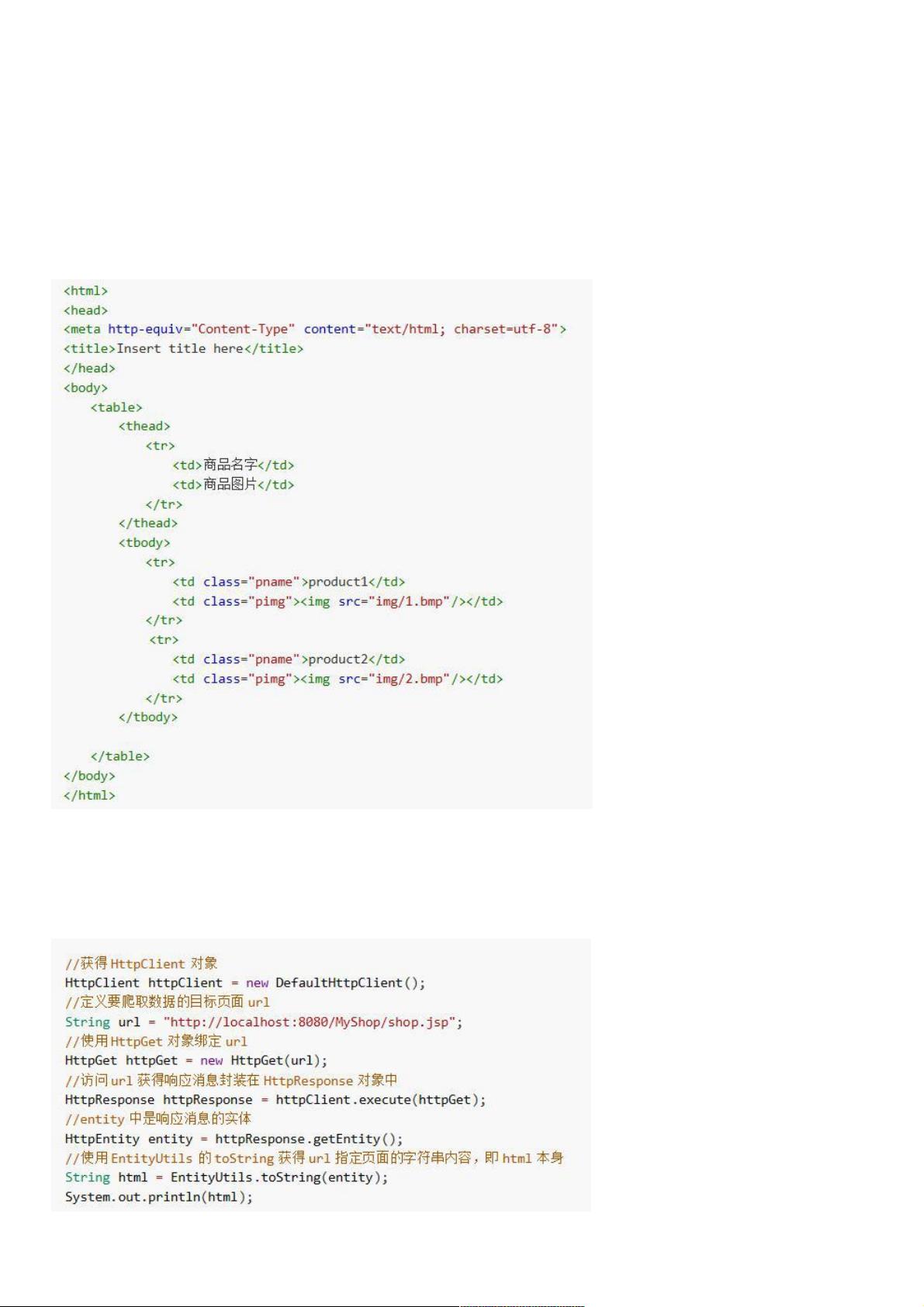

1.Jsoup简述 Java中支持的爬虫框架有很多,比如WebMagic、Spider、Jsoup等。今天我们使用Jsoup来实现一个简单的爬虫程序。 Jsoup拥有十分方便的api来处理html文档,比如参考了DOM对象的文档遍历方法,参考了CSS选择器的用法等等,因此我们可以使用Jsoup快速地掌握爬取页面数据的技巧。 2.快速开始 1)编写HTML页面 页面中表格的商品信息是我们要爬取的数据。其中属性pname类的商品名称,以及属于pimg类的商品图片。 2)使用HttpClient读取HTML页面 HttpClient是一个处理Http协议数据的工具,使用 **Jsoup简介** Jsoup是Java中一个非常实用的库,专为解析和操作HTML文档设计。它提供了类似于DOM、CSS以及jQuery的选择器,使得在Java中处理HTML变得相当便捷。Jsoup支持从URL直接抓取网页内容,或者将HTML字符串解析成一个可操作的Document对象。这个库在爬虫开发中扮演着核心角色,因为它的API设计简洁且功能强大,允许开发者高效地提取和操作网页数据。 **使用HttpClient读取HTML** 在实现爬虫的过程中,我们通常需要一个工具来发送HTTP请求并接收响应。HttpClient是Apache提供的一款用于处理HTTP协议的Java库,可以用来获取网页内容。使用HttpClient,你可以创建一个HttpGet或HttpPost对象,指定URL,然后执行请求以获取响应。一旦得到响应,可以将其转换为InputStream,从而为Jsoup提供解析的输入。 **解析HTML与Jsoup** Jsoup的核心是`parse()`方法,它接受一个包含HTML的字符串,返回一个`Document`对象,这个对象就像HTML文档的DOM树。`Document`对象提供了丰富的API来遍历和选择元素,例如`select()`方法可以使用CSS选择器来定位特定的HTML元素。例如,如果我们要抓取类名为`pname`的商品名称和类名为`pimg`的商品图片,可以通过以下方式实现: ```java Document doc = Jsoup.connect("http://example.com").get(); Elements names = doc.select(".pname"); Elements images = doc.select(".pimg"); ``` 之后,我们可以通过迭代`names`和`images`集合来获取具体元素的文本或属性。 **保存爬取的数据** 完成数据抓取后,通常需要存储这些信息。对于文本数据,如商品名称,可以创建一个实体Bean来封装数据,然后通过JDBC或ORM框架(如Hibernate)存入数据库。例如,创建一个`Product`类,包含`name`和`imageUrl`字段,然后将`names`和`images`的对应元素组合并存入数据库。 对于图片,可以使用IO流直接从`InputStream`写入到服务器本地的文件系统。这样,每个图片的URL对应的`InputStream`可以被转换为一个本地文件。 **更深入的爬虫技术** 虽然上述步骤演示了一个基本的爬虫实现,但实际的爬虫项目可能涉及到更复杂的问题,如处理JavaScript渲染的页面、处理分页、反爬虫策略、并发抓取等。Jsoup本身不支持执行JavaScript,对于这类情况,可能需要结合其他工具,如Selenium。此外,爬虫的伦理和法律问题也非常重要,确保遵守网站的robots.txt规则,尊重网站的抓取政策。 Jsoup是一个强大的工具,可以帮助开发者快速构建Java爬虫。结合HttpClient,可以实现从网页抓取数据,而进一步的存储和处理则取决于具体的需求和项目规模。学习和掌握这些技能,将有助于你成为一个更加全面的Java程序员。

- 粉丝: 4

- 资源: 913

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- dnSpy-net-win32-222.zip

- mongoose-free-6.9

- 德普微一级代理 DP100N06MGL PDFN3.3*3.3 TRMOS N-MOSFET 60V, 8mΩ, 45A

- 【java毕业设计】SpringBoot+Vue幼儿园管理系统 源码+sql脚本+论文 完整版

- 德普微一级代理 DP021N03FGLI DFN5*6 DPMOS N-MOSFET 30V 180A 1.8mΩ

- 巨潮资讯网5000只股票orgId-dict加密字典

- 基于java实现的快速排序代码

- 德普微一级代理 DP3145D SOT23-6 USB PD 协议单口控制器

- 【一文搞懂:什么是集成学习-原理+python代码】

- 国际象棋检测7-YOLO(v5至v9)、COCO、CreateML、Darknet、Paligemma、TFRecord数据集合集.rar

信息提交成功

信息提交成功