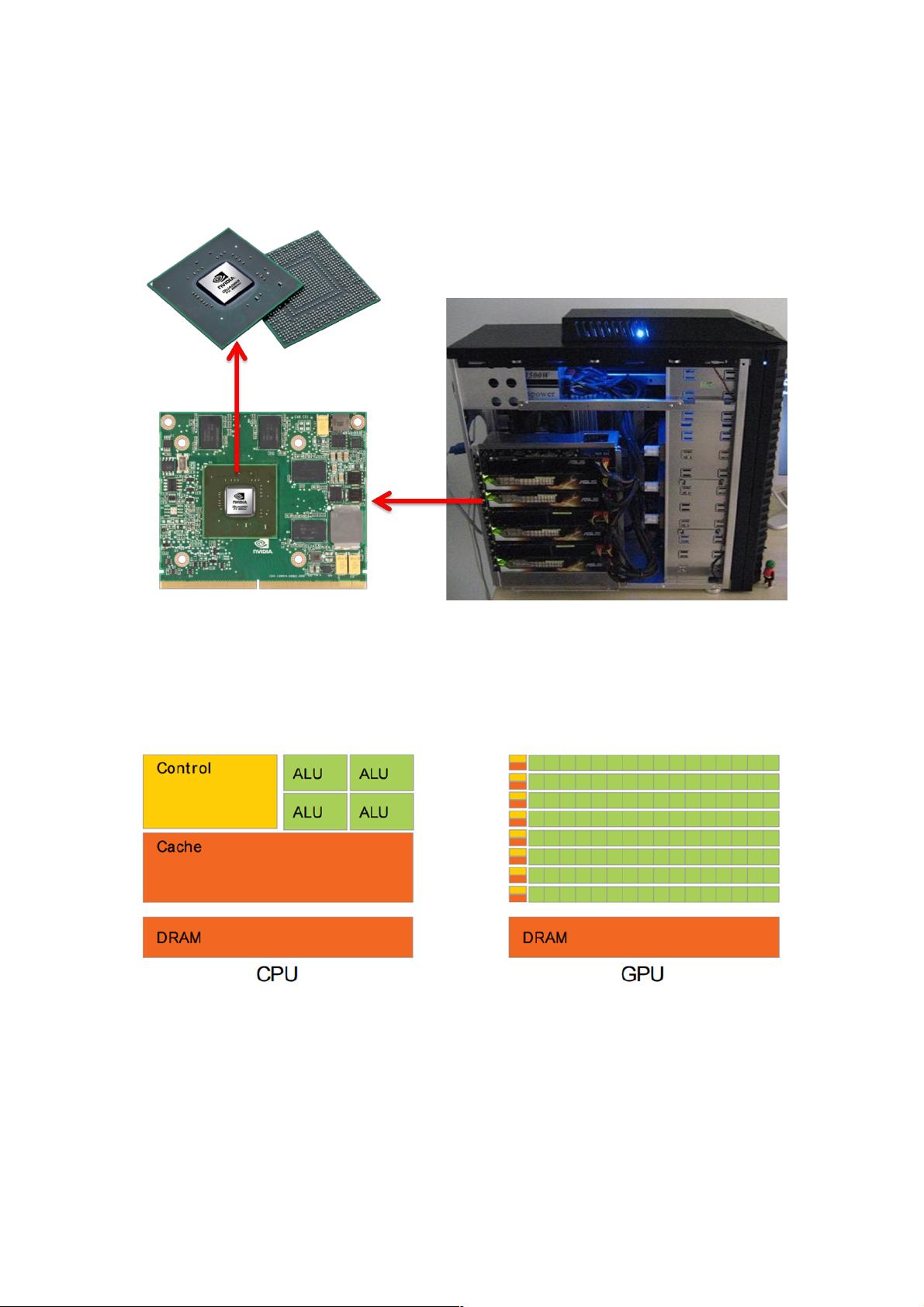

如图1所示,这台PC机与普通PC机不同的是这里插了7张显卡,左下角是显卡,在中间的就是GPU芯片。显卡的处理器称为图形处理器(GPU),它是显卡的“心脏”,与CPU类似,只不过GPU是专为执行复杂的数学和几何计算而设计的。GPU计算能力非常强悍,举个例子:现在主流的i7处理器的浮点计算能力是主流的英伟达GPU处理器浮点计算能力的1/12。图2对CPU与GPU中的逻辑架构进行了对比。其中Control是控制器、ALU算术逻辑单元、Cache是cpu内部缓存、DRAM就是内存。可以看到GPU设计者将更多的晶体管用作执行单元,而不是像CPU那样用作复杂的控制单元和缓存。从实际来看, GPU,即图形处理器,是显卡的核心部件,与CPU类似,但其设计专注于执行复杂的数学和几何计算。这种专门化使GPU在浮点计算能力上远超CPU,例如,当前主流的i7处理器的浮点运算能力仅为主流英伟达GPU的1/12。GPU的高效源于其内部结构,更多地利用晶体管作为执行单元,而不是像CPU那样用于复杂的控制单元和缓存。在CPU中,大约5%的芯片空间是ALU,而在GPU中,这一比例高达40%,这也是GPU计算能力强大的主要原因。 GPU的设计使其能够处理大规模并行计算任务,尤其适用于图形渲染、数值模拟和机器学习等领域。为了利用GPU的计算潜力,开发人员通常需要借助GPU编程库,如Nvidia的CUDA和Apple推广的OpenCL。CUDA是Nvidia特有的并行计算平台,提供了C/C++的原生支持。而OpenCL则是一个跨平台的开放标准,允许开发者编写一次代码,就能在不同厂商的GPU上运行。尽管OpenCL的通用性可能会导致性能损失,但它降低了学习和移植的成本。 编程GPU的过程通常涉及定义核函数(kernel function),这些函数将在GPU的多个线程上并行执行。例如,对于图像处理任务,可以为每个像素分配一个线程,执行特定操作,如加法。通过这种方式,GPU可以在短时间内处理大量像素,极大地加速了计算速度。 CUDA程序通常包含三个主要部分:主机代码(Host Code)、设备代码(Device Code)和核函数。主机代码在CPU上运行,负责管理数据传输到GPU,启动核函数,以及接收结果。设备代码则包含在核函数中,这些函数在GPU上并行执行。在实践中,GPU加速的效果显著,如P&D DEM图像预处理算法的示例,即使在较旧的GPU如GeForce GT 330上也能实现20倍的加速,而在更专业的Tesla M2075上,加速比接近100倍。 GPU是专为处理大量数据和并行计算而设计的,其并行结构和优化的硬件使其在图形处理和计算密集型任务中展现出卓越的性能。通过使用CUDA和OpenCL等编程工具,开发者能够充分利用GPU的优势,实现高效的计算解决方案。

- 粉丝: 6

- 资源: 926

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- C#ASP.NET手机终端进销存系统源码数据库 SQL2008源码类型 WebForm

- 8款不同的404页面,告诉用户“页面未找到”

- 通过@property实现可控进度条 vue 进度条

- (源码)基于C和Java的网络通信与数据处理系统.zip

- C#ASP.NET多用户微信商城分销直销平台源码数据库 SQL2008源码类型 WebForm

- (源码)基于Spring Cloud Alibaba的微服务管理系统.zip

- (源码)基于C#的电动车销售管理系统.zip

- (源码)基于Spring Boot和Vue的博客管理系统.zip

- (源码)基于快应用框架的轻量级应用管理系统.zip

- (源码)基于QT的景点管理系统.zip

信息提交成功

信息提交成功

评论0