【Spark内核篇04】SparkShuffle解析1

需积分: 0 103 浏览量

更新于2022-08-04

收藏 703KB PDF 举报

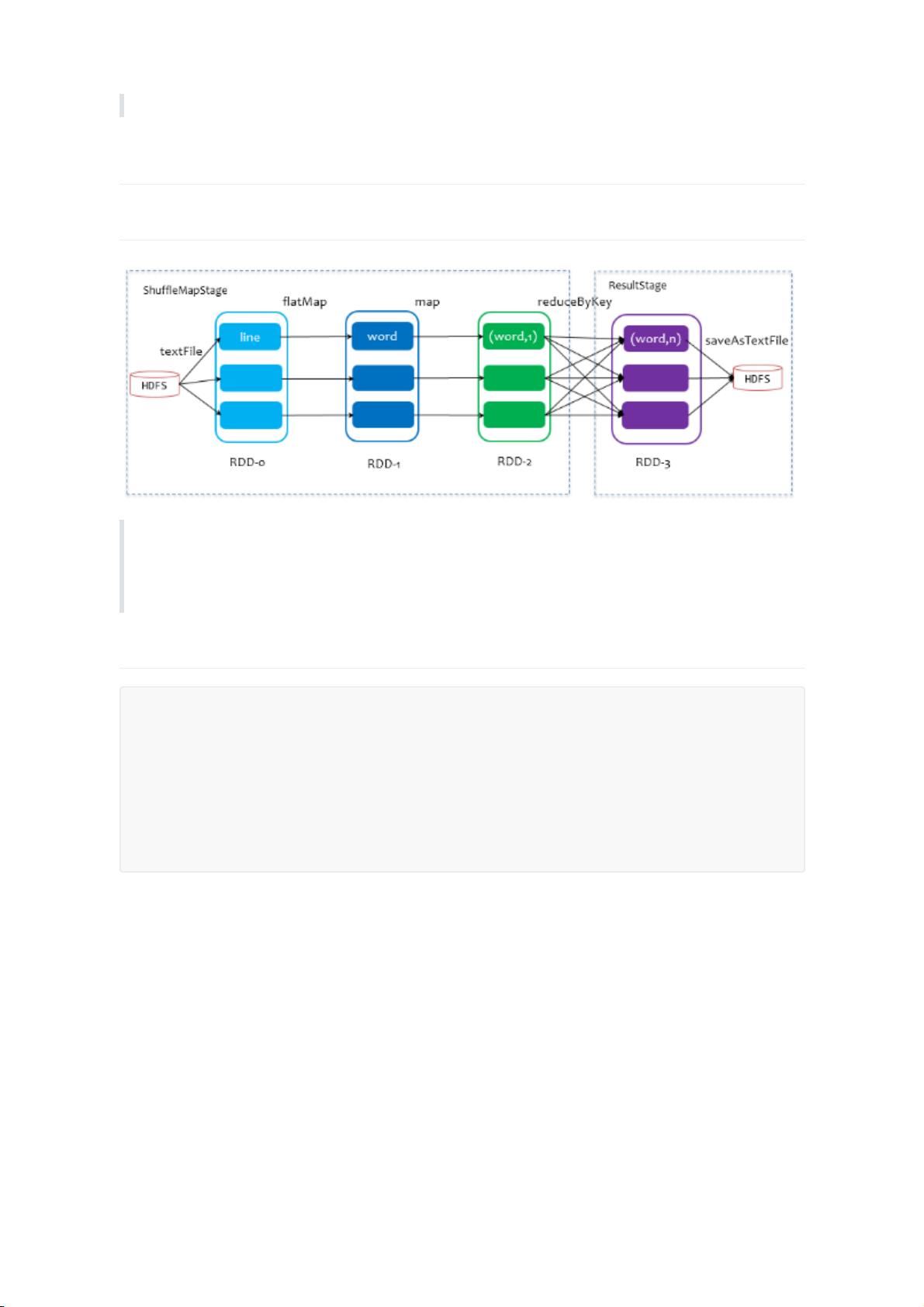

Spark Shuffle是Apache Spark中处理大规模数据并行运算的关键步骤,它是数据在不同节点间重新分布的过程,用于确保数据在执行shuffle操作(如reduceByKey、join等)时能够正确地分发到合适的executor或reducer。在Spark作业执行过程中,Shuffle发生在ShuffleMapStage和ResultStage之间。

ShuffleMapStage是作业执行的第一阶段,它由一系列map任务组成,这些任务处理输入数据并将结果分组。每个ShuffleMapStage结束后,会生成一些中间结果,这些结果会被写入磁盘,形成所谓的shuffle文件。这些文件是按照特定的分区策略(如哈希分区)组织的,以准备供ResultStage的reducer使用。

ResultStage,也称为finalStage,对应于应用程序中的action操作,如count、collect等。当action触发时,Spark会启动一个新的Job,Job由一个或多个Stage组成,ResultStage是Job的最后一个Stage,它将对ShuffleMapStage产生的数据进行处理,完成最后的计算。

接下来,我们详细探讨几种shuffle实现:

1. **HashShuffle**: 在这种模式下,每个executor上的task使用哈希函数对键进行分区,使得相同键的数据被分到同一分区。每个task会为每个分区创建一个缓冲区,将相同键的数据收集到一起。当缓冲区达到一定大小或者任务结束时,缓冲区中的数据会被写入磁盘。原始的HashShuffle会生成大量小文件,这可能导致磁盘I/O开销增加。为优化这一点,Spark引入了合并机制(通过设置`spark.shuffle.consolidateFiles`为true),将小文件合并为更少的大文件,降低磁盘读取的次数。

2. **SortShuffle**: 在SortShuffle中,数据首先被写入内存数据结构,如Map(对于reduceByKey)或ArrayList(对于join),并进行局部排序。当达到一定阈值或任务结束时,内存中的数据被写入磁盘。在溢写磁盘前,数据会根据key进行排序,然后分批写入磁盘文件。这个过程会产生多个临时文件,最后通过merge过程将它们合并成一个文件,同时创建索引文件以定位数据。

3. **Bypass Merge SortShuffle**: 当满足特定条件(map任务数量小于`spark.shuffle.sort.bypassMergeThreshold`且非聚合类shuffle算子)时,Spark会使用bypass机制,跳过排序过程。每个task会为每个reducer创建一个磁盘文件,直接根据key的哈希值写入,同样先写入内存缓冲区,然后溢写到磁盘。尽管这个过程不进行排序,但最后仍然会合并所有临时文件,形成一个最终文件,性能开销较小。

Spark Shuffle是分布式计算中的重要环节,它涉及到数据的重新分布,以支持高效的并行计算。不同类型的shuffle机制有各自的优缺点,优化的目标是在保持计算效率的同时,减少不必要的磁盘I/O和网络传输。理解这些机制有助于我们更好地设计和调优Spark应用程序,以提高整体性能。

艾法

- 粉丝: 29

- 资源: 319

最新资源

- 家庭用具检测15-YOLO(v8至v11)数据集合集.rar

- deploy.yaml

- PHP快速排序算法实现与优化

- 2023-04-06-项目笔记 - 第三百五十五阶段 - 4.4.2.353全局变量的作用域-353 -2025.12.22

- 2023-04-06-项目笔记 - 第三百五十五阶段 - 4.4.2.353全局变量的作用域-353 -2025.12.22

- pdfjs2.5.207和4.9.155

- 认识小动物-教案反思.docx

- csi-driver-nfs

- 冒泡排序算法详解及Java与Python实现

- 字幕网页文字检测20-YOLO(v5至v11)、COCO、CreateML、Paligemma、TFRecord、VOC数据集合集.rar