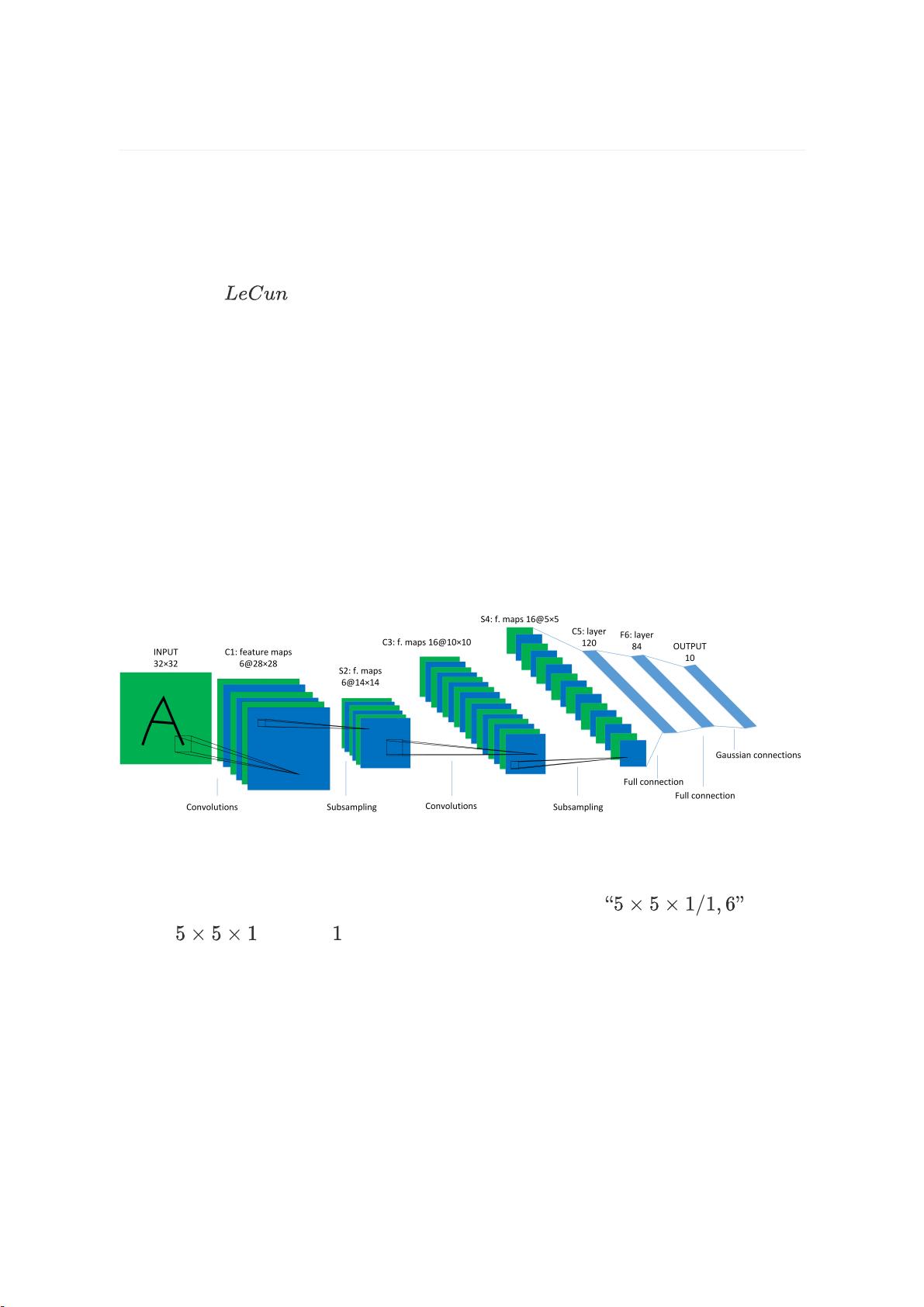

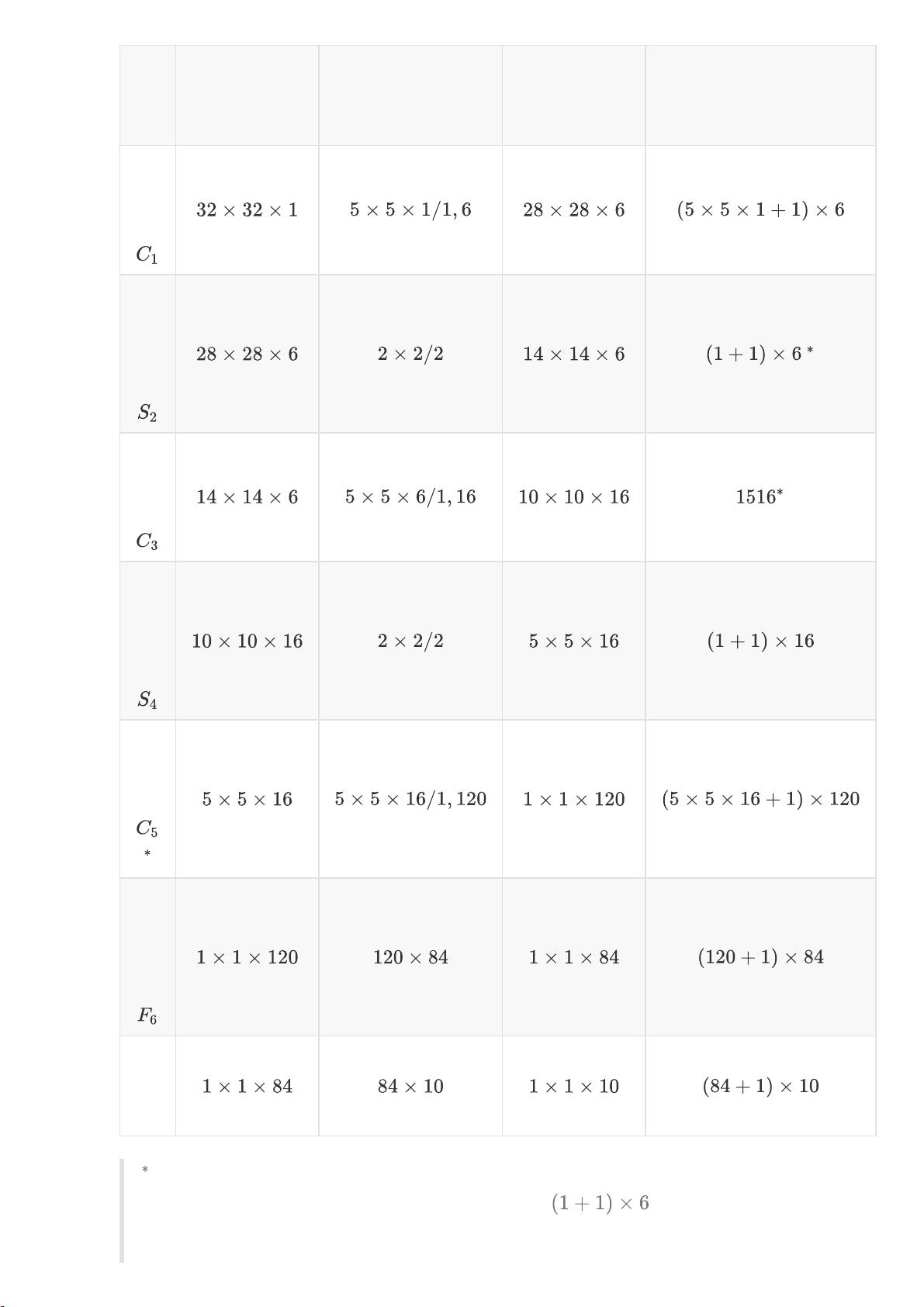

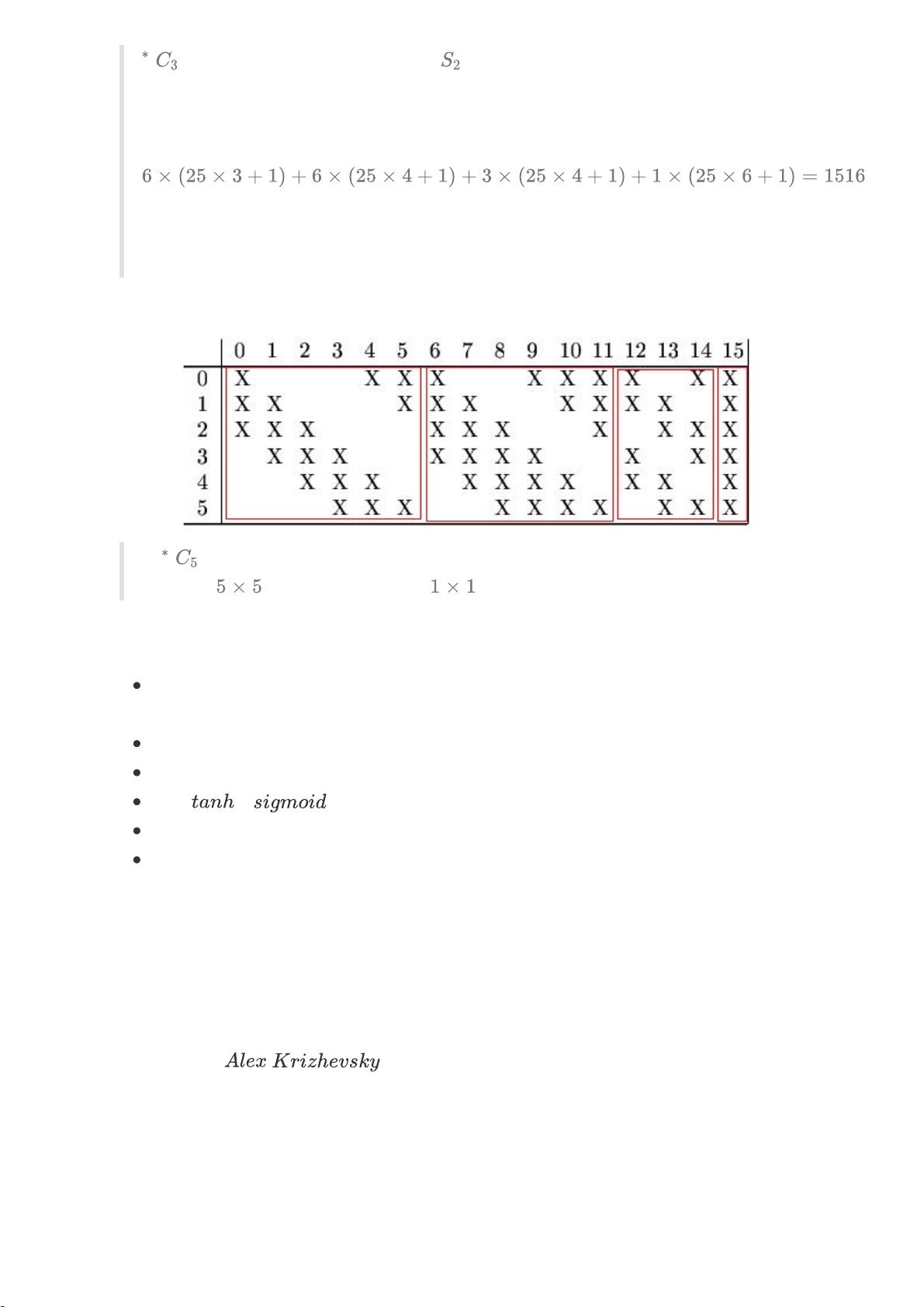

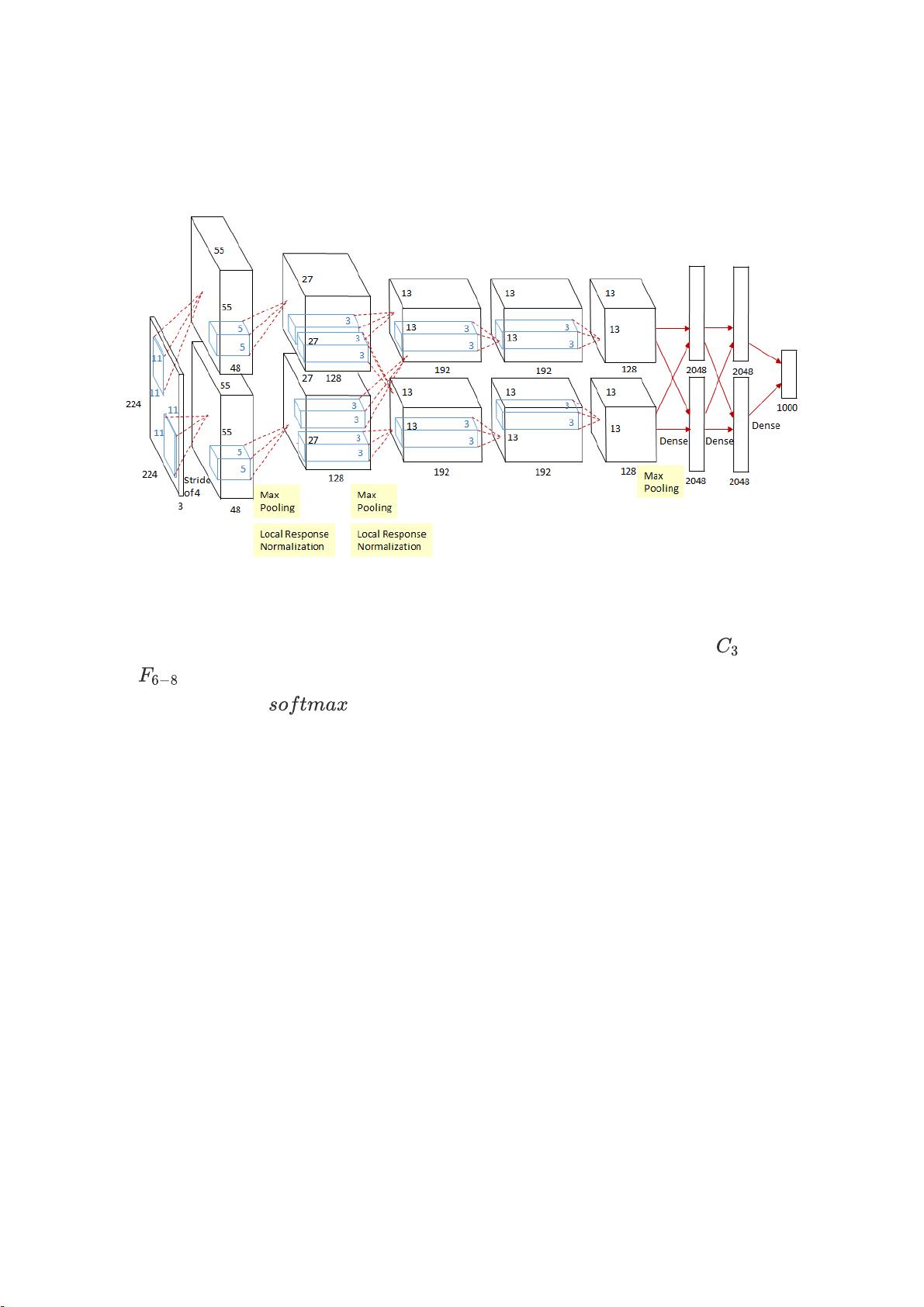

卷积神经网络(CNN)是深度学习领域的重要组成部分,尤其在图像识别和处理任务中表现卓越。本篇文章将深入探讨两个经典卷积神经网络模型——LeNet-5和AlexNet。 1. LeNet-5 LeNet-5是1998年由Yann LeCun等人提出的,主要用于手写数字和机器印刷字符识别。该模型的核心思想是利用卷积、下采样和非线性映射来提取和识别图像特征。 1.1 模型介绍 LeNet-5展示了卷积操作如何通过参数共享来捕捉像素间的空间关系。网络结构包括2个卷积层、2个下采样层和3个全连接层,为现代深度学习图像识别网络奠定了基础。 1.2 模型结构 LeNet-5的网络结构由7层构成,不包括输入层。卷积层通过滤波器提取特征,下采样层减少计算量并保持重要信息,全连接层则用于分类。下采样层的参数不为零,而是乘以系数和加上偏置。卷积层使用稀疏连接,限制了连接数以适应当时的计算能力,并强制不同特征图组合以学习多样特征。 1.3 模型特性 - 序列组合:卷积-下采样-非线性映射,是LeNet-5的关键特性,也是现代CNN的基础。 - 空间特征提取:卷积层用于捕捉空间相关性。 - 下采样:通过映射空间均值实现。 - 非线性映射:使用激活函数如Sigmoid或ReLU引入非线性。 - 稀疏连接:减少连接数,降低计算成本。 2. AlexNet 2.1 模型介绍 AlexNet是Alex Krizhevsky等人在2012年提出的,它首次在ILSVRC图像分类竞赛中取得显著成果,推动了CNN在计算机视觉领域的广泛应用。AlexNet使用GPU加速计算,使深层网络成为可能。 2.2 模型结构 AlexNet共有8层,包括5个卷积层和3个全连接层。网络设计为双GPU并行处理,除特定层外,两个GPU各自计算一部分。最后一层全连接层输出1000类的概率分布。与LeNet-5相似,但更复杂,包括局部响应规范化(LRN)和更大规模的卷积核。 2.3 模型特性 - GPU加速:使得大型网络的训练成为可能。 - 层间并行:两个GPU协同工作,提高计算效率。 - LRN:用于增强局部特征的区分性。 - 大规模卷积核:增加了模型的表达能力。 总结: LeNet-5和AlexNet都是卷积神经网络的里程碑,它们的成功在于卷积层的特征提取、下采样的信息保留以及非线性映射的引入。AlexNet在LeNet-5的基础上进一步深化网络,使用GPU并行计算,提高了处理复杂问题的能力。这两个模型的创新对后续的深度学习模型产生了深远影响,如VGG、ResNet等,进一步推动了深度学习的发展。

剩余21页未读,继续阅读

- 粉丝: 37

- 资源: 326

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功

评论0