Esri大数据平台搭建指南之HDFS1

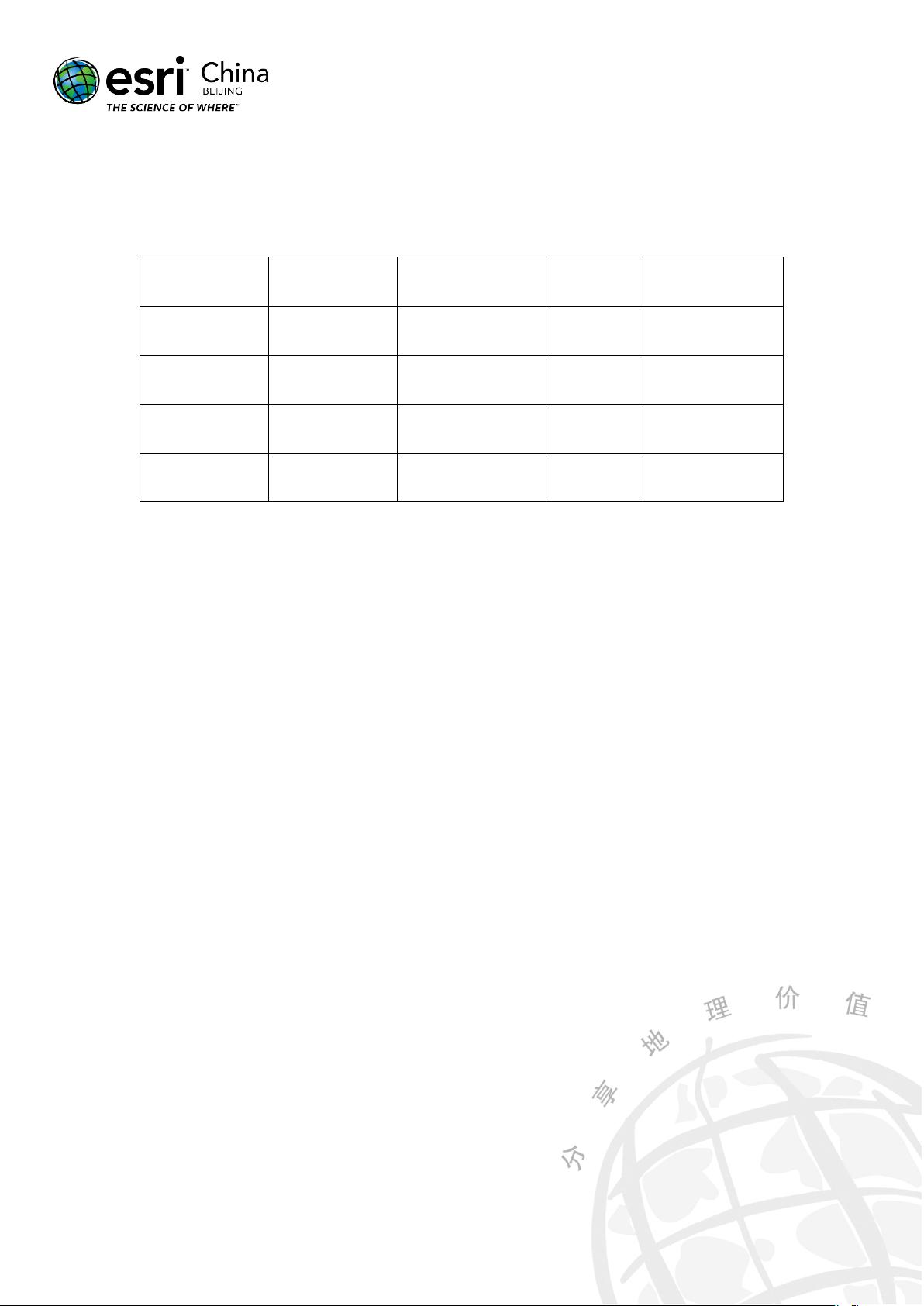

Esri大数据平台搭建指南之HDFS1 一、HDFS简介 HDFS(Hadoop Distributed File System)是Hadoop生态系统中的一个分布式文件系统,旨在存储和处理大规模数据。HDFS具有高可扩展性、可靠性和高性能的特点,可以满足大数据处理的需求。HDFS由两部分组成:NameNode和DataNode。NameNode负责维护文件系统的命名空间,DataNode负责存储文件的数据块。 二、搭建环境概览 1. 硬件环境 大数据平台搭建需要满足一定的硬件配置要求,包括服务器、存储设备、网络设备等。服务器需要配置高性能的CPU、内存和存储空间,以满足大数据处理的需求。存储设备需要选择高性能的硬盘,以提高数据的读写速度。网络设备需要选择高速的交换机和路由器,以确保数据的传输速度。 2. 操作系统 大数据平台搭建需要选择合适的操作系统,包括Linux和Windows。Linux是最常用的操作系统,包括 CentOS、Ubuntu、Red Hat等。Windows也可以作为大数据平台搭建的操作系统,但是需要选择高性能的服务器。 3. 软件介质 大数据平台搭建需要选择合适的软件介质,包括Hadoop、Spark、Hive等。Hadoop是大数据处理的基础平台,提供了分布式文件系统HDFS和计算引擎MapReduce。Spark是一个基于内存的计算引擎,提供了高性能的数据处理能力。Hive是一个数据仓库工具,提供了数据的存储和查询能力。 4. 测试数据 大数据平台搭建需要准备测试数据,包括原始数据和处理后的数据。测试数据需要满足一定的规模和复杂度,以确保大数据平台的可靠性和高性能。 5. 可选软件 大数据平台搭建需要选择合适的可选软件,包括数据挖掘、机器学习和数据可视化等。数据挖掘可以帮助用户发现数据中的隐藏模式和关系。机器学习可以帮助用户构建预测模型和分类模型。数据可视化可以帮助用户直观地了解数据的分布和变化。 三、HDFS 搭建 1. 基础环境准备 HDFS搭建需要准备基础环境,包括操作系统、Hadoop安装包和 SSH免密登陆工具。操作系统需要选择合适的 Linux版本,包括CentOS、Ubuntu、Red Hat等。Hadoop安装包需要选择合适的版本,包括Hadoop 2.x和Hadoop 3.x。SSH免密登陆工具需要选择合适的工具,包括SSH和 PuTTY等。 2. 配置 SSH 免密登陆 HDFS搭建需要配置 SSH 免密登陆,以便于自动化Hadoop集群的管理。SSH免密登陆需要生成公钥和私钥,并将公钥复制到Hadoop集群的所有节点上。 3. 启动 Hadoop 集群 HDFS搭建需要启动 Hadoop 集群,以便于大数据处理。Hadoop 集群需要配置合适的节点,包括NameNode、DataNode和ResourceManager等。ResourceManager负责调度作业和资源管理。NameNode负责维护文件系统的命名空间。DataNode负责存储文件的数据块。 Esri大数据平台搭建指南之HDFS1提供了大数据平台搭建的详细指导,包括HDFS简介、搭建环境概览和HDFS搭建等。通过遵循本指南,可以快速搭建大数据平台,满足大数据处理的需求。

剩余16页未读,继续阅读

信息提交成功

信息提交成功

评论0

最新资源