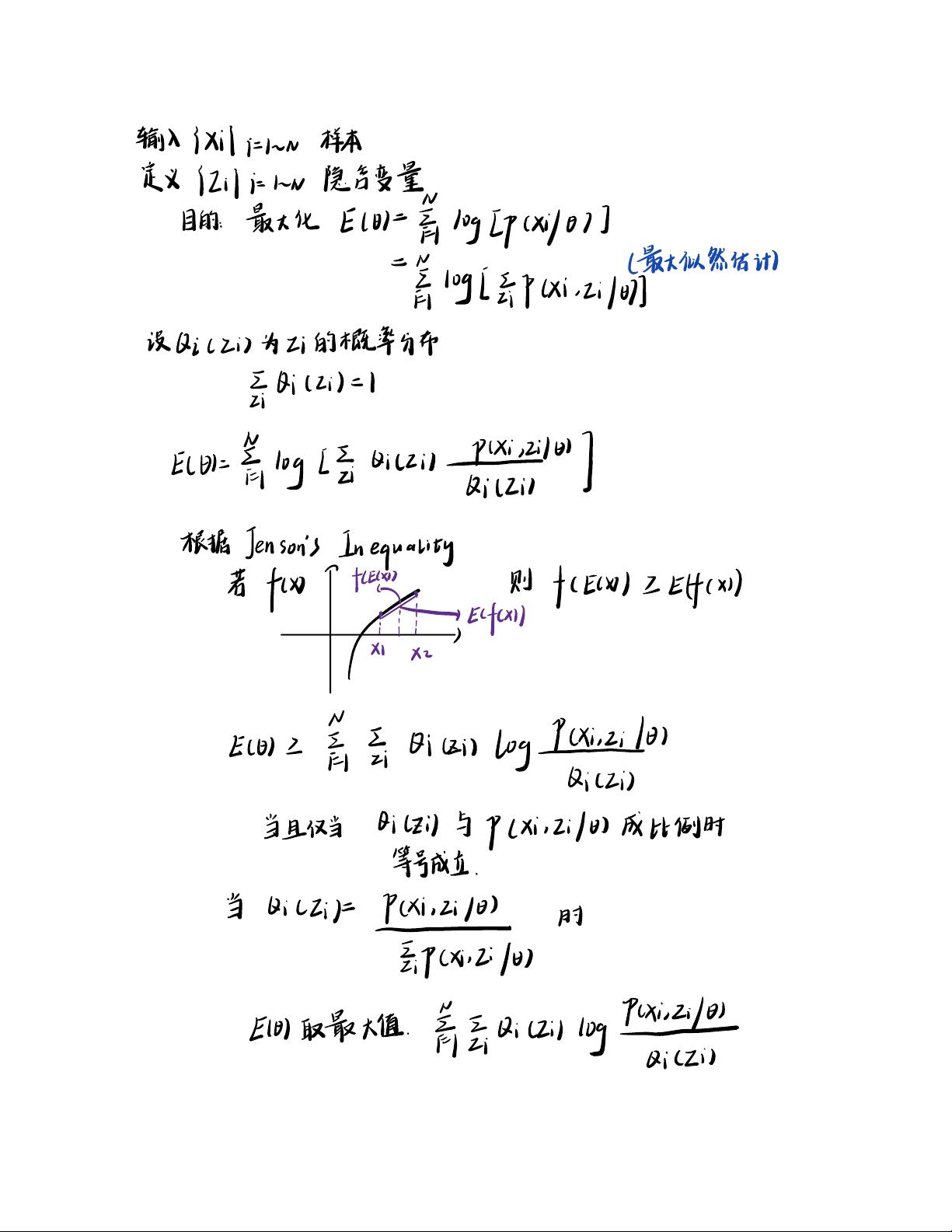

EM算法,全称为期望最大化(Expectation-Maximization)算法,是一种在统计学和机器学习领域广泛应用的迭代方法,主要用于含有隐含变量的概率模型的最大似然估计。在本节我们将探讨EM算法的收敛性证明。 我们设定问题背景:假设我们有一组观测数据 \( \mathbf{x} = (x_1, x_2, ..., x_n) \),其中每个样本 \( x_i \) 可能与一个隐含变量 \( Z \) 相关。我们的目标是找到参数 \( \theta \) 的最大似然估计 \( \hat{\theta} \),但因为隐含变量的存在,直接最大化似然函数变得困难。 EM算法通过引入中间概率分布 \( Q(Z) \) 来解决这个问题。在E步骤(期望步骤)中,我们固定当前的参数估计 \( \theta^{(t)} \) 并计算 \( Q(Z) \),通常选择为 \( Q(Z) = P(Z | \mathbf{x}, \theta^{(t)}) \)。在M步骤(最大化步骤)中,我们用E步骤得到的 \( Q(Z) \) 来更新参数估计,最大化 \( Q \) 对应的对数似然函数,即 \( \theta^{(t+1)} = \arg\max_{\theta} \mathcal{L}(\theta | Q) \)。 描述中提到的Jensen's不等式是证明EM算法收敛性的一个关键工具。Jensen's不等式指出,对于任意凸函数 \( f \) 和随机变量 \( Z \),有 \( f(E[Z]) \leq E[f(Z)] \),等号成立当且仅当 \( Z \) 是常数。应用到EM算法,我们可以得到 \( \mathcal{L}(\theta^{(t+1)} | \mathbf{x}) \geq \mathcal{L}(\theta^{(t)} | \mathbf{x}) \),即每次迭代后对数似然函数非减。 在E步骤中,根据Jensen's不等式,我们有 \( E_{Q^{(t)}}[\log p(\mathbf{x}, Z | \theta)] \geq \log E_{Q^{(t)}}[p(\mathbf{x}, Z | \theta)] = \log p(\mathbf{x} | \theta^{(t)}) + const \),其中 \( const \) 是不依赖于 \( \theta \) 的常数。M步骤保证了新的参数 \( \theta^{(t+1)} \) 使得E步骤中的期望最大化,因此 \( \mathcal{L}(\theta^{(t+1)} | \mathbf{x}) \) 不会比 \( \mathcal{L}(\theta^{(t)} | \mathbf{x}) \) 小。 接下来,我们讨论EM算法的收敛性。设 \( M^{(t)} \) 为第 \( t \) 次迭代的对数似然函数值,那么有 \( M^{(t+1)} \geq M^{(t)} \)。由于似然函数是非负的,\( M^{(t)} \) 有上界,即 \( M^{(t)} \leq \log p(\mathbf{x}) \)。随着迭代次数增加,\( M^{(t)} \) 会逐渐增大并趋于某个局部极大值或全局极大值,这表明EM算法能够确保参数估计序列 \( \theta^{(1)}, \theta^{(2)}, ... \) 逐步接近最优解。 在实际应用中,EM算法的收敛速度并不总是很快,可能需要多次迭代才能达到满意的结果。有时,初始化选择对算法的性能有很大影响。例如,在聚类问题中,K均值算法可以视为EM算法的一个特例,其收敛性可以通过类似的方法证明。在K均值中,每个样本被分配到最近的簇中心,然后簇中心被更新为该簇内所有样本的均值,这个过程不断迭代直至簇中心不再显著变化。 总结起来,EM算法通过交替进行期望和最大化步骤,能够在含有隐含变量的模型中寻找最大似然估计,并且具有理论上的收敛性保证。通过Jensen's不等式,我们可以证明每次迭代后对数似然函数非减,从而确保算法能够逐步接近局部最优解。在实际应用中,需要注意初始化策略的选择以及迭代次数的控制,以确保算法的效率和结果的准确性。

- 粉丝: 22

- 资源: 316

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功

评论0