支持向量机通俗导论(理解SVM的三层境界)LaTeX最新版_2015.1.91

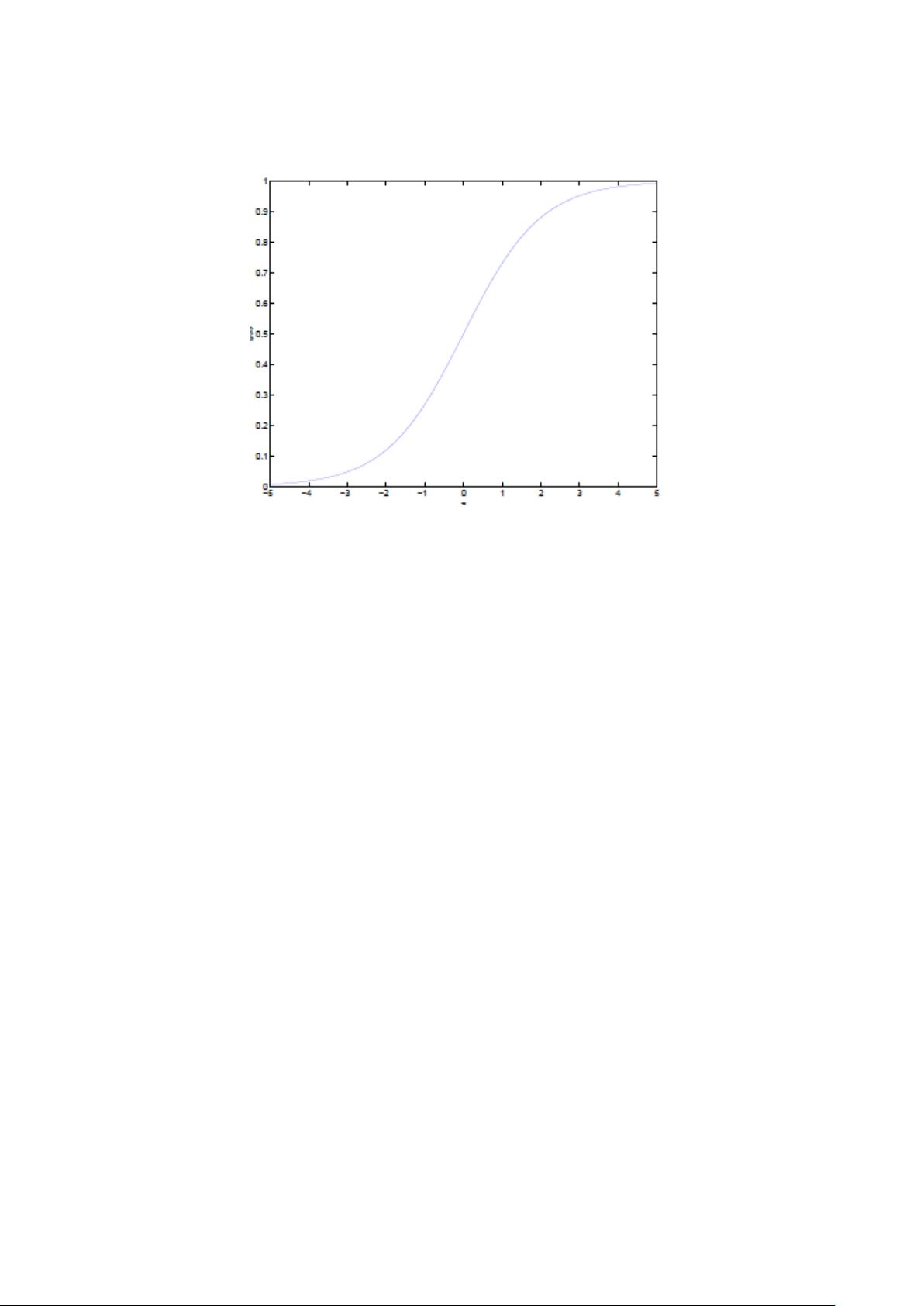

支持向量机(Support Vector Machine,简称 SVM)是一种在机器学习领域广泛应用的监督学习模型,尤其在分类和回归任务中表现出色。SVM的核心思想是找到一个最优的超平面,使得不同类别的样本尽可能地被分隔开来,同时保持最大的间隔。 ### 第一层:了解 SVM #### 分类标准的起源 分类问题旨在将数据划分到不同的类别中。SVM通过构建决策边界(即超平面)来实现这一目标。最初的分类方法可以追溯到统计学中的判别分析,SVM则通过最大化间隔来优化这一过程。 #### 线性分类的例子 在二维空间中,线性分类可以通过画一条直线或高维空间中的超平面来实现。SVM的目标是找到这条能最大化两类样本间隔的直线或超平面。 #### 函数间隔与几何间隔 **函数间隔** 是分类器预测错误率的度量,而**几何间隔** 考虑了样本点到超平面的实际距离,是函数间隔的标准化版本,确保了间隔的一致性。 #### 最大间隔分类器 SVM选择的是能最大化几何间隔的超平面,这有助于提高模型的泛化能力,因为它更注重于那些离决策边界最近的样本(支持向量)。 ### 第二层:深入 SVM #### 从线性可分到线性不可分 在实际问题中,数据往往不是线性可分的。为了解决这个问题,SVM引入了**软间隔**,允许某些样本点可以穿越决策边界,但要付出一定的代价(惩罚项)。 #### 从原始问题到对偶问题的求解 原始问题直接优化间隔,但在处理非线性问题时变得复杂。通过对偶问题,我们可以利用拉格朗日乘子法,将问题转化为求解特征空间中的核函数,简化了计算。 #### 对偶问题的条件 对偶问题的求解依赖于KKT条件(Karush-Kuhn-Tucker conditions),这些条件保证了原始问题和对偶问题解的一致性。 #### 对偶问题求解的三个步骤 1. **构造拉格朗日函数** 2. **应用KKT条件** 3. **求解二次规划问题** #### 线性不可分的情况与核函数 核函数是SVM处理非线性问题的关键。它通过将数据从原始特征空间映射到高维的特征空间,在新空间中实现线性可分。 #### 核函数的隐式映射 核函数允许我们不直接操作高维特征空间,而是通过内积的形式间接进行计算,简化了计算过程。 #### 处理非线性数据的核函数 常见的核函数有线性核、多项式核、高斯核(RBF)和sigmoid核等。这些核函数能处理不同类型的非线性问题。 #### 核函数的本质 核函数的本质是找到一种映射,使得原本在低维空间中非线性可分的数据在高维空间中变得线性可分。 #### 使用松弛变量处理非线性 松弛变量(slack variables)允许数据点越过决策边界,以适应非线性或噪声数据。 #### 感知器算法与SVM 感知器是线性分类器的一种,它与SVM类似,但没有最大化间隔的概念。SVM通过最大化间隔提高了分类性能和泛化能力。 #### 非线性学习器与最大间隔定理 SVM是非线性学习器,其最大间隔定理保证了在找到最优分类超平面的同时,最大化了模型的泛化能力。 #### 损失函数与最小二乘法 SVM的损失函数通常选用合页损失(Hinge Loss),它衡量的是样本点未正确分类的程度。最小二乘法是另一种常用的损失函数,常用于线性回归问题,通过最小化预测值与真实值之间的平方误差来寻找最佳拟合。 ### 总结 SVM作为一种强大的分类工具,通过优化间隔和引入核函数解决了非线性问题。理解SVM的三层境界,即从基础概念到深入理论,再到实际应用,对于掌握SVM的精髓至关重要。

剩余51页未读,继续阅读

- 粉丝: 24

- 资源: 337

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- VB+ACCESS超市管理系统设计(源代码+系统)(20245h).7z

- VB+ACCESS自动组卷系统(源代码+系统)(2024no).7z

- VB+ACCESS药品供销存贮系统(源代码+系统+开题报告+外文翻译+英文文献+答辩PPT)(20242k).7z

- VB+access药品供销存贮系统(系统+封面+开题报告+论文+任务书+答辩PPT+外文文献+中文翻译)(2024d0).7z

- vb+access职工工资管理信息系统(系统+开题+论文+任务书)(2024xq).7z

- VB+ACCESS网络计时管理系统设计(源代码+系统)(2024gv).7z

- VB+ACCESS网吧计费系统(源代码+系统)(2024yz).7z

- vb+access学籍管理系统(20246x).7z

- vb+access学籍管理系统(系统+论文)(20240b).7z

- VB+ACcess学生成绩管理系统(开题报告+答辩PPT+论文+系统)(2024on).7z

- VB+ACcess学生成绩管理系统(论文+系统+答辩PP)(2024r5).7z

- VB+ACCESS学生档案管理系统(论文)(2024h0).7z

- vb+ACCESS学生档案管理系统(论文+源代码)(2024ql).7z

- VB+access学生管理系统(论文+系统)(2024am).7z

- vb+access学生公寓管理系统(论文+系统)(2024g7).7z

- VB+ACCESS学生公寓管理系统(源代码+系统)(2024vq).7z

信息提交成功

信息提交成功

评论0