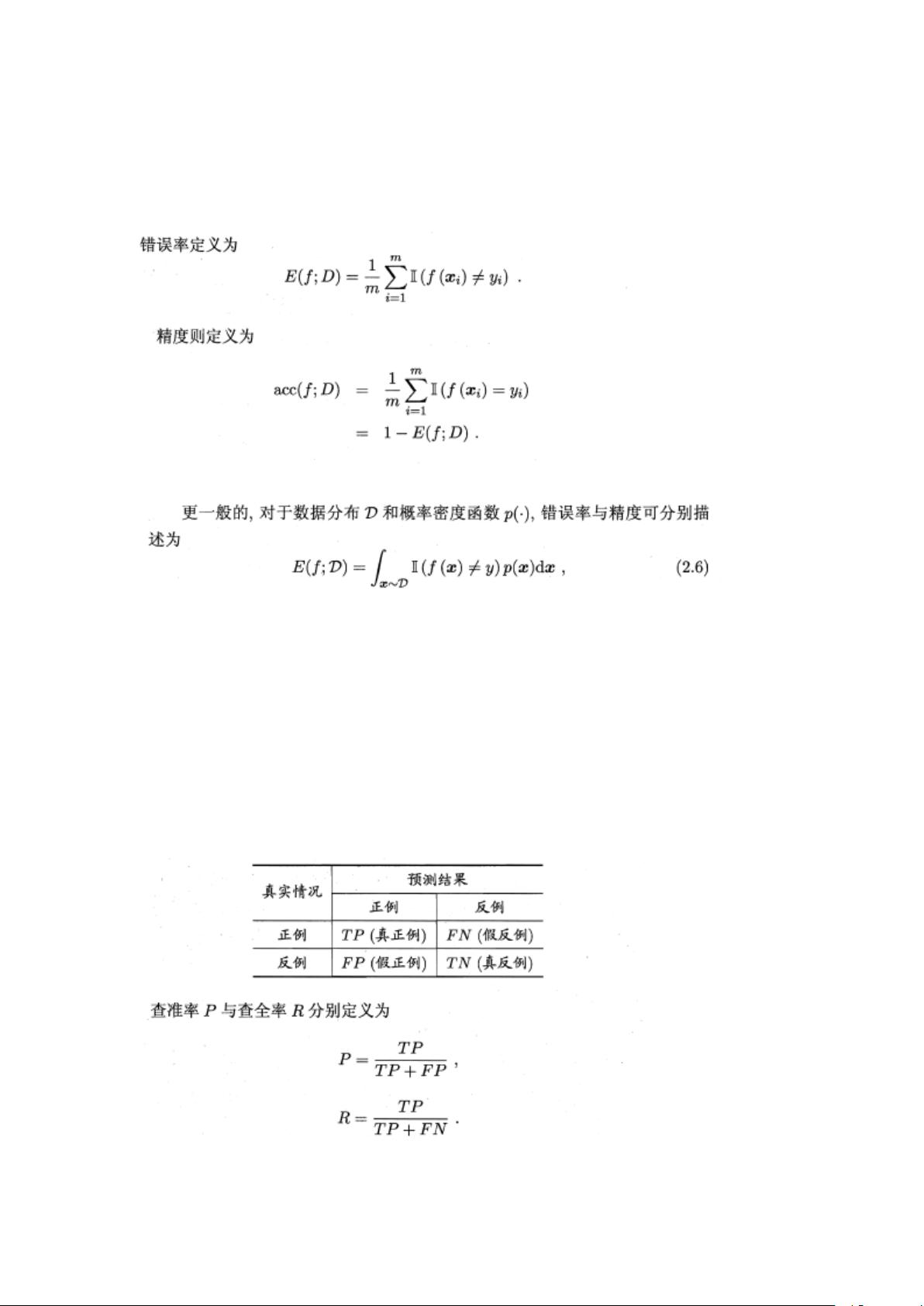

在机器学习领域,模型评估与选择是至关重要的步骤,它确保我们选择的模型能够在未知数据上表现出良好的泛化能力。本章主要涵盖了三个关键概念:性能度量、比较检验以及偏差与方差。我们关注性能度量,这是衡量模型预测能力的关键指标。 2.5 性能度量 性能度量用于量化模型在预测任务上的表现,可以是针对回归任务或分类任务。在回归任务中,如房价预测,均方误差(MSE)是最常用的指标,它衡量了模型预测值与真实值之间的平均差异。在分类任务中,错误率和精度是常用的性能度量,错误率是分类错误的样本数占总样本数的比例,而精度则是分类正确的样本数占比,两者之和为1。 2.5.1 最常见的性能度量 对于分类问题,除了错误率和精度外,查准率和查全率也是重要的评估指标。查准率(Precision)是指分类为正例且实际为正例的样本数占预测为正例的样本总数的比例,而查全率(Recall)是分类为正例且实际为正例的样本数占实际正例总数的比例。查准率和查全率之间存在权衡,提高一方通常会牺牲另一方。P-R曲线描绘了在不同阈值下查准率与查全率的变化,通过曲线下的面积或平衡点(BEP)可以比较不同模型的性能。 2.5.2 F1分数与宏观/微观评估 F1分数是查准率和查全率的调和平均,特别地,F1分数是当β=1时的Fβ分数,它提供了一个综合考虑查准率和查全率的单一指标。在处理多分类问题时,有宏观和微观两种评估方式。宏观F1是各分类F1分数的平均,而微观F1则是总体TP、FP、TN、FN的平均。 2.5.3 ROC曲线与AUC ROC曲线则通过真正例率(TPR)与假正例率(FPR)来评估模型的性能,它考察的是模型对正例和负例排序的准确性。ROC曲线下的面积(AUC)是衡量模型区分正负样本能力的无量纲指标,AUC越大,模型的性能越好。 在比较多个学习器时,如果一个学习器的P-R曲线被另一个完全包住,那么后者性能更优;若曲线交叉,通常通过比较曲线下的面积或平衡点来决定优劣。在实际应用中,根据具体任务的需求和场景,选择合适的性能度量是至关重要的,这有助于我们选择最合适的模型并优化其性能。

剩余8页未读,继续阅读

- 粉丝: 30

- 资源: 336

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- (174717862)有源滤波电路1-模电Multisim仿真实验

- (3822212)单片机Proteus仿真

- (481250)Proteus 与单片机 仿真

- (179979052)基于MATLAB车牌识别系统【带界面GUI】.zip

- 计算机网络四次实验报告

- (175549404)基于微信小程序的十二神鹿点餐(外卖小程序)(毕业设计,包括数据库,源码,教程).zip

- (179941432)基于MATLAB车牌识别系统【GUI含界面】.zip

- (179941434)基于MATLAB车牌识别系统【含界面GUI】.zip

- (178021462)基于Javaweb+ssm的医院在线挂号系统的设计与实现.zip

- (178047214)基于springboot图书管理系统.zip

信息提交成功

信息提交成功