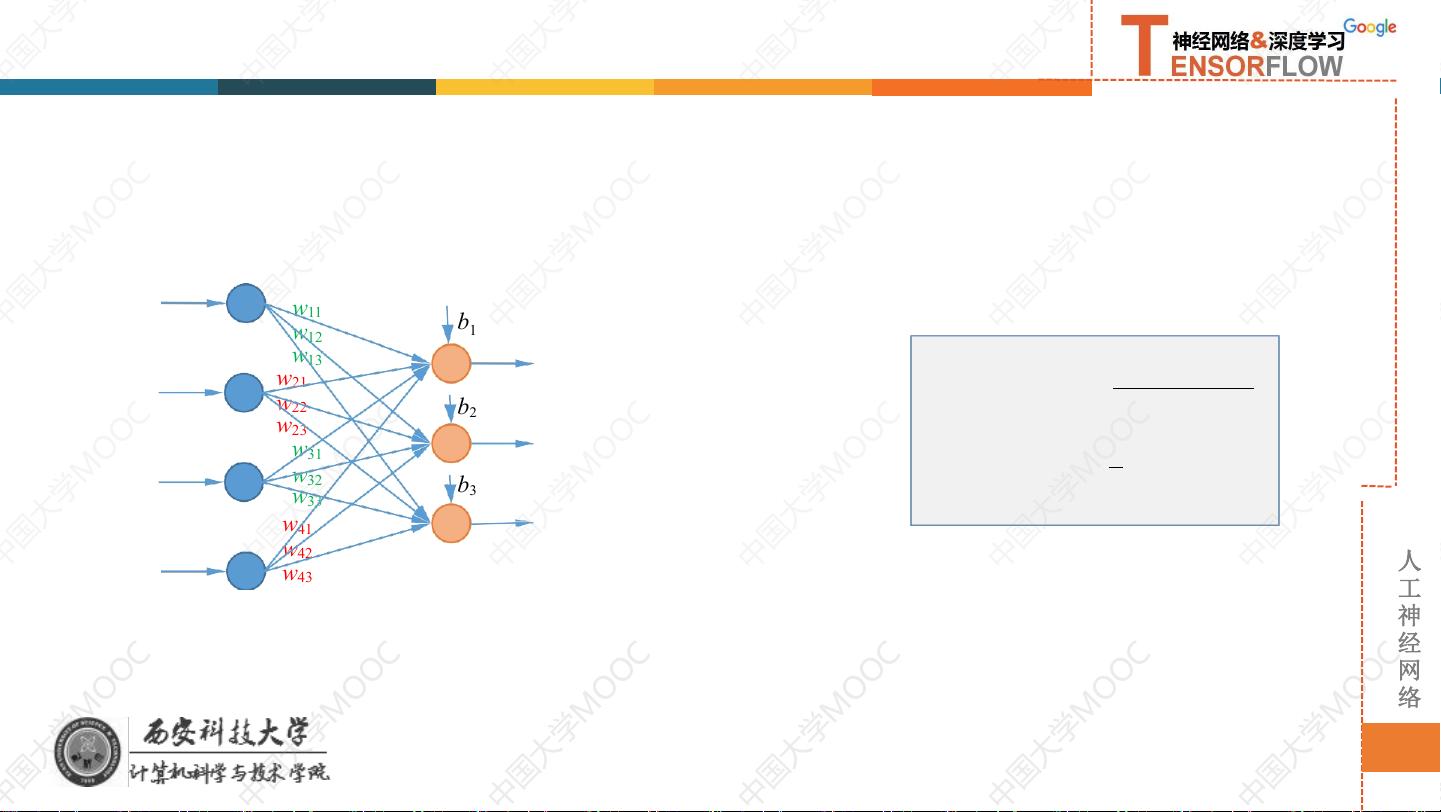

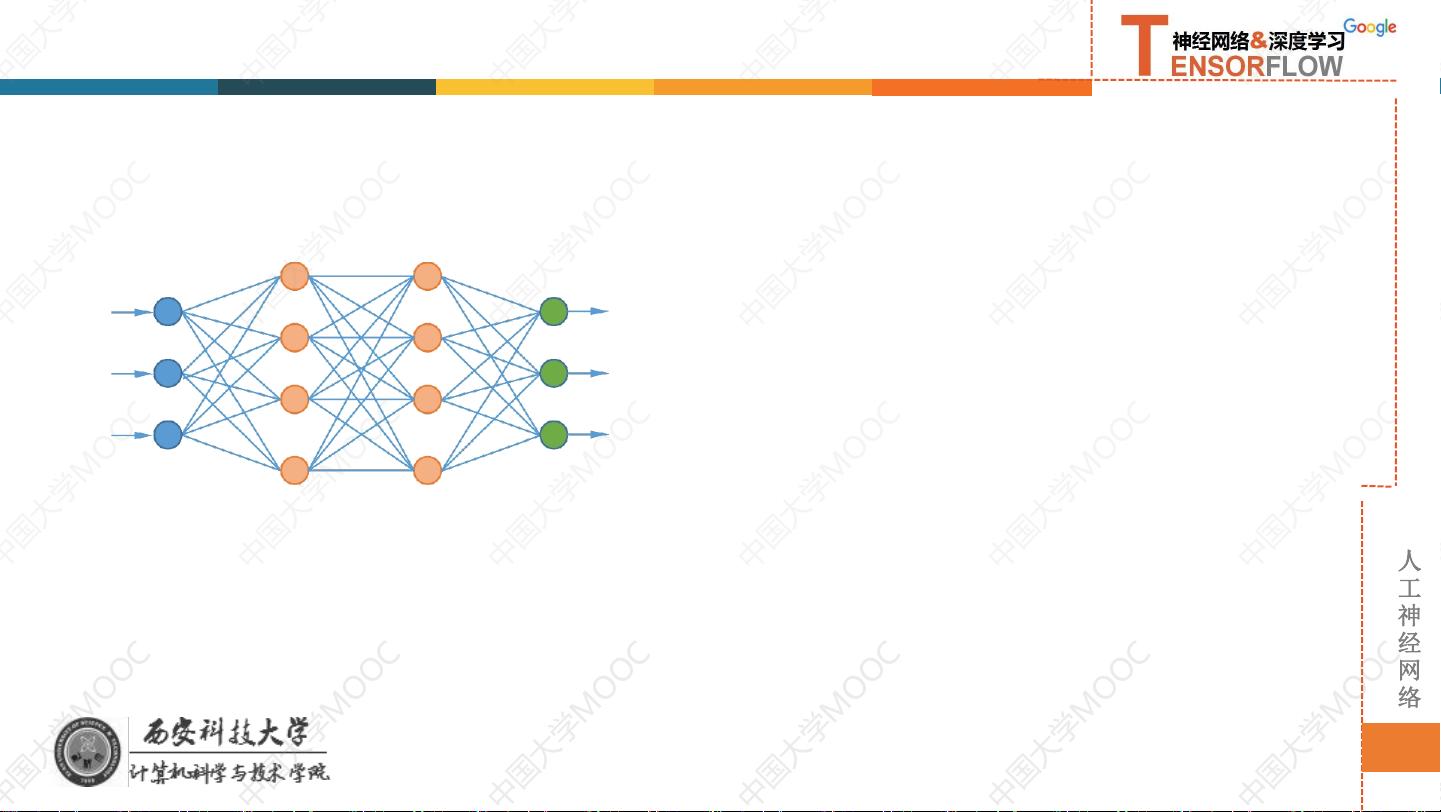

误差反向传播(Backpropagation)算法是神经网络学习的核心方法之一,主要用于多层神经网络的权重和偏置参数的优化。在12.4章节中,它被详细讲解为训练神经网络的一种有效策略,特别是在解决非线性分类问题时。 在人工神经网络中,模型的复杂性通过增加隐藏层的数量得以提升,每个隐藏层由多个神经元组成,这些神经元通过权重与前一层和后一层的神经元连接。权重决定了输入信号在神经元间的传递强度,而偏置则影响神经元激活与否的阈值。误差反向传播算法的目标是找到一组最佳的权重和偏置值,使得网络预测结果与实际数据之间的误差最小。 1. **前向传播**:算法执行前向传播,即输入数据通过网络的每一层,每个神经元对其输入应用一个非线性函数(如Sigmoid、ReLU等),并计算输出。这一过程生成了一个预测输出和实际输出之间的误差。 2. **损失函数**:损失函数(Loss Function)衡量预测输出与真实输出的差异。通常使用交叉熵损失函数或均方误差损失函数。损失函数的导数(梯度)提供了关于权重和偏置如何影响损失的指导。 3. **反向传播**:误差反向传播的关键在于利用链式法则计算损失函数对每个权重和偏置的梯度。这个过程从输出层开始,反向地计算每一层的误差,并将这个误差通过网络“传播”回去,更新每一层的权重和偏置。每层神经元的误差是由其后一层的误差通过权重反向传播得到的。 4. **梯度下降**:在获得了所有权重和偏置的梯度之后,使用梯度下降(Gradient Descent)或其他优化算法(如Adam、RMSprop等)更新这些参数。权重和偏置的更新方向是沿着梯度的负方向,以减小损失函数。 5. **迭代过程**:整个过程(前向传播、计算损失、反向传播、更新参数)会反复进行,直到网络的性能不再显著提高或者达到预设的迭代次数,这被称为一个训练周期或 epoch。 6. **防止过拟合**:为了防止模型在训练集上表现良好但在测试集上表现糟糕(过拟合),可以采取早停法、正则化、Dropout等技术。正则化通过添加一个惩罚项来限制权重的大小,Dropout则在每次训练时随机关闭一部分神经元,以增加模型的泛化能力。 误差反向传播算法在深度学习领域扮演着至关重要的角色,它是许多现代神经网络模型训练的基础,包括卷积神经网络(CNN)、循环神经网络(RNN)以及变种如LSTM和GRU。理解并有效地运用误差反向传播,可以帮助我们构建和训练更强大的神经网络模型,以解决各种复杂的问题。

剩余15页未读,继续阅读

- 粉丝: 39

- 资源: 316

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 房地产经纪公司员工薪酬制度.doc

- 房地产绩效考核指标库.doc

- 精神病学试题和答案.doc

- 计算机一级操作知识点.doc

- 房地产中介员工待遇以及提成标准.doc

- 某房地产公司薪酬体系设计方案.doc

- 房地产薪酬管理制度.doc

- 六年级品德及社会(上册)教学案.doc

- 农村留守儿童教育问题和对策研究.doc

- 房地产薪酬体系.docx

- 房地产公司各岗位职责.docx

- 马克思主义与社会科学方法论习题与答案.doc

- 品牌管理教学大纲.doc

- 区域经济名词解释及其简答(完整版).doc

- 汽机专业新员工培训教材.doc

- IEEE33节点的配电网simulink模型,附带有节点和支路数据详细参考和来源文献 数据已经调试完毕,使用matlab能够正常运行,mdl文件,适合于任何版本,配电网模型中也可以接入分布式电源

信息提交成功

信息提交成功

评论0