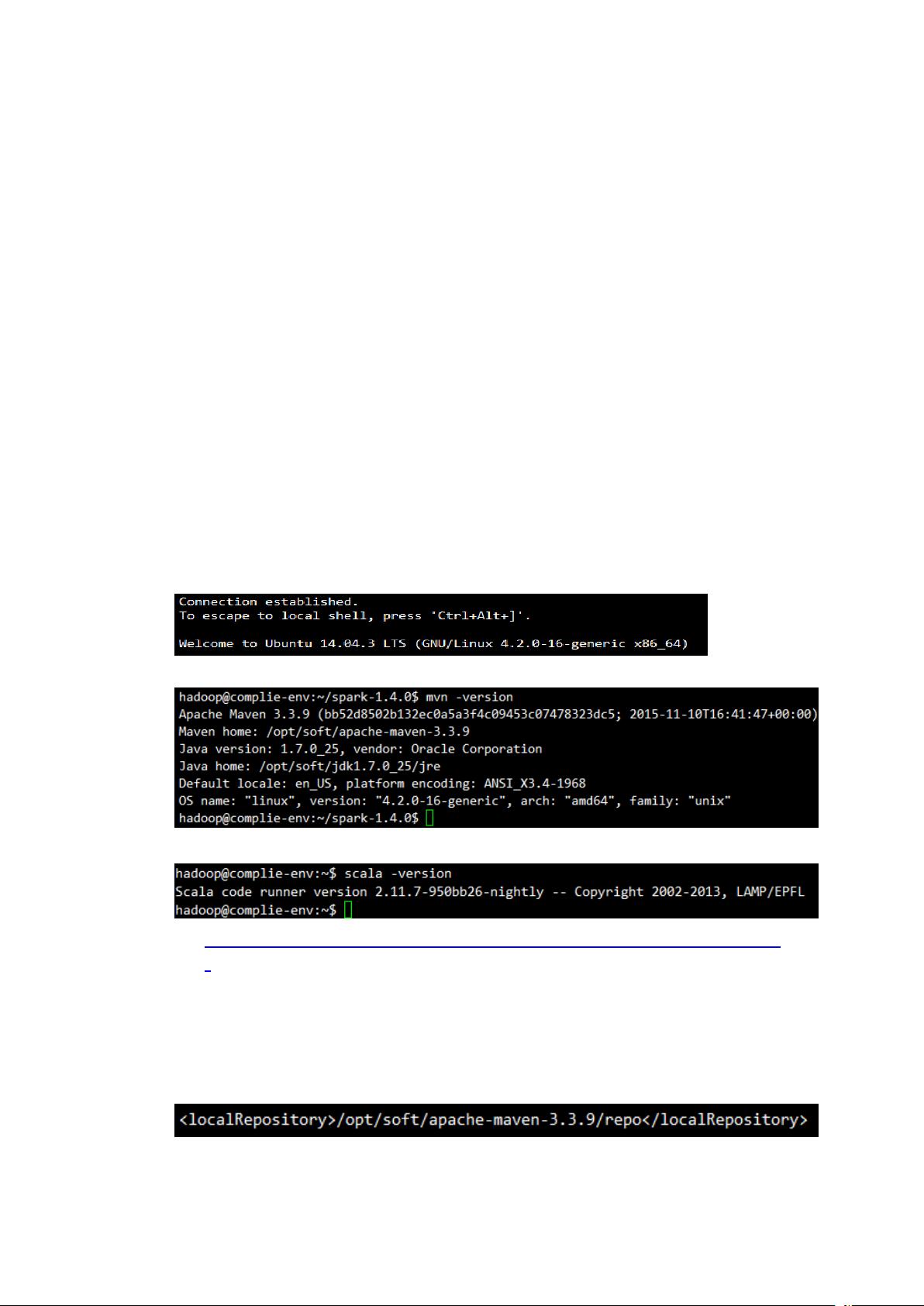

Hive on Spark实施笔记1

需积分: 0 20 浏览量

2022-08-08

20:11:33

上传

评论

收藏 270KB DOCX 举报

晕过前方

- 粉丝: 113

- 资源: 328

最新资源

- 基于matlab实现用有限元法计算电磁场的Matlab工具 .rar

- 基于matlab实现有限元算法 计算电磁场问题 边界条件包括第一类边界和第二类边界.rar

- 基于matlab实现用于计算不同车重下的电动汽车动力性和经济性.rar

- 基于matlab实现遗传算法求解多车场车辆路径问题 有多组算例可以用.rar

- 浏览器.apk

- 基于matlab实现是一个matlab中的power system 中搭建的一个模型

- 基于JSP毕业设计-教学管理系统(源代码+论文).zip

- 基于JSP毕业设计-家政管理系统-毕业设计.zip

- 基于Python实现淘宝商品评论采集(含逆向)源代码

- 基于matlab实现多目标进化算法NSGAⅡ&Matlab讲解.rar

资源上传下载、课程学习等过程中有任何疑问或建议,欢迎提出宝贵意见哦~我们会及时处理!

点击此处反馈

评论0