朴素贝叶斯法原理1

需积分: 0 134 浏览量

更新于2022-08-03

收藏 464KB PDF 举报

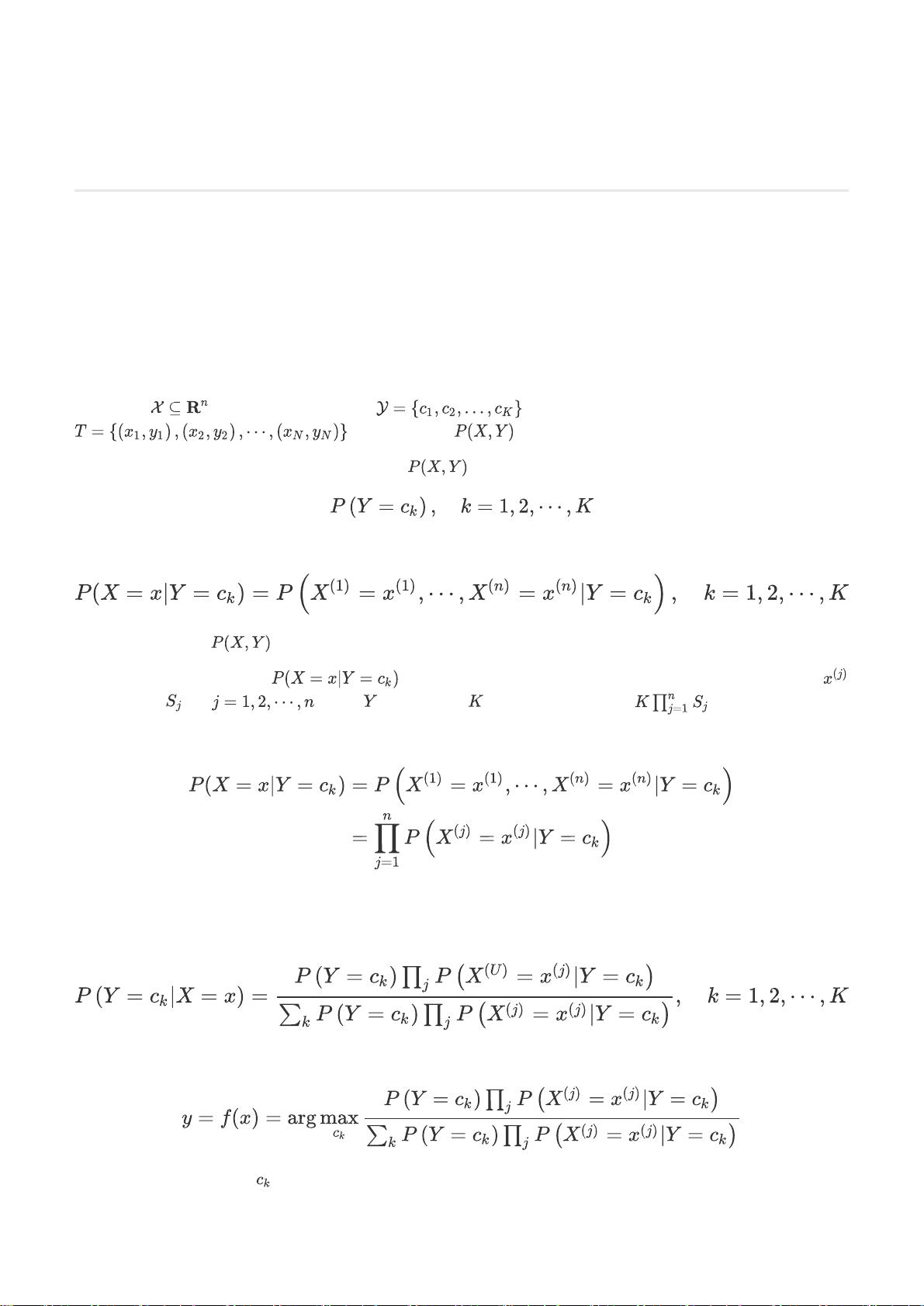

朴素贝叶斯法是一种基于概率理论的机器学习算法,尤其适用于文本分类和其他领域的问题。它的核心思想是利用贝叶斯定理和特征之间的独立性假设来进行预测。在这个方法中,我们首先介绍基本方法、参数估计以及拉普拉斯平滑这三个关键概念。

1. 基本方法

在朴素贝叶斯法中,输入空间是特征的集合,输出空间是类标记的集合。假设我们有一个训练数据集,这个数据集是由联合概率分布P(X,Y)独立同分布产生的,其中X代表特征,Y代表类别。朴素贝叶斯法的目标是从这个数据集中学习到联合概率分布P(X,Y)。具体来说,我们需要估计先验概率P(Y)和条件概率P(X|Y)。然而,由于特征数量庞大,直接估计所有条件概率参数是非常困难的。为了解决这个问题,朴素贝叶斯法引入了“条件独立性”假设,即每个特征在给定类别的情况下与其他特征独立。这意味着特征之间不相互影响,并且它们对分类的影响是独立的。这样,我们可以利用贝叶斯公式来计算后验概率:

P(Y|X) = P(X|Y) * P(Y) / P(X)

朴素贝叶斯分类器就是基于这个公式进行分类的。

2. 参数估计

在朴素贝叶斯法中,参数估计通常采用极大似然估计。对于先验概率P(Y),它的极大似然估计是类别Y的样本数量除以总样本数量。即:

P(Y=k) = Nk / N

其中Nk是类别为k的样本数量,N是总样本数量。

条件概率P(X|Y)的极大似然估计则涉及到特征的计数。假设特征Xi有m个可能的取值,对于类别Y=k,特征Xi取值为xi的条件概率估计为:

P(Xi=xi|Y=k) = Nki / Nk

其中Nki是在类别k中特征Xi取值为xi的样本数量,Nk是类别k的样本总数。

3. 拉普拉斯平滑

在实际应用中,有时会出现某些特征的特定取值在训练数据中未出现的情况,导致极大似然估计得到的概率为0。为了避免这种情况,朴素贝叶斯法引入了拉普拉斯平滑。拉普拉斯平滑通过添加一个较小的常数α(通常取1)来修正概率估计,使得即使在训练数据中未观察到的特征取值也能获得非零概率:

P'(Xi=xi|Y=k) = (Nki + α) / (Nk + mα)

这样,条件概率不会因为缺乏观测而变为0,保证了模型的稳定性。同时,修正后的概率仍然满足概率的归一化条件。

总结起来,朴素贝叶斯法是一种基于概率的分类算法,它利用特征的独立性假设简化了参数估计,并通过拉普拉斯平滑处理了训练数据中未出现的特征取值问题。尽管其假设在实际问题中可能过于理想化,但在许多情况下,朴素贝叶斯法仍然表现出良好的性能和效率。

艾斯·歪

- 粉丝: 42

- 资源: 342

最新资源

- 毕业设计JAVAWEB校园订餐系统项目源码

- html css js分页按钮

- Comsol多孔板相场断裂模型:一种高效的数值模拟工具,好的,以下是根据您提供的“comsol多孔板相场断裂模型”提炼出的一个标题: COMSOL多孔板相场模拟与断裂分析模型 此标题涵盖了您提供

- Vcredist运行库【2005、2008、2010、2012、2013、2015-2022】X86+X64集合打包

- 六轴EtherCAT总线伺服涂布收卷机程序:动态测量与同步控制,具备参考值的六个伺服+变频器+编码器方案,六轴EtherCAT总线伺服涂布收卷机高级编程:伺服、变频器与编码器的协同控制及动态测量频率转

- springboot接入InfoSuiteAs

- 命令行界面构建库 :CmdForge

- 电力系统风储协同调频策略的MATLAB仿真模型:基于四机两区系统的频域模型与控制策略优化分析,MATLAB仿真模型:风储联合一次调频在四机两区电力系统的应用与优化,电力系统风储联合一次调频MATLAB

- 【微信小程序源码】笑话

- 「三菱R系列PLC应用:ST、RD77MS定位与触摸屏配方功能实现异地操作及快速通信」,三菱R系列PLC案例详解:高级应用与CClink通信实现机器人远程操作及触摸屏配方功能,三菱R系列PLC案例程序

- 【微信小程序源码】滑动选项卡

- Video_59564296397953.mp3

- 使用c++开发相机的示例CameraDS,引用DirectShow技术

- 贪吃蛇 web版 支持python启动

- 基于NRBO优化算法的Transformer-BiLSTM回归模型Matlab代码:适用于多变量时序预测的电力负荷与光伏功率预测,NRBO-Transformer结合BiLSTM神经网络的时序数据回归

- 【微信小程序源码】京东白条