数据预处理与特征工程 full version1

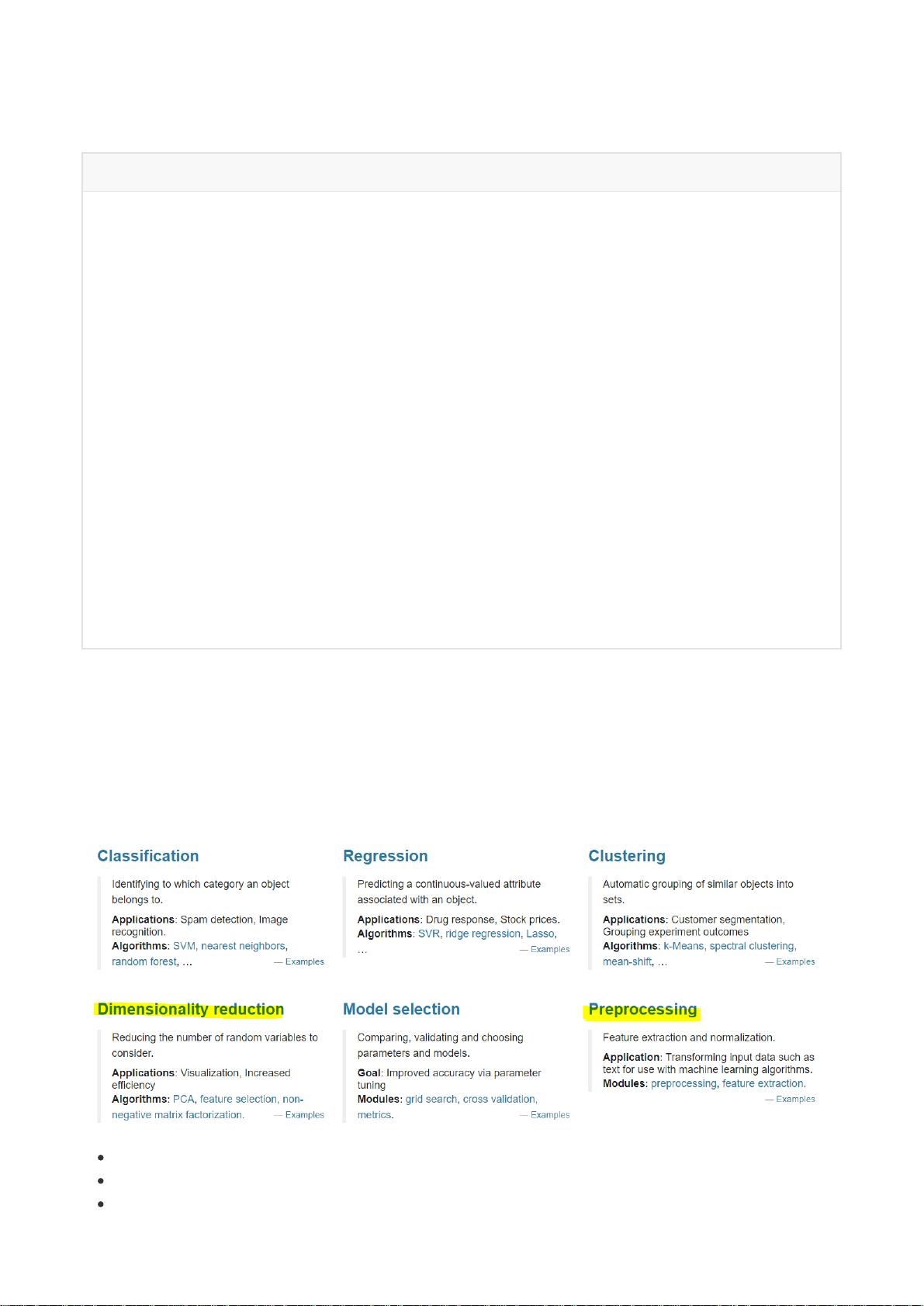

数据预处理与特征工程是机器学习流程中至关重要的步骤,它们直接影响着模型的性能和预测效果。在这篇文章中,我们将探讨这些概念,并结合scikit-learn库进行实践。 获取数据是整个流程的起点。这通常涉及从各种来源如数据库、CSV文件、APIs或者网络爬虫获取原始数据。在获取数据后,我们需要对其进行初步的清洗和整理,确保数据的质量和可用性。 数据预处理主要包括以下几个方面: 1. **数据无量纲化**:数据可能存在不同的量级和单位,这会影响模型的学习过程。常见的方法有标准化(Z-score)和归一化(最小-最大缩放),使得数据具有相同的尺度。 2. **缺失值处理**:数据中可能存在缺失值,这可能是由于记录错误或测量不可行等原因。处理缺失值的方法包括删除含有缺失值的样本、使用平均值、中位数、众数填充,或者使用更复杂的插值方法。 3. **处理分类型特征**:分类变量需要转化为数值形式才能被模型处理。常用的方法有独热编码(One-Hot Encoding)和标签编码。对于有缺失值的分类变量,可以考虑使用模式填充(Mode imputation)。 4. **处理连续型特征**:对于连续型特征,有时需要进行二值化(例如,设置阈值将数据分为两类)或者分段(例如,将数据划分为多个区间)。这有助于减少特征的复杂性,同时保持信息的完整性。 接下来是特征工程,它是提升模型性能的关键环节: 1. **Filter过滤法**:根据特征的统计属性(如方差、相关性)筛选特征。例如,`VarianceThreshold`可以剔除低变异性特征;卡方检验和F检验可以评估特征与目标变量的关联程度。 2. **Embedded嵌入法**:这种方法将特征选择过程融入模型训练中,如Lasso回归、Ridge回归等,它们通过正则化惩罚项来自动降低不重要特征的权重。 3. **Wrapper包装法**:这类方法直接使用模型的性能指标来评价特征子集,例如递归特征消除(RFE)和基于格子搜索的特征选择。 在scikit-learn中,我们可以通过`preprocessing`模块实现上述预处理操作,如`StandardScaler`、`MinMaxScaler`用于无量纲化,`Imputer`类处理缺失值,`LabelEncoder`和`OneHotEncoder`处理分类特征。同时,`feature_selection`模块提供了过滤法和嵌入法的实现。 建模、测试模型并预测结果是机器学习的目标。我们可以使用scikit-learn的各类模型,如随机森林、支持向量机、神经网络等。通过交叉验证、网格搜索等方法调优模型参数,以提高模型的泛化能力。 在实际工作中,面对不完美的数据,我们需要具备数据预处理和特征工程的技能,以应对数据中的噪声、异常值和缺失值等问题。只有这样,我们才能充分利用数据,避免模型在现实场景中失效。因此,理解并熟练掌握数据预处理和特征工程对于任何数据科学家来说都是必要的。

剩余30页未读,继续阅读

- 粉丝: 893

- 资源: 290

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功

评论0