基于细粒度数据流架构的稀疏神经网络全连接层加速_向陶然1

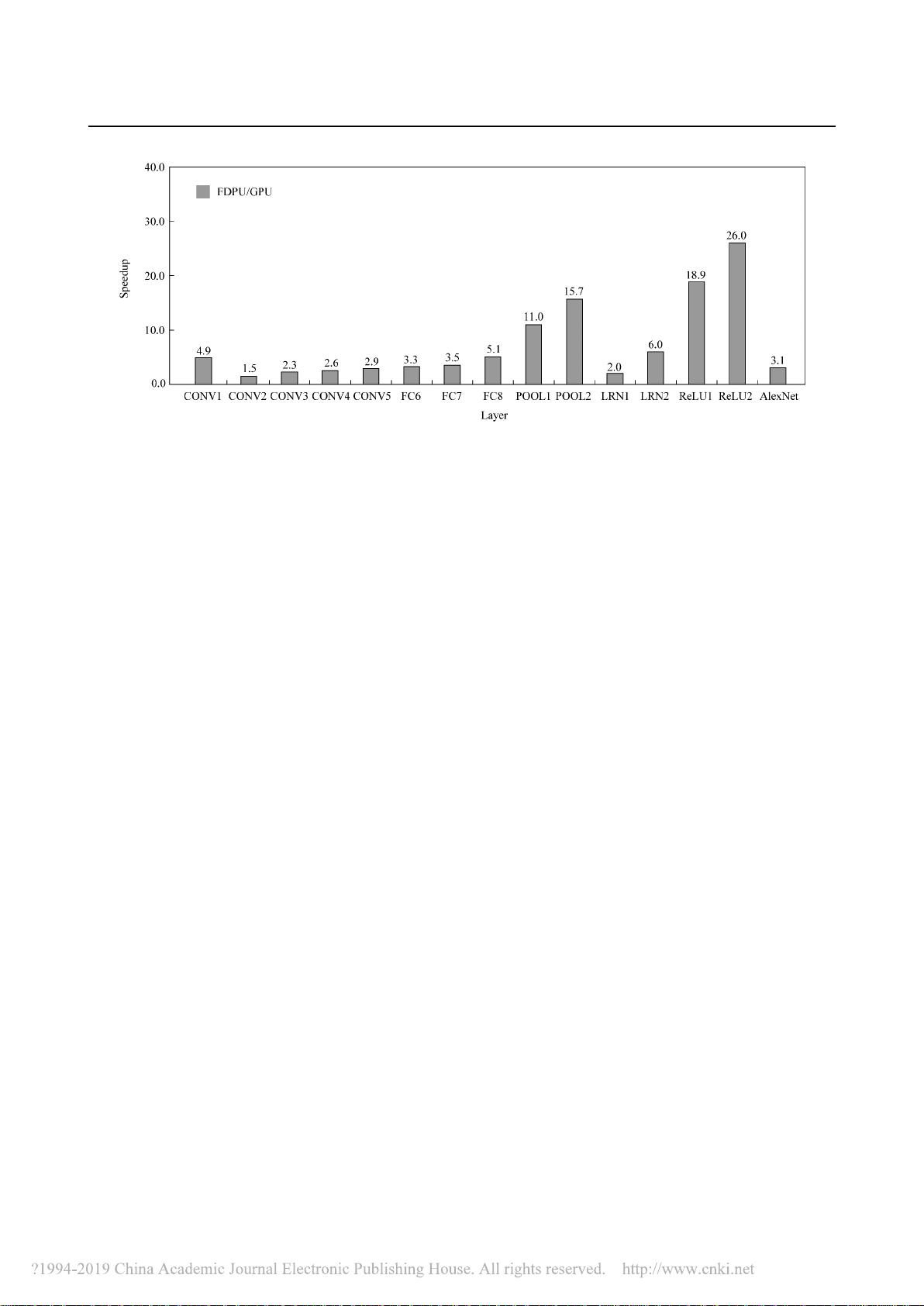

:“基于细粒度数据流架构的稀疏神经网络全连接层加速_向陶然1” :深度神经网络(DNN)在当前的图像识别领域扮演着重要角色,广泛应用在人脸识别、图像识别和文字识别等多个场景。由于其复杂的计算需求,已经出现了许多硬件加速器来提升并行处理能力。然而,DNN中的全连接层具有大量权重参数,这对加速器的带宽提出了较高要求。 【内容】:为了解决全连接层带来的带宽压力,研究者们提出了DNN压缩算法。这些算法旨在减少网络的存储和计算需求,但基于FPGA(现场可编程门阵列)和ASIC(专用集成电路)的加速器通常为了追求更高的性能和更低的功耗而牺牲通用性。因此,设计一种能够同时兼顾高效能、低带宽需求和良好通用性的加速架构至关重要。 本文主要探讨了一种基于细粒度数据流架构的稀疏神经网络全连接层加速策略。细粒度数据流架构允许更灵活的数据管理和调度,能够更好地适应稀疏网络结构,因为稀疏网络中的权重并非全部参与计算,这为优化带宽使用提供了可能。通过这种架构,可以有效地减少无效数据传输,提高计算资源利用率,并降低对内存带宽的需求。 该研究首先介绍了DNN全连接层的计算特点以及现有的加速器挑战。接着,详细阐述了细粒度数据流架构的设计原理,包括如何利用稀疏性优化数据流,如何调整计算单元以适应非均匀的权重分布,以及如何在不增加过多复杂性的前提下实现高效能。此外,文章还可能分析了不同稀疏度对加速效果的影响,并对比了所提出的加速方法与其他常见加速技术的性能差异。 实验结果表明,该细粒度数据流架构在保持较高准确率的同时,显著降低了全连接层的计算延迟和带宽消耗,尤其在处理高稀疏度的神经网络时优势更为明显。这种加速方案不仅适用于特定的DNN模型,而且展示出了较好的通用性,可以在多种不同的神经网络架构上进行部署。 总结来说,这项工作为解决DNN全连接层的计算瓶颈提供了一个新的视角,即通过细粒度数据流架构和稀疏性优化,实现了高性能和低带宽需求的平衡。这为未来设计更加高效且通用的神经网络硬件加速器提供了有益的参考和启示。

剩余12页未读,继续阅读

- 粉丝: 22

- 资源: 291

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功

评论0