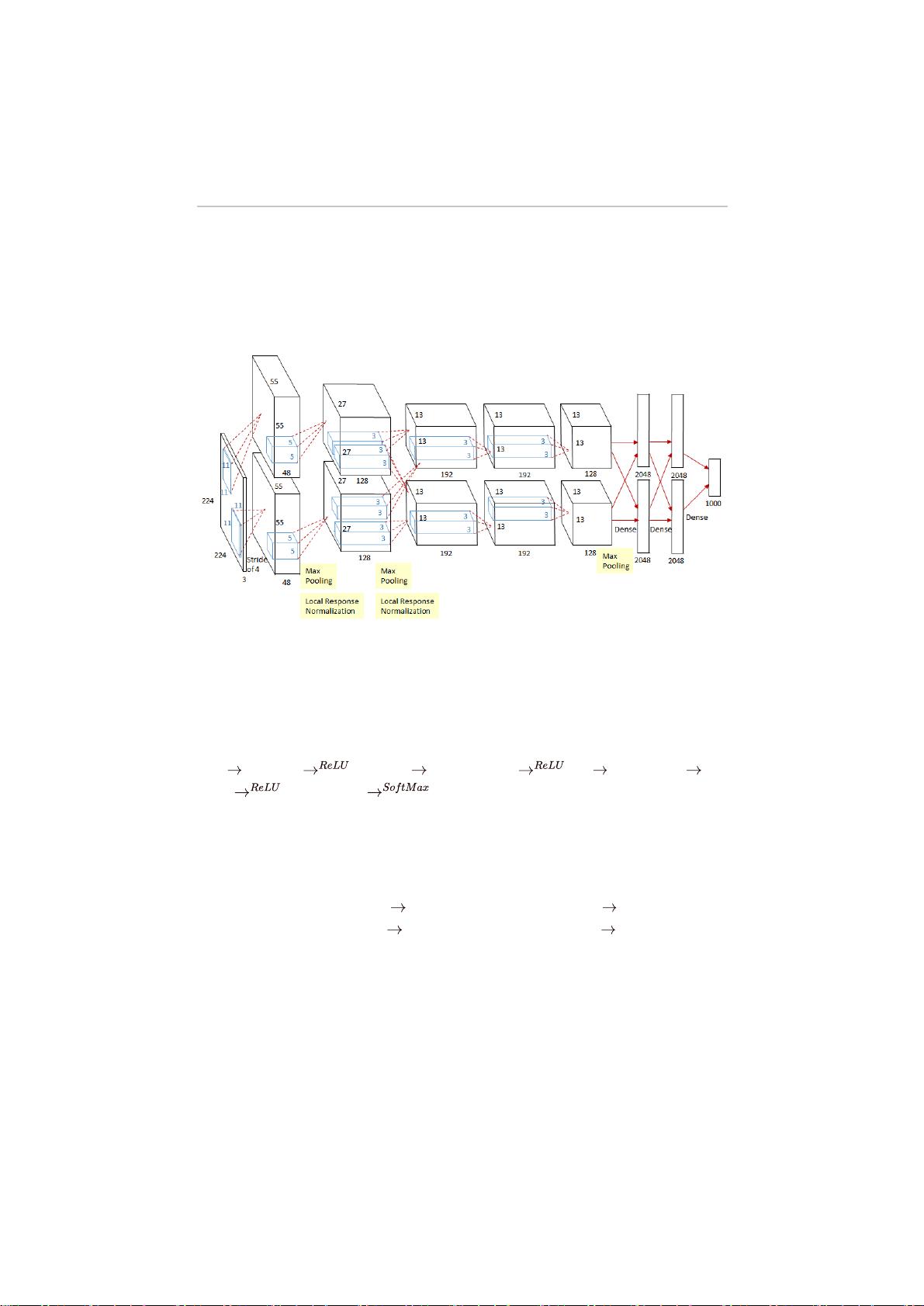

《AlexNet深度学习模型解析与实现探讨》 AlexNet,作为深度学习领域的里程碑之作,于2012年在ImageNet图像识别挑战赛上取得了显著的突破,为卷积神经网络(CNN)的发展奠定了坚实的基础。本文将深入探讨AlexNet的基本原理、结构特点以及其在实际应用中的挑战与可行性。 1. 原理与结构 AlexNet的核心是CNN,它通过一系列卷积层、池化层、激活函数和全连接层来提取和学习图像特征。具体而言: 1.1 卷积层:卷积层通过滑动卷积核对输入图像进行运算,提取出局部特征,每个卷积核相当于一个小的滤波器,能够检测特定的图像模式。 1.2 池化层:池化层用于降低数据的维度,通常采用最大池化,保留关键信息,减少计算量并防止过拟合。 1.3 误差反向传播算法(BP算法):这是训练神经网络的主要手段,通过计算损失函数关于权重的梯度,更新网络权重以最小化误差。 1.4 Softmax函数:作为分类层的激活函数,将网络输出转化为概率分布,使得每个类别的概率总和为1。 1.5 ReLU激活函数:在隐藏层中广泛使用,其非线性特性有助于模型学习更复杂的特征。 1.6 全连接层:在最后一层前,所有神经元都与前一层的所有神经元相连,用于分类决策。 AlexNet的结构包含多个卷积层和池化层,以及两个全连接层,由于计算资源限制,它采用了两个GPU并行训练。 2. AlexNet的挑战 2.1 参数量大:AlexNet拥有约6000万个参数,需要大量计算资源进行训练。 2.2 过拟合预防:使用Dropout等技术防止过拟合,但实现复杂,需要高效处理大量矩阵运算。 2.3 梯度消失与爆炸:深层网络中,反向传播过程可能导致梯度消失或爆炸,影响训练效果。 2.4 硬件限制:当时的硬件对浮点数运算支持有限,且内存限制对大模型训练构成挑战。 3. 实现与简化 虽然完全复现AlexNet面临困难,但我们可以简化模型,如针对MNIST手写数字识别任务构建小型CNN。基本流程包括输入层、一个卷积层、一个池化层、一个全连接层,以及输出层。以下是一个简化的实现示例: 3.1 输入层:接收8x8的灰度图像。 3.2 卷积层:使用5x5的卷积核进行卷积运算,生成4x4的特征矩阵。 3.3 ReLU激活:将卷积层输出通过ReLU函数进行非线性转换。 3.4 池化层:采用最大池化,将4x4的特征矩阵降维至2x2。 3.5 全连接层:将池化层输出映射到类别数量的输出向量。 4. 结论 AlexNet的成功展示了深度学习在图像识别中的巨大潜力,尽管实现完整的模型存在诸多挑战,但通过对模型的简化,仍可在有限资源下体验到CNN的魅力。随着计算能力的提升和优化算法的发展,如今的深度学习模型已经能够处理更复杂的任务,AlexNet的精神依然激励着我们在人工智能领域不断探索和创新。

- 粉丝: 29

- 资源: 298

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜 信息提交成功

信息提交成功

评论0