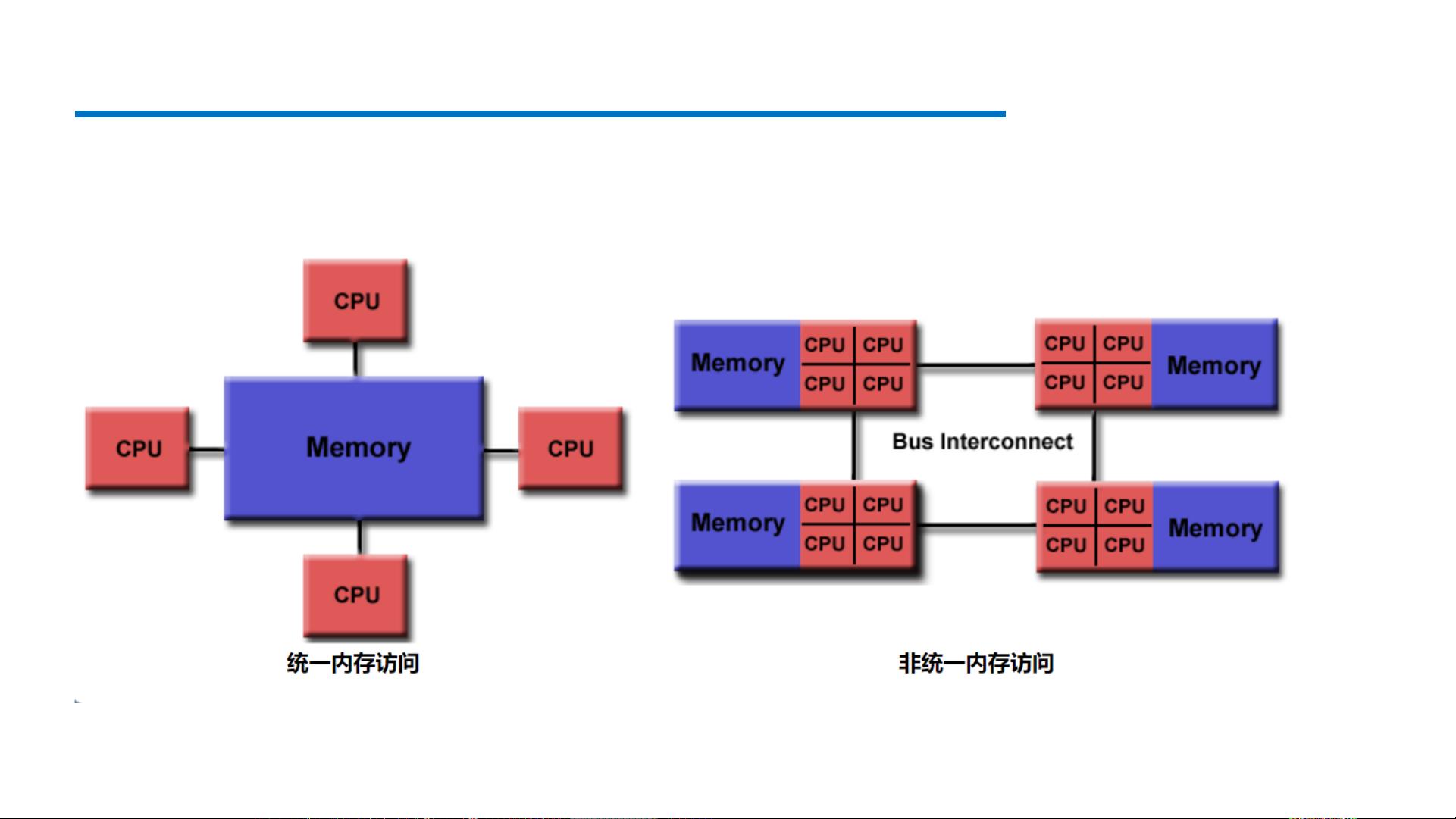

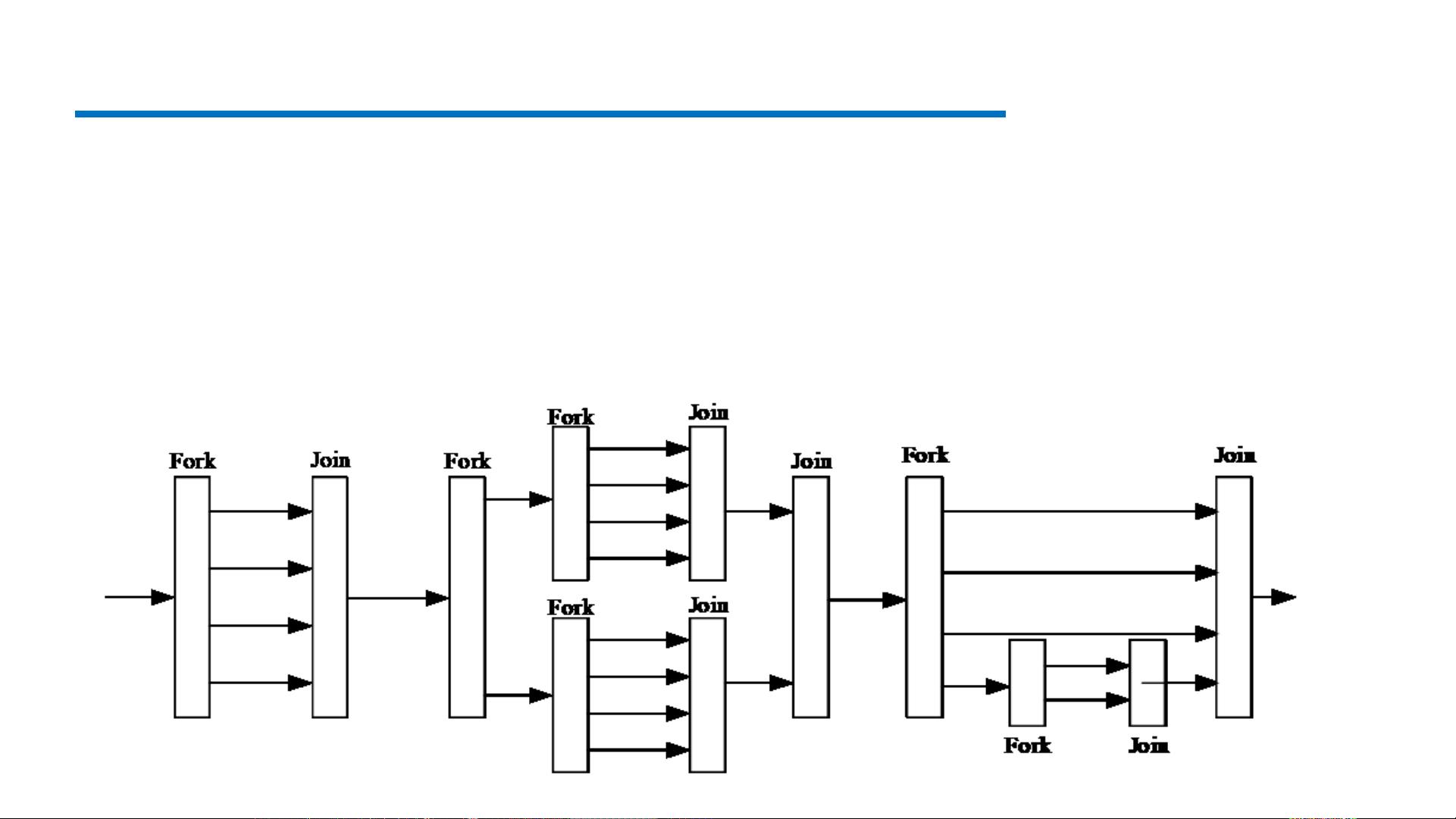

【基于MPI+OpenMP的并行编程1】 并行编程是一种技术,允许程序在多处理器或分布式计算资源上同时执行,以提高计算效率。在本文中,我们将关注两种主要的并行编程模型:MPI(Message Passing Interface)和OpenMP。MPI主要用于分布式内存系统,而OpenMP则适用于共享内存系统。 **MPI(Message Passing Interface)简介** MPI是一种标准,用于编写在多处理节点之间通信的并行程序。它提供了一组函数,使得进程间可以交换数据和协调工作。MPI程序由多个独立的进程组成,它们可以在同一台机器上或跨网络的不同机器上运行。MPI的主要优点是它的灵活性和可移植性,适用于各种并行硬件平台。 **OpenMP简介** OpenMP是一种编译器指令,用于在共享内存系统上实现多线程并行化。它的优势在于其简单易用和高效,程序员只需在源代码中添加pragma注解,编译器就能自动识别并进行并行化处理。OpenMP支持C、C++和Fortran语言,并且有多种编译器如Sun Compiler、GNU Compiler和Intel Compiler等对其提供支持。OpenMP的程序在没有OpenMP支持的环境中仍可正常运行,只是无法利用多线程加速。 **OpenMP的Fork-Join并行执行模型** OpenMP采用Fork-Join模型,从一个主线程开始,遇到`#pragma omp parallel`指令时,会创建或唤醒多个子线程,这些子线程并行执行任务,然后在遇到隐式同步点时合并回主线程。并行域可以嵌套,相邻的Fork和Join之间定义了一个并行区域。 **OpenMP的版本** 要检查OpenMP的版本,可以通过编译器命令行选项查看,例如`$gcc -v` 和 `$echo |cpp -fopenmp -dM |grep -i openmp`,或者访问OpenMP官方资源网站获取更多信息。 **OpenMP编译制导** OpenMP的所有编译制导指令以`#pragma omp`开头,后面跟着指令名称和可选的从句。例如,`#pragma omp parallel`用于创建并行区域,`#pragma omp for`用于并行化循环。`#pragma omp parallel`指令创建一个并行区域,`#pragma omp for`指令则与之结合,将循环并行化。需要注意的是,循环必须符合特定格式,以确保并行化安全。 **示例代码** 以下代码展示了如何使用OpenMP并行化`printf`语句和for循环: ```c #include <stdio.h> #include <omp.h> int main() { #pragma omp parallel printf("The parallel region is run by thread %d.\n", omp_get_thread_num()); int i; #pragma omp parallel for for (i = 0; i < 4; i++) printf("i = %d, threadId = %d.\n", i, omp_get_thread_num()); return 0; } ``` 在这个例子中,`omp_get_thread_num()`函数用于获取当前线程的编号,显示并行执行时每个线程的标识。 **结论** MPI和OpenMP的结合使用可以实现分布式和共享内存环境下的高效并行计算。MPI负责节点间的通信,而OpenMP则处理同一节点内的多线程并行。这种混合编程模型能够充分利用现代高性能计算系统的资源,提高大规模计算任务的执行速度。

剩余75页未读,继续阅读

- 粉丝: 29

- 资源: 332

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 机械手自动排列控制PLC与触摸屏程序设计

- uDDS源程序publisher

- 中国风格, 节日 主题, PPT模板

- 生菜生长记录数据集.zip

- 微环谐振腔的光学频率梳matlab仿真 微腔光频梳仿真 包括求解LLE方程(Lugiato-Lefever equation)实现微环中的光频梳,同时考虑了色散,克尔非线性,外部泵浦等因素,具有可延展

- 企业宣传PPT模板, 企业宣传PPT模板

- jetbra插件工具,方便开发者快速开发

- agv 1223.fbx

- 全国职业院校技能大赛网络建设与运维规程

- 混合动力汽车动态规划算法理论油耗计算与视频教学,使用matlab编写快速计算程序,整个工程结构模块化,可以快速改为串联,并联,混联等 控制量可以快速扩展为档位,转矩,转速等 状态量一般为SOC,目

信息提交成功

信息提交成功