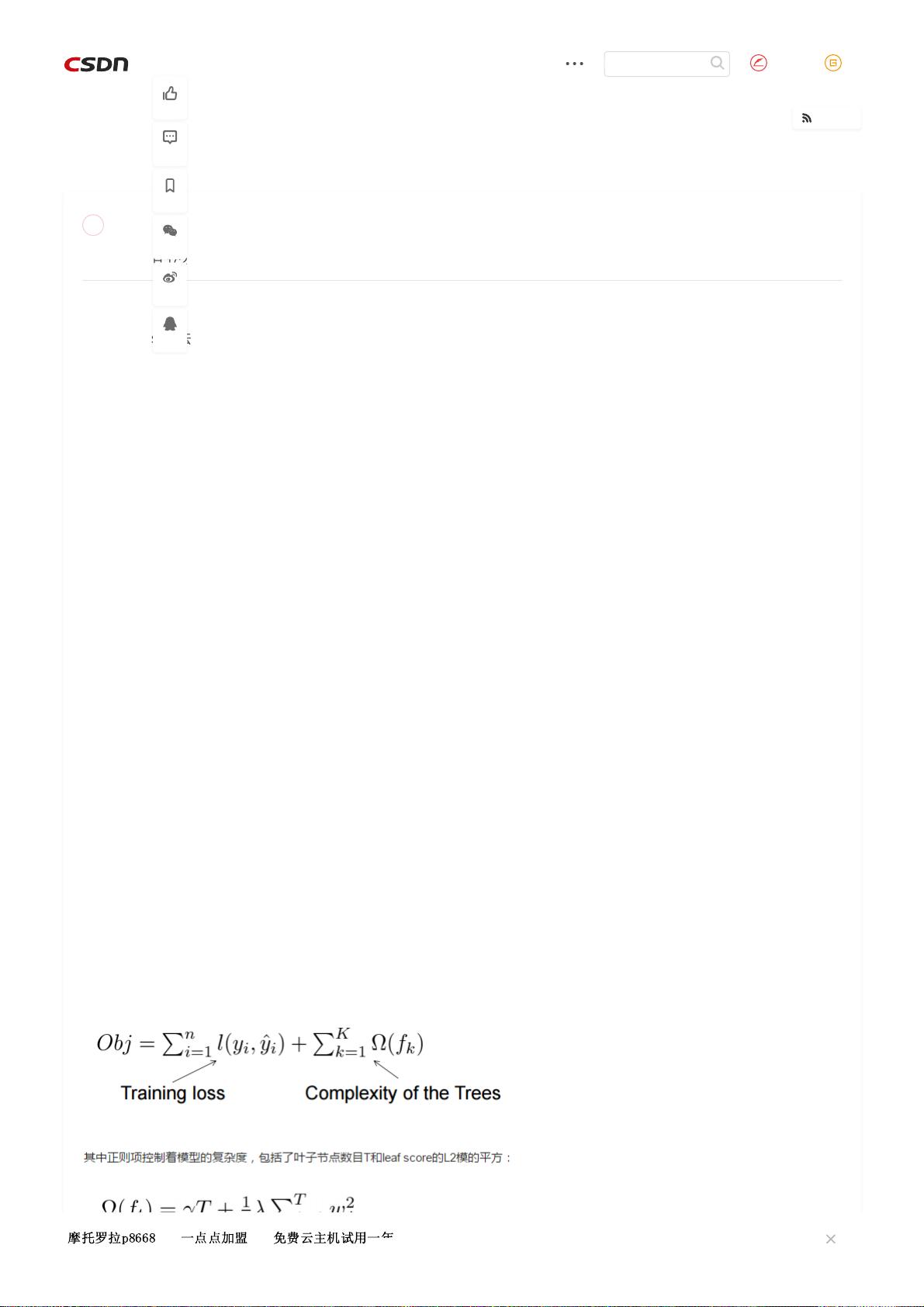

标时不仅考虑了模型的预测误差,还考虑了模型的复杂度。这使得xgBoost在提高模型准确度的同时,能够有效地防止过拟合。 在GBDT(Gradient Boosting Decision Tree)的基础上,xgBoost(eXtreme Gradient Boosting)引入了多项优化,使其在性能和效率上更胜一筹。xgBoost允许使用列采样(column subsampling),这是一种降低过拟合风险的策略,类似于随机森林。通过随机选择一部分特征进行建树,xgBoost能够在保持模型泛化能力的同时减少计算量。 xgBoost引入了二阶导数信息来优化目标函数,这是对传统GBDT仅使用一阶导数的改进。这种二阶泰勒展开的方法使得模型能够更快地收敛,并且能够更精确地拟合数据的曲面形状。同时,xgBoost还支持自定义损失函数,只要该函数的一阶和二阶导数可求。 此外,xgBoost在正则化方面做得非常出色。它不仅限制了树的深度和叶子节点的数量,还在损失函数中加入了正则项,对模型的复杂度进行惩罚。这有助于控制模型的variance,防止过拟合,同时保持模型的bias较低。xgBoost还引入了学习速率(eta,或称为缩减率),每次迭代后都会将叶子节点的权重乘以这个系数,从而降低单个树的影响,允许更多的迭代次数以达到更好的效果。 对于处理缺失值,xgBoost提供了自动化策略。它可以自动决定如何根据缺失值进行特征分裂,使得模型能够更好地处理含有缺失值的数据集。这与传统的决策树算法相比,大大提高了处理缺失值的灵活性。 xgBoost的并行计算能力也是其独特之处。虽然它不能在树级别进行并行,但可以在特征级别并行。通过预先对数据进行排序并存储为块状结构,xgBoost能够在节点分裂时并行计算各个特征的增益,显著提高了训练速度。此外,xgBoost还提出了一种并行的近似直方图算法,用于高效地生成候选的分割点,这对于大规模数据或分布式环境中的模型训练尤为关键。 xgBoost中的树节点分裂公式是基于增益计算的,考虑了信息增益或基尼不纯度等指标,同时添加了正则化项,以控制模型复杂度。这个公式保证了模型在追求预测性能的同时,也考虑了模型的简洁性。 xgBoost相比于其他如GBDT、lightGBM和随机森林(Random Forest)等集成学习方法,具备了更高的优化效率、更强的正则化能力、更优秀的缺失值处理和并行计算特性,使其在实际应用中成为一种极具竞争力的机器学习工具。

- 粉丝: 19

- 资源: 285

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功

评论0