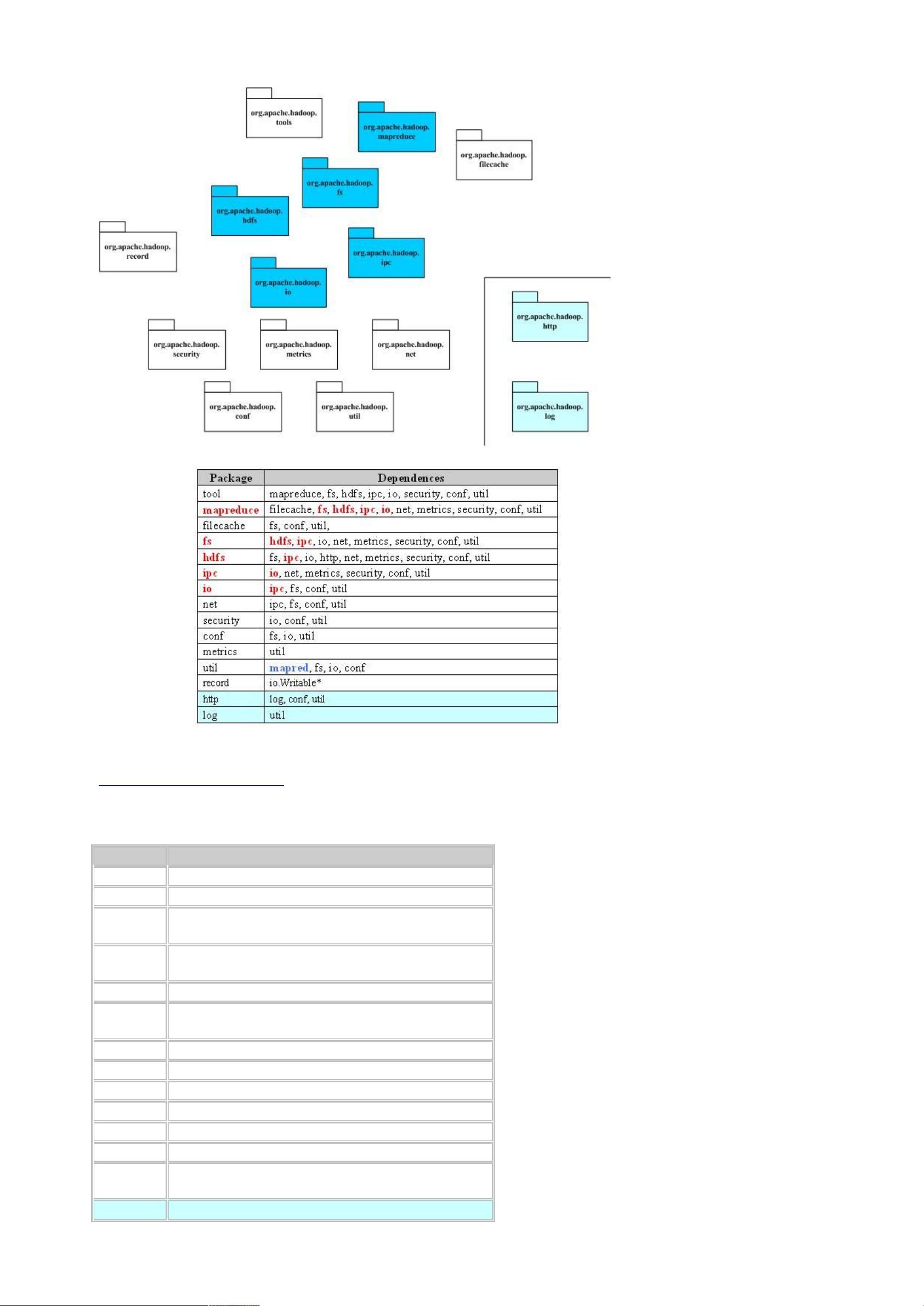

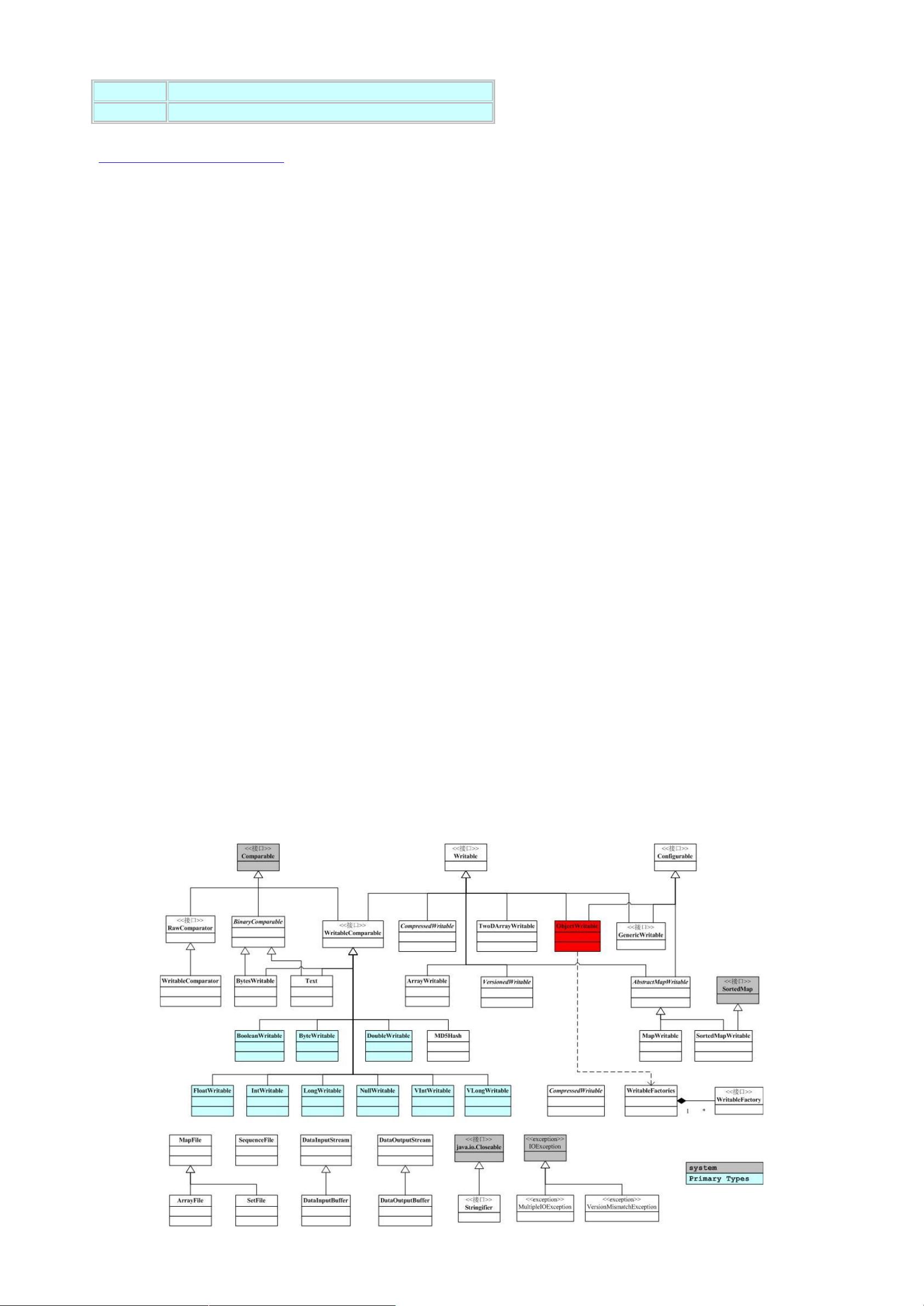

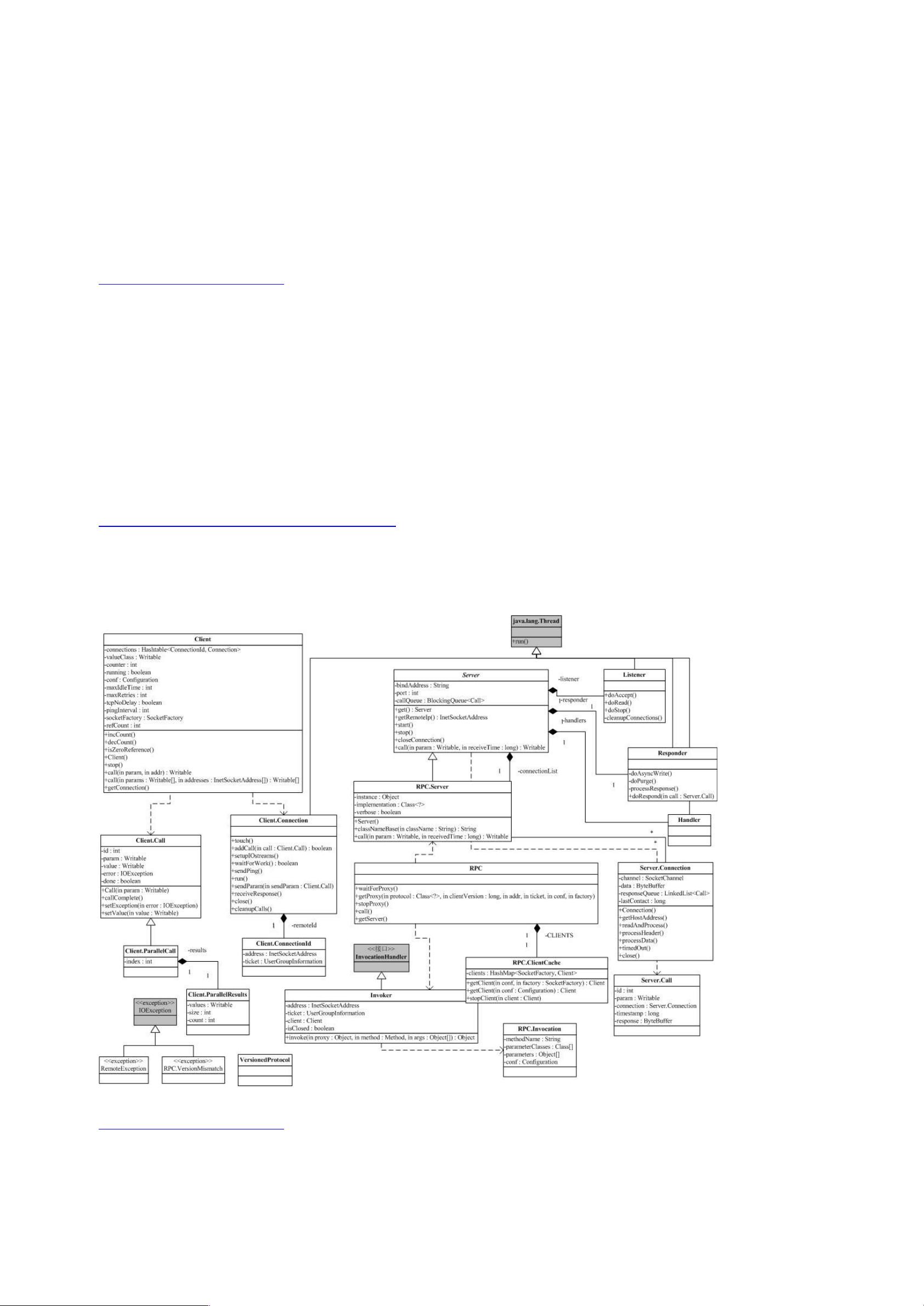

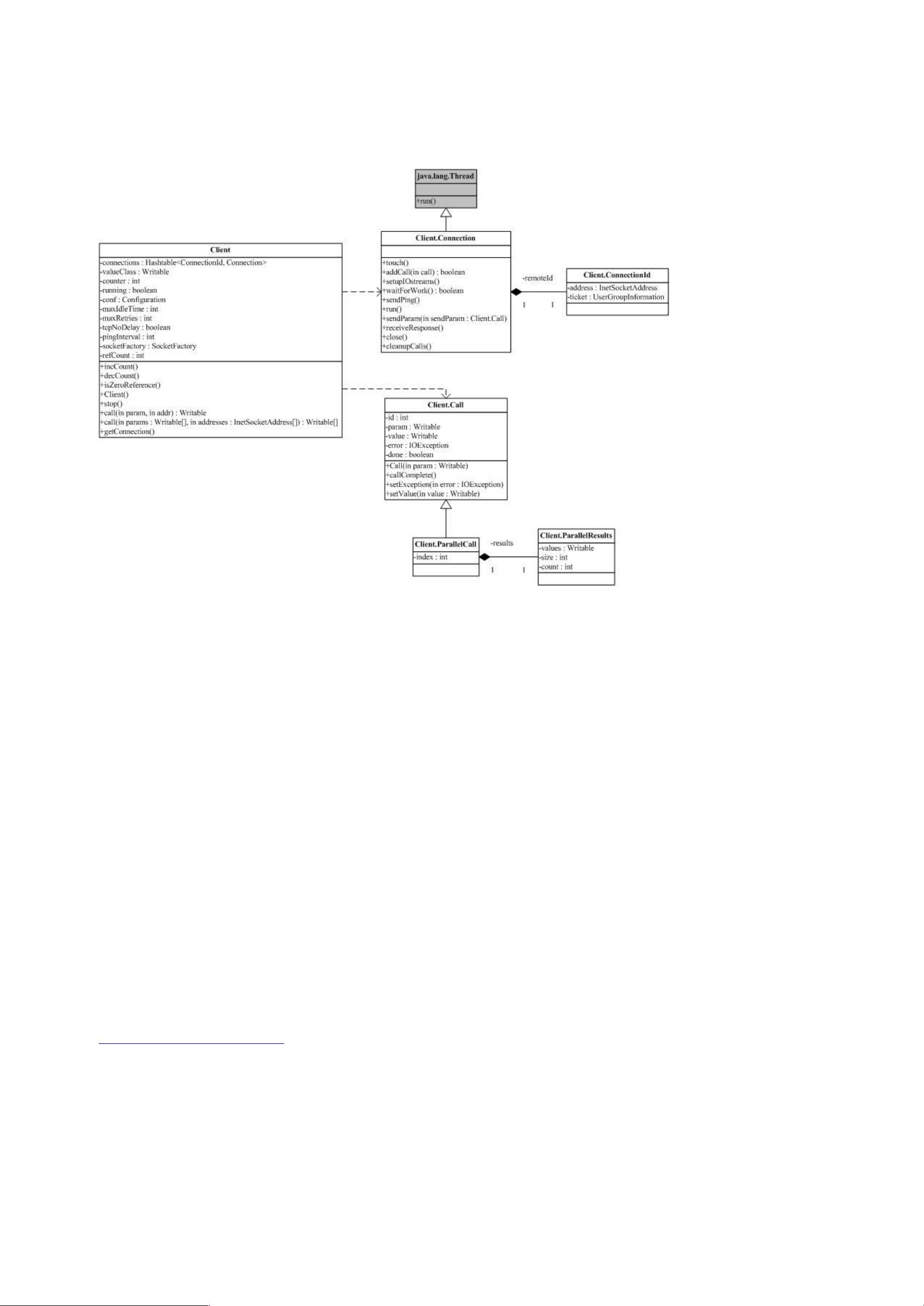

Hadoop是一个开源的分布式计算框架,它由Apache软件基金会维护,并且是大数据处理领域的重要组成部分。Hadoop的设计灵感来源于Google的几篇论文,包括GoogleCluster、Chubby、GFS、BigTable和MapReduce。这些论文揭示了Google如何构建大规模分布式计算系统。在Hadoop中,我们可以看到与这些技术相对应的实现,例如Chubby对应ZooKeeper,GFS对应HDFS,BigTable对应HBase,而MapReduce则直接在Hadoop中得到实现。 Hadoop的核心组件包括两个主要部分:Hadoop分布式文件系统(HDFS)和MapReduce计算模型。HDFS是一个高容错性的分布式文件系统,它设计用于存储大量数据并保证高吞吐量的数据访问。HDFS将大型文件分割成块,并将这些块复制到多台机器上,以提高可用性和容错性。HDFS的API使得应用程序能够透明地访问分布式文件系统,而无需关心底层实现的细节。 MapReduce则是处理大数据的一种编程模型,它将复杂的计算任务分解为“映射”(map)和“化简”(reduce)两步。映射阶段,数据被分发到集群中的多个节点上进行并行处理;化简阶段,处理结果被聚合起来,生成最终的输出。这种模型非常适合于批处理任务,如数据分析、日志处理等。 在Hadoop的源码中,我们可以看到各个包之间的复杂依赖关系。例如,`fs`包提供了文件系统的抽象接口,允许对不同类型的文件系统进行统一访问,包括本地文件系统和分布式文件系统。`ipc`包实现了一个简单的远程过程调用(RPC)机制,这对于HDFS和MapReduce之间的通信至关重要。`io`包则包含了数据编码和解码的工具,使得数据可以在网络间高效传输。`security`包处理用户认证和权限管理,确保系统的安全性。`metrics`包则负责收集系统的运行时统计信息,便于监控和管理。 Hadoop的序列化机制是其另一个重要特性。它没有使用Java自带的序列化机制,而是定义了自己的`Writable`接口。所有需要在网络间传输的对象都必须实现这个接口,以便进行高效的序列化和反序列化操作。这提高了数据在网络上的传输效率,同时也降低了跨语言交互的复杂性。 Hadoop源码分析涵盖了分布式文件系统的设计原理、分布式计算模型的实现以及相关的通信、安全和监控机制。深入理解Hadoop的源码,有助于开发者更好地利用这个框架来处理大数据问题,同时也能为优化分布式系统提供宝贵的经验。

剩余63页未读,继续阅读

- 粉丝: 19

- 资源: 16

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- (18956428)STM32F103C8T6 小系统原理图 PCB

- (175828796)python全国疫情数据爬虫可视化分析系统(django)源码数据库演示.zip

- 记账本项目市场需求文档(MRD)

- (31687028)PID控制器matlab仿真.zip

- 基于SpringBoot的“在线答疑系统”的设计与实现(源码+数据库+文档+PPT).zip

- (11828838)进销存系统源码

- 记账本项目三大模块原型图

- fed54987-3a28-4a7a-9c89-52d3ac6bc048.vsidx

- (177367038)QT实现教务管理系统.zip

- (178041422)基于springboot网上书城系统.zip

信息提交成功

信息提交成功