Apache Doris数据分析综合案例实战

需积分: 0 162 浏览量

更新于2024-05-07

1

收藏 7.98MB PDF 举报

### Apache Doris 数据分析综合案例实战

#### 一、背景介绍

随着互联网技术的发展和电商平台的崛起,诸如京东这样的大型电商平台在每年特定时间举办的大规模促销活动已成为吸引大量消费者参与的重要营销手段。京东618作为中国乃至全球范围内重要的网络购物节之一,在每年6月18日前后达到高潮。自1998年京东创立以来,618已经成为京东最重要的年度庆典之一,同时也逐渐发展成为与双11并驾齐驱的另一全民网购狂欢节。

#### 二、项目需求分析

##### 2.1 项目需求

在当前大数据时代背景下,电商平台需要利用先进的数据处理技术和工具来实时监测销售情况及用户行为,以便做出快速反应并优化运营策略。具体来说,企业需要一套能够实时展示订单数据与用户访问数据的大屏系统,以便管理层能够迅速获取关键业务指标,进行决策支持。

##### 2.2 数据来源

- **PV/UV数据来源**:页面埋点技术被广泛应用于收集用户的浏览行为,这些数据被发送到Web服务器,并由其写入Kafka的`click_log`主题中。

- **销售金额与订单量数据来源**:订单数据主要来源于MySQL数据库。通过对MySQL数据库的Binlog日志进行监听,可以实时捕获订单变化,并通过Canal工具将这些数据实时同步到Kafka的`order`主题中。

#### 三、实现方案

针对不同规模的企业以及不同的数据量和实时性要求,有多种实现方案可供选择:

##### 3.1 Java方式实现

对于小型企业或数据量相对较小的情况(例如,核心数据总量小于20万条),可以通过编写Java程序定时查询MySQL数据库来获取所需的数据。这种方式简单且实用,只需对MySQL数据库进行适当的优化(如增加索引等)即可满足需求。

##### 3.2 通过Flink方案实现

当数据量特别大,无法直接通过MySQL查询时,可以采用Apache Flink这种流处理框架来实现。例如,阿里巴巴在双十一期间就采用了此类方案来实现实时监控大屏的需求,确保延迟不超过1秒,从而满足了极高的实时性要求。

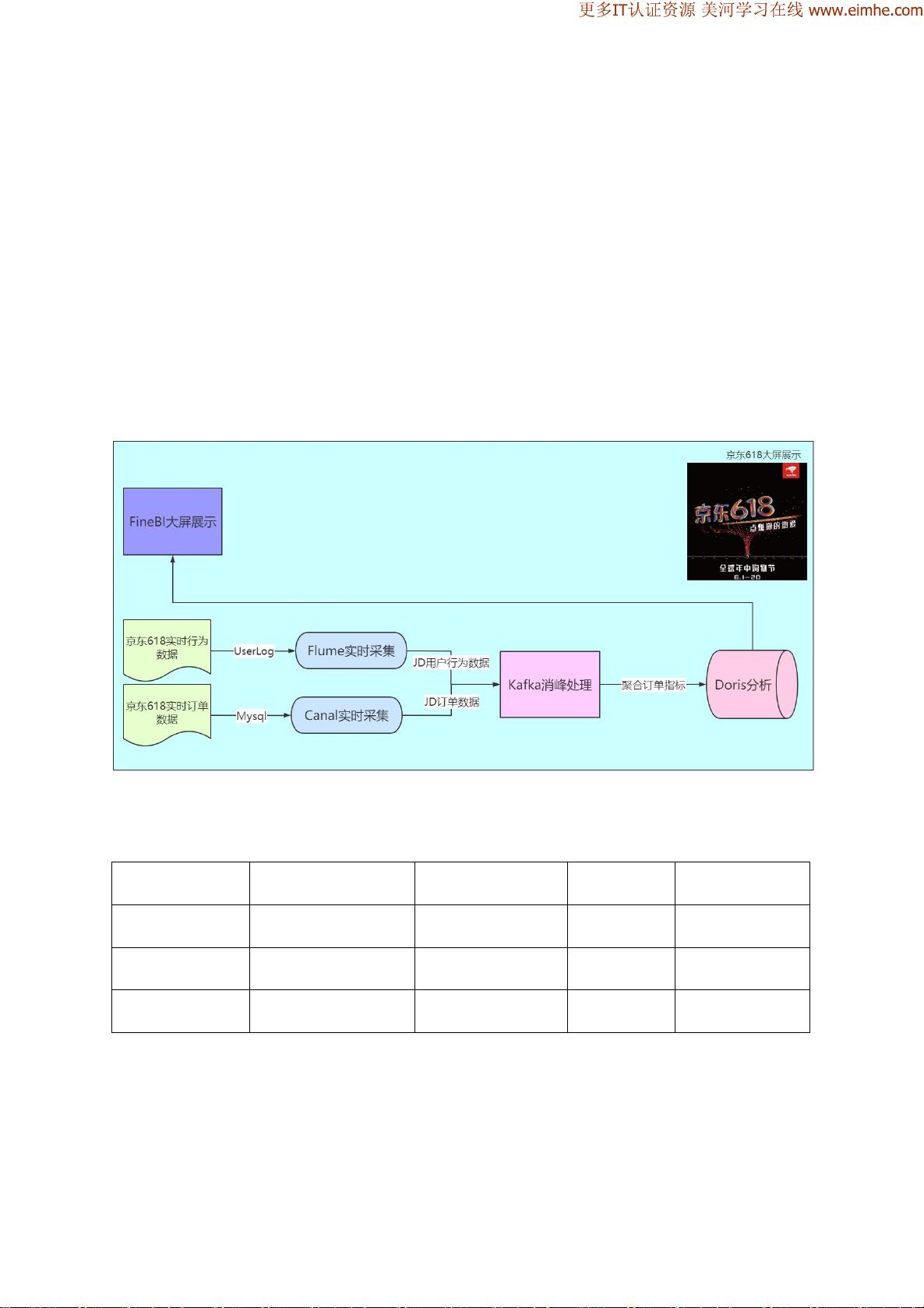

##### 3.3 实时数仓项目架构

为了更好地整合各种数据源并提供统一的数据服务接口,构建实时数仓是一个理想的选择。实时数仓能够高效地处理海量数据,并为上层应用提供低延迟的数据访问能力。在此基础上,可以进一步集成Apache Doris等分布式存储引擎,实现高效的数据查询和分析功能。

#### 四、服务器环境介绍

本项目涉及多台服务器,主要包括以下配置:

- **主机名**:node01、node02、node03

- **操作系统**:CentOS 7.5.1804

- **IP地址**:分别为192.168.10.10、192.168.10.20、192.168.10.30

- **内存**:3GB

- **硬盘**:40GB

#### 五、框架软件版本

为了支持实时数仓项目的运行,需要在所有节点上安装以下软件及其对应版本:

- **CentOS**:7.5

- **JDK**:1.8.0_181

- **MySQL**:5.7(仅在node01上)

- **ZooKeeper**:3.4.9

- **Flume**:1.8.0

- **Kafka**:2.11-0.10.0.0

- **Canal**:1.1.4

- **Doris**:0.22

- **FineBI**:5.1.10

#### 六、前置操作

- **启动Zookeeper集群**:在每台节点上执行`zkServer.sh start`

- **启动Kafka集群**:同样需要在每台节点上启动

- **启动Doris集群**:包括FE和BE两个组件,通过指定的脚本分别启动

#### 七、数据模拟

为了测试整个系统的稳定性和性能,需要进行数据模拟工作,具体步骤如下:

##### 7.1 导入MySQL数据库

- 在MySQL中创建名为`itcast_shops`的数据库

- 使用提供的SQL脚本文件`itcast_shops.sql`导入初始数据

##### 7.2 行为日志数据模拟

- 下载并解压`itcast_dw_pvuvlog-1.0.tar.gz`安装包

- 修改配置文件`log.properties`,设置日志输出路径

- 创建日志输出目录`/export/click_log`

- 启动数据生成器

- 查看日志是否正常生成

##### 7.3 业务订单数据模拟

- 下载并解压`itcast_dw_order-1.0.tar.gz`安装包

- 进行相应的配置调整

- 启动数据生成器

本案例通过详细的步骤介绍了如何利用Apache Doris进行大规模数据分析,并提供了从背景介绍、需求分析、实现方案到具体操作指南的一站式解决方案。通过本案例的学习,可以深入理解大数据实时处理的核心技术及其应用场景,为进一步开展相关领域的研究和实践奠定坚实的基础。

CodeGolang

- 粉丝: 154

- 资源: 1417

最新资源

- 3. Kafka入门-安装与基本命令

- java全大撒大撒大苏打

- pca20241222

- LabVIEW实现LoRa通信【LabVIEW物联网实战】

- CS-TY4-4WCN-转-公版-XP1-8B4WF-wifi8188

- 计算机网络期末复习资料(课后题答案+往年考试题+复习提纲+知识点总结)

- 从零学习自动驾驶Lattice规划算法(下) 轨迹采样 轨迹评估 碰撞检测 包含matlab代码实现和cpp代码实现,方便对照学习 cpp代码用vs2019编译 依赖qt5.15做可视化 更新:

- 风光储、风光储并网直流微电网simulink仿真模型 系统由光伏发电系统、风力发电系统、混合储能系统(可单独储能系统)、逆变器VSR+大电网构成 光伏系统采用扰动观察法实现mppt控

- (180014016)pycairo-1.18.2-cp35-cp35m-win32.whl.rar

- (180014046)pycairo-1.21.0-cp311-cp311-win32.whl.rar