没有合适的资源?快使用搜索试试~ 我知道了~

hadoop1.x环境搭建及其入门

需积分: 0 5 下载量 45 浏览量

2016-09-26

21:22:32

上传

评论

收藏 5.52MB DOCX 举报

温馨提示

hadoop1.x环境搭建及其入门,如需获取更多hadoop资源

资源推荐

资源详情

资源评论

一、Linux 上搭建 Hadoop 环境(单机模式):

1、安装 JDK

./jdkxxxx.bin

2、配置环境变量

编辑 /etc/prole 文件 添加以下内容

## JAVA

export JAVA_HOME=/opt/modules/jdk1.6.0_45

export PATH=$PATH:$JAVA_HOME/bin

以 rootroot root 用户登陆,执行 以下命令,使配置生效 source /etc/prole

3.安装 Hadoop

1)第一步,解压【 $ tar -zxvf hadoop-1.2.1.tar.gz】到 /opt/modules/

2)配置环境变量

以 root 编辑 /etc/prole 文件 添加以下内容

##hadoop

export HADOOP_HOME=/opt/modules/hadoop-1.2.1

export PATH=$PATH:/opt/modules/hadoop-1.2.1/bin

以 rootroot root 用户登陆,执行 以下命令,使配置生效 source /etc/prole

4)测试

命令行输入 hadoop

[root@hadoop-master dandelion]# hadoop

4.配置 Hadoop 中的 JDK 安装路径

测试 hadoop

命令行 输入

[root@hadoop-master hadoop-1.2.1]# hadoop jar hadoop-examples-1.2.1.jar

grep /opt/data/input/ /opt/data/output 'dfs[a-z.]+'

详细可参照:hp://blog.csdn.net/qianhaifeng2012/ar$cle/details/49281765

二、Linux 上搭建 Hadoop 环境(伪分布式模

式):

1

2.1)防火墙一定要关闭

2)IP 地址需要静态,不能自动获取

3)修改 hostname 为:hadoop-master

4)hostname 还需与 IP 绑定,命令如下

[root@hadoop-master hadoop-1.2.1]# vim /etc/hosts

127.0.0.1 localhost

192.168.246.128 hadoop-master.dragon.org hadoop-master

5)设置 windows 的 hosts 文件

加上以下内容,与 hadoop 对应

192.168.246.128 hadoop-master hadoop-master.dragon.org

6)ssh 自动登录

$ssh-keygen -t rsa

$cp ~/.ssh/id_rsa.pub ~/.ssh/authorized_keys

复制完成之后,尝试第一次登录

$ ssh localhost

$ ssh hadoop-master

$ ssh hadoop-master.dragon.org

输入 yes 下次 再次输入$ ssh localhost 便不需要重新输入 yes ,因为已经验证一

次

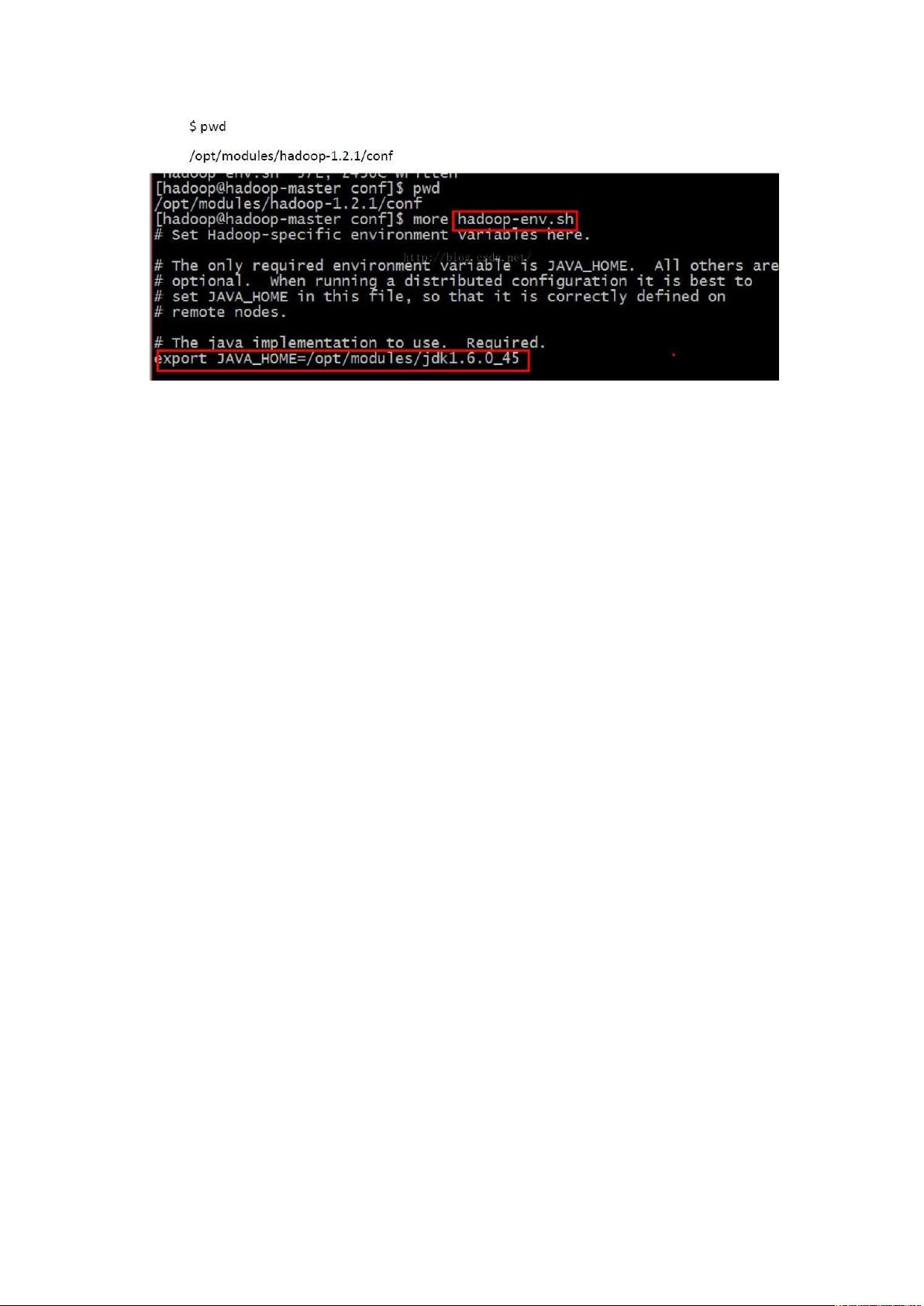

2、配置 hadoop-1.2.1/conf 目录下几个配置文件

hadoop-env.sh

core-site.sh

hdfs-site.sh

mapred-site.sh

其中 hadoop-env.sh 中加入

export JAVA_HOME=/opt/modules/jdk1.6.0_45

core-site.sh 中加入()

<conguraBon>

<property>

<name>fs.default.name</name>

<value>hdfs://hadoop-master.dragon.org:9000</value>

//<value>hdfs://111.11.1.1.1:9000</value> 最好配置成 ip

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/data/tmp</value>

</property>

< /conguraBon>

hdfs-site.sh 中加入

<conguraBon>

<property>

<name>dfs.replicaBon</name>

<value>1</value>

</property>

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

< /conguraBon>

mapred-site.sh 中加入

<conguraBon>

<property>

<name>mapred.job.tracker</name>

<value>hadoop-master.dragon.org:9001</value>

</property>

< /conguraBon>

配置完之后 格式化文件系统

hadoop/bin 目录下 $hadoop namenode -format

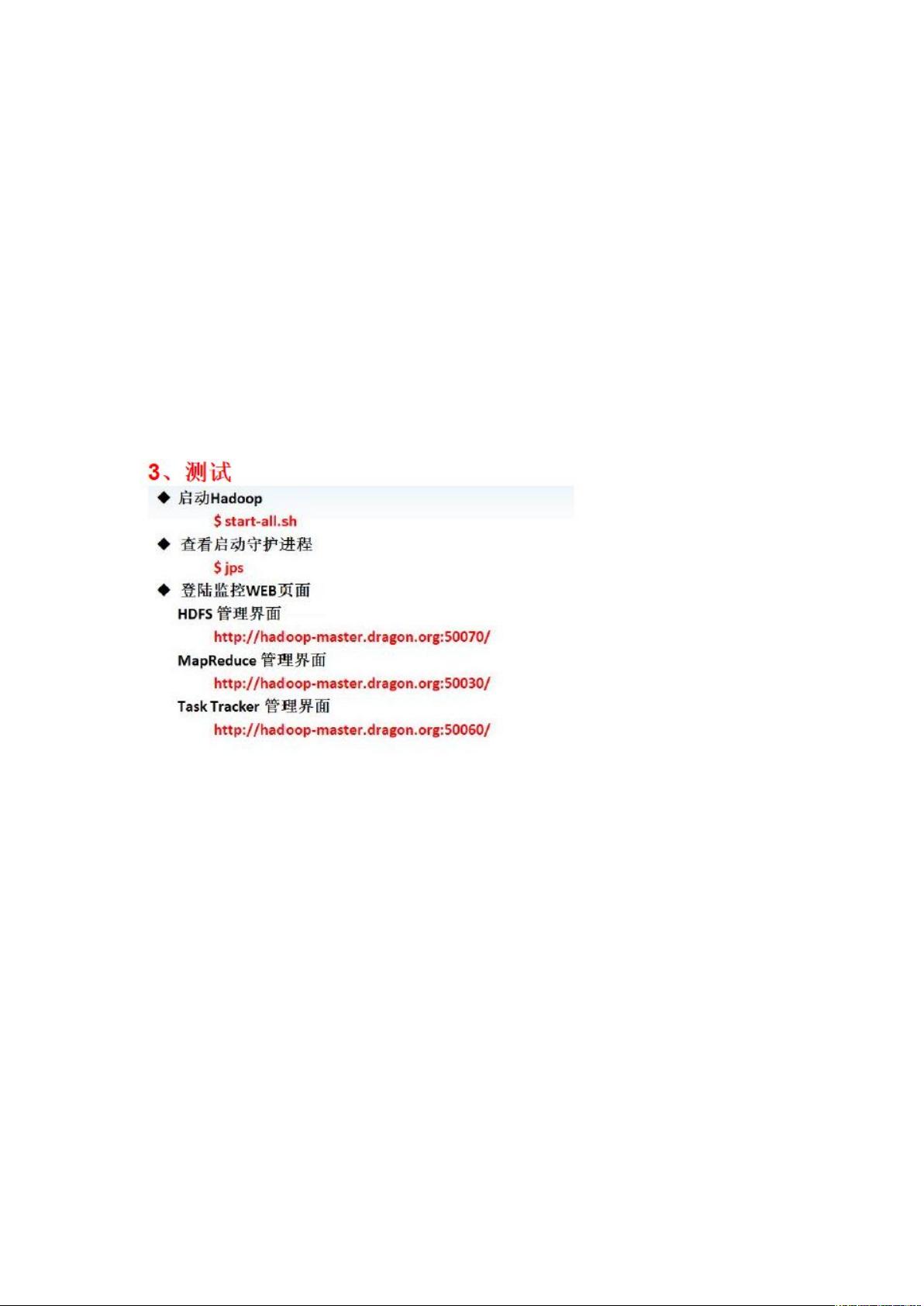

三、Hadoop 的启动停止的三种方法:

1.启动:start-all.sh

启动顺序:namenode、datanode、secondarynamenode、jobtracker、tasktracker

停止:stop-all.sh

停止顺序:与启动顺序相反

2.启动: start-dfs.sh start-mapred.sh

停止:stop-mapred.sh start-dfs.sh (mapred 是运行在 dfs 之上的)

3.启动:

./hadoop-daemon.sh start namenode

./hadoop-daemon.sh start datanode

剩余26页未读,继续阅读

资源评论

木子金丰

- 粉丝: 58

- 资源: 27

上传资源 快速赚钱

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜安全验证

文档复制为VIP权益,开通VIP直接复制

信息提交成功

信息提交成功