hadoop-2.2.0编译安装

需积分: 0 51 浏览量

更新于2015-06-26

收藏 398KB DOC 举报

在本文中,我们将深入探讨如何在64位Linux CentOS 6.5系统上编译和安装Hadoop-2.2.0。Hadoop是一个开源的分布式系统基础架构,旨在简化大规模数据处理和存储。它的核心组件包括HDFS(Hadoop Distributed File System)和MapReduce,分别用于数据存储和计算。

我们要明确的是,Hadoop 2.2.0的官方发行版并不直接支持64位系统,因此我们需要从源码编译以适应64位环境。以下是详细的步骤:

1. **环境准备**:

- 操作系统:Linux CentOS 6.5 64位

- Java开发环境:JDK 1.7.0_79

- 注意,Hadoop依赖于特定版本的JDK,确保正确安装。

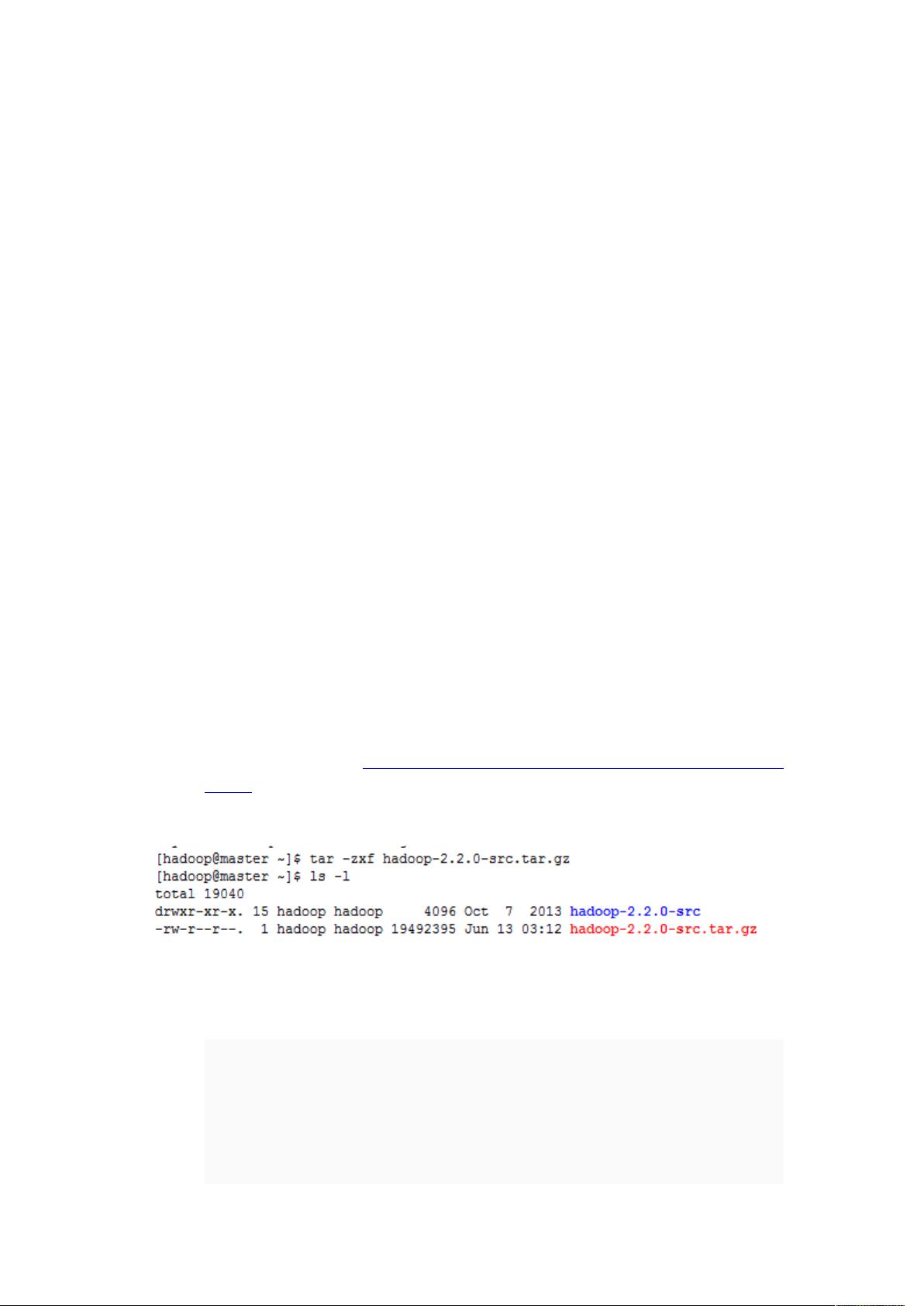

2. **下载源码**:

- 从Apache官网获取Hadoop-2.2.0的源码包:http://archive.apache.org/dist/hadoop/core/hadoop-2.2.0/

- 使用`tar -zxf hadoop-2.2.0-src.tar.gz`解压源码。

3. **修复Hadoop源码中的bug**:

- 修改`hadoop-2.2.0-src/hadoop-common-project/hadoop-auth`目录下的`pom.xml`文件,添加缺少的依赖项,以解决Hadoop 2.2.0的已知问题。

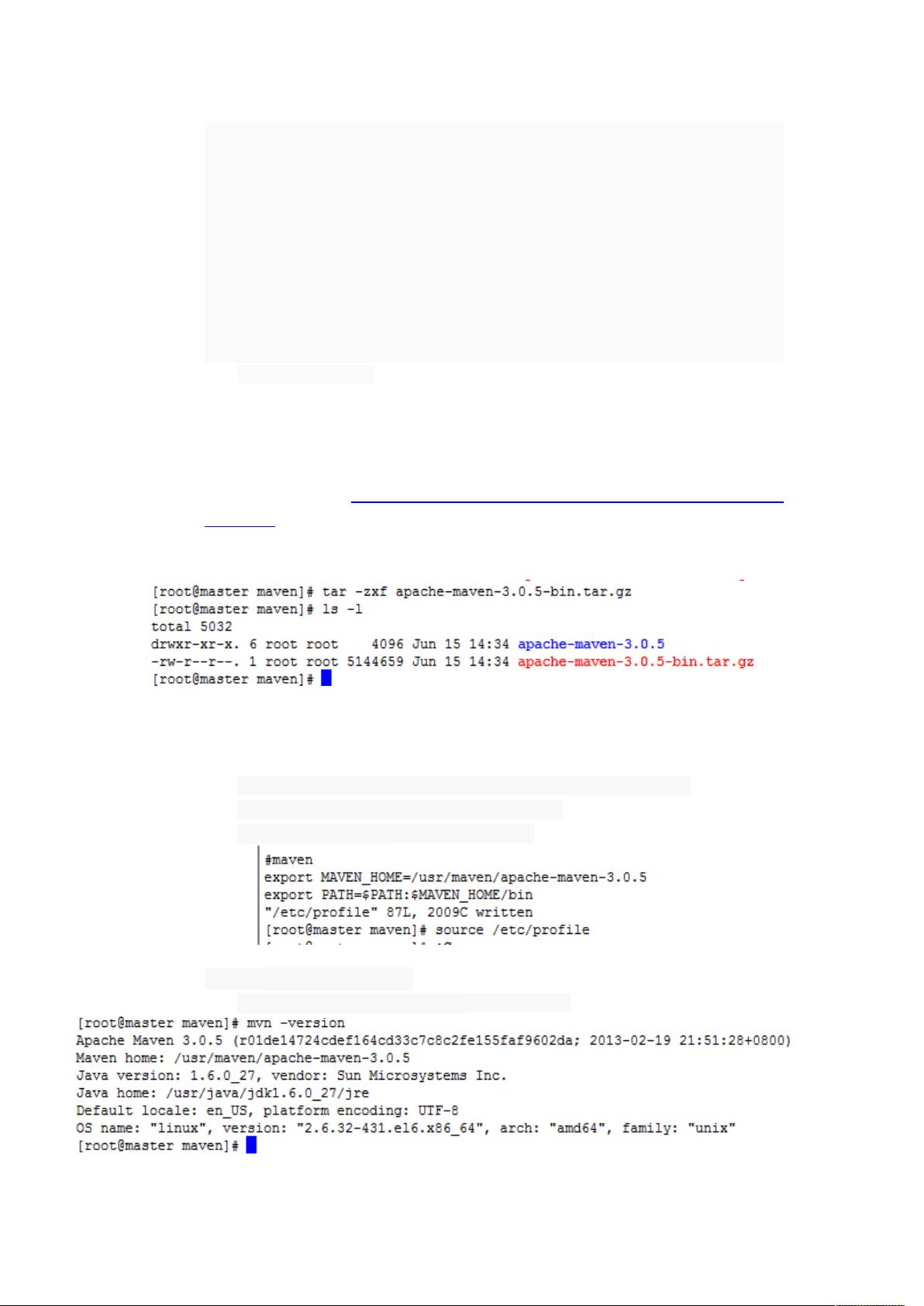

4. **安装Maven**:

- 下载Maven 3.0.5:http://archive.apache.org/dist/maven/maven-3/3.0.5/binaries/

- 解压并配置环境变量,确保`$PATH`包含Maven的`bin`目录。

5. **验证Maven安装**:

- 运行`mvn -version`检查Maven是否安装成功。

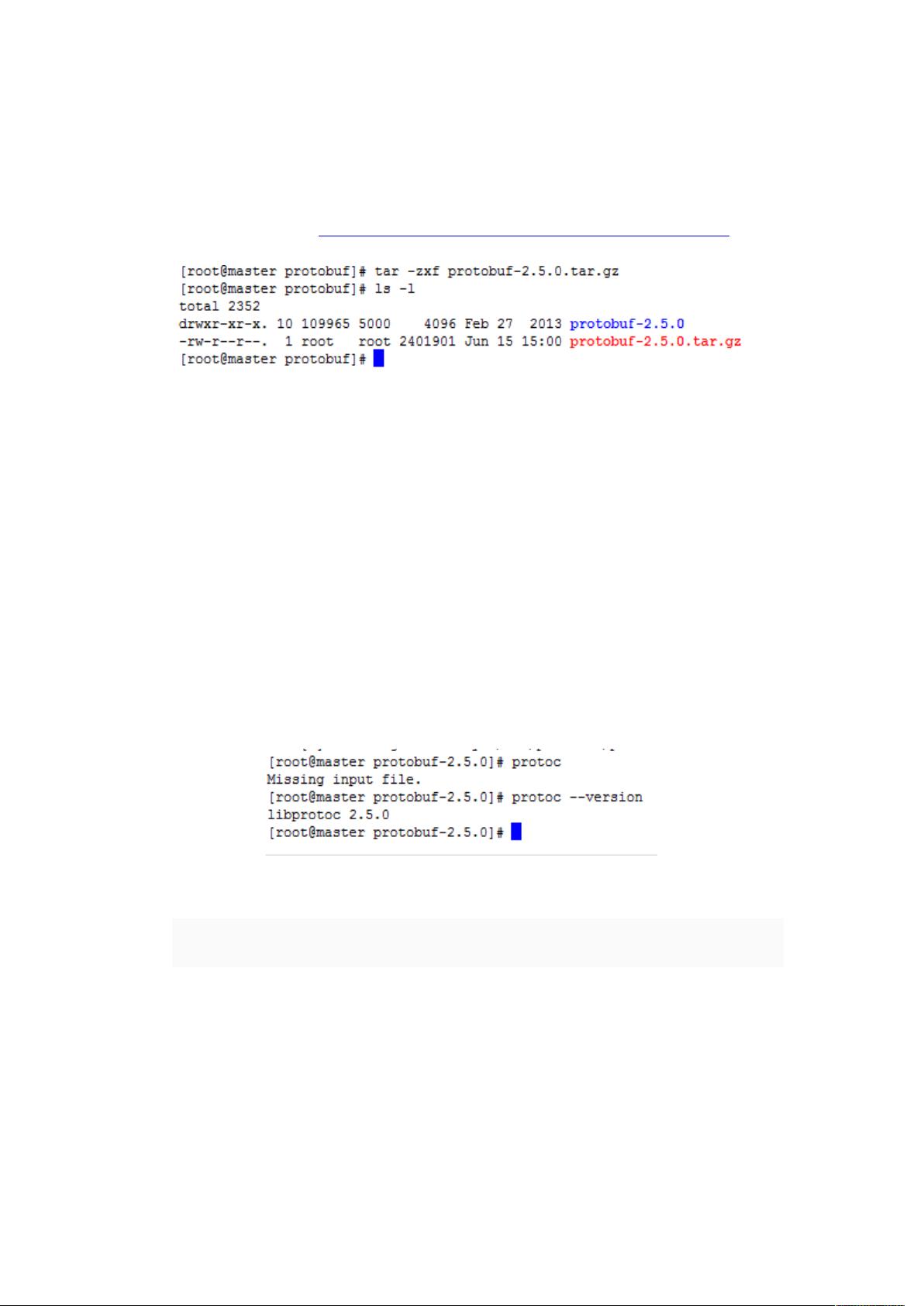

6. **安装protobuf**:

- 下载protobuf 2.5.0:https://code.google.com/p/protobuf/downloads/list

- 解压后安装protobuf及其依赖,如`gcc`和`gcc-c++`。

7. **编译Hadoop源码**:

- 在Hadoop源码根目录下运行`mvn package -Pdist,native -DskipTests -Dtar`来编译Hadoop。

- 编译完成后,会在`hadoop-dist/target`目录下生成打包好的Hadoop二进制文件。

8. **配置Hadoop**:

- 配置`etc/hadoop`目录下的`core-site.xml`、`hdfs-site.xml`、`mapred-site.xml`和`yarn-site.xml`,指定Hadoop的参数,如数据节点、名称节点等。

9. **格式化NameNode**:

- 运行`hadoop namenode -format`命令初始化NameNode。

10. **启动Hadoop服务**:

- 启动DataNode、NameNode、ResourceManager、NodeManager和HistoryServer等Hadoop服务。

11. **分布式安装**:

- 将编译好的Hadoop二进制文件复制到所有节点。

- 在每个节点上配置Hadoop环境变量和相关配置文件。

- 分别启动各节点的服务。

12. **测试Hadoop集群**:

- 运行`hadoop fs -ls /`确认HDFS工作正常。

- 使用`wordcount`示例程序测试MapReduce功能。

总结,Hadoop的编译和安装过程涉及到多个步骤,包括环境准备、源码修复、编译工具安装、Hadoop源码编译、配置及分布式安装。通过这些步骤,我们可以构建一个适应64位系统的Hadoop集群,实现大数据的高效处理和存储。在实际操作过程中,可能会遇到各种问题,需要根据错误提示进行排查和解决。

tory710812

- 粉丝: 0

- 资源: 12

最新资源

- 白色扁平化风格的图书网上商城整站网站模板.zip

- 白色扁平化风格的私人订制旅行模板下载.zip

- 白色扁平化风格的特色菜谱美食网站模板下载.zip

- 白色扁平化风格的外贸企业网站模板下载.zip

- 白色扁平化风格的外贸项目整站网站模板.zip

- 白色扁平化风格的五谷养生模板下载.zip

- 白色扁平化风格的休闲咖啡美食网站模板.zip

- 白色扁平化风格的西餐厅网店模板下载.zip

- 白色扁平化风格的小麦水果蔬菜种植企业网站模板.zip

- 白色扁平化风格的右侧伸缩导航设计网站模板.zip

- 白色扁平化风格的专业摄影师个人作品网站模板.zip

- 白色扁平化风格的医疗管理企业网站模板.rar

- 白色创意风格的房地产建筑整站网站源码下载.zip

- 白色创意风格的单反爱好者网站模板下载.zip

- 白色创意风的铅笔企业网站模板下载.rar

- 白色创意风格的商业CSS网页模板下载.zip