# 中文情感分析

中文情感分析的实质是文本分类问题,本项目分别采用**CNN**和**BI-LSTM**两种模型解决文本分类任务,并用于情感分析,达到不错的效果。

两种模型在小数据集上训练,在验证集的准确率、号回率及F1因子均接近**90%**

项目设计的目标可以接受不同语料的多种分类任务,只要语料按照特定格式准备好,就可以开始调参训练、导出、serving。

### code environment

在 python3.6 & Tensorflow1.13 下工作正常

其他环境也许也可以,但是没有测试过。

还需要安装 `scikit-learn` package 来计算指标,包括准确率回召率和F1因子等等。

### 语料的准备

语料的选择为 *谭松波老师的评论语料*,正负例各2000。属于较小的数据集,本项目包含了原始语料,位于`data/hotel_comment/raw_data/corpus.zip`中

解压 `corpus.zip` 后运行,并在`raw_data`运行

```sh

python fix_corpus.py

```

将原本`gb2312`编码文件转换成`utf-8`编码的文件。

### 词向量的准备

本实验使用开源词向量[*chinese-word-vectors*](https://github.com/Embedding/Chinese-Word-Vectors)

选择知乎语料训练而成的Word Vector, 本项目选择词向量的下载地址为 https://pan.baidu.com/s/1OQ6fQLCgqT43WTwh5fh_lg ,需要百度云下载,解压,直接放在工程目录下

### 训练数据的格式

参考 `data/hotel_comment/*.txt` 文件

- step1

本项目把数据分成训练集和测试集,比例为`4:1`, 集4000个样本被分开,3200个样本的训练集,800的验证集。

对于训练集和验证集,制作训练数据时遵循如下格式:

在`{}.words.txt`文件中,每一行为一个样本的输入,其中每段评论一行,并用`jieba`分词,词与词之间用空格分开。

```text

除了 地段 可以 , 其他 是 一塌糊涂 , 惨不忍睹 。 和 招待所 差不多 。

帮 同事 订 的 酒店 , 他 老兄 刚 从 东莞 回来 , 详细 地问 了 一下 他 对 粤海 酒店 的 印象 , 说 是 硬件 和 软件 : 极好 ! 所以 表扬 一下

```

在`{}.labels.txt`文件中,每一行为一个样本的标记

```text

NEG

POS

```

本项目中,可在`data/hotel_comment`目录下运行`build_data.py`得到相应的格式

- step2

因为本项目用了`index_table_from_file`来获取字符对应的id,需要两个文件表示词汇集和标志集,对应于`vocab.labels.txt`和`vocab.words.txt`,其中每一行代表一个词或者是一行代表一个标志。

本项目中,可在`data/hotel_comment`目录下运行`build_vocab.py`得到相应的文件

- step3

由于下载的词向量非常巨大,需要提取训练语料中出现的字符对应的向量,对应本项目中的`data/hotel_comment/w2v.npz`文件

本项目中,可在`data/hotel_comment`目录下运行`build_embeddings.py`得到相应的文件

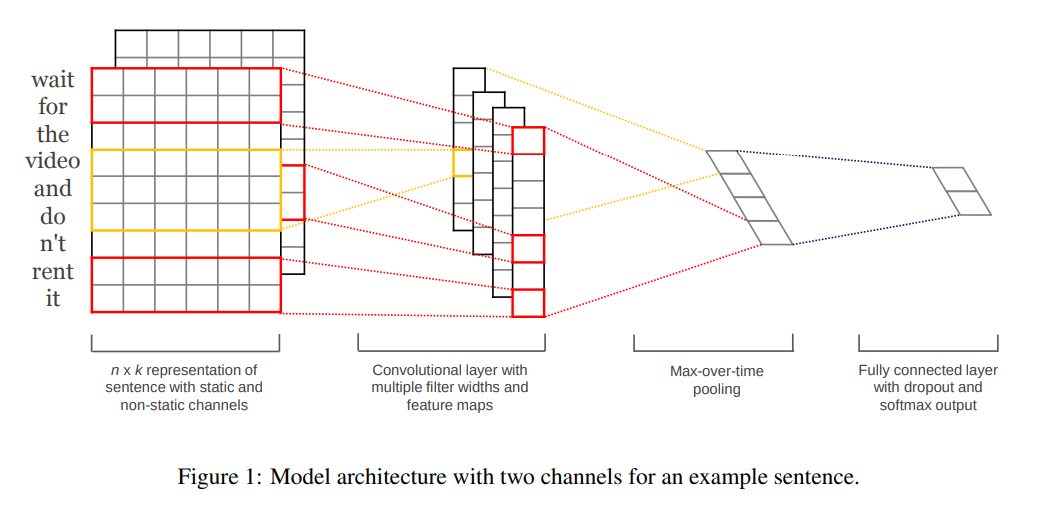

## 模型一:CNN

#### 结构:

1. 中文词Embedding

2. 多个不同长度的定宽卷积核

3. 最大池化层,每个滤波器输出仅取一个最大值

4. 全连接

图来源于论文 https://arxiv.org/abs/1408.5882 ,但与论文不同的是,论文中采取了一个pre-train 的embeddings和一个没有训练的embeddings组成了类似图像概念的双通道。本项目中只采用了一个预训练embeddings的单通道。

CNN模型的训练,在`cnn`目录底下运行

```

python main.py

```

#### CNN模型训练时间

在**GTX 1060 6G**的加持下大概耗时2分钟

#### CNN模型的训练结果

在`model`目录底下运行

```

python score_report.py cnn/results/score/eval.preds.txt

```

输出:

```

precision recall f1-score support

POS 0.91 0.87 0.89 400

NEG 0.88 0.91 0.89 400

micro avg 0.89 0.89 0.89 800

macro avg 0.89 0.89 0.89 800

weighted avg 0.89 0.89 0.89 800

```

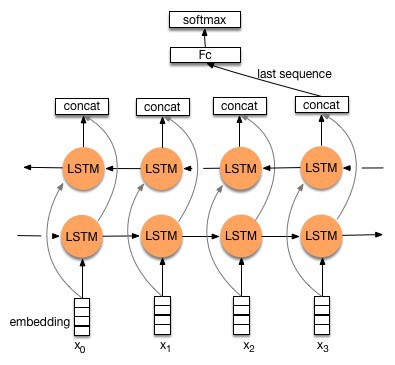

## 模型二: BI-LSTM

1. 中文词Embedding

2. bi-lstm

3. 全连接

BI-LSTM模型的训练,在`lstm`目录底下运行

```

python main.py

```

#### BI-LSTM模型训练时间

在**GTX 1060 6G**的加持下大概耗时5分钟

#### BI-LSTM模型的训练结果

在`model`目录底下运行

```

python score_report.py lstm/results/score/eval.preds.txt

```

输出:

```

precision recall f1-score support

POS 0.90 0.87 0.88 400

NEG 0.87 0.91 0.89 400

micro avg 0.89 0.89 0.89 800

macro avg 0.89 0.89 0.89 800

weighted avg 0.89 0.89 0.89 800

```

### 模型的导出和serving(BI-LSTM为例)

#### 模型导出

在`lstm`目录底下运行

```

python export.py

```

导出`estimator`推断图,可以用作prediction。本项目已上传了`saved_model`,可以不通过训练直接测试。

在`model/lstm`目录底下运行 `python serve.py`可以利用导出的模型进行实体识别。详情见代码。

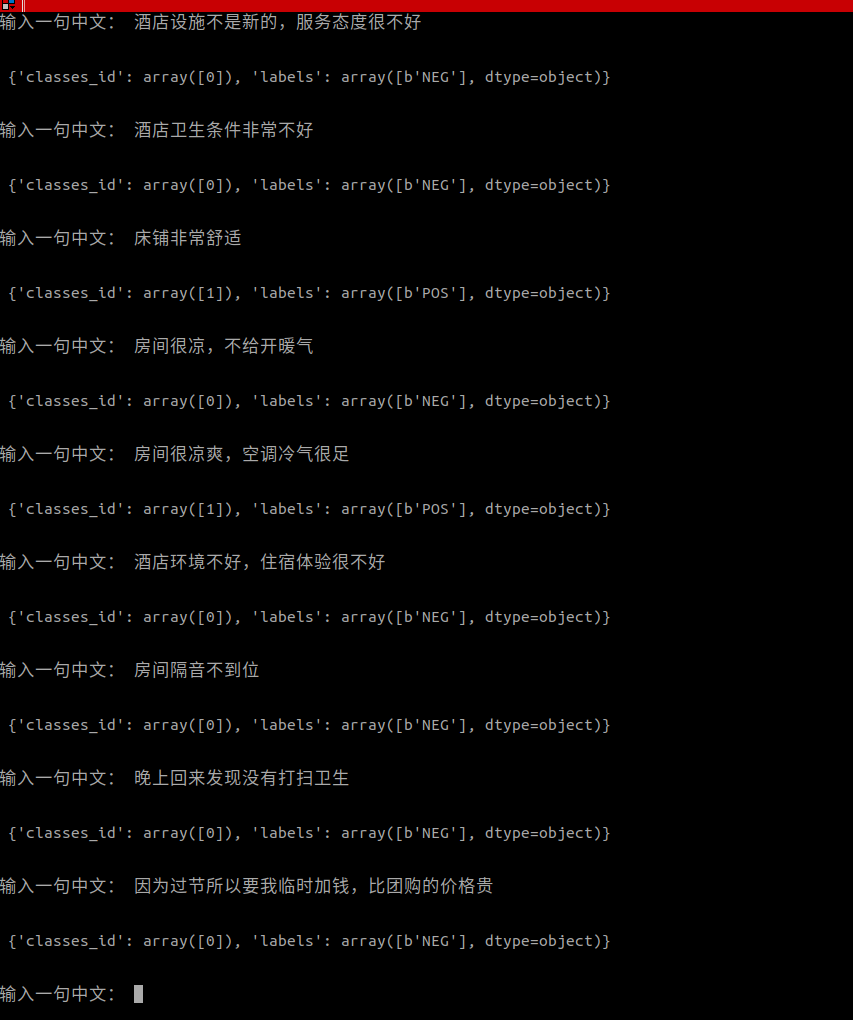

测试结果

虽然模型由真实评论数据训练而成,这些数据长短不一(有的分词后长度超过1000),但由上图可得,模型对短评论表现尚可。

## 参考

[1] http://www.wildml.com/2015/12/implementing-a-cnn-for-text-classification-in-tensorflow/

[2] https://arxiv.org/abs/1408.5882

没有合适的资源?快使用搜索试试~ 我知道了~

django项目实战之网络舆情分析系统Python源码+说明(毕业设计项目)

共36个文件

py:13个

txt:10个

png:2个

1.该资源内容由用户上传,如若侵权请联系客服进行举报

2.虚拟产品一经售出概不退款(资源遇到问题,请及时私信上传者)

2.虚拟产品一经售出概不退款(资源遇到问题,请及时私信上传者)

版权申诉

0 下载量 82 浏览量

2024-10-28

08:18:36

上传

评论

收藏 298.36MB ZIP 举报

温馨提示

django项目实战之网络舆情分析系统Python源码+说明(毕业设计项目),该项目是个人毕设项目,答辩评审分达到98分,代码都经过调试测试,确保可以运行!欢迎下载使用,可用于小白学习、进阶。该资源主要针对计算机、通信、人工智能、自动化等相关专业的学生、老师或从业者下载使用,亦可作为期末课程设计、课程大作业、毕业设计等。项目整体具有较高的学习借鉴价值!基础能力强的可以在此基础上修改调整,以实现不同的功能。 django项目实战之网络舆情分析系统Python源码+说明(毕业设计项目)django项目实战之网络舆情分析系统Python源码+说明(毕业设计项目)django项目实战之网络舆情分析系统Python源码+说明(毕业设计项目)django项目实战之网络舆情分析系统Python源码+说明(毕业设计项目)django项目实战之网络舆情分析系统Python源码+说明(毕业设计项目)django项目实战之网络舆情分析系统Python源码+说明(毕业设计项目)django项目实战之网络舆情分析系统Python源码+说明(毕业设计项目)django项目实战之网络舆情分析系统Python源码+

资源推荐

资源详情

资源评论

收起资源包目录

django项目实战之网络舆情分析系统(源码+说明).zip (36个子文件)

django项目实战之网络舆情分析系统(源码+说明).zip (36个子文件)  -master

-master  pic

pic  1_GRQ91HNASB7MAJPTTlVvfw.jpeg 30KB

1_GRQ91HNASB7MAJPTTlVvfw.jpeg 30KB clip.png 133KB

clip.png 133KB 截图_选择区域_20211202181126.png 68KB

截图_选择区域_20211202181126.png 68KB sgns.zhihu.bigram本项目词向量.bz2 226.43MB

sgns.zhihu.bigram本项目词向量.bz2 226.43MB data

data  hotel_comment

hotel_comment  vocab.words.txt 159KB

vocab.words.txt 159KB raw_data

raw_data  fix_coupus.py 946B

fix_coupus.py 946B corpus.zip 1.43MB

corpus.zip 1.43MB train.labels.txt 13KB

train.labels.txt 13KB eval.labels.txt 3KB

eval.labels.txt 3KB train.words.txt 1.47MB

train.words.txt 1.47MB vocab.labels.txt 8B

vocab.labels.txt 8B build_data.py 1KB

build_data.py 1KB build_vocab.py 1KB

build_vocab.py 1KB build_embedings.py 1KB

build_embedings.py 1KB eval.words.txt 362KB

eval.words.txt 362KB model

model  cnn

cnn  serve.py 1KB

serve.py 1KB main.py 7KB

main.py 7KB export.py 664B

export.py 664B debug.py 838B

debug.py 838B saved_model

saved_model  1557069338

1557069338  assets

assets  vocab.words.txt 159KB

vocab.words.txt 159KB vocab.labels.txt 8B

vocab.labels.txt 8B saved_model.pb 24.61MB

saved_model.pb 24.61MB variables

variables  variables.index 464B

variables.index 464B variables.data-00000-of-00001 25.25MB

variables.data-00000-of-00001 25.25MB lstm

lstm  serve.py 994B

serve.py 994B main.py 6KB

main.py 6KB export.py 789B

export.py 789B debug.py 776B

debug.py 776B saved_model

saved_model  1557073579

1557073579  assets

assets  vocab.words.txt 159KB

vocab.words.txt 159KB vocab.labels.txt 8B

vocab.labels.txt 8B saved_model.pb 24.63MB

saved_model.pb 24.63MB variables

variables  variables.index 387B

variables.index 387B variables.data-00000-of-00001 24.91MB

variables.data-00000-of-00001 24.91MB score_report.py 697B

score_report.py 697B .gitignore 172B

.gitignore 172B README.md 6KB

README.md 6KB共 36 条

- 1

资源评论

yava_free

- 粉丝: 4776

- 资源: 1849

上传资源 快速赚钱

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

资源上传下载、课程学习等过程中有任何疑问或建议,欢迎提出宝贵意见哦~我们会及时处理!

点击此处反馈

安全验证

文档复制为VIP权益,开通VIP直接复制

信息提交成功

信息提交成功