什么是 ChatGPT 思维? 时间旅行游戏和对类人工具的危险期望

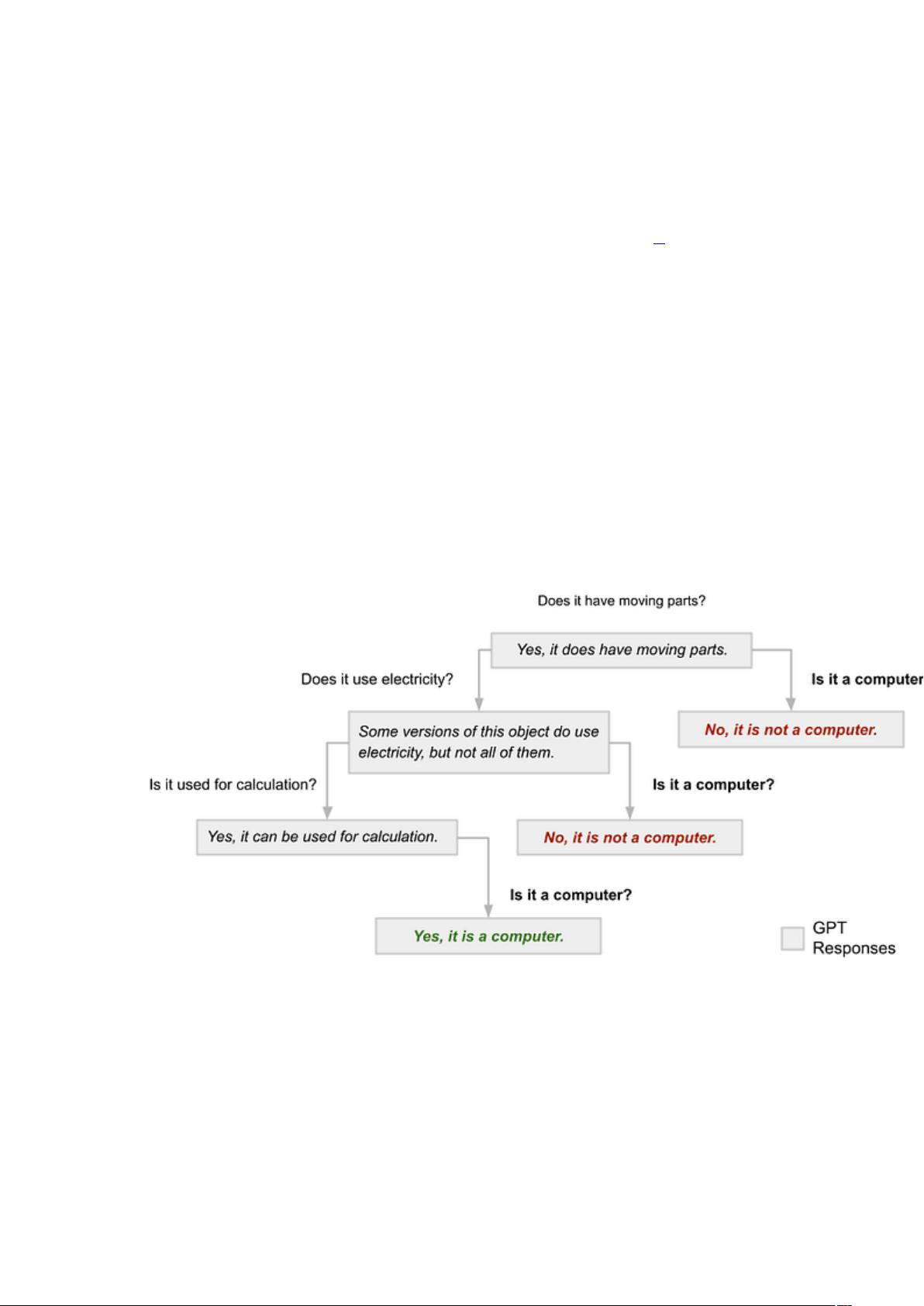

介绍 我们生活在非常时期。大约三周前,OpenAI通过 ChatGPT [ 2 ]向公众提供了GPT–4 [ 1 ],这真是一个奇迹!该模型及其同类模型(大型语言模型 [LLM])及其后继者将推动巨大的创新和变革。一些最令人兴奋的发展是微软研究院的“通用人工智能的火花:GPT-4 的早期实验”[ 3 ]中概述的各种新兴功能。 这些包括: 心智理论 [ 4 ]——模型描述人类知识状态的能力,其中可能包含关于特定场景的不完整信息,以及 工具使用——系统接触并利用外部工具(例如计算器)以在提供适当界面时补充其响应的能力。 可以理解的是,人们急于将这些技术产品化,并付出了巨大的努力来描述这些模型的风险和局限性 [ 5、6 ]。但可能比之前出现的任何技术都更不清楚如何与这些新应用程序相关联。它们是用于简单的信息检索和总结吗?显然不是。他们的一大优势是交互式地回答后续问题和澄清请求。他们不是通过技术查询语言,而是通过我们的人类语言来做到这一点——这让我们非常接近“你”而不是“它”。 在这篇文章中,我将首先分享一个使用 Chat 这些功能要求模型开发高级抽象,使其能够以非常复杂的方式进行概括。 ChatGPT思维是指大型语言模型(LLM),如OpenAI的GPT-4,展现出的模仿人类思维方式的能力。这些模型不仅能够处理和生成人类语言,还能进行心智理论,即理解人类知识状态,甚至能利用外部工具,如计算器,来增强其响应。然而,ChatGPT等模型的交互性和复杂性引发了一系列讨论,尤其是在风险和局限性方面。 在描述的一个时间旅行游戏中,ChatGPT被测试者要求玩类似于“20个问题”的游戏。测试者发现,尽管ChatGPT在某些情况下表现出较高的推理能力,但在其他时候,模型的响应并不一致,显示出无状态性。这意味着模型对同一输入可能会有不同的输出,这与人类思考的连贯性相悖。这种行为可能源于模型的统计先验,即它们基于转换器架构,每一个新的计算都会产生不同的响应,而不保留之前的对话状态。 可解释性是机器学习领域的重要议题,特别是对于像ChatGPT这样的LLM。由于模型的复杂性、规模、闭源实现以及开放式生成任务,现有的可解释性技术很难应用。尽管用户可以询问模型为何产生特定响应,但这些解释并不总是可靠的,因为它们只是基于统计预测的文本补全,而非真正反映模型的推理过程。此外,解释可能不稳定,容易受到虚假上下文的影响。 对于使用LLM的开发者和用户来说,重要的是理解这些工具的局限性。尽管它们在信息检索、总结和交互式问答上表现出色,但它们并不具备人类那样的状态记忆或一致推理能力。这种认识对于避免对类人工具产生不切实际的期望至关重要,特别是在设计依赖这些模型的软件或插件时。未来的研究应专注于如何增强模型的稳定性和可解释性,同时保持其强大的语言生成能力,以确保这些技术在创新的同时,也能在伦理和安全方面得到适当的管理。

剩余11页未读,继续阅读

- 粉丝: 1699

- 资源: 418

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功