解决出现CUDA error-out of memory的问题.pdf

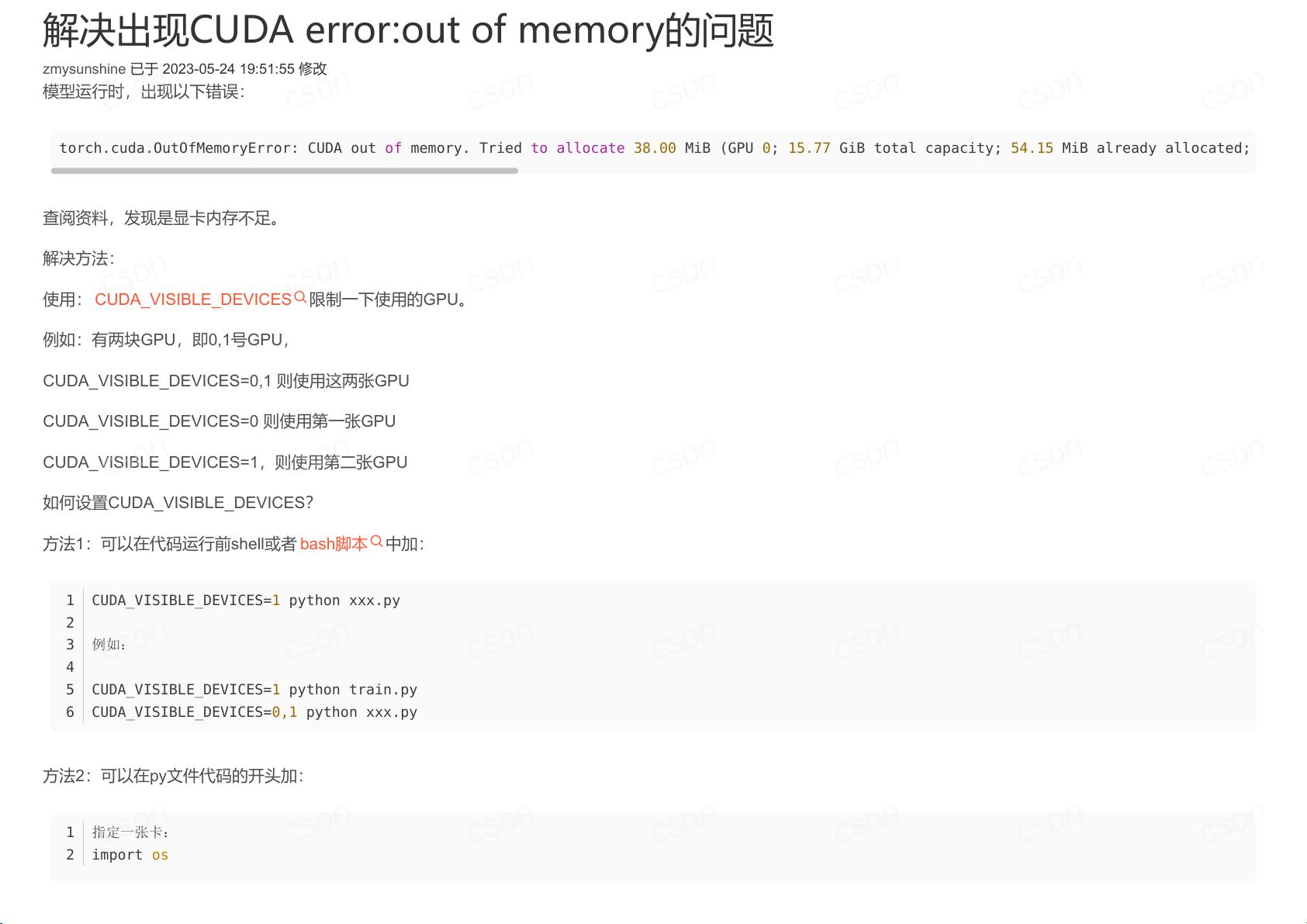

在深度学习领域,CUDA(Compute Unified Device Architecture)是NVIDIA公司推出的一种编程接口,它允许开发者利用GPU的强大计算能力进行并行处理。然而,在训练深度学习模型时,我们经常遇到“CUDA error: out of memory”这样的错误,这表明GPU的显存不足以运行当前的任务。本文将详细介绍这个问题的原因、影响以及解决方法。 ### 问题原因 1. **模型复杂度过高**:深度学习模型的大小(权重和参数的数量)和网络结构决定了其对显存的需求。如果模型过于复杂,需要加载到显存的数据量会显著增加。 2. **批量大小过大**:在训练过程中,我们通常以批次(batch)的方式处理数据。批量大小越大,GPU需要一次性存储的数据越多。 3. **优化器状态**:优化器如SGD(随机梯度下降)在训练过程中会存储梯度信息,这也会占用显存。 4. **缓存和临时数据**:运算过程中可能产生大量临时数据,如果没有及时清理,会占用显存。 ### 解决策略 1. **减少批量大小**:减小批量大小可以降低每次迭代时GPU内存的需求。这是最直接且常用的解决办法,但可能会延长训练时间。 2. **调整模型架构**:简化模型结构,如减少层数、通道数或使用更轻量级的卷积核,可以降低模型对显存的需求。 3. **使用混合精度训练**:利用NVIDIA的混合精度训练(AMP,Automatic Mixed Precision),使用半精度浮点数代替单精度,可以显著减少显存使用。 4. **动态批大小**:根据GPU的可用显存动态调整批量大小,例如使用`torch.cuda.memory_allocated()`和`torch.cuda.memory_cached()`来监测显存使用情况。 5. **数据预处理**:对输入数据进行预处理,如压缩、归一化,减少数据在GPU上的占用。 6. **内存管理**:手动释放不再需要的张量,如在PyTorch中使用`torch.cuda.empty_cache()`来清空GPU缓存。 7. **CUDA_VISIBLE_DEVICES**:通过设置环境变量`CUDA_VISIBLE_DEVICES`选择性地使用GPU,避免多GPU环境下所有GPU同时工作导致的显存耗尽。例如: - `CUDA_VISIBLE_DEVICES=0` 只使用第一张GPU。 - `CUDA_VISIBLE_DEVICES=1` 只使用第二张GPU。 - `CUDA_VISIBLE_DEVICES=0,1` 使用第一张和第二张GPU。 8. **分布式训练**:如果有多张GPU,可以考虑使用数据并行、模型并行或混合并行等分布式训练策略,将任务分配到不同的GPU上。 9. **优化器状态管理**:对于一些优化器,如Adam,可以考虑减少动量历史的存储,或者使用不存储历史动量的优化器变体。 10. **使用GPU内存限制**:在PyTorch中,可以通过`torch.cuda.set_per_process_memory_fraction()`来限制每个进程可用的GPU内存比例。 以上策略并非孤立使用,而是需要根据实际项目需求和硬件资源灵活组合,以找到最适合的解决方案。理解并掌握这些技巧对于有效利用GPU资源、避免或解决“CUDA error: out of memory”问题至关重要。在实践中,应结合日志监控和调试工具,对模型的显存使用进行精细化管理,确保训练过程的顺利进行。

- 粉丝: 7863

- 资源: 5

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功