是空空呀

- 粉丝: 197

- 资源: 3万+

最新资源

- Matlab版本2023b的Embedded Coder Support Package for ARM Cortex-M Processors支持包免费分享,1.8G压缩包分成3个(2/3)

- ghostscript-10.0.0

- 医疗保障信息平台定点医药机构接口规范

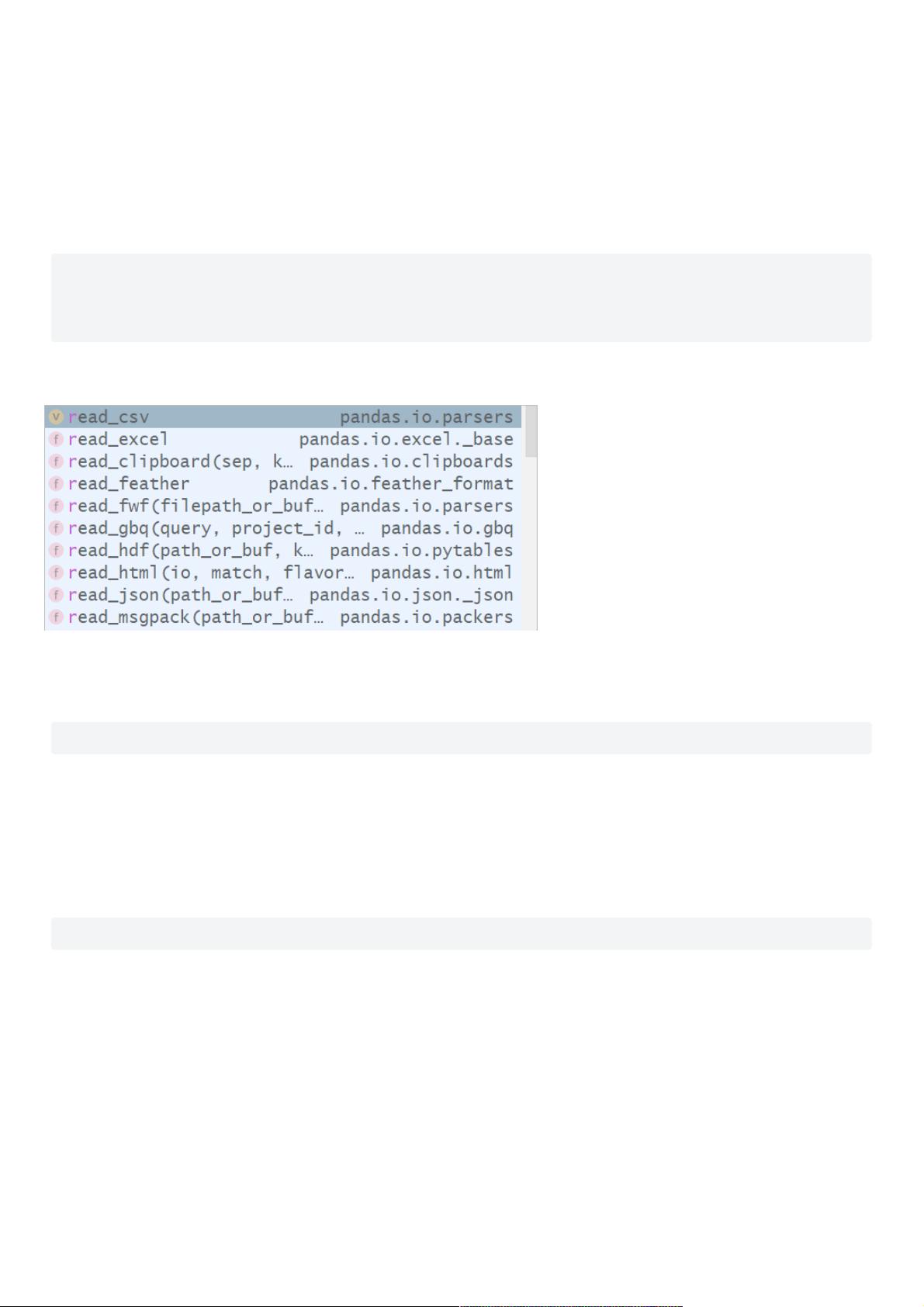

- Python编程基础入门到高级开发技巧指南

- 手机充电头外观尺寸检测机工程图机械结构设计图纸和其它技术资料和技术方案非常好100%好用.zip

- JSP EIMS系统-OA子系统的设计与开发(源代码+LW).zip

- (JSP)JTBC_CMS_2.0.0.8.zip

- linux java jdk8

- Windows系统上Tomcat的安装与配置详解

- Linux-Shell基础命令语言

- 服装图像数据集,衣服图像数据,包含服装属性

- Matlab版本2023b的Embedded Coder Support Package for ARM Cortex-M Processors支持包免费分享,1.8G压缩包分成3个(3/3)

- glove11111wwee.pdf

- ECharts象形柱图-圣诞愿望清单和山峰高度-4.zip

- ECharts象形柱图-人体含水量-2.zip

- ECharts象形柱图-驯鹿的速度-6.zip

资源上传下载、课程学习等过程中有任何疑问或建议,欢迎提出宝贵意见哦~我们会及时处理!

点击此处反馈