Hadoop生态系统及其版本演化.doc

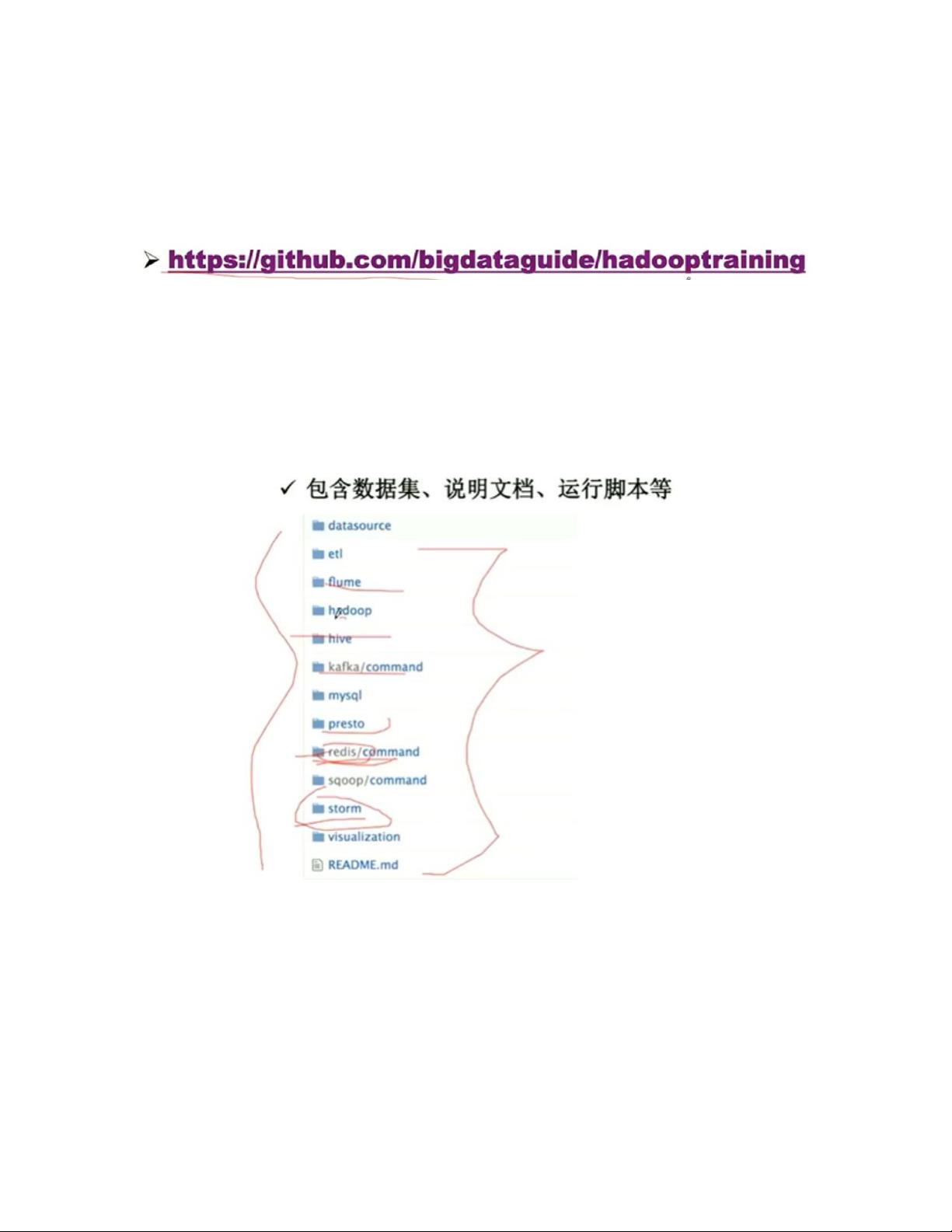

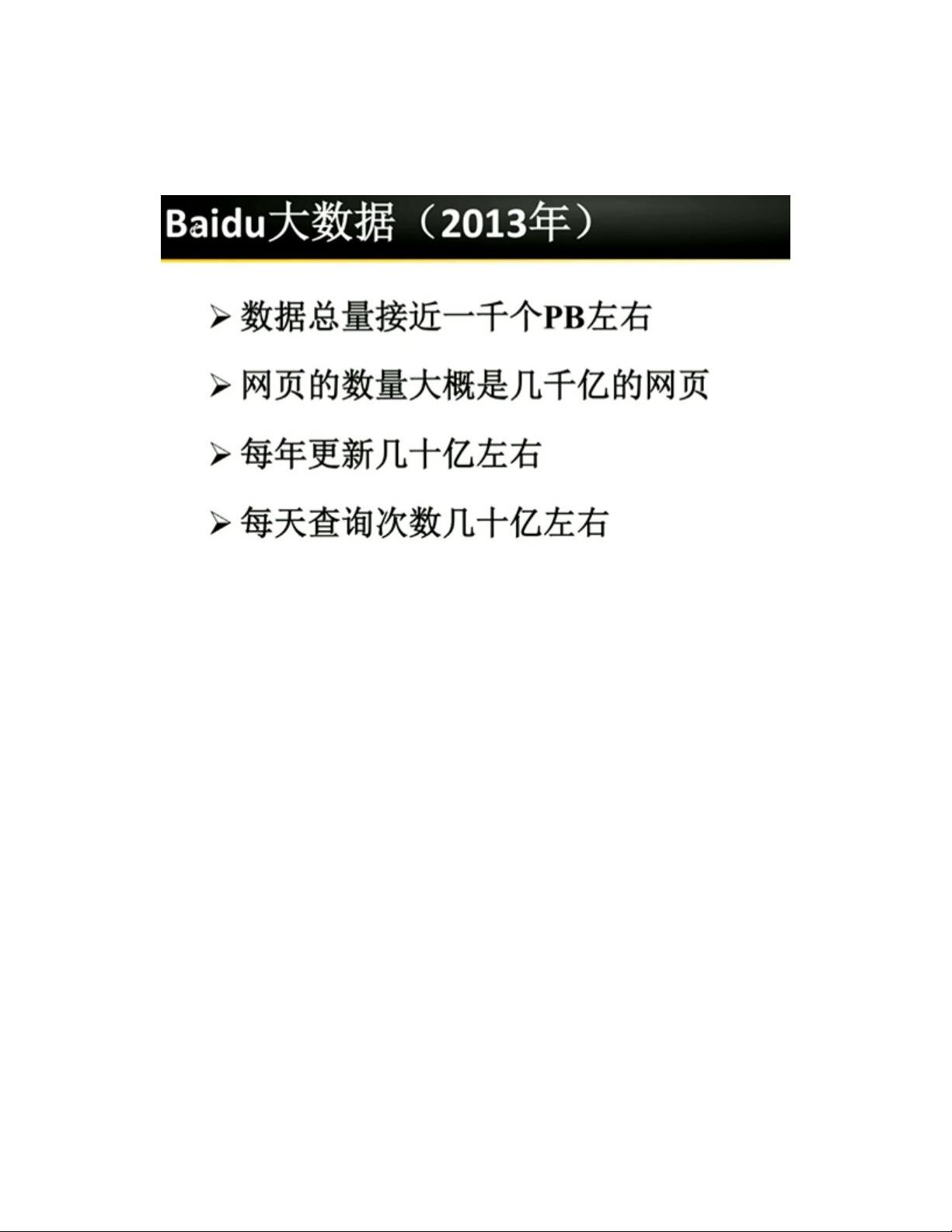

【Hadoop生态系统及其版本演化】 Hadoop是一个开源的分布式计算框架,主要用于处理和存储大规模数据。它的出现源于互联网行业的快速发展,尤其是搜索引擎和电子商务等领域的数据处理需求。Hadoop以其高效、可扩展和容错性高的特点,成为了大数据处理的核心工具。 大数据技术框架通常包括四个主要部分:数据收集、数据存储、数据分析和数据可视化。Hadoop生态系统围绕这些部分构建了一系列组件,以满足不同需求。例如: 1. **数据收集**:Flume是Hadoop生态系统中用于收集、聚合和移动大量日志数据的工具。它可以将来自不同源的数据流式传输到HDFS或其它存储系统。 2. **数据存储**:Hadoop分布式文件系统(HDFS)是Hadoop的核心组件,提供高吞吐量的数据访问,适合大规模数据集的存储。HBase是基于HDFS的分布式数据库,支持实时读写,适用于结构化和半结构化数据。 3. **资源管理**:YARN(Yet Another Resource Negotiator)是Hadoop的资源管理系统,负责调度和管理集群中的计算资源,为MapReduce等计算框架提供服务。 4. **数据分析**:Hive是基于Hadoop的数据仓库工具,提供了SQL-like查询接口,方便数据分析师进行大数据分析。Presto是一个快速、分布式、可扩展的SQL查询引擎,专为交互式查询设计,能在多种数据源上运行。 5. **版本演化**:Hadoop经历了多个版本的迭代,从最初的1.x到现在的3.x。2.x引入了YARN,解决了资源管理和任务调度的问题。3.x版本带来了更多的优化和新特性,如更好的性能、更丰富的功能和更高的兼容性。 学习Hadoop需要一定的基础知识,包括Linux操作、Java编程、项目构建工具Maven的使用,以及集成开发环境如Eclipse或IntelliJ IDEA。虽然这些要求较高,但并不需要精通,具备基本的使用能力即可。掌握Hadoop能让你具备处理大数据问题的能力,进行程序调优,并理解大数据处理的一般思路。 Hadoop的学习有一定难度,因为它涵盖众多系统和方向,如数据收集、存储、资源管理和分析。但其核心API相对稳定,即使Hadoop内核有变化,对应用开发者的影响较小。通过持续学习和实践,可以从本课程中获取构建大数据项目的基础知识,掌握项目架构和技术原型。 课程内容将逐步讲解Hadoop生态系统,包括概述、版本演化、安装部署,以及通过分布式日志分析系统的实战案例,帮助学员理解和掌握Hadoop在实际场景中的应用。课程资料会在GitHub上持续更新,以便学员跟踪学习。 Hadoop生态系统是大数据处理的重要组成部分,了解并掌握其原理和应用对于从事大数据工作具有重要意义。随着技术的发展,Hadoop将持续演进,适应不断变化的数据处理需求。

剩余48页未读,继续阅读

- 粉丝: 21

- 资源: 6

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- (源码)基于ESP8266的WebDAV服务器与3D打印机管理系统.zip

- (源码)基于Nio实现的Mycat 2.0数据库代理系统.zip

- (源码)基于Java的高校学生就业管理系统.zip

- (源码)基于Spring Boot框架的博客系统.zip

- (源码)基于Spring Boot框架的博客管理系统.zip

- (源码)基于ESP8266和Blynk的IR设备控制系统.zip

- (源码)基于Java和JSP的校园论坛系统.zip

- (源码)基于ROS Kinetic框架的AGV激光雷达导航与SLAM系统.zip

- (源码)基于PythonDjango框架的资产管理系统.zip

- (源码)基于计算机系统原理与Arduino技术的学习平台.zip

信息提交成功

信息提交成功