一份PPT带你快速了解Graph Transformer:包括Graph Transformer 的简要回顾且其与GNN、Transformer的关联

【图-注意力笔记,篇章1】Graph Transformer:包括Graph Transformer 的了解与回顾且其与GNN、Transformer的关联

【图-注意力笔记,篇章2】Graphormer 和 GraphFormers论文笔记之两篇经典Graph Transformer来入门

【异构图笔记,篇章3】GATNE论文阅读笔记与理解:General Attributed Multiplex HeTerogeneous Network Embedding

包含这几个部分

可以参考我的博客:https://blog.csdn.net/qq_41895003/article/details/129218936

图注意力机制是近年来在深度学习领域中,特别是图神经网络(GNN)和Transformer模型结合的一个重要研究方向。这份由FRyan制作的PPT详细介绍了这一机制,旨在帮助读者快速理解Graph Transformer及其与GNN、Transformer的关系。

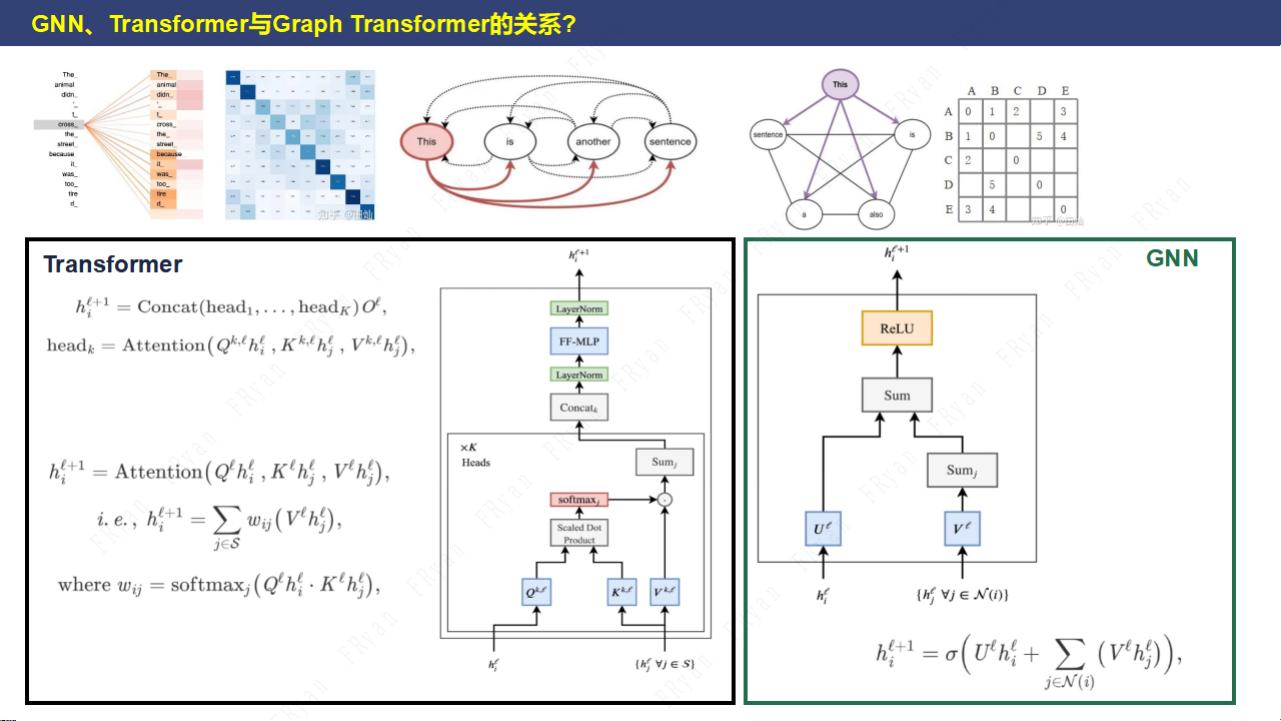

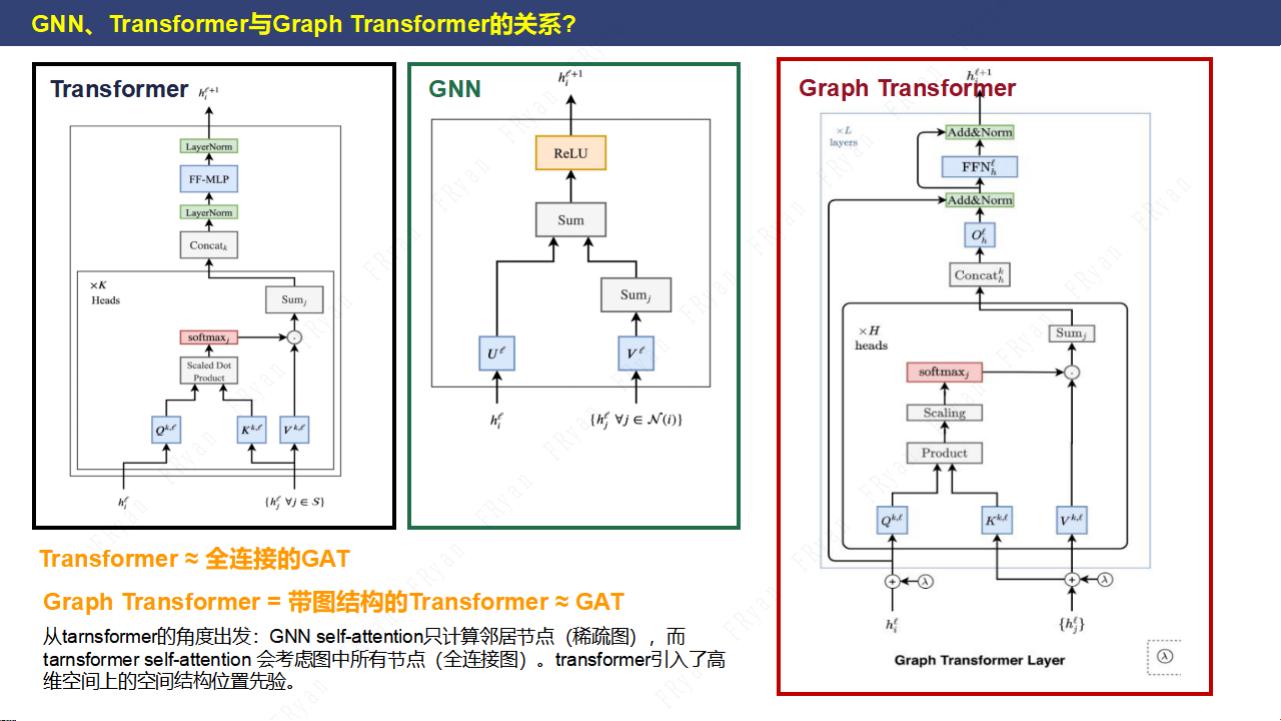

我们要知道图神经网络(GNN)是一种专门处理图数据的深度学习模型,它可以对节点、边和整个图进行信息传播和聚合,以学习节点的嵌入表示。GNN的基本操作包括消息传递和节点特征的更新,通过多轮迭代实现图中信息的全局传播。

Transformer,最初由Vaswani等人在2017年提出,是自然语言处理领域的一次重大突破。Transformer模型的核心是自注意力机制(Self-Attention),它允许模型在计算每个位置的表示时考虑序列中所有位置的信息,从而具备了处理长距离依赖的能力。

Graph Transformer则是将Transformer的注意力机制应用到图数据上,它扩展了Transformer的自注意力机制,使其能够处理非欧几里得结构的数据。在Graph Transformer中,每个节点可以“关注”其他节点,权重取决于它们之间的关系强度,这与Transformer中的查询、键和值的概念类似。这种机制使得Graph Transformer在图数据的建模上具有强大的表达能力。

Graphormer是Graph Transformer的一个具体实现,由Ying等人为Facebook AI Research开发。它提出了一系列针对图数据的改进策略,如边缘注意力、局部和全局上下文的融合、定向注意力等,提高了图学习任务的性能。GraphFormers是对Graphormer的进一步发展,可能包含了更多的优化和扩展,以适应更多类型和复杂性的图数据。

GAT(Graph Attention Network)是另一种基于注意力机制的GNN模型,由Veličković等人提出。GAT引入了注意力机制来动态地为每个节点的邻居分配权重,而不是采用传统的均等加权方式。GATNE(General Attributed Multiplex HeTerogeneous Network Embedding)是GAT在网络嵌入领域的应用,它可以处理带有属性的异构图,即图中包含不同类型的节点和边。

通过阅读GATNE的论文笔记,我们可以深入理解如何在异构图环境中有效地学习节点嵌入,以及如何利用属性信息来增强嵌入的表达能力。这些笔记通常会涵盖模型架构、训练方法、实验结果和实际应用。

图注意力机制是连接GNN和Transformer的重要桥梁,它在图数据的处理中展示了强大的潜力。通过FRyan的PPT和相关笔记,读者可以系统地学习这一机制,并掌握如何将其应用于实际问题中。无论是对于图数据的分析、节点分类、链接预测还是其他图相关的任务,图注意力机制都是一个不可或缺的工具。