Spark Python API,通常被称为PySpark,是Apache Spark与Python编程语言的接口,使得开发者能够利用Python的简洁性和Spark的强大计算能力处理大规模数据。PySpark在大数据处理领域具有广泛的应用,尤其适合于数据科学和机器学习项目。下面我们将深入探讨PySpark API中的关键概念和常用函数。 1. **SparkContext(SC)**:这是PySpark程序的核心,它连接到Spark集群并初始化所有其他组件。`SparkConf()`用于配置Spark,`SparkContext(conf=conf)`则用于创建SparkContext实例。 2. **RDD(弹性分布式数据集)**:RDD是Spark中最基本的数据抽象,它是不可变的、分区的记录集合。通过`sc.parallelize()`或`sc.textFile()`方法可以从现有数据源创建RDD。 3. **DataFrame和Dataset**:DataFrame是基于RDD的优化存储结构,支持SQL查询和关系数据库操作。它可以通过`sqlContext.read.format()`读取多种格式的数据,如CSV、JSON、Parquet等。Dataset是DataFrame的类型安全版本,提供了更丰富的编译时检查。 4. **转换(Transformations)**:RDD、DataFrame和Dataset可以进行一系列转换,如`map()`, `filter()`, `flatMap()`, `groupByKey()`, `reduceByKey()`, `join()`, `distinct()`等。这些转换定义了数据处理逻辑,但不会立即执行,只有在触发行动操作时才会计算。 5. **行动(Actions)**:行动如`count()`, `collect()`, `save()`, `take()`等会触发计算并返回结果。`count()`返回RDD元素数量,`collect()`将结果返回到驱动程序,`save()`将数据写入持久化存储。 6. **DataFrame和Dataset的操作**:DataFrame提供了丰富的SQL查询功能,如`select()`, `where()`, `groupBy()`, `agg()`, `join()`等。Dataset则提供了对Java泛型的支持,允许更强类型的安全性。 7. **广播变量(Broadcast Variables)**:广播变量用于在每个Executor之间高效地分发大对象。使用`sc.broadcast()`创建,然后在任务中使用`value`属性访问。 8. **累加器(Accumulators)**:累加器是只写的共享变量,可以在任务中增加值,但不能读取。适用于收集统计信息,如`sc.accumulator()`。 9. **PySpark SQL**:PySpark提供了一个名为`pyspark.sql`的模块,支持DataFrame的SQL查询。可以创建DataFrame注册为临时视图,然后使用`sql()`函数执行SQL查询。 10. **Spark SQL和HBase集成**:通过`HBaseContext`,PySpark可以与HBase数据库交互,进行数据读写。`hbase_table = sqlContext.read.format('org.apache.spark.sql.hbase')...`用于读取HBase表,`df.write.format('org.apache.spark.sql.hbase')...`用于写入。 11. **PySpark调试和性能优化**:PySpark程序可以通过设置`spark.sql.shuffle.partitions`等配置参数来调整性能。此外,使用`%pylab inline`和`display`函数可以在Jupyter notebook中实时查看数据和图表,便于调试。 12. **Spark Job和Stage**:一个Spark作业是由多个Stage组成的,Stage由DAG(有向无环图)决定,每个Stage包含一个或多个Task。理解Stage可以帮助优化任务执行。 通过深入学习PySpark API并熟练运用这些概念和函数,开发者可以有效地处理大数据问题,构建高效的数据处理管道。在实际应用中,还需要关注资源管理、容错机制以及与其他大数据技术的集成,以实现更复杂的解决方案。

pysparkAPI.rar (5个子文件)

pysparkAPI.rar (5个子文件)  pysparkAPI(2).pdf 500KB

pysparkAPI(2).pdf 500KB httpswww.iteblog.comarchivescategoryhbase.txt 41B

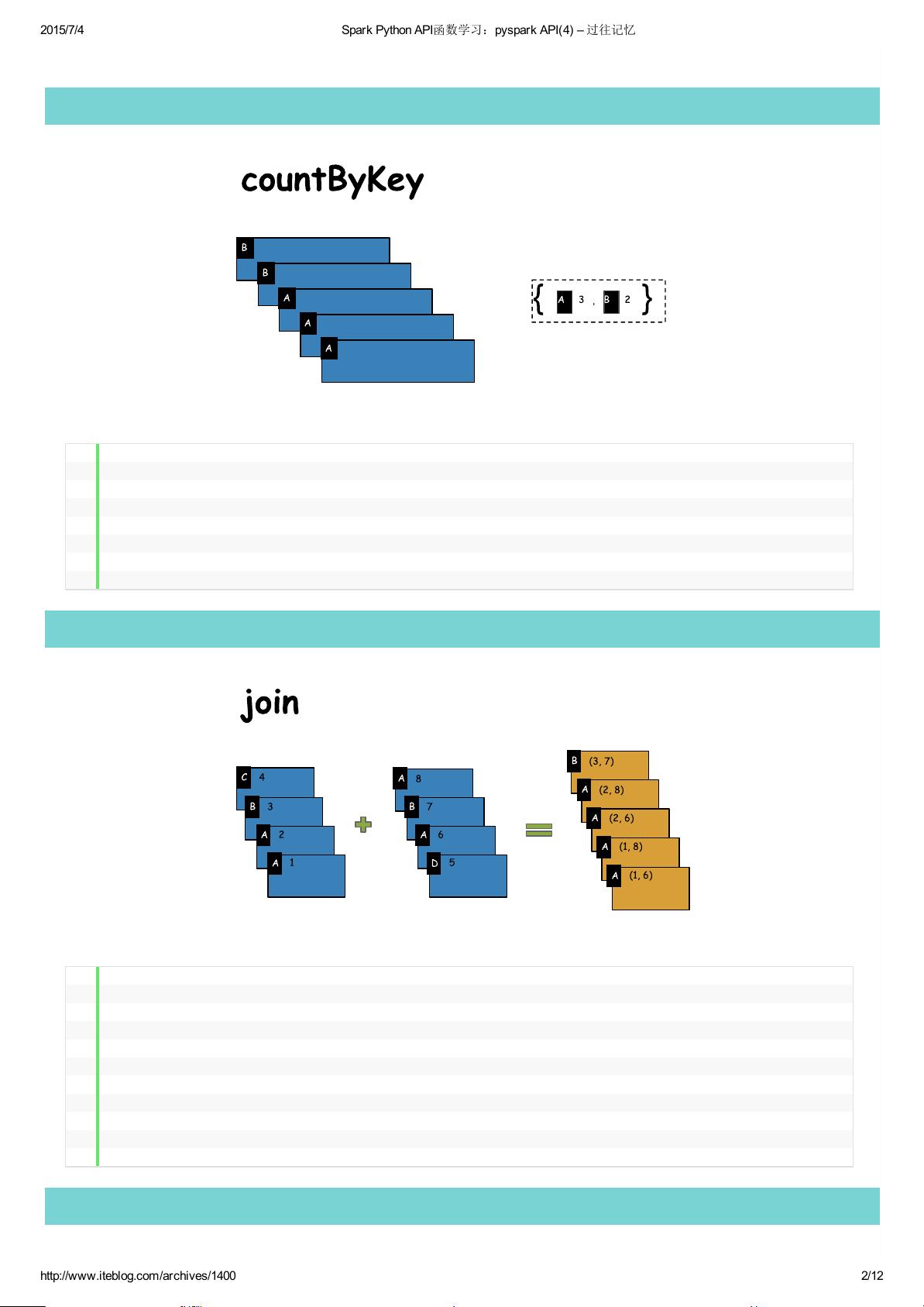

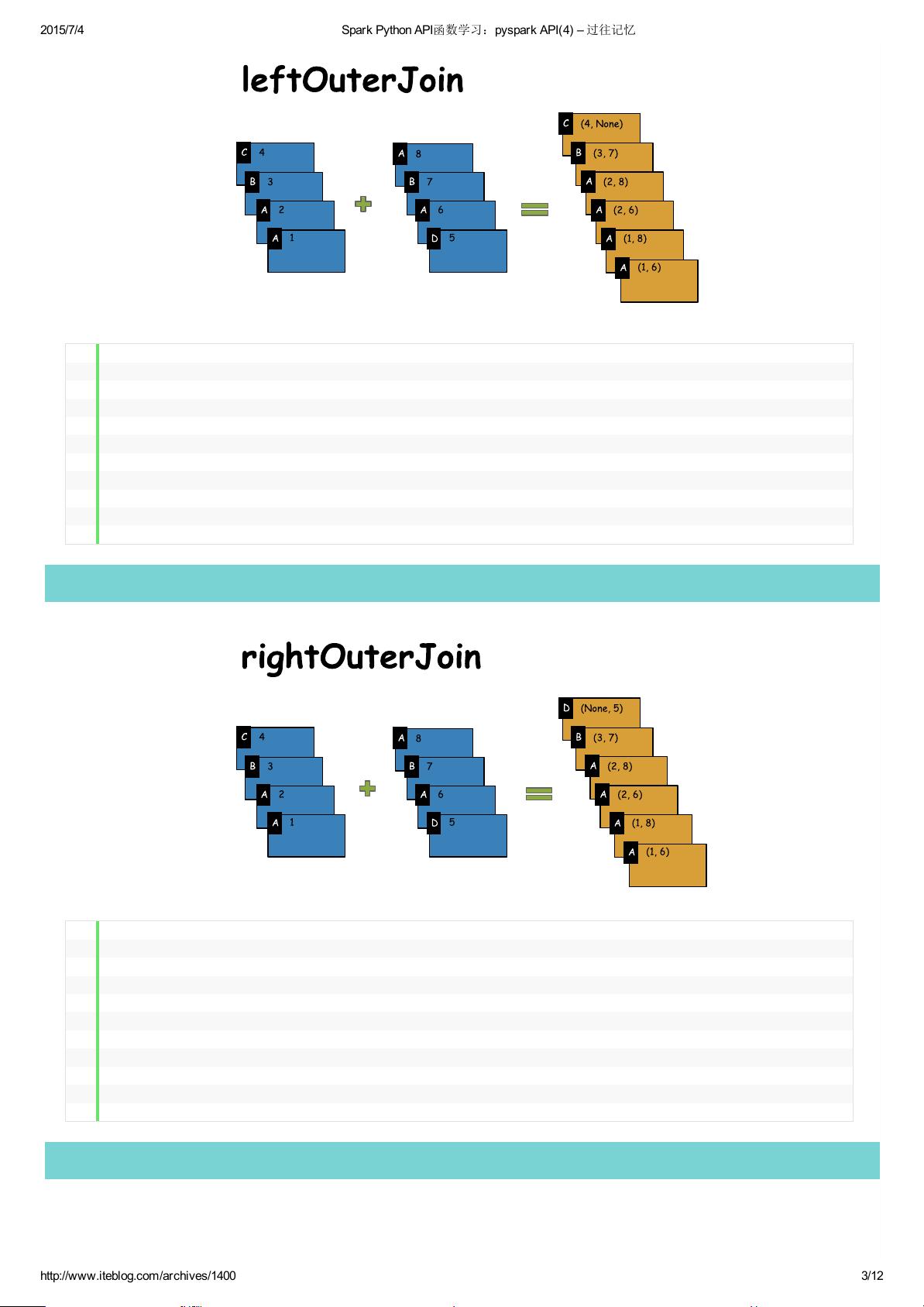

httpswww.iteblog.comarchivescategoryhbase.txt 41B pysparkAPI(1).pdf 558KB

pysparkAPI(1).pdf 558KB Spark Python API函数学习:pyspark API(4) – 过往记忆(1).pdf 774KB

Spark Python API函数学习:pyspark API(4) – 过往记忆(1).pdf 774KB pysparkAPI(3).pdf 508KB

pysparkAPI(3).pdf 508KB- 1

- 粉丝: 699

- 资源: 6

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功