WordCountSort去重复average实例MapR

2.虚拟产品一经售出概不退款(资源遇到问题,请及时私信上传者)

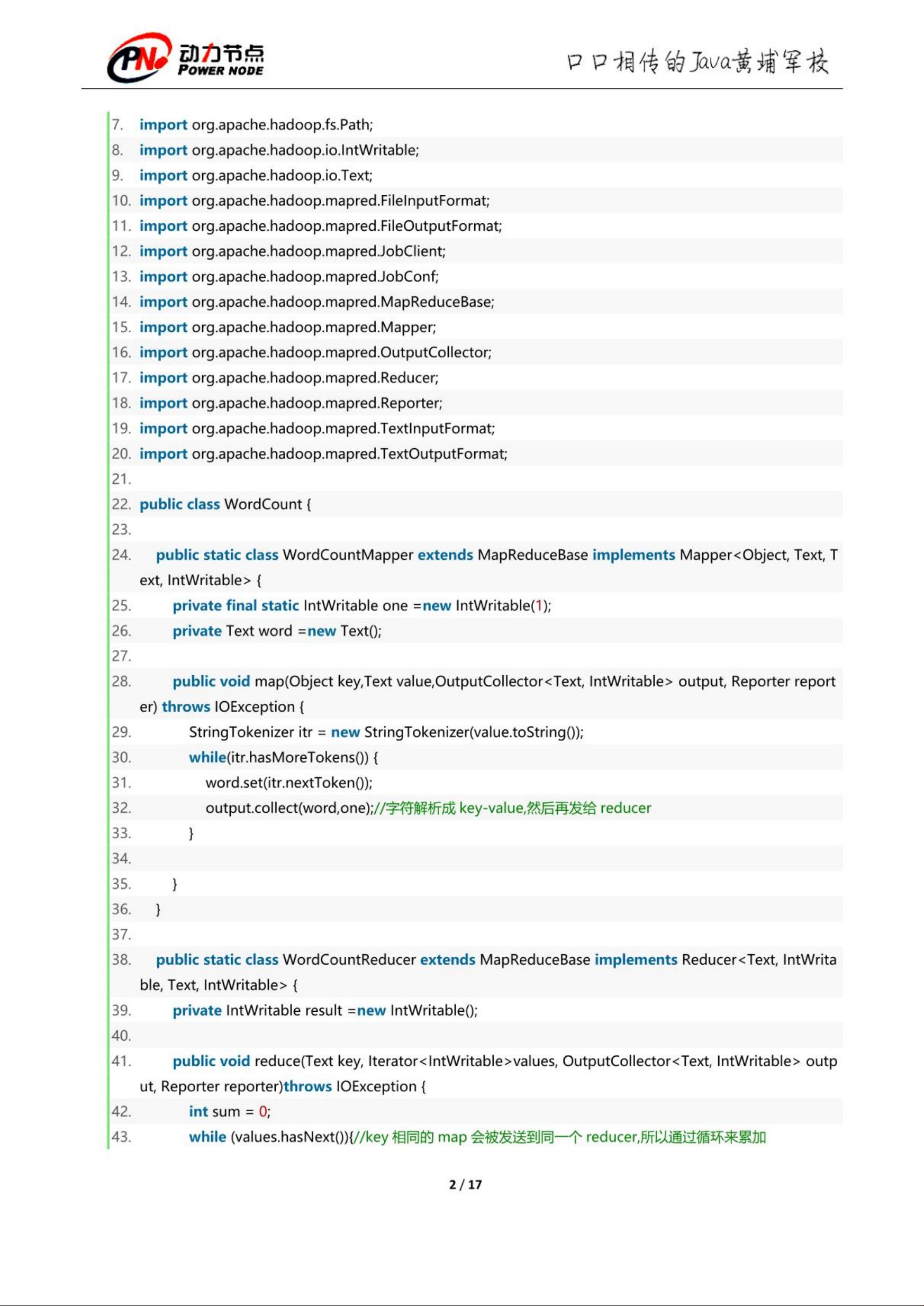

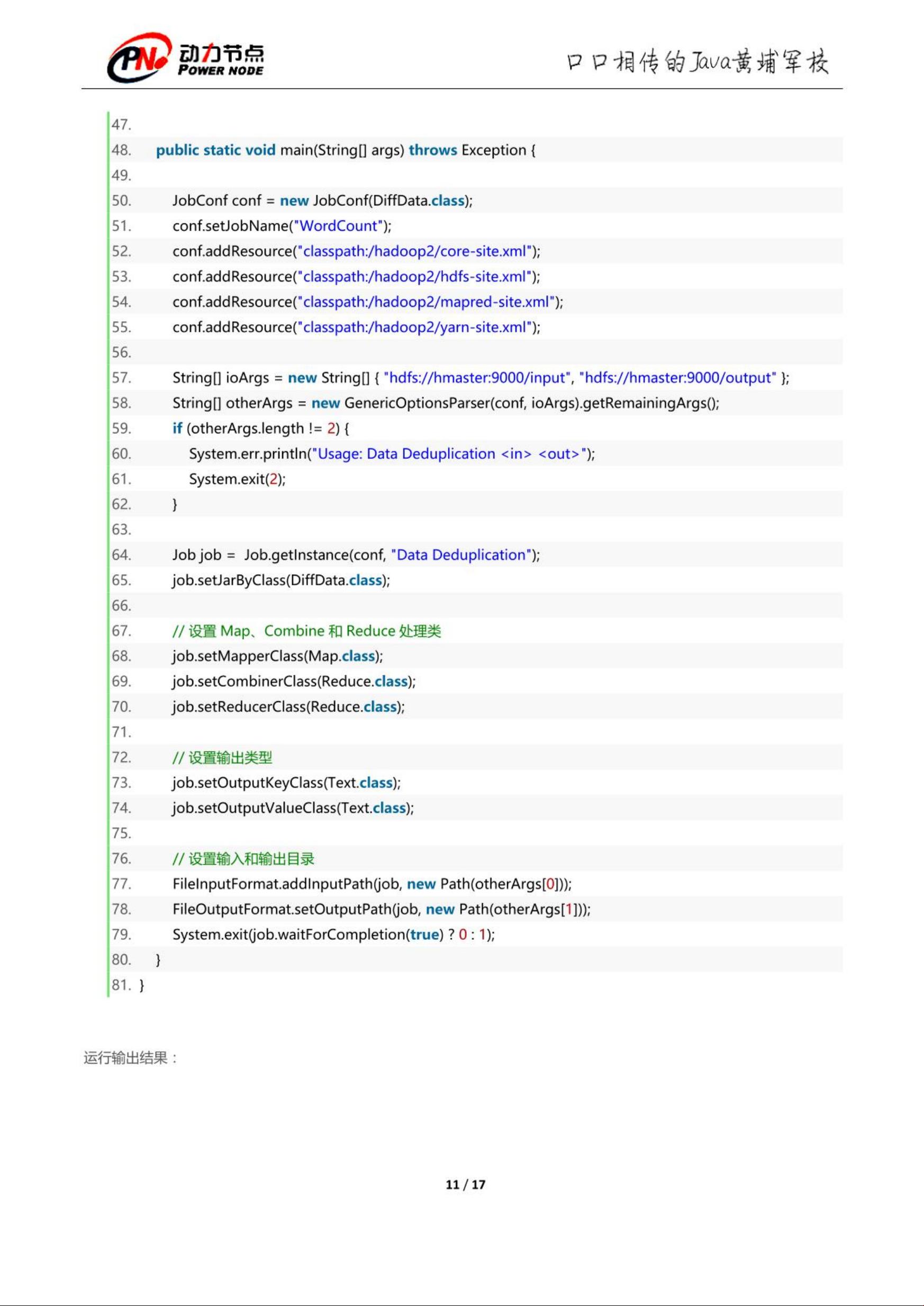

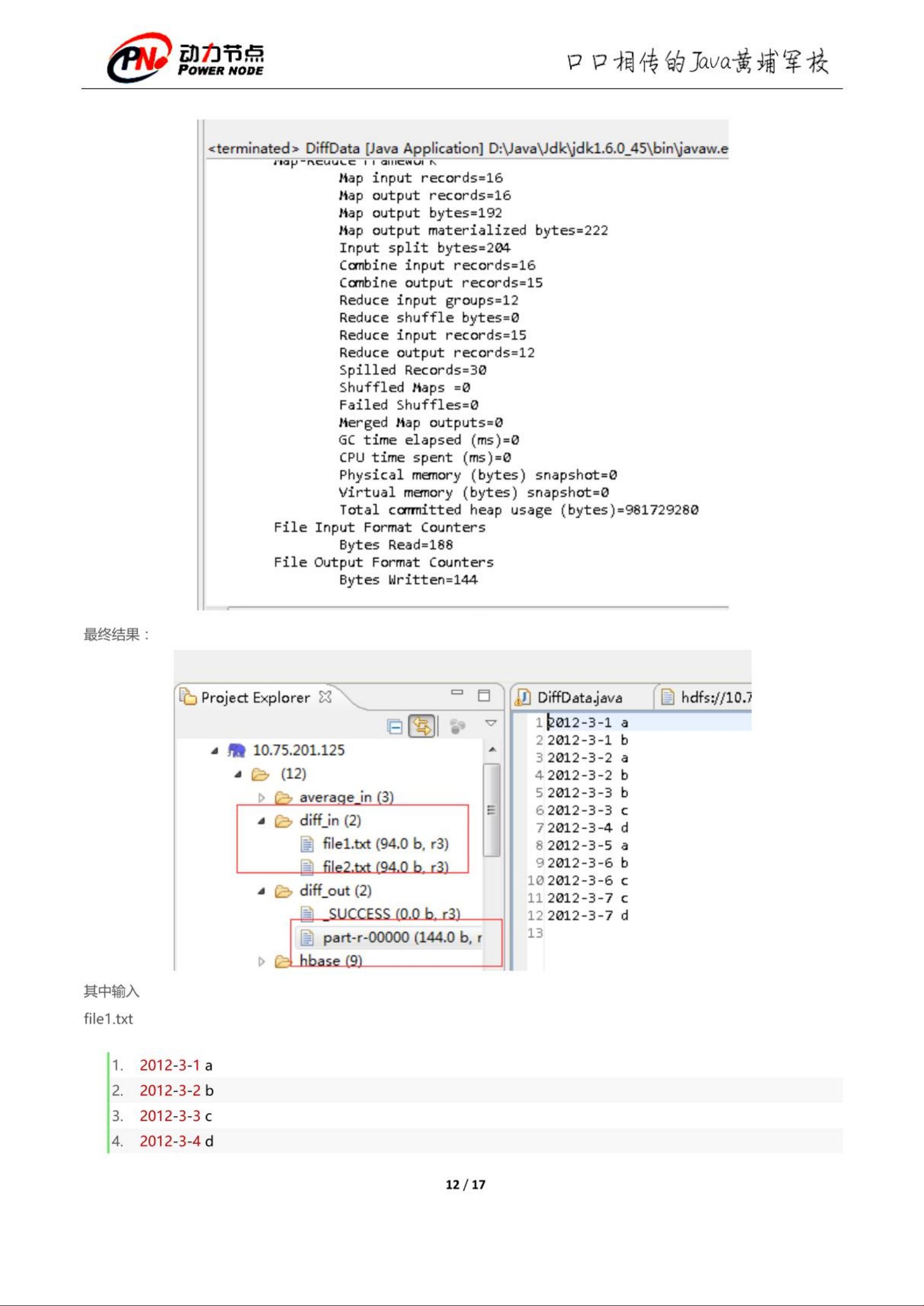

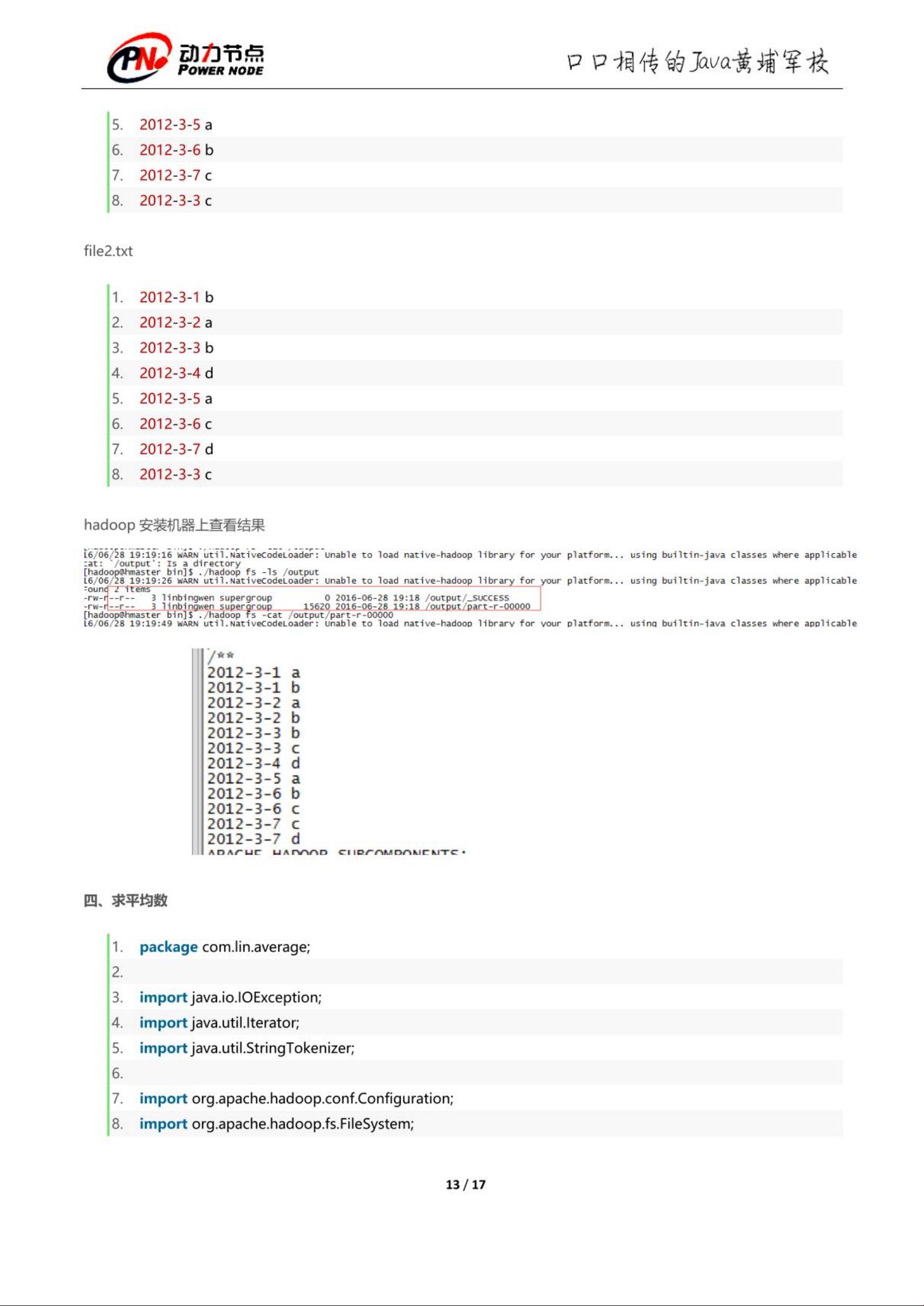

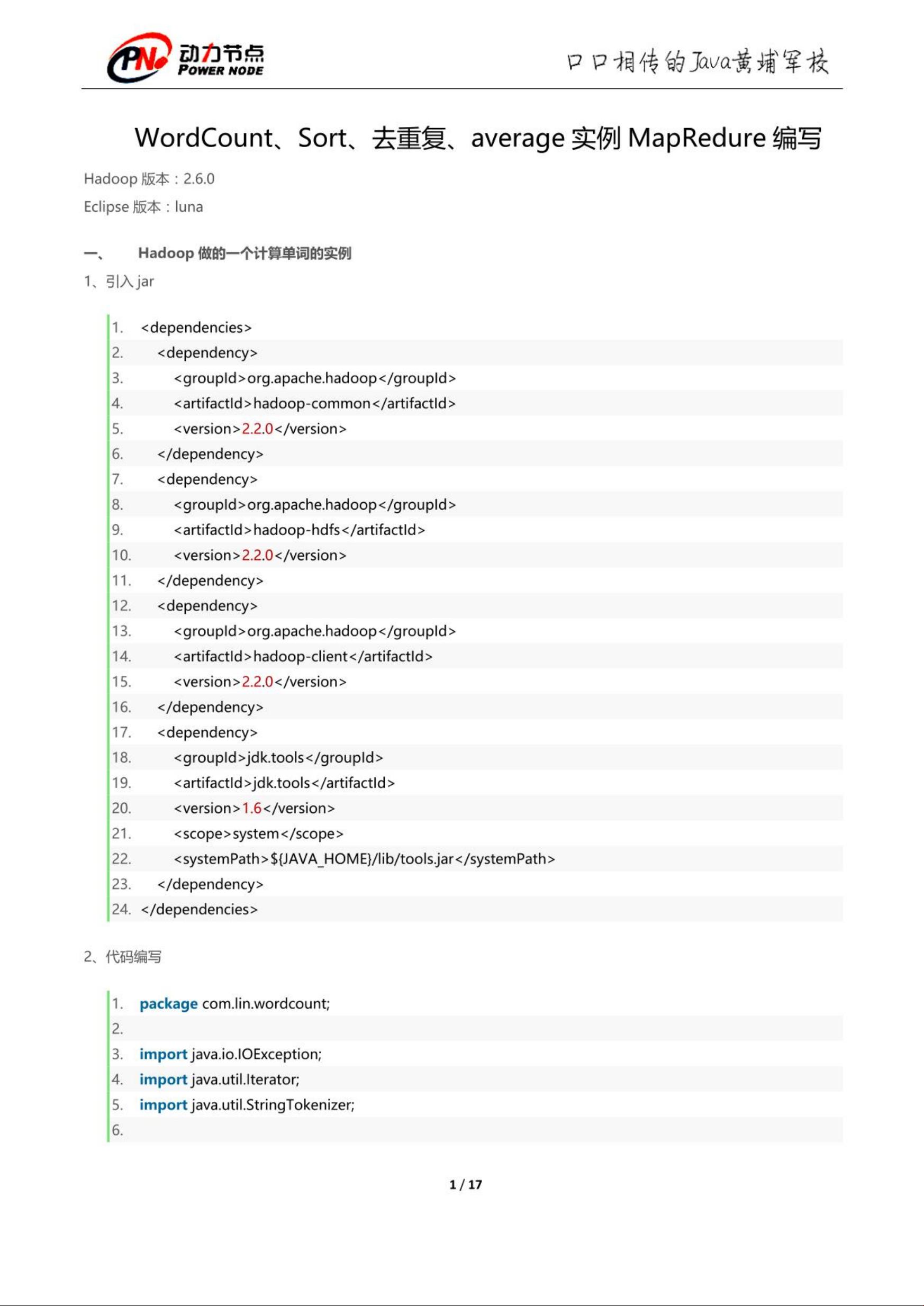

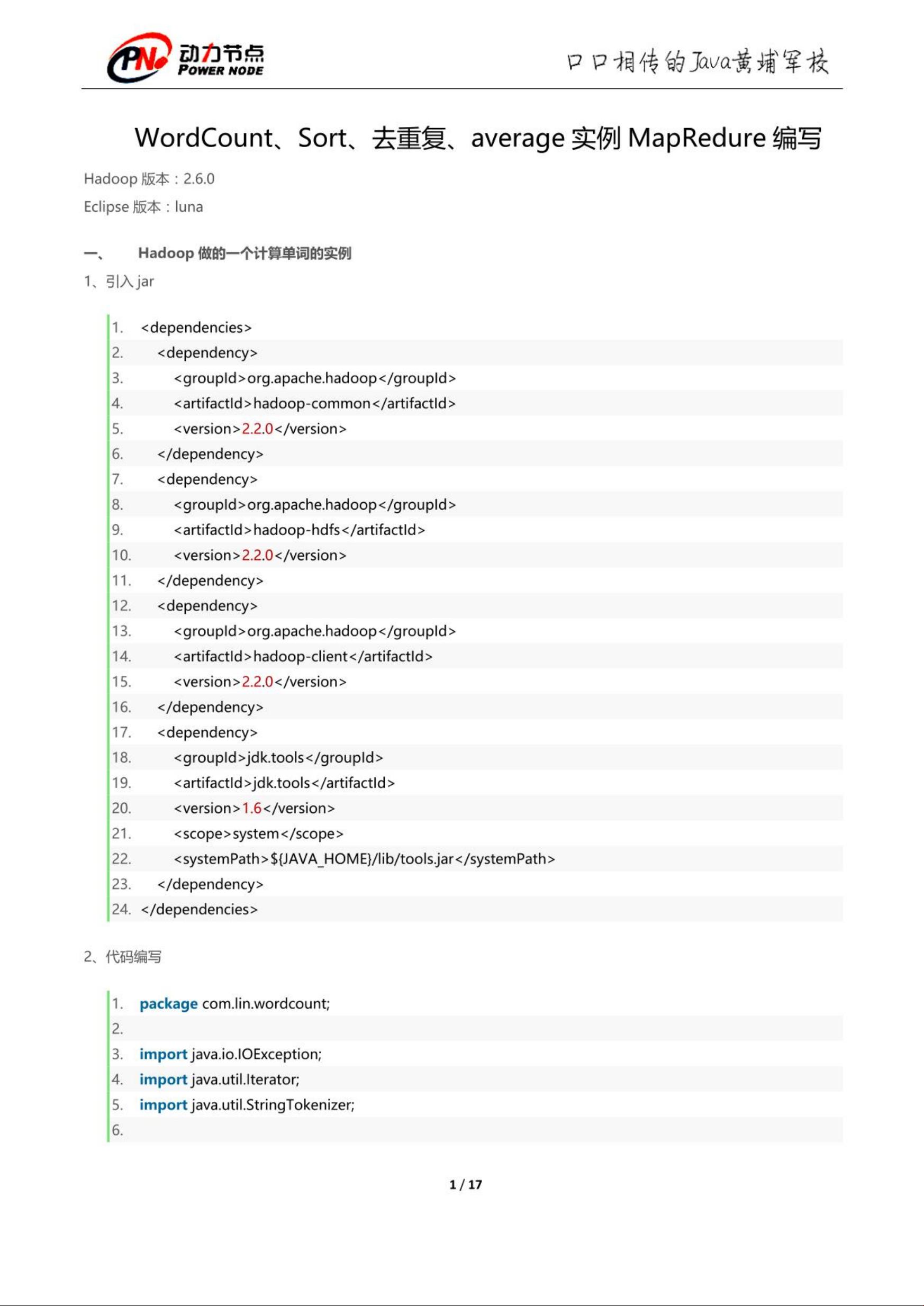

【WordCountSort去重复average实例MapReduce编写】是Hadoop大数据处理中的一个经典案例,它主要涉及了数据处理流程中的三个关键步骤:Map、Shuffle(Sort)和Reduce。在这个实例中,我们的目标是对输入文本中的单词进行计数,同时解决重复数据的问题,并计算平均值。以下是这个实例的具体细节: **Map阶段**: 1. **输入**: 输入数据通常是多行文本,每行包含一些单词。在MapReduce中,每一行被视为一个键值对,键通常为空,值是整行文本。 2. **Mapper**: Mapper是处理输入数据的第一步。在这里,Mapper函数会读取每一行,然后通过分词将单词提取出来。每个单词成为新的键,而对应的值为1,表示该单词出现了一次。 3. **去重**: 在Map阶段,可以实现简单的去重逻辑,例如使用HashSet来存储已经处理过的单词,如果遇到重复的单词,直接忽略。 **Shuffle与Sort阶段**: 1. **分区**: Shuffle阶段会根据键对数据进行分区,确保相同键的记录会被发送到同一个Reducer。 2. **排序**: 对每个分区内的数据,Shuffle阶段还会按照键进行排序,这一步对于WordCount至关重要,因为我们需要聚合相同单词的计数。 **Reduce阶段**: 1. **Reduce函数**: 这是处理数据的最后一步。Reducer接收来自Mapper的键值对,对于每个唯一的单词(键),它会累加所有的值(计数),从而得到单词的总出现次数。 2. **去重**: 如果在Mapper阶段没有完全处理重复,Reducer也可以在此时进一步处理。例如,检查连续的值是否都是1,如果是,说明可能是重复的单词,只保留一次即可。 3. **计算average(平均值)**: 虽然WordCount通常只计算每个单词的数量,但如果我们想要计算平均词频,可以在Reduce阶段累加所有单词的计数,然后除以单词总数。 在这个实例中,`动力节点共17页.pdf.zip`可能是一个包含详细教程或代码示例的压缩文件,可能涵盖了如何实现上述过程的步骤。通常,这种类型的资料会详细解释每个阶段的代码实现,以及如何在MapReduce框架下运行这些代码,如Hadoop或Spark。 WordCountSort去重复average实例是一个用于理解和实践Hadoop MapReduce的好例子,它展示了大数据处理的基本思想,同时也引入了去重和计算平均值等扩展功能。通过学习这个实例,开发者可以更好地掌握分布式计算的基本原理,为处理大规模数据集打下基础。

WordCountSort去重复average实例MapRedure编写__动力节点共17页.pdf.zip (1个子文件)

WordCountSort去重复average实例MapRedure编写__动力节点共17页.pdf.zip (1个子文件)  赚钱项目

赚钱项目  吃不胖.知识分享

吃不胖.知识分享  吃不胖.CSDN知识分享

吃不胖.CSDN知识分享  WordCountSort去重复average实例MapRedure编写__动力节点共17页.pdf 2.47MB

WordCountSort去重复average实例MapRedure编写__动力节点共17页.pdf 2.47MB- 1

- 粉丝: 1w+

- 资源: 4万+

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功