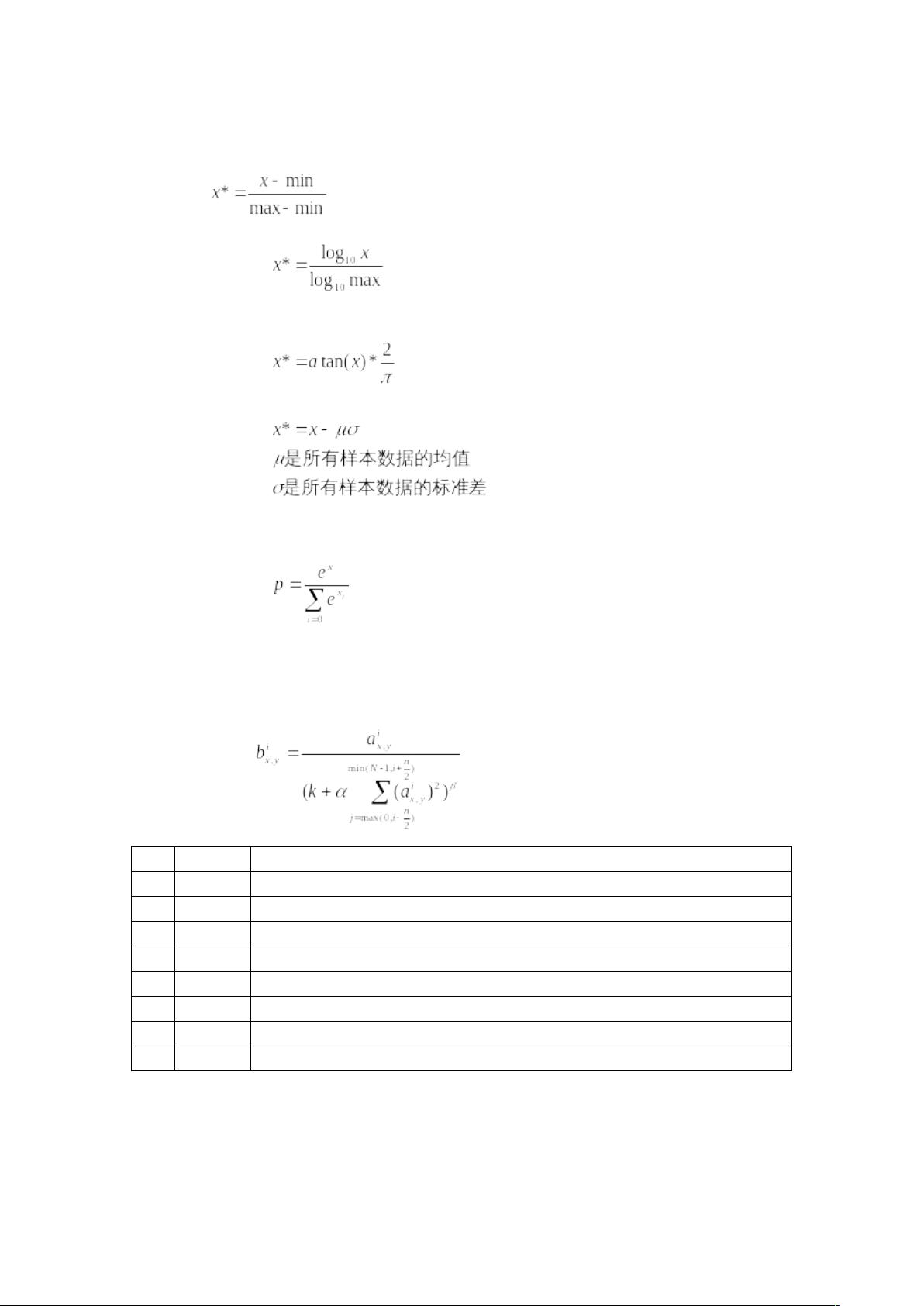

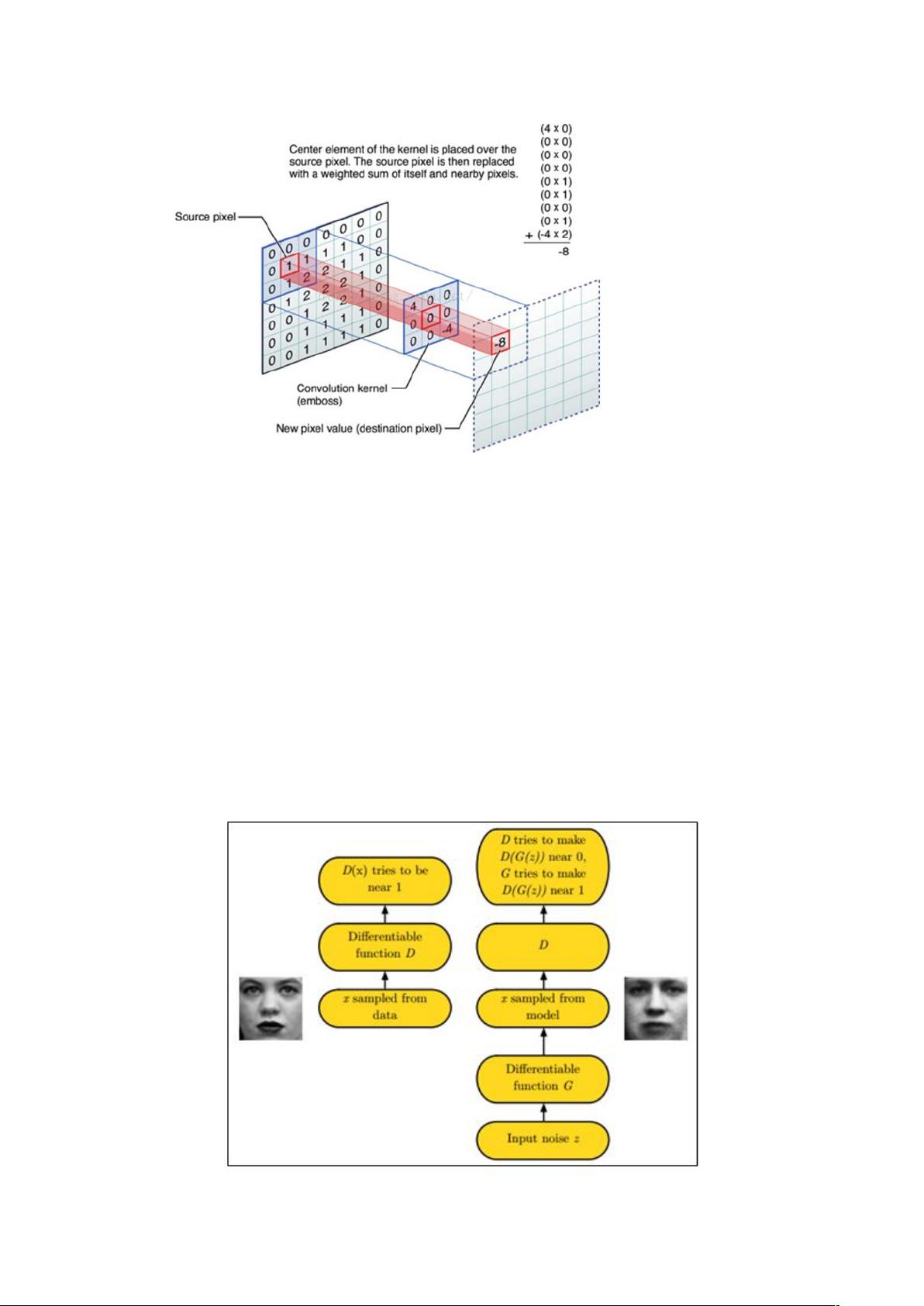

### 深度学习面试知识点总结 #### 梯度下降算法步骤详解 梯度下降算法是深度学习中用于寻找损失函数最小值的一种优化方法。它通过不断调整权重和偏置来减小损失函数的值。 1. **初始化权重和偏差**:在训练开始时,我们通常使用随机值初始化权重和偏差。这一步是为了打破对称性,确保不同的神经元在训练初期能够朝不同的方向发展。 2. **前向传播**:将输入数据传递给神经网络,根据当前的权重和偏差计算输出值。 3. **计算损失**:利用损失函数(如均方误差或交叉熵)计算预测值与实际值之间的差异。 4. **反向传播**:根据损失函数的梯度来更新网络中的权重和偏差,目的是最小化损失函数的值。这一步通常涉及到链式法则来计算梯度。 5. **迭代更新**:重复上述步骤,直到达到预定的停止条件(如最大迭代次数或损失函数的变化小于阈值)。最终得到一组能够较好地拟合训练数据的权重和偏差值。 #### H-K算法与感知器算法对比 H-K算法(霍布森-凯洛格算法)是一种用于求解最小二乘问题的方法。相比于传统的感知器算法,H-K算法有以下优点: 1. **适用于线性可分和非线性可分情况**:H-K算法不仅适用于线性可分的数据集,还可以处理非线性可分的情况。这一点是感知器算法不具备的。 2. **提供最优解**:对于线性可分的情况,H-K算法能够找到一个全局最优解。这意味着它能找到最佳的权重向量,使得模型在训练数据上的表现最优。 3. **非线性可分的识别**:在处理非线性可分数据时,H-K算法能够识别出数据不是线性可分的,并且及时退出迭代过程,避免不必要的计算。 #### 矩阵运算效率分析 在处理大型矩阵乘法时,计算顺序的选择会影响计算效率。给定三个矩阵A(m×n), B(n×p), C(p×q),其中m<n<p<q。 - **计算顺序一**:首先计算\( AB \),然后再计算\((AB)C\)。 - \( AB \)的计算涉及\( m \times n \times p \)次乘法和\( (m \times p) \times (n-1) \)次加法。 - \((AB)C\)的计算涉及\( m \times p \times q \)次乘法和\( (m \times q) \times (p-1) \)次加法。 - 总计算量:\( m \times n \times p + m \times p \times q + m \times p \times (n-1) + m \times q \times (p-1) \)次运算。 - **计算顺序二**:首先计算\( BC \),然后再计算\( A(BC) \)。 - \( BC \)的计算涉及\( n \times p \times q \)次乘法和\( (n \times q) \times (p-1) \)次加法。 - \( A(BC) \)的计算涉及\( m \times n \times q \)次乘法和\( (m \times q) \times (n-1) \)次加法。 - 总计算量:\( n \times p \times q + m \times n \times q + n \times q \times (p-1) + m \times q \times (n-1) \)次运算。 由条件m<n<p<q可知,计算顺序一\((AB)C\)的计算量更少,因此更高效。 #### 大数据处理策略 当数据量过大无法一次性加载到RAM中时,可以采用以下几种策略: 1. **随机梯度下降(SGD)**:每次只选取一个样本进行梯度计算并更新权重。这种方法可以在一定程度上解决内存不足的问题,并且由于每次只处理一小部分数据,训练速度较快。 2. **小批量梯度下降(Mini-batch Gradient Descent)**:介于批量梯度下降和随机梯度下降之间,每次选取一部分样本进行梯度计算。 3. **优化方法**:包括AdaGrad、Momentum、Nesterov Momentum、Adagrad、RMSprop、Adam等。这些方法通过对学习率进行动态调整或引入动量概念来提高训练效率。 - **AdaGrad**:自动调整学习率,对于频繁出现的参数降低学习率,对于不常出现的参数提高学习率。 - **Momentum**:引入动量概念,加速收敛过程。 - **Nesterov Momentum**:进一步改进Momentum算法,提高收敛速度。 - **RMSprop**:解决AdaGrad学习率过快衰减的问题。 - **Adam**:结合了Momentum和RMSprop的优点。 - **L-BFGS**:有限内存版本的Broyden-Fletcher-Goldfarb-Shanno算法,适用于大规模数据集,减少迭代过程中所需的内存开销。 #### 其他相关知识点 - **混沌度(Perplexity)**:用于评估语言模型的性能指标,数值越小表示模型预测效果越好。 - **卷积神经网络(Convolutional Neural Network, CNN)**:用于图像识别等任务,通过卷积层提取特征。 - **反卷积神经网络(Deconvolutional Neural Network, DeCNN)**:用于图像生成等任务,通过反卷积层恢复图像细节。 - **正则化**:通过添加惩罚项来防止模型过拟合,如L1和L2正则化。 - **Dropout**:随机失活神经元,防止过拟合。 - **梯度裁剪**:限制权重的梯度大小,防止梯度爆炸。 - **注意力机制**:使模型关注输入序列中的关键部分,提高模型处理长序列的能力。 - **Encoder-Decoder框架**:用于机器翻译、文本摘要等多种自然语言处理任务。 - **循环神经网络(RNN)**:用于处理序列数据,能够捕捉时间序列中的长期依赖关系。 - **Dropconnect**:不同于Dropout,失活的是神经元间的连接而非神经元本身。 - **内存网络**:在获取特定内存空间时,通常选择读取矢量形式数据,这需要基于内容的地址来完成。 - **归一化**:通过数据预处理将数据转换为统一的尺度,有助于模型训练和提高收敛速度。 - **Min-Max标准化**:将数据缩放到[0,1]区间。 - **Z-Score标准化**:将数据转换为均值为0、标准差为1的标准正态分布。 - **Softmax变换**:用于多分类问题,确保输出的概率和为1。 - **局部响应归一化(LRN)**:增强模型的泛化能力,创建竞争机制。 - **Batch Normalization(BN)**:通过对每一批次数据进行归一化处理,加速训练过程并提高模型性能。 以上总结了深度学习面试中可能遇到的一些重要知识点和技术细节,希望对准备面试的朋友有所帮助。

剩余26页未读,继续阅读

- 粉丝: 55

- 资源: 2

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 人、垃圾、非垃圾检测18-YOLO(v5至v11)、COCO、CreateML、Paligemma、TFRecord、VOC数据集合集.rar

- 金智维RPA server安装包

- 二维码图形检测6-YOLO(v5至v9)、COCO、CreateML、Darknet、Paligemma、TFRecord数据集合集.rar

- Matlab绘制绚丽烟花动画迎新年

- 厚壁圆筒弹性应力计算,过盈干涉量计算

- 网络实践11111111111111

- GO编写图片上传代码.txt

- LabVIEW采集摄像头数据,实现图像数据存储和浏览

- 几种不同方式生成音乐的 Python 源码示例.txt

- python红包打开后出现烟花代码.txt

信息提交成功

信息提交成功