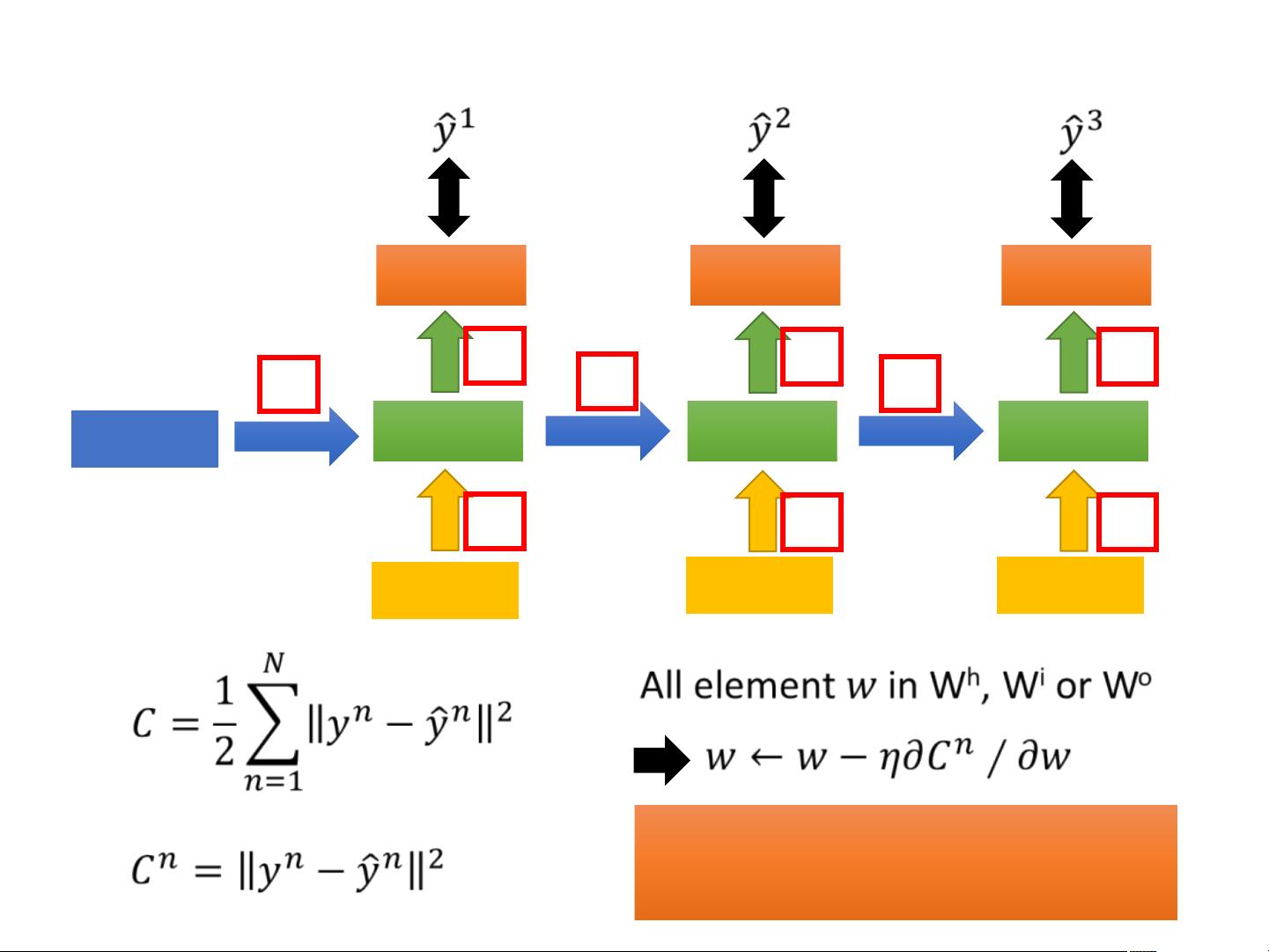

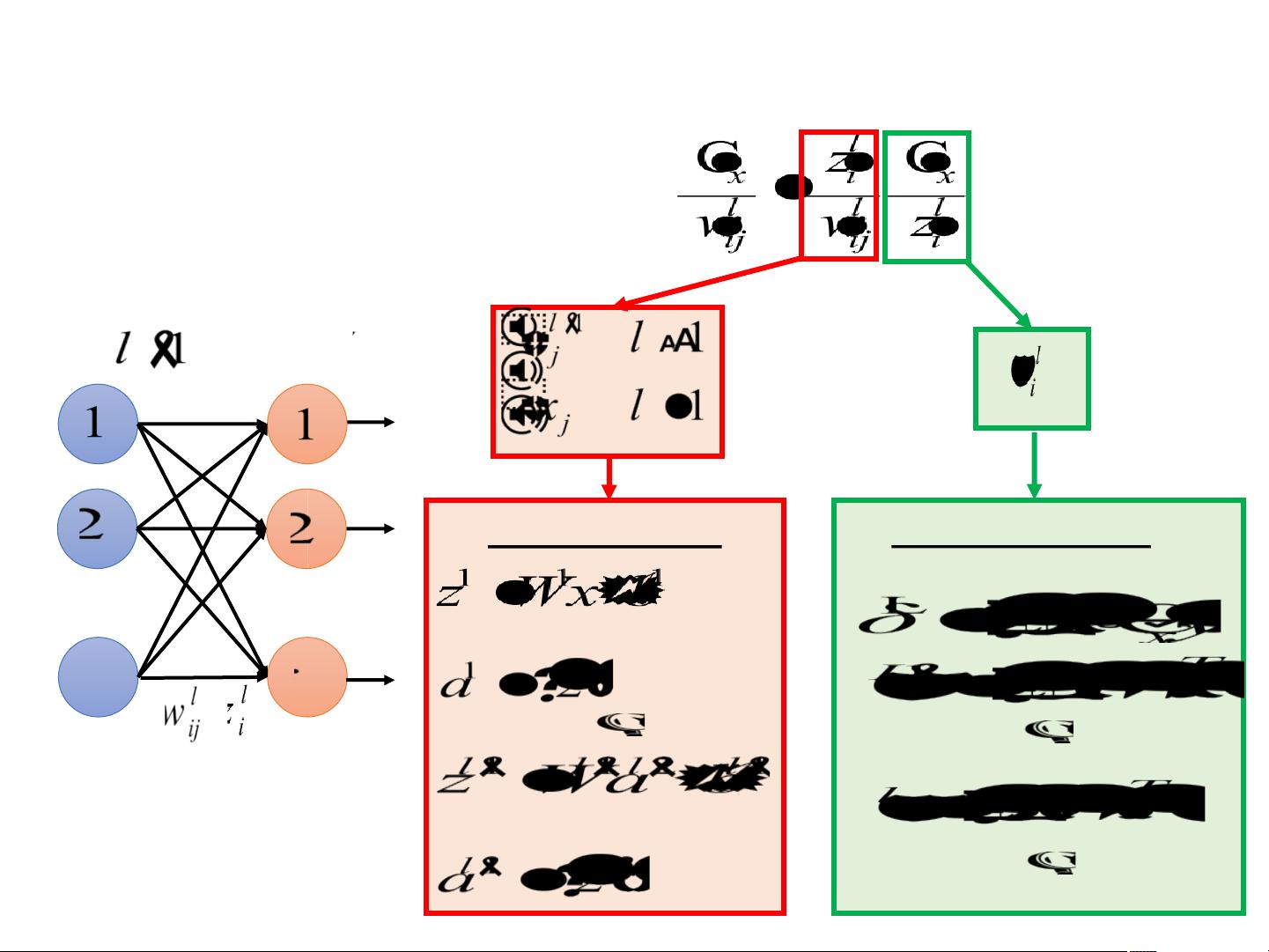

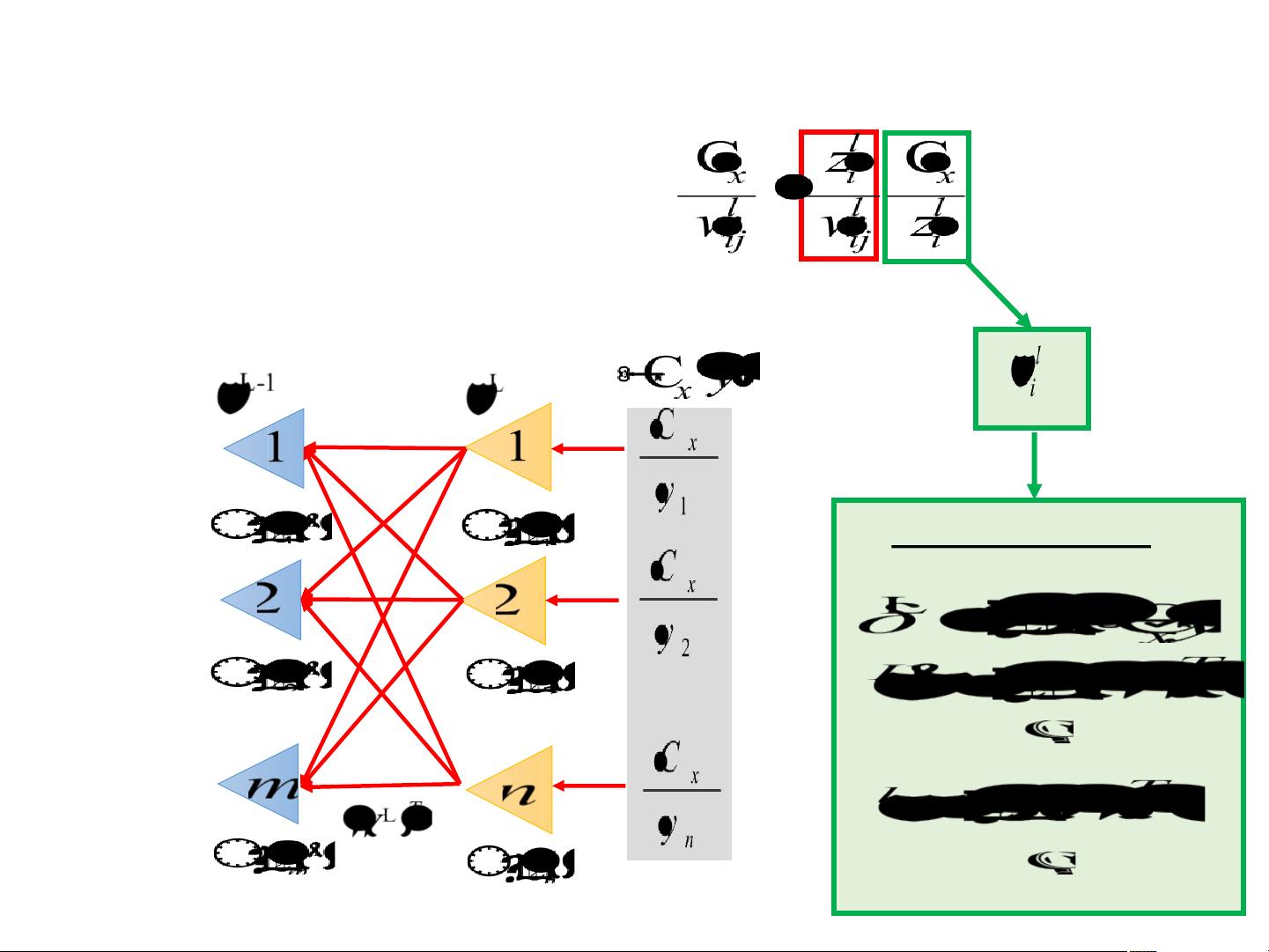

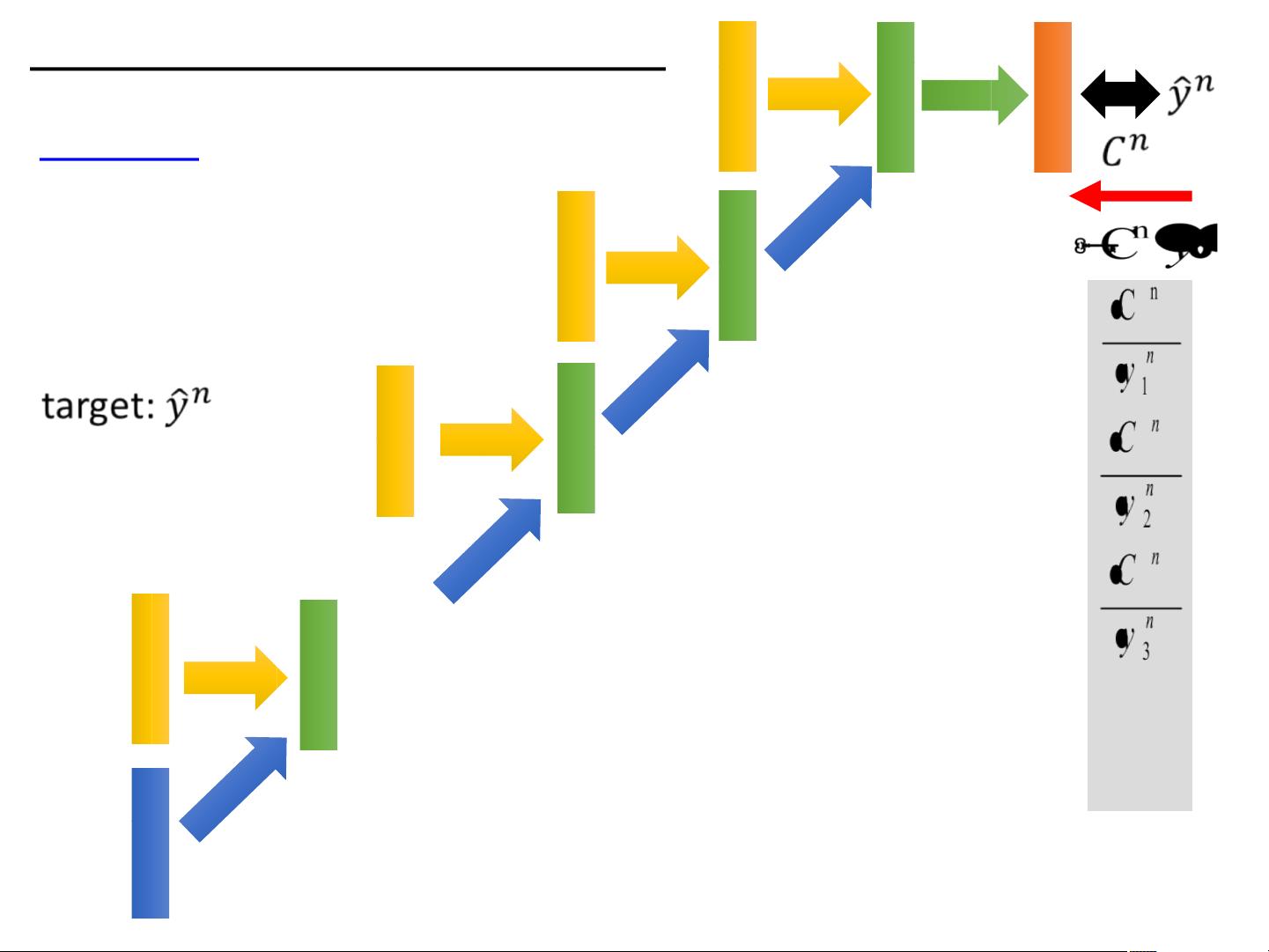

全套资源下载地址:https://download.csdn.net/download/qq_27595745/85101760 【课程列表】 BP神经网络 反向传播神经网络 CNN卷积神经网络 DNN深度学习技巧 Regression回归:案例研究 RNN神经网络训练 SVM支持向量机 VAE无监督学习:生成 半监督学习 分类:概率生成模型 估计量的偏差和方差 结构化线性模式 结构化学习导论 结构化支持向量机SVM 课程介绍 模型集成 集成学习 迁移学习 深度学习 深度学习框架Keras 深入强化学习 神经网络(RNN) 梯度下降 为什么要做深度学习 无监督学习:词嵌入word2vec 无监督学习:深度自动编码器 无监督学习:线性降维 无监督学习:相邻嵌入 序列标记 《机器学习算法教程:深度学习中的RNN神经网络训练》 在现代的机器学习领域,尤其是深度学习中,循环神经网络(Recurrent Neural Networks,RNNs)是一种至关重要的模型,尤其适用于处理序列数据,如自然语言、时间序列等。RNN通过其循环结构能够捕获数据中的长期依赖关系,这在很多任务中是非常关键的。 一、RNN的基本概念 RNN的核心特性是其“记忆”能力,即网络的隐藏状态会根据输入序列动态更新。在训练过程中,RNN的目标是通过反向传播算法(Backpropagation Through Time, BPTT)来调整权重参数,以最小化预测输出与实际输出之间的误差。 二、BPTT算法 BPTT是反向传播算法在时间序列上的扩展,它允许我们在序列的每个时间步长上计算误差,并反向传播这个误差以更新权重。在RNN中,由于权重共享,同一个权重会在不同的时间步上被多次使用,这使得模型能够学习到长期依赖关系。然而,这也带来了梯度消失(Gradient Vanishing)和梯度爆炸(Gradient Exploding)的问题。 三、梯度消失与梯度爆炸 梯度消失指的是在网络深层,由于连续的乘法操作,导致梯度值变得非常小,几乎为零,从而使权重更新变得微乎其微,阻碍了模型的学习。相反,梯度爆炸则是梯度值变得过大,可能导致模型不稳定。这两种情况都对RNN的训练构成挑战。 四、解决方案 为了解决这些问题,研究者提出了多种策略。一种是使用梯度裁剪(Gradient Clipping),通过限制梯度的范围来防止梯度爆炸。此外,门控循环单元(Gated Recurrent Units, GRUs)和长短期记忆网络(Long Short-Term Memory, LSTM)引入了门控机制,有效地解决了梯度消失问题,增强了模型对长期依赖的捕捉能力。 五、其他深度学习算法 除了RNN,本教程还涵盖了其他机器学习和深度学习的基础算法,如BP神经网络、卷积神经网络(CNN)、深度神经网络(DNN)、支持向量机(SVM)、无监督学习、词嵌入(Word2Vec)、深度自动编码器以及模型集成、迁移学习和深度学习框架Keras等。 六、课程资源 为了帮助学习者深入理解这些概念,提供了全套的英文PPT课件,包括28页的内容,详细讲解了各个主题,同时也包含了案例研究和实际应用的示例,这对于学习和掌握这些复杂的算法至关重要。 本教程旨在提供一个全面的深度学习和RNN神经网络训练的学习平台,不仅介绍了理论知识,也提供了实践资源,对于希望在机器学习领域深化学习的人来说,是一份宝贵的参考资料。

剩余27页未读,继续阅读

- 粉丝: 467

- 资源: 7836

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 白色风格的购物商城网站模板下载.zip

- 白色风格的后台管理模板整站下载.zip

- 白色风格的后台管理系统模板下载.rar

- 白色风格的生活社区网站模板下载.zip

- 白色风格的商务网站模板下载.rar

- 白色风格的手机网站模板下载.rar

- 白色风格的直播平台模板整站下载.zip

- 白色大气风格的商务会议活动模板下载.rar

- 白色大气风格的商务网站模板下载.rar

- 白色大气风格的商务团队公司模板下载.zip

- 白色大气风格的商业办公楼租赁模板下载.zip

- 白色大气风格的商业html5模板.zip

- 白色大气风格的商务英语学习培训网站模板.zip

- 白色大气风格的商业公司模板下载.zip

- 白色大气风格的商业代理公司模板下载.zip

- 白色大气风格的商业策划公司模板下载.zip

信息提交成功

信息提交成功