华为mindspore培训资料:3. 卷积神经网络详解.pptx

需积分: 0 125 浏览量

更新于2024-03-24

收藏 3.85MB PPTX 举报

### 华为MindSpore培训资料:卷积神经网络详解

#### 一、卷积神经网络(CNN)基础

**1.1 卷积层原理**

卷积神经网络(Convolutional Neural Networks, CNN)是一种专门用于处理具有网格结构拓扑数据的神经网络,广泛应用于图像识别和分类等任务中。其核心思想是利用图像数据的局部特征和平移不变性,通过卷积操作提取特征。

- **局部特征与平移不变性**:卷积层能够捕捉图像的局部特征,并且这些特征对于图像的平移是不变的。这意味着即使物体在图像中的位置发生了变化,卷积层仍然能够识别它们。

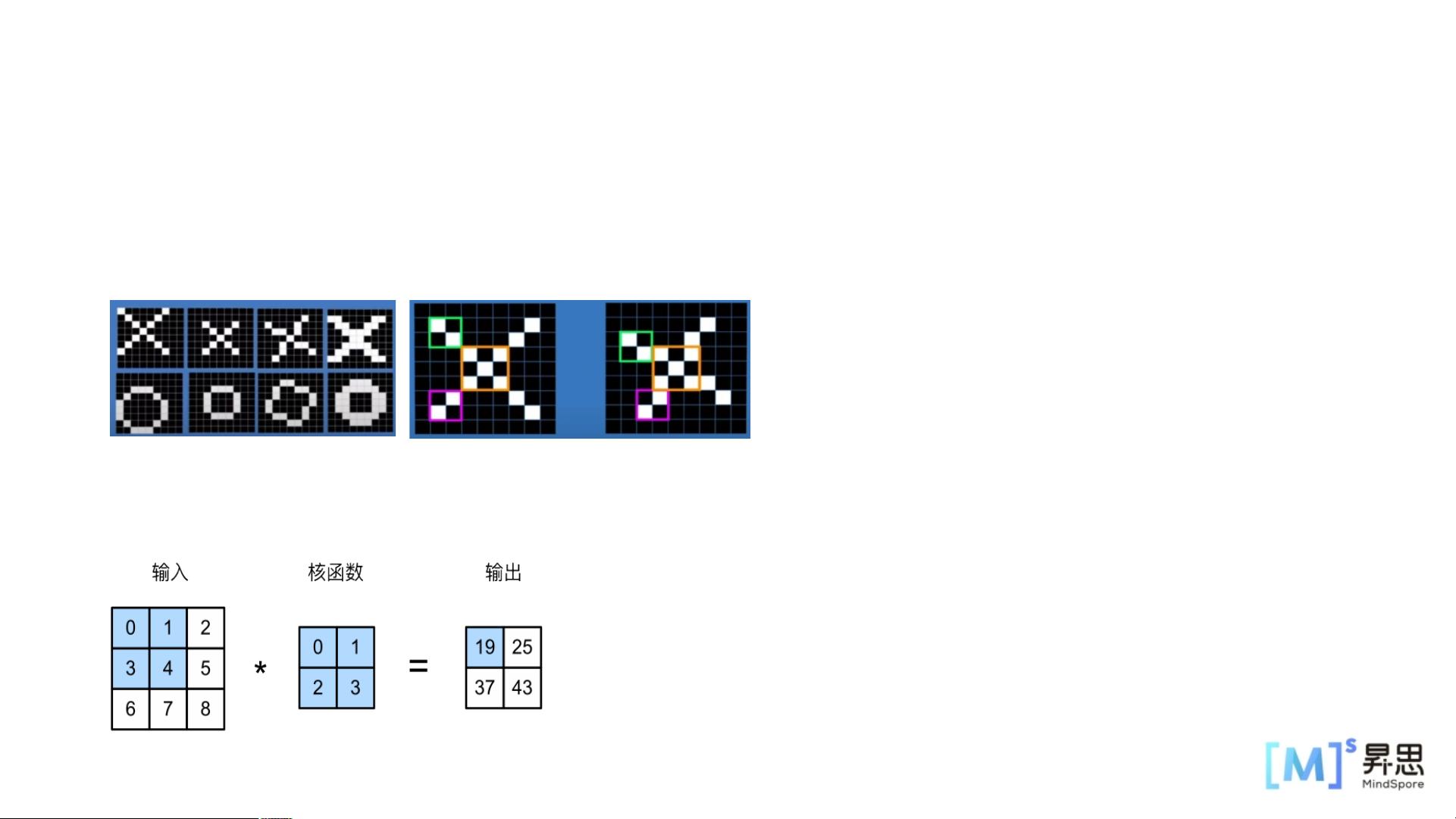

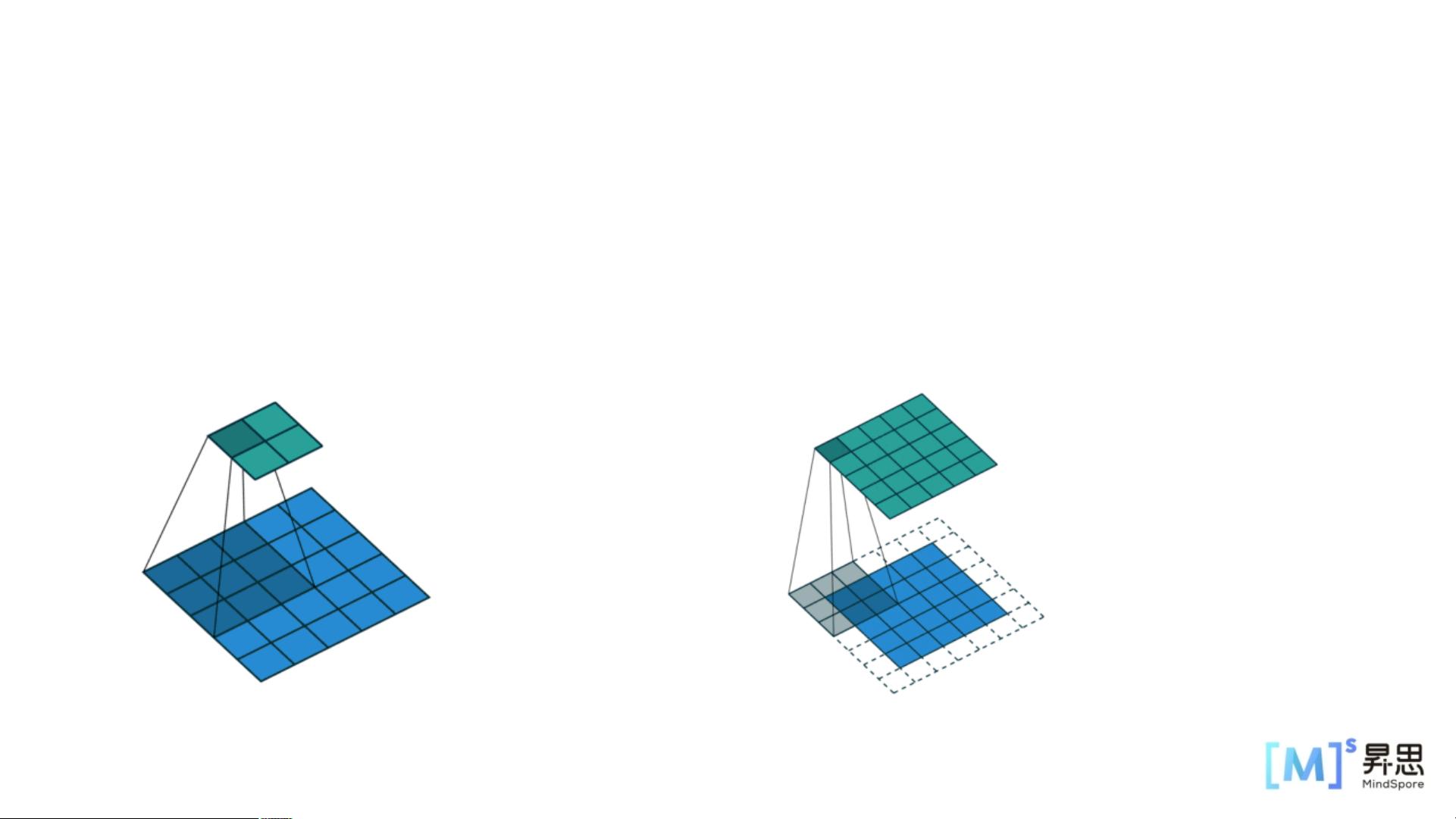

- **卷积运算**:卷积层内部包含多个卷积核,卷积核逐步在二维输入数据上进行“滑动”,每次进行卷积运算,得到输出的feature map上某个像素的数值。具体步骤如下:

- 卷积窗口从输入张量的左上角开始,从左到右、从上到下滑动。

- 当卷积窗口滑动到新一个位置时,包含在该窗口中的部分张量与卷积核张量进行按元素相乘,得到的张量再求和得到一个单一的标量值,由此我们得出了这一位置的输出张量值。

**1.2 卷积核、步长、填充与特征图**

- **卷积核(Kernel)**:组成卷积核的每一个元素都对应一个权重(和偏差),为模型参数;卷积核大小为超参数。

- **步长(Stride)**:卷积核每次移动的距离;超参数。

- **填充(Padding)**:对输入数据进行填充;超参数。

- **特征图(Feature Map)**:卷积层的输入输出数据;输出特征图的大小和卷积核大小、步长、填充有关。

**示例**:输入为5x5,卷积核为3x3,步长为2,无填充,则特征图为2x2。如果步长为1且填充为pw=ph=2,则特征图也是5x5。

#### 二、卷积神经网络实现 - 互相关运算

在卷积层中,互相关运算是用来计算输出feature map的关键步骤。它通过将输入数据与卷积核进行互相关运算来得到输出特征图。具体而言:

- 输入数据与卷积核进行按元素相乘后求和,得到输出特征图的每个元素值。

- 卷积层中的两个被训练的参数是卷积核权重和标量偏置。

#### 三、现代卷积神经网络:ResNet

**3.1 池化层**

- **最大池化**:获取局部信息,更好地保留纹理上的特征。

- **平均池化**:保留整体数据的特征,突出背景的信息。

- **随机池化**:既能最大化保证最大元素的取值,又能确保不过度失真。

**3.2 批量归一化(Batch Normalization)**

批量归一化可以加速模型收敛,减轻网络梯度爆炸或梯度消失的问题。它是基于通道维度对隐藏层的输入/输出数据进行归一化。

**3.3 ResNet网络**

- **退化问题**:随着网络层数变深,网络表现反而不如浅层网络。

- **残差网络结构(Residual Network)**:为了解决退化问题,ResNet提出了一种特殊的残差结构,使网络能够有效叠加更多的层而不会降低性能。

**3.4 构建残差块**

- **building block结构**:基本的残差块结构。

- **bottleneck结构**:更高效的残差块结构,通常用于更深的网络中。

- **实现残差块**:通过定义`make_layer`函数实现残差块的构建,其参数包括上一个残差网络输出的通道数、残差网络输入的通道数、残差网络块堆叠的个数和卷积移动的步幅等。

**3.5 ResNet50架构**

ResNet50是一个50层的深度残差网络,由以下主要部分构成:

- **conv1**:输入图片大小为32x32,输入channel为3。经过卷积核数量为64,卷积核大小为7x7,stride为2的卷积层;然后通过Batch Normalization层;最后通过ReLU激活函数。输出feature map大小为16x16,输出channel为64。

- **conv2_x**:输入feature map大小为16x16,输入channel为64。输出feature map大小为8x8,输出channel为256。

- **conv3_x**:输入feature map大小为8x8,输入channel为256。输出feature map大小为4x4,输出channel为512。

- **conv4_x**:输入feature map大小为4x4,输入channel为512。输出feature map大小为2x2,输出channel为1024。

- **conv5_x**:输入feature map大小为2x2,输入channel为1024。输出feature map大小为1x1,输出channel为2048。

- **average pool & fc**:输入channel为2048,输出channel为分类的类别数。

通过以上介绍可以看出,卷积神经网络尤其是ResNet网络,是图像识别和分类任务中非常强大的工具。通过合理设置卷积核、步长、填充等参数,结合批量归一化、残差块等技术,可以显著提升模型的性能和鲁棒性。

没用的程序员

- 粉丝: 103

- 资源: 23

最新资源

- 遥感图像处理-YOLOv11改进版在卫星船舶识别中的应用.pdf

- 遥感图像分析-YOLOv11在卫星影像中的地物分类与变化检测.pdf

- 遥感影像分析-YOLOv11在卫星图像建筑物提取中的超分辨率应用.pdf

- 遥感影像处理-YOLOv11卫星图像洪涝灾害区域检测算法.pdf

- 遥感影像解译-YOLOv11改进模型在卫星图像建筑物提取中的应用.pdf

- 运动科学突破-YOLOv11运动员姿态跟踪与动作规范性评估系统.pdf

- 运动分析新高度-YOLOv11实时羽毛球轨迹追踪与战术分析系统.pdf

- MATLAB实现ICEEMDAN-IMPA-GRU时间序列预测(含模型描述及示例代码)

- 边缘计算实践-YOLOv11模型量化与树莓派嵌入式部署全攻略(边缘设备).pdf

- 边缘计算实战-YOLOv11模型剪枝与嵌入式设备部署指南.pdf

- Python 实现PSO-GRU(粒子群优化门控循环单元)时间序列预测的详细项目实例(含完整的程序,GUI设计和代码详解)

- 2.4G无线收发模块黄板子.zip

- 《全球网络安全政策法律发展研究报告 (2024) 》

- Python 实现SSA-ELM麻雀算法优化极限学习机时间序列预测的详细项目实例(含完整的程序,GUI设计和代码详解)

- Python 实现GWO-ELM灰狼优化算法优化极限学习机时间序列预测的详细项目实例(含完整的程序,GUI设计和代码详解)

- Python 实现PSO-ELM粒子群优化极限学习机时间序列预测的详细项目实例(含完整的程序,GUI设计和代码详解)