Hadoop源代码分析(完整版).pdf

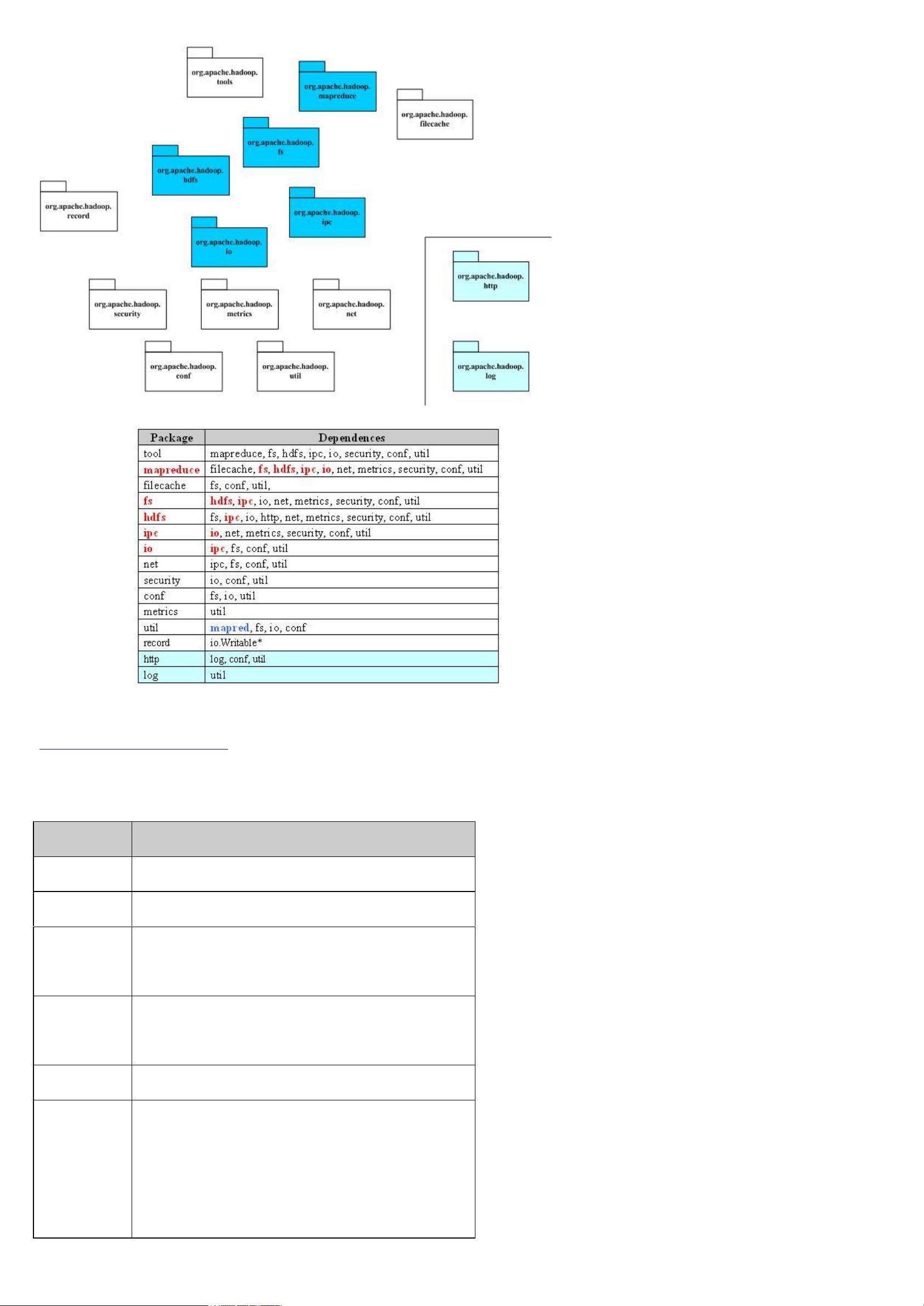

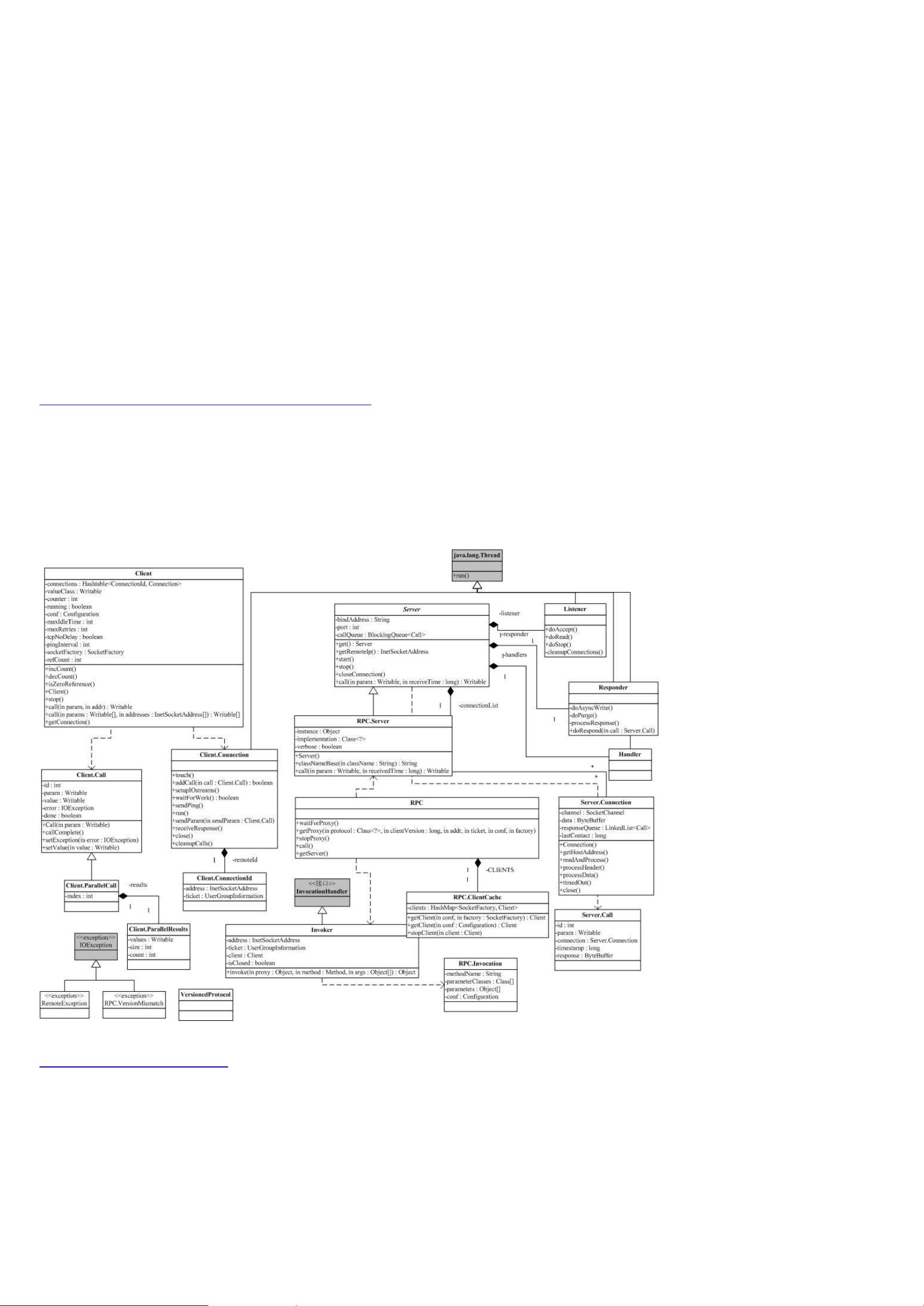

Hadoop是一个非常著名的开源分布式计算框架,它由Apache软件基金会开发。Hadoop的源代码分析涉及对其分布式存储系统HDFS(Hadoop Distributed File System)和分布式计算模型MapReduce的深入理解。 Hadoop的分布式存储系统HDFS是一种高度容错的系统,适合在廉价硬件上运行。它提供了高吞吐量的数据访问,非常适用于大规模数据集的存储。HDFS的设计模仿了Google的GFS(Google File System),其设计原则是把数据分割成块(block),默认大小为64MB或128MB,并跨整个集群进行存储。HDFS有两个主要的组件:NameNode和DataNode。NameNode是中心节点,负责管理文件系统的命名空间和客户端对文件的访问;DataNode则存储实际的数据。 Hadoop的MapReduce是Google的MapReduce模型的开源实现,它是一个编程模型和处理大数据集的相关实现。MapReduce模型包含两个关键步骤:Map(映射)和Reduce(归约)。用户在Map阶段指定一个映射函数处理输入数据,然后在Reduce阶段指定一个归约函数来合并中间结果,从而得到最终结果。Hadoop MapReduce处理的数据通常存储在HDFS上。 Hadoop源代码分析涉及到理解Hadoop架构的多个方面,包括其核心组件和它们之间的依赖关系。例如,Hadoop包之间依赖关系复杂,这是因为HDFS提供了一个分布式文件系统的API,该API需要屏蔽本地文件系统和分布式文件系统之间的差异,甚至可以兼容在线存储系统,比如Amazon S3。这种抽象层次导致了在分布式文件系统的实现中,某些高级功能可能依赖于看似底层的功能,从而形成了类似蜘蛛网型的依赖关系。 Hadoop的关键部分还包括包间的依赖关系。比如,系统配置包conf依赖于文件系统包fs,因为读取配置文件时需要使用文件系统。而文件系统的功能部分又在fs包中进行了抽象。Hadoop的配置参数(conf)是系统的核心,用于管理Hadoop集群的配置。 Hadoop提供了命令行工具(PackageDependencies tool),例如DistCp和archivemapreduce。另外,Hadoop中HDFS的文件系统抽象fs提供了一个统一的文件访问接口,可以支持多种文件系统的实现。Hadoop的IPC(进程间通信)实现是简单的,并依赖于io提供的编解码功能。由于Hadoop的MapReduce和HDFS都有通信的需求,因此需要对通信对象进行序列化。Hadoop没有采用Java的序列化机制,而是引入了自己的Writable接口,其中定义了大量可序列化的对象,以方便在网络上传输。 此外,Hadoop提供了各种数据编解码器,包括基于DDL(数据描述语言)自动生成的编解码函数,目前支持C++和Java两种语言。Hadoop使用了Jetty框架提供的HTTPServlet来支持HTTP服务,使得用户可以通过浏览器观察文件系统状态和日志。 Hadoop的包功能分析还包括记录(record)的自动生成机制,它们根据DDL来创建相应的编解码函数。对于网络功能,Hadoop封装了一些基本的网络操作,比如DNS和socket。安全性方面,Hadoop提供了对用户和用户组信息的安全管理(security)。Hadoop的配置(conf)和性能统计(metrics)收集系统属于网络管理的范畴,它们负责收集系统的配置参数和统计信息。util工具类提供了通用的辅助功能。 源代码中提到的MyWritable类是Hadoop中Writable接口的一个典型实现,它演示了如何通过实现Writable接口中的write和readFields方法来定义可序列化的对象。这个类能够被Hadoop的IPC机制用于序列化和反序列化,以在网络中传输。 在阅读和分析Hadoop的源代码时,了解这些关键组件和它们的交互方式对于深入理解Hadoop的工作机制至关重要。Hadoop的设计和实现借鉴了许多Google的技术和架构,它目前是许多大数据处理应用的基础。随着Hadoop生态的不断扩展,越来越多的开源项目也基于其思想进行开发,例如Facebook的Hive。

剩余108页未读,继续阅读

- 粉丝: 0

- 资源: 10

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功