Hadoop云计算平台搭建最详细过程.doc

2.虚拟产品一经售出概不退款(资源遇到问题,请及时私信上传者)

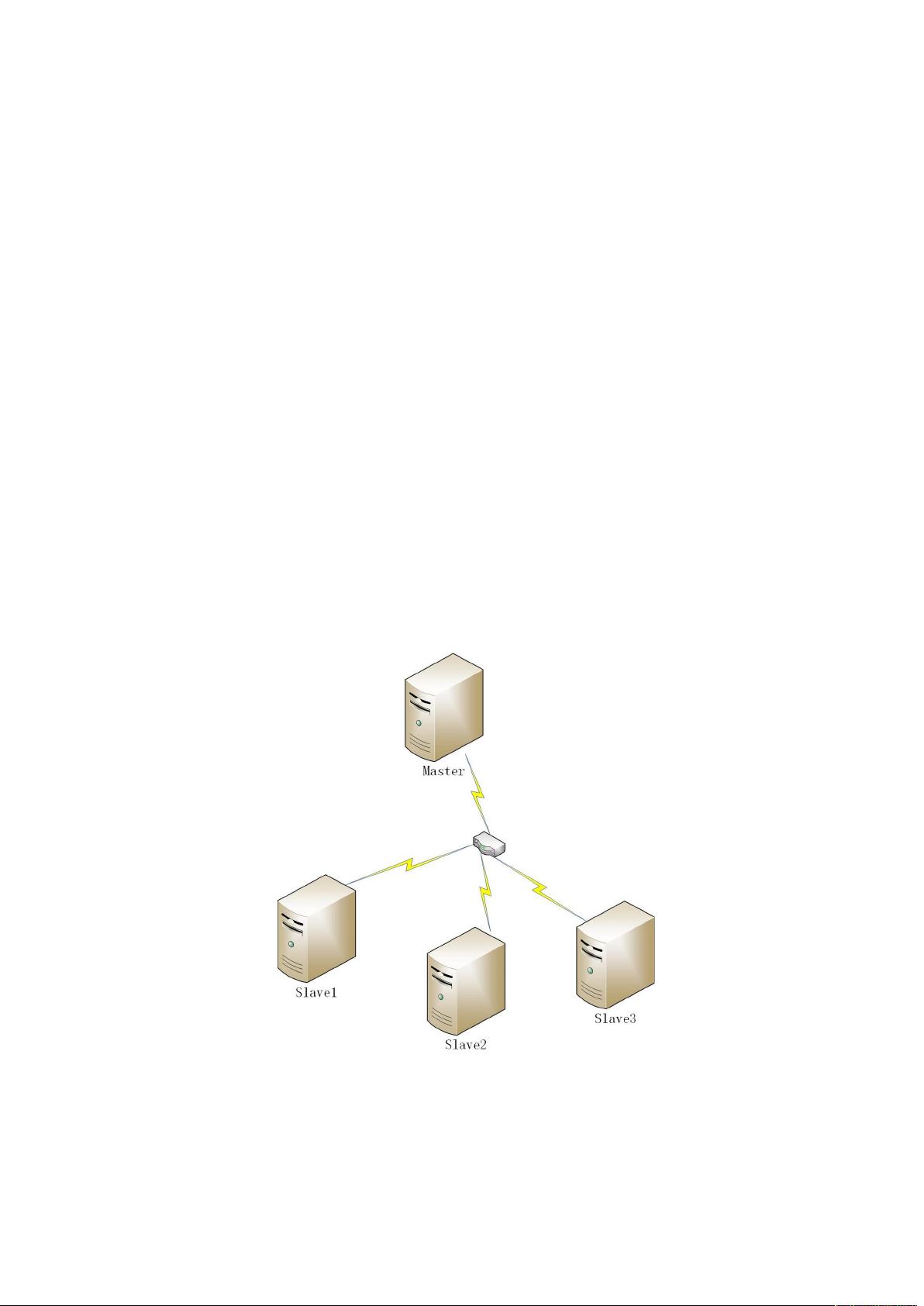

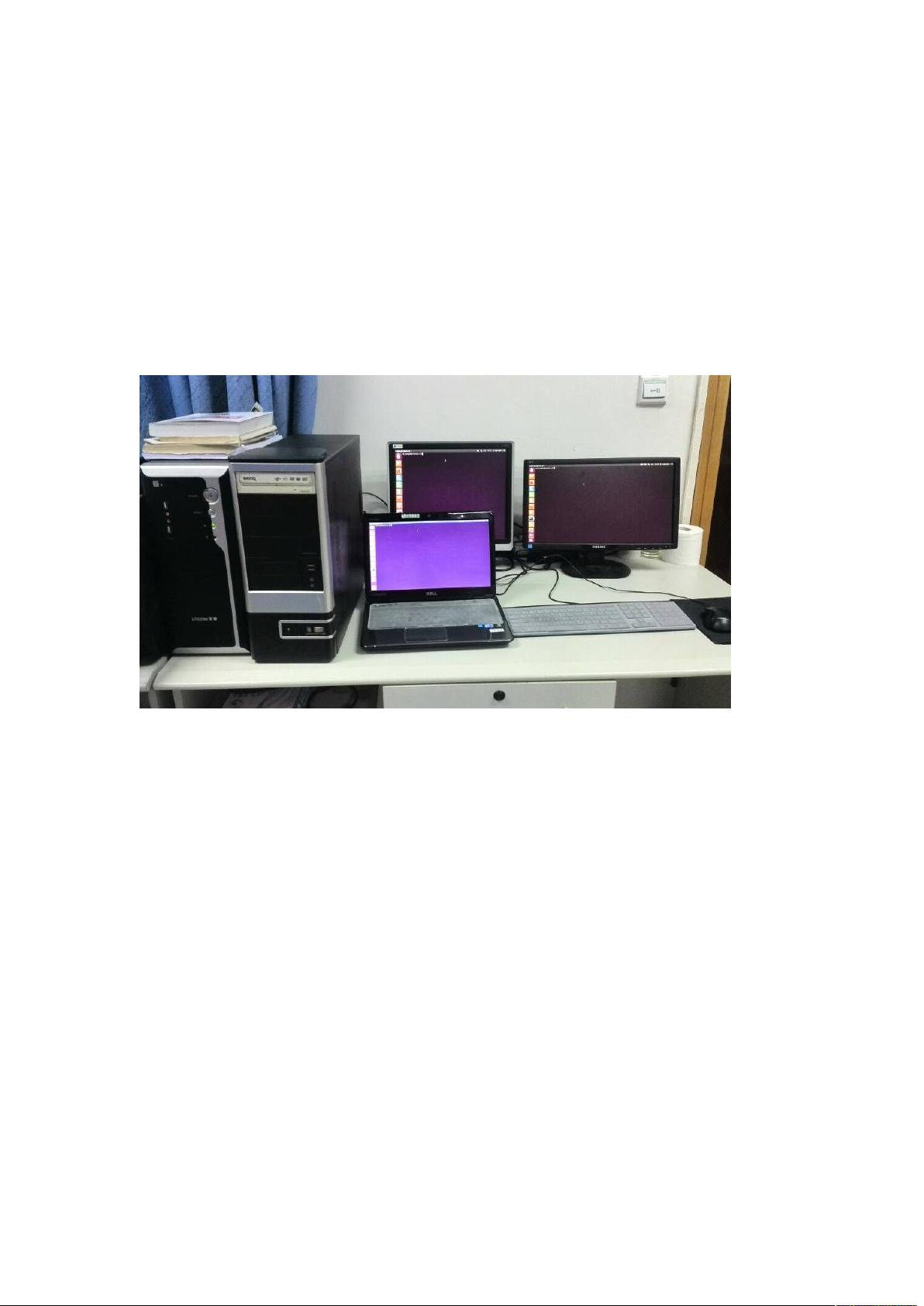

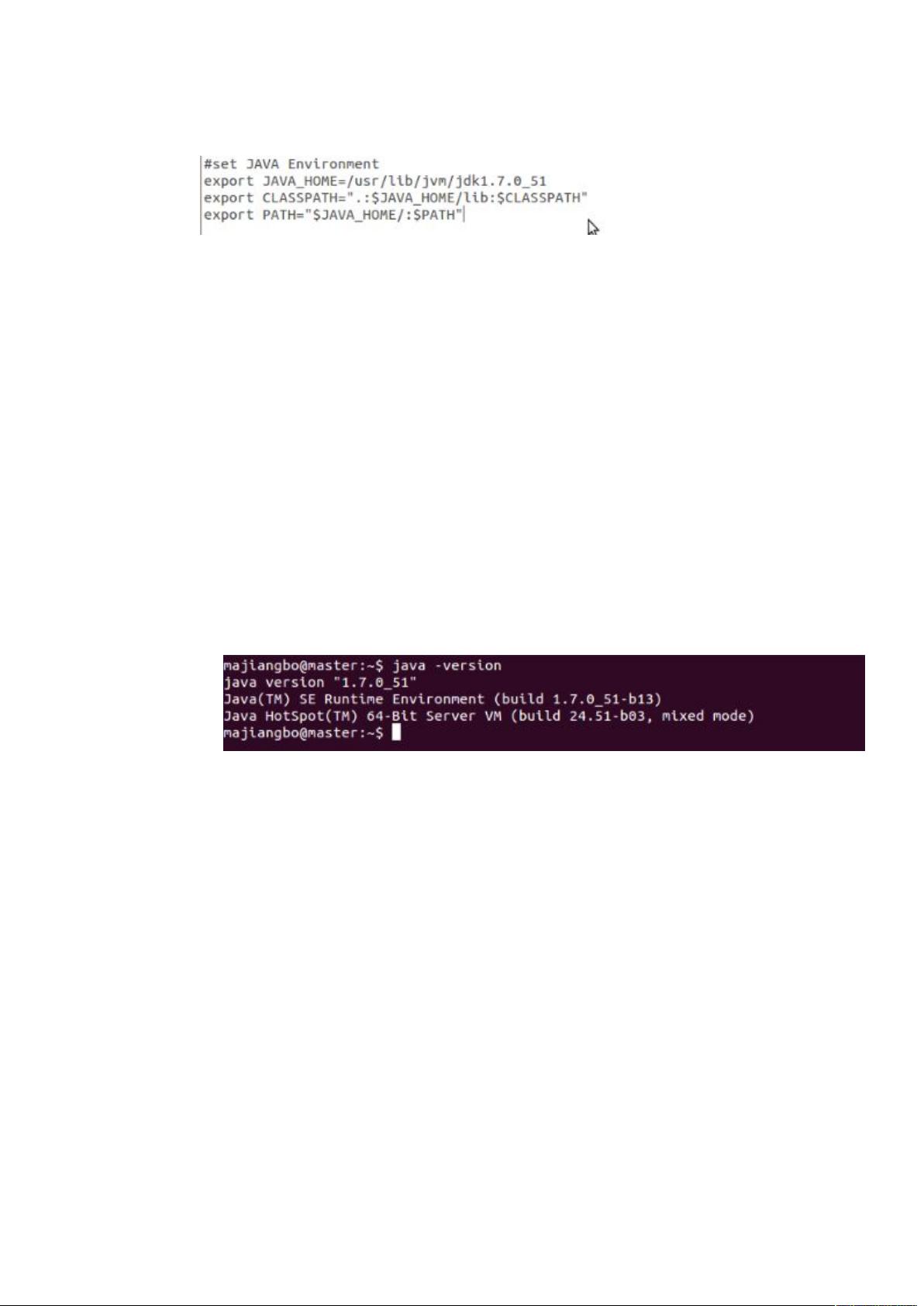

在搭建Hadoop云计算平台的过程中,我们需要了解和掌握一系列的关键知识点,包括Hadoop的架构、组件、安装环境以及各个组件的功能。下面将详细阐述这些内容。 Hadoop是一个开源的分布式计算框架,它允许在廉价硬件上处理大量数据。Hadoop的核心由两个主要部分组成:HDFS(Hadoop Distributed File System)和MapReduce。HDFS提供了高容错性的分布式存储,而MapReduce则负责数据处理,通过分发、并行化工作负载来提高计算效率。 在搭建Hadoop平台时,我们通常会涉及到多个组件,如Hbase、Pig、Hive、Zookeeper、Ganglia、Chukwa和Eclipse等。Hbase是一个基于Hadoop的数据存储系统,支持实时查询,适用于大数据存储。Pig和Hive是两种数据分析工具,Pig提供了一种高级语言(Pig Latin)来编写MapReduce任务,而Hive则提供了SQL-like的语言(HQL)进行数据查询和分析。Zookeeper是一个协调服务,用于管理分布式系统的配置信息和命名服务。Ganglia是一个分布式监控系统,用于收集、聚合和展示集群的性能数据。Chukwa则是Hadoop的大型数据收集系统,用于日志管理和故障排查。Eclipse则配合Hadoop-eclipse-plugin插件,为开发者提供Hadoop应用的开发环境。 安装环境的选择至关重要,Hadoop官方推荐在Linux环境下运行,尤其是64位的Ubuntu 12.04.4,因为这个版本已经被广泛验证并且稳定。硬件需求包括足够的CPU、内存和硬盘空间,具体配置可以根据实际需求调整。在多台机器上构建集群时,至少需要一台Master节点和若干台Slave节点,Master节点通常承担NameNode、JobTracker等职责,而Slave节点则作为DataNode和TaskTracker运行。 安装步骤大致分为以下几个阶段: 1. **环境准备**:确保所有机器都安装了64位的Ubuntu 12.04.4,并且配置好SSH免密码登录,方便集群间的通信。 2. **安装JDK**:Hadoop依赖Java环境,需要安装JDK 7或以上版本。 3. **下载和解压Hadoop**:将Hadoop的tar.gz文件解压到指定目录,并配置环境变量。 4. **配置Hadoop**:修改`hadoop-env.sh`、`core-site.xml`、`hdfs-site.xml`、`mapred-site.xml`等配置文件,设定集群的网络拓扑、数据存储策略、JobTracker等参数。 5. **格式化NameNode**:首次启动Hadoop前,需要对NameNode进行格式化,初始化HDFS。 6. **启动Hadoop**:启动NameNode、DataNode、SecondaryNameNode、TaskTracker等相关进程。 7. **安装其他组件**:如Hbase、Pig、Hive等,它们各自有自己的配置文件需要修改以适应Hadoop集群。 8. **配置SSH免密码登录**:确保所有节点之间可以通过SSH无密码访问,简化集群操作。 9. **验证安装**:通过运行简单的MapReduce任务或HDFS操作来验证Hadoop集群是否正常工作。 在Windows环境下,虽然可以使用Cygwin模拟Linux环境,但由于分布式操作未经过充分测试,可能会遇到更多问题,因此推荐在Linux上进行搭建。 搭建Hadoop云计算平台是一个涉及多个层面和技术的复杂过程,需要对分布式系统、网络配置、脚本编写以及Java编程有一定的了解。通过这个过程,我们可以深入理解Hadoop的运作机制,并为后续的大数据处理和分析打下坚实的基础。

剩余22页未读,继续阅读

- 粉丝: 10

- 资源: 20万+

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功