回归分析是一种统计学方法,用于探索变量间的关系,并建立数学模型来预测或解释这些关系。在标题和描述中反复提及“回归分析pdf”,这可能是指一份详细的文档,涵盖了回归分析的理论、应用以及实例解析。回归分析的核心在于,通过一个或多个自变量(独立变量)来研究它们对因变量(依赖变量)的影响。

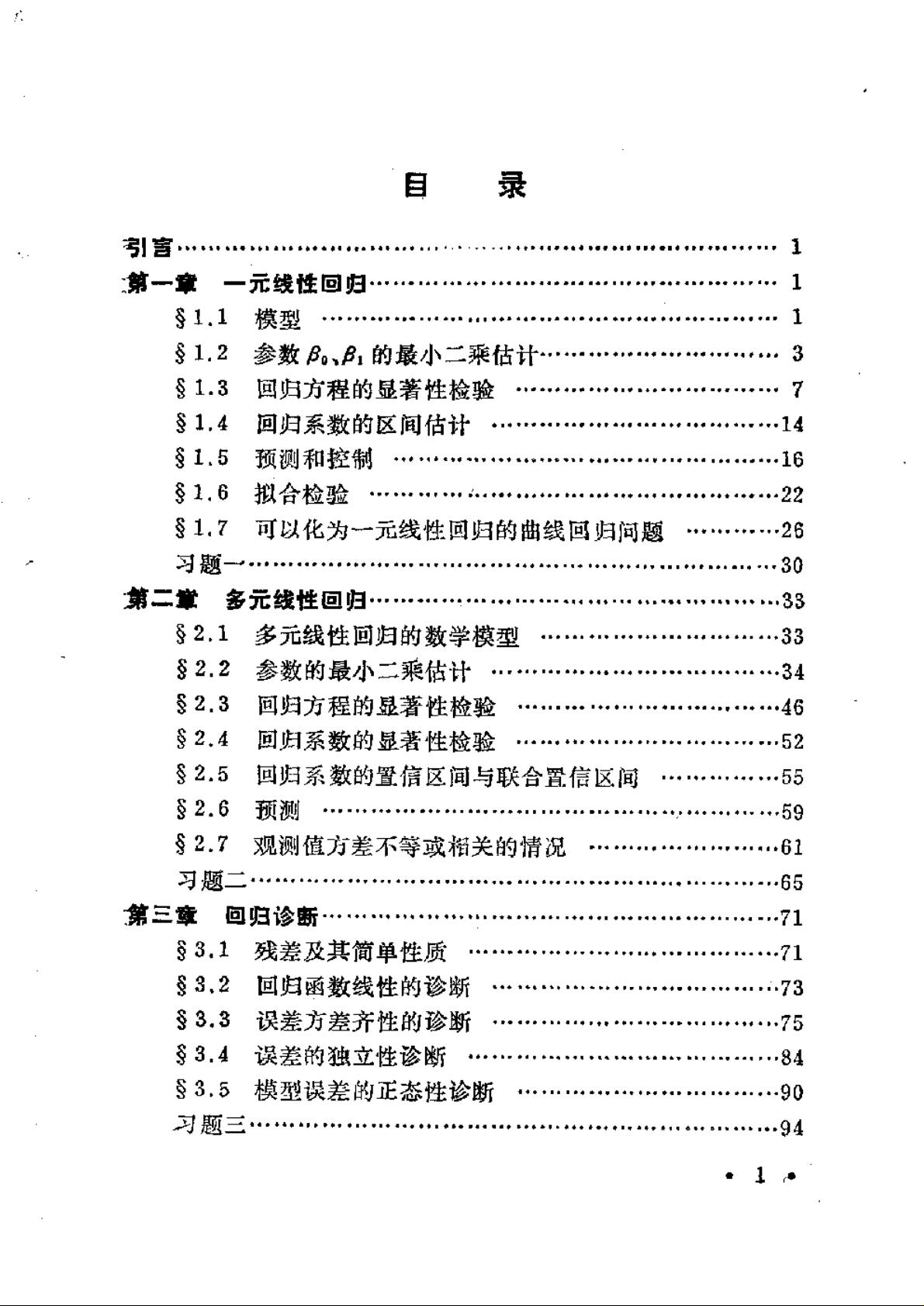

1. **回归模型**:回归分析的基础是构建回归模型,它通常表达为因变量与自变量之间的函数关系。线性回归是最常见的形式,例如,y = β0 + β1x1 + β2x2 + ... + ε,其中y是因变量,x1, x2等是自变量,β0, β1, β2是回归系数,ε表示误差项。

2. **估计参数**:利用最小二乘法或最大似然估计,我们可以找到最佳的回归系数,使得模型预测值与实际数据最接近。

3. **假设检验**:回归分析中的显著性检验,如t检验和F检验,用于判断自变量对因变量是否有显著影响。p值是衡量这一显著性的关键指标。

4. **多重共线性**:如果自变量之间存在高度相关性,就会出现多重共线性问题,这可能导致模型不稳定,难以准确估计参数。

5. **异方差性**:当误差项的方差随自变量的变化而变化时,称为异方差性。这会影响模型的可靠性和预测效果,通常需要通过图示或统计测试来诊断。

6. **自相关**:如果误差项之间存在相关性,称为自相关,这可能会影响回归系数的估计。自相关检测通常通过残差图或Durbin-Watson统计量进行。

7. **岭回归与套索回归**:为了解决多重共线性问题,可以采用岭回归(Ridge Regression),通过引入正则化参数来减小回归系数的绝对值。LASSO(Least Absolute Shrinkage and Selection Operator)回归则通过L1正则化实现变量选择和系数 shrinkage。

8. **非线性回归**:当因变量与自变量之间的关系不是线性时,需要使用非线性回归模型,如多项式回归、指数回归或对数回归等。

9. **多元回归**:当模型包含两个或更多自变量时,称为多元回归,可以同时考虑多个因素对因变量的影响。

10. **预测与解释**:回归模型不仅可以用来预测未知数据点的因变量值,还可以解释变量间的关系,帮助我们理解自变量如何影响因变量。

在压缩包中的“回归分析”文件,很可能是深入探讨这些主题的PDF文档,包含了回归分析的理论概念、计算方法、实例分析和应用案例,对于学习和掌握回归分析是非常宝贵的资源。读者可以通过阅读这份文档,进一步提升对回归分析的理解和应用能力。