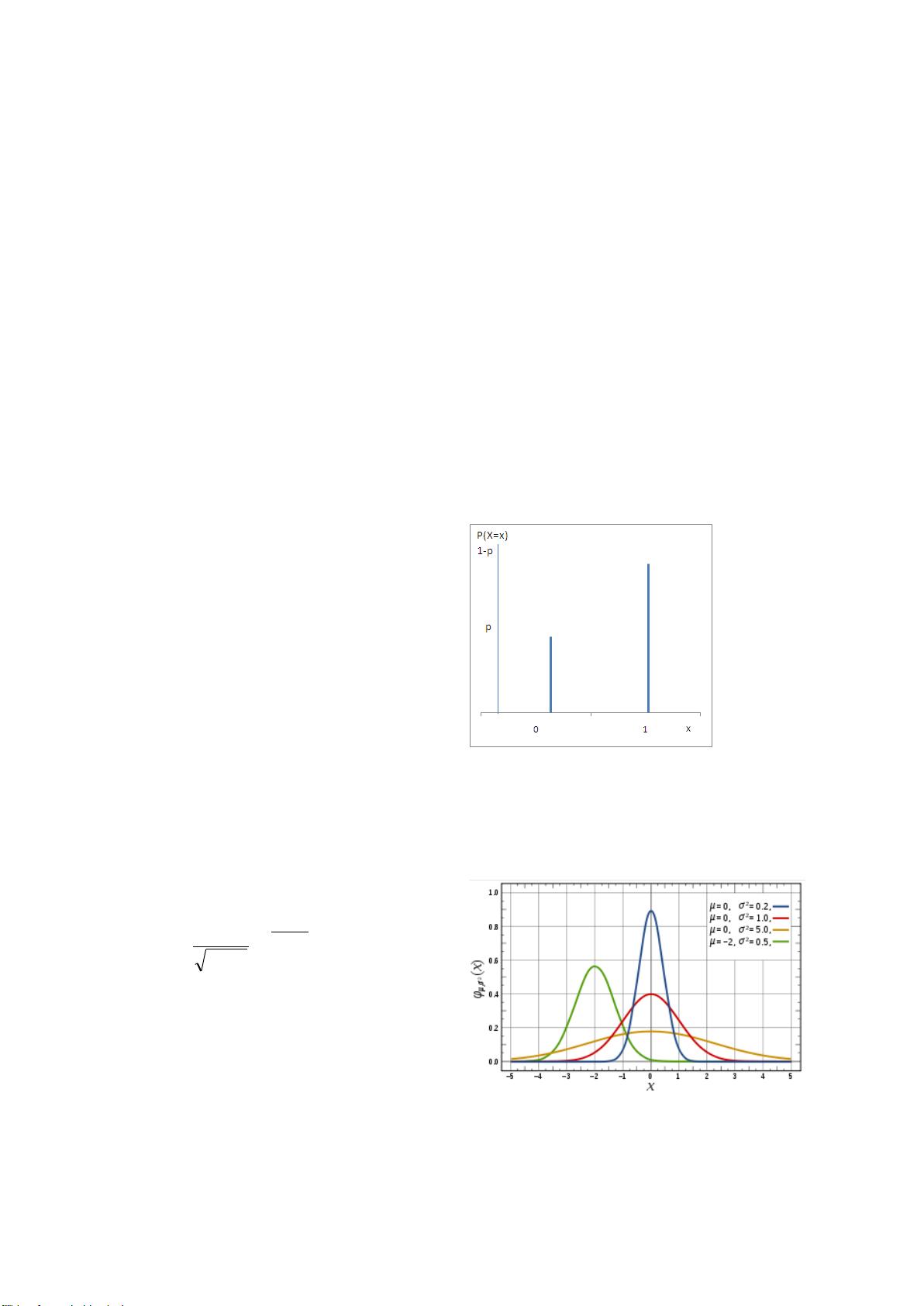

### 数据挖掘与机器学习基础知识 #### 第一章 机器学习的统计基础 ##### 1.1 概率论 **1.1.1 概率论基本概念** - **样本空间**: 在任何随机实验中,所有可能的基本结果的集合被称为样本空间,用S表示。例如,在拍拍贷用户学历的随机实验中,样本空间可以定义为S = {“研究生或以上”,“本科”,“大专”,“高中”,“中专”,“初中及以下”}。 - **事件**: 事件A是样本空间S的子集。根据所包含元素的数量,事件可以分为:空事件、原子事件、混合事件以及样本空间本身。例如,A = {“研究生或以上”,“本科”,“大专”}是一个混合事件。 - **概率论定义**: 概率是用来描述事件发生的不确定性的一种度量。例如,如果反复投掷一枚硬币,并记录正面朝上的结果出现的次数,那么这个结果出现的概率p可以通过多次重复实验得到的一个稳定值来表示。 **1.1.2 概率定律** - **事件的概率**: 对于任意事件A,其概率P(A)满足以下性质:P(A) ≥ 0,P(S) = 1,对于一系列互斥事件有P(A ∪ B) = P(A) + P(B)。 - **条件概率**: 在已知事件A发生的条件下,事件B发生的概率,记作P(B|A),计算公式为P(B|A) = P(A ∩ B) / P(A)。 - **独立性**: 如果两个事件的发生相互之间没有影响,则称这两个事件为统计独立事件。具体来说,若P(B|A) = P(B),则事件B和A统计独立,此时P(A ∩ B) = P(A) * P(B)。 - **总概率**: 任一事件A的概率可以通过其在另一个事件B发生或不发生的情况下来表示:P(A) = P(A|B) * P(B) + P(A|B̅) * P(B̅)。 - **贝叶斯定理**: 是条件概率的一种应用形式,用于计算逆概率P(B|A),即在已知A发生的条件下B发生的概率,公式为P(B|A) = (P(A|B) * P(B)) / P(A)。 **1.2 随机变量,期望,方差** - **随机变量**: 随机变量是随机试验结果的数值型表示。它可以分为离散随机变量和连续随机变量两种类型。 - **概率分布**: 描述随机变量所有可能的输出及其对应的概率。对于离散随机变量,概率分布函数给出每个值出现的概率;对于连续随机变量,则由概率密度函数描述。 - **期望**: 随机变量的期望值是所有可能值的加权平均,权重为其相应的概率。对于离散随机变量X,期望值E(X) = Σx * p(x),对于连续随机变量X,期望值E(X) = ∫x * p(x) dx。 - **方差**: 方差是用来衡量随机变量值与其均值偏离程度的一种度量。对于离散随机变量X,方差Var(X) = Σ(x - E(X))^2 * p(x);对于连续随机变量X,方差Var(X) = ∫(x - E(X))^2 * p(x) dx。 通过上述统计学的基础知识,我们可以更好地理解和处理数据挖掘与机器学习中的各种问题。接下来,我们将进一步探讨常用的数据挖掘算法及其Python实现。 ### 第二部分 机器学习概述 #### 第三章 机器学习概述 本章节将介绍机器学习的基本概念和发展历程,并讨论常见的机器学习任务如分类、回归、聚类等,以及相关的评价指标。 ### 第三部分 监督学习——分类与回归 #### 第四章 KNN(k最近邻分类算法) KNN是一种基于实例的学习方法,用于分类和回归。它的核心思想是在特征空间中的实例之间进行距离度量,通过计算未知实例与训练集中所有实例的距离,并选择距离最近的k个训练实例来对未知实例进行分类或回归预测。 #### 第五章 决策树 决策树是一种常用的分类和回归方法,通过构建一棵树形结构来进行预测。每个内部节点表示一个属性上的测试,每个分支代表一个测试结果,而每个叶子节点代表一种类别(对于分类问题)或一个数值(对于回归问题)。决策树的学习过程通常包括特征选择、树的生成以及剪枝。 #### 第六章 朴素贝叶斯分类 朴素贝叶斯分类器是一种基于贝叶斯定理的分类方法,它假设各个特征之间相互独立。这种假设虽然简单但往往能在实际应用中取得较好的效果,特别是在文本分类等领域。 #### 第七章 Logistic回归 Logistic回归是一种用于解决二分类问题的统计学方法,通过拟合数据来估计概率。它通过sigmoid函数将线性回归的输出转换为概率值,从而用于分类。 #### 第八章 SVM(支持向量机) 支持向量机是一种二分类模型,其目标在于找到一个超平面来最大化正负两类之间的间隔。支持向量机不仅可以处理线性可分的问题,还可以通过核技巧处理非线性可分的情况。 #### 第九章 集成学习(Ensemble Learning) 集成学习通过组合多个学习器的预测来提高预测性能。常见的集成学习方法包括Bagging和Boosting。Bagging通过有放回地采样训练数据集来训练多个模型,而Boosting则通过迭代地调整训练数据的权重来构建强分类器。 ### 第四部分 非监督学习——聚类与关联分析 #### 第十二章 K-means聚类分析 K-means是一种无监督学习算法,用于将数据对象分成K个簇,使得簇内的相似度高而簇间的相似度低。K-means通过迭代的方式不断更新簇中心来优化簇内成员之间的距离。 #### 第十三章 关联分析(Apriori算法) 关联分析用于发现数据集中项之间的有趣关系或关联规则。Apriori算法是一种经典的关联规则挖掘算法,通过频繁项集的递归枚举来找出所有的频繁项集和关联规则。 ### 第五部分 Python数据预处理 #### 第十五章 Python数据分析基础 本章介绍如何使用Python进行数据的读取、清洗、探索性数据分析等基础操作。主要包括使用Pandas库进行数据处理,使用Matplotlib和Seaborn进行数据可视化等。 #### 第十六章 Python进行数据清洗 数据清洗是数据预处理的重要步骤之一,包括缺失值处理、异常值检测与处理、重复数据删除等。通过Python中的Pandas库可以方便地完成这些任务。 ### 第六部分 数据结构与算法 #### 一、二叉树(前、中、后遍历) 二叉树是一种树形数据结构,每个节点最多有两个子节点。本节将介绍二叉树的基本概念及其遍历方法,包括前序遍历、中序遍历和后序遍历。 #### 二、几种基本排序方法 排序算法是计算机科学中的基础算法之一,本节将介绍几种常见的排序方法,包括冒泡排序、插入排序、选择排序、快速排序等,并讨论它们的时间复杂度和适用场景。 ### 第七部分 SQL知识 本部分将介绍SQL语言的基本概念和常用操作,包括数据查询、数据插入、数据更新、数据删除等,以及如何使用SQL进行数据分析。 ### 第八部分 数据挖掘案例分析 #### 案例一 AJourneythroughTitanic597c770e 本案例将通过对泰坦尼克号乘客数据集的分析,探索乘客生存率的影响因素,并利用多种机器学习算法进行预测。 #### 案例二 Analysis for airplane crashes since 1908 本案例将分析自1908年以来的飞机坠毁事故数据,识别导致事故的主要原因,并探讨如何通过数据挖掘技术预防未来的事故发生。 #### 案例三 贷款预测问题 在本案例中,将利用银行贷款数据集来预测贷款申请人的违约风险,并使用不同的机器学习算法比较预测效果。 #### 案例四 KNN算法实现葡萄酒价格模型预测及交叉验证 本案例将通过KNN算法对葡萄酒的价格进行预测,并采用交叉验证的方法来评估模型的泛化能力。 本文档涵盖了从数据挖掘的基础知识到具体算法的Python实现等多个方面,旨在帮助读者全面了解数据挖掘领域的重要技术和实践。通过理论与实践相结合的方式,不仅能够加深对数据挖掘算法的理解,还能掌握实际项目中的数据处理和建模技巧。

剩余111页未读,继续阅读

赵民勇2018-06-10进军python

赵民勇2018-06-10进军python

- 粉丝: 16

- 资源: 16

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功