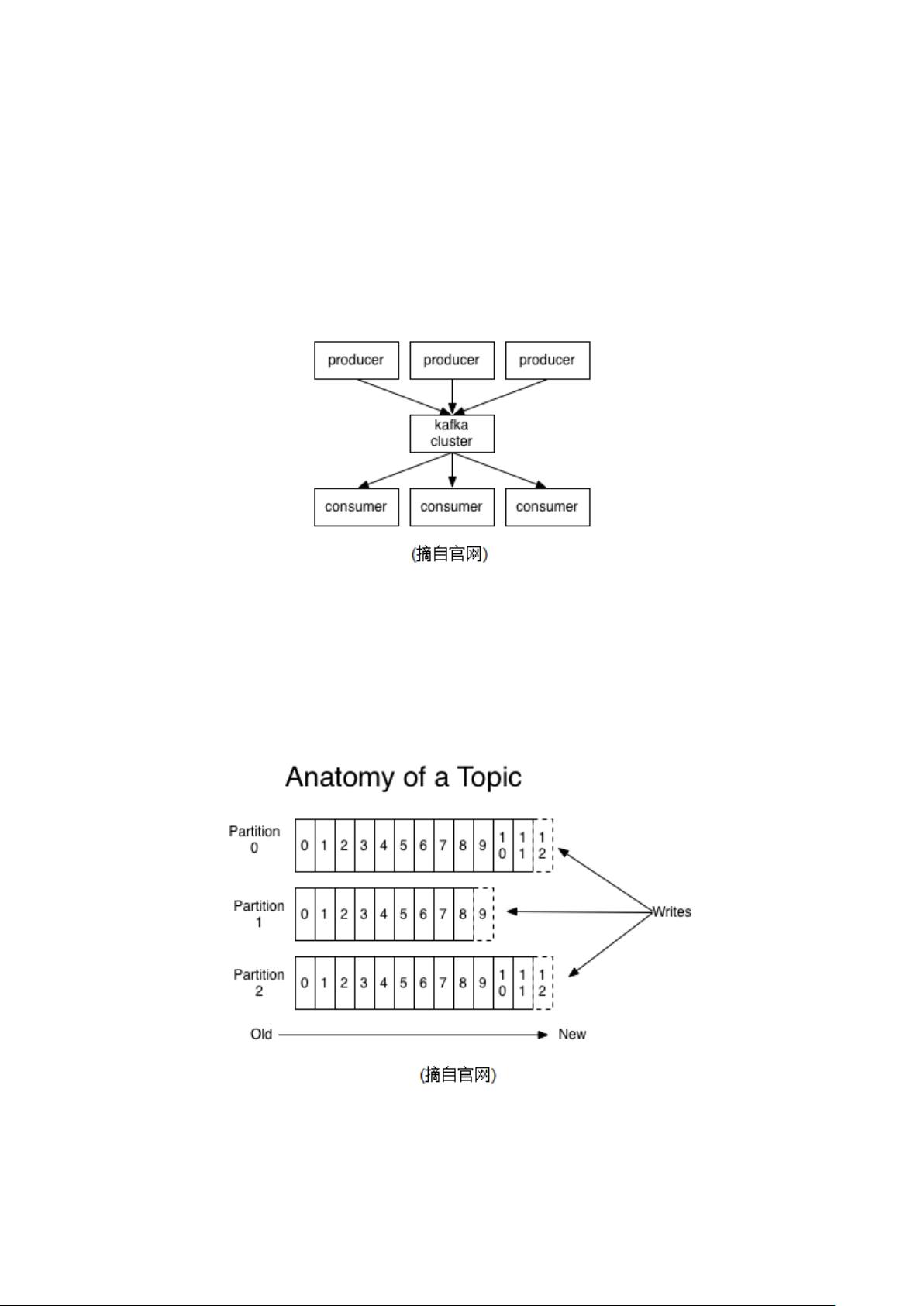

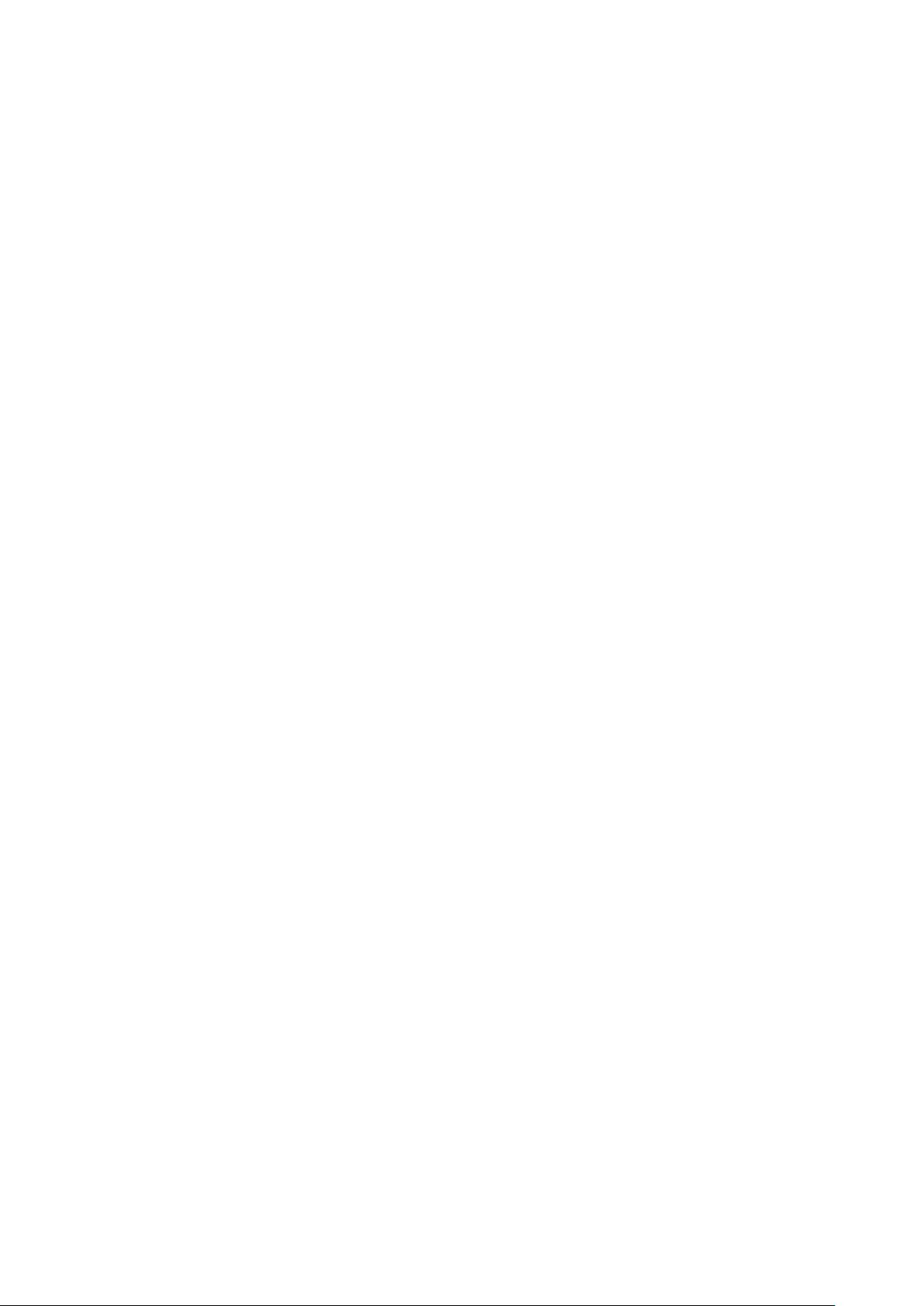

Kafka是一个分布式、分区、可复制的提交日志服务,最初由LinkedIn公司采用Scala和Java编写,并于2011年开源。它旨在提供一个统一、高吞吐量、低延迟的平台,用于处理活跃消息流数据。Kafka可以处理消费者和生产者两端的高并发量,而且它不直接提供消息的随机读写能力,这是为了优化其在磁盘I/O使用上的性能。 在Kafka集群的环境中,生产者(Producer)负责将数据发布到指定的主题(Topic)中,消费者(Consumer)则订阅这些主题,并消费其中的数据。Kafka通过主题来归类消息,每个主题可以被进一步分成多个分区(Partition),分区作为分布式的基本单位。每个分区在物理上对应于服务器上的一个日志文件,消息在分区内的文件中以追加的方式存储,并通过偏移量(offset)进行索引。Kafka不提供索引机制来存储offset,以防止随机读写的开销。 Kafka中的消息一旦被消费,并不会立即删除,而是按照预先设定的保存策略进行保留。这意味着Kafka能够利用磁盘空间保存历史消息,并且减少消息消费后对文件内容的改动。消费者会根据需要保存消息的offset,这个状态信息是存储在Zookeeper中的,由消费者自己控制。消费者能够以任意顺序消费消息,只需将offset重置到指定位置。 在Kafka集群中,分区的设计除了方便日志内容的分散以避免单个磁盘容量的限制之外,还有助于提升数据的读写效率。分区数越多,可以容纳的消费者数量也就越多,从而提升并发消费的能力。Kafka集群中的每个分区都有一个leader,这个leader是负责处理所有读写操作的节点。如果leader节点失效,会有其他节点(follower)接管成为新的leader。为了提高可用性,每个分区可以配置多个备份(replicas),并且这些备份会分布在整个集群中,Kafka会尝试均衡地将leader分散在各个实例上,以保证整体性能稳定。 Kafka的生产者和消费者客户端设计非常轻量级,它们不需要维护集群状态信息,这些信息是由Zookeeper负责保存的。因此,即使生产者或消费者客户端离线,也不会对集群造成额外影响。由于分区数量决定了leader的数量,因此增加分区数量也是提高集群吞吐量的一个有效手段。 Kafka集群中的生产者可以指定消息发布的分区,这通常通过轮询(round-robin)方式或其他算法实现。而消费者则是按照消费组(consumer group)来组织,每个消费者属于一个消费组,每个组可以包含多个消费者。如果消费者都属于同一个消费组,则消息会在消费者之间进行负载均衡;若每个消费者都属于不同的消费组,则每个消费者都会收到消息的副本,类似于发布-订阅模式。 总结而言,Kafka集群文档详细介绍了Kafka集群的基本概念、架构设计、工作原理以及如何进行消息生产和消费。文档从分区、复制、状态存储以及消费者组等方面阐述了Kafka如何实现高吞吐量、低延迟的消息处理。了解和掌握这些知识点是搭建和维护Kafka集群的前提。

剩余14页未读,继续阅读

- 粉丝: 0

- 资源: 3

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 【java毕业设计】智慧社区智慧共享资源搜索与推荐系统(源代码+论文+PPT模板).zip

- 【java毕业设计】智慧社区智慧共享资源分类管理系统(源代码+论文+PPT模板).zip

- 【java毕业设计】智慧社区智慧共享资源评价系统(源代码+论文+PPT模板).zip

- 【java毕业设计】智慧社区智慧会员等级与积分管理系统(源代码+论文+PPT模板).zip

- 【java毕业设计】智慧社区智慧社区活动报名与签到系统(源代码+论文+PPT模板).zip

- 【java毕业设计】智慧社区智慧会员活动中心管理系统(源代码+论文+PPT模板).zip

- 【java毕业设计】智慧社区智慧社区活动反馈与评价系统(源代码+论文+PPT模板).zip

- 【java毕业设计】智慧社区智慧社区留言板与回复系统(源代码+论文+PPT模板).zip

- 【java毕业设计】智慧社区智慧社区公告发布与查询系统(源代码+论文+PPT模板).zip

- 【java毕业设计】智慧社区智慧社区管理员日志审计系统(源代码+论文+PPT模板).zip

- 【java毕业设计】智慧社区智慧社区新闻资讯分类管理系统(源代码+论文+PPT模板).zip

- 【java毕业设计】智慧社区智慧社区管理员角色与权限管理系统(源代码+论文+PPT模板).zip

- 【java毕业设计】智慧社区新闻资讯评论与点赞系统(源代码+论文+PPT模板).zip

- 【java毕业设计】智慧社区智慧社区新闻资讯搜索与订阅系统(源代码+论文+PPT模板).zip

- 【java毕业设计】智慧社区在线影院影片分类系统(源代码+论文+PPT模板).zip

- 【java毕业设计】智慧社区在线影院观影记录与评分系统(源代码+论文+PPT模板).zip

信息提交成功

信息提交成功