vs+libtorch(环境配置以及部署),包含batch推理,FP16推理

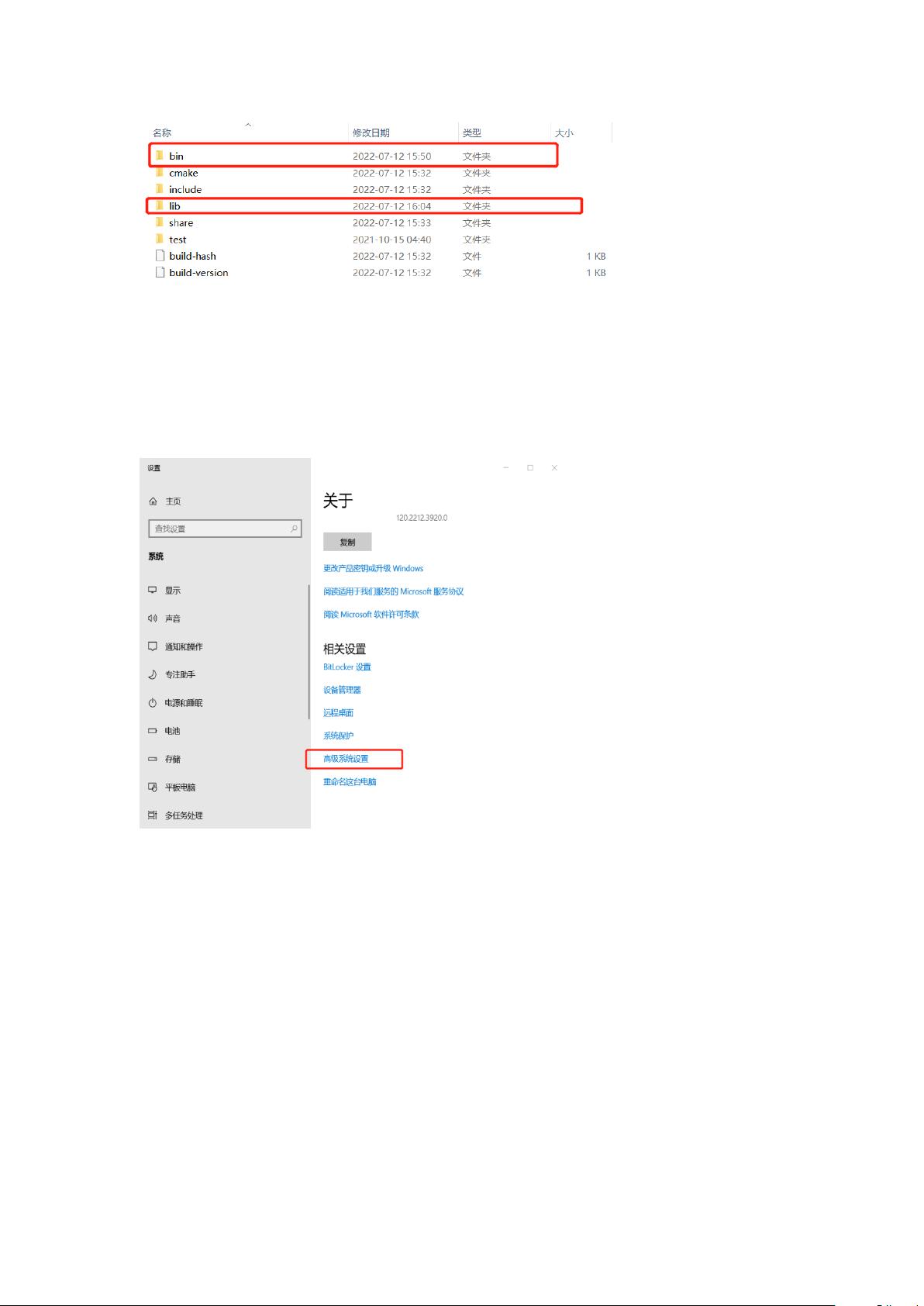

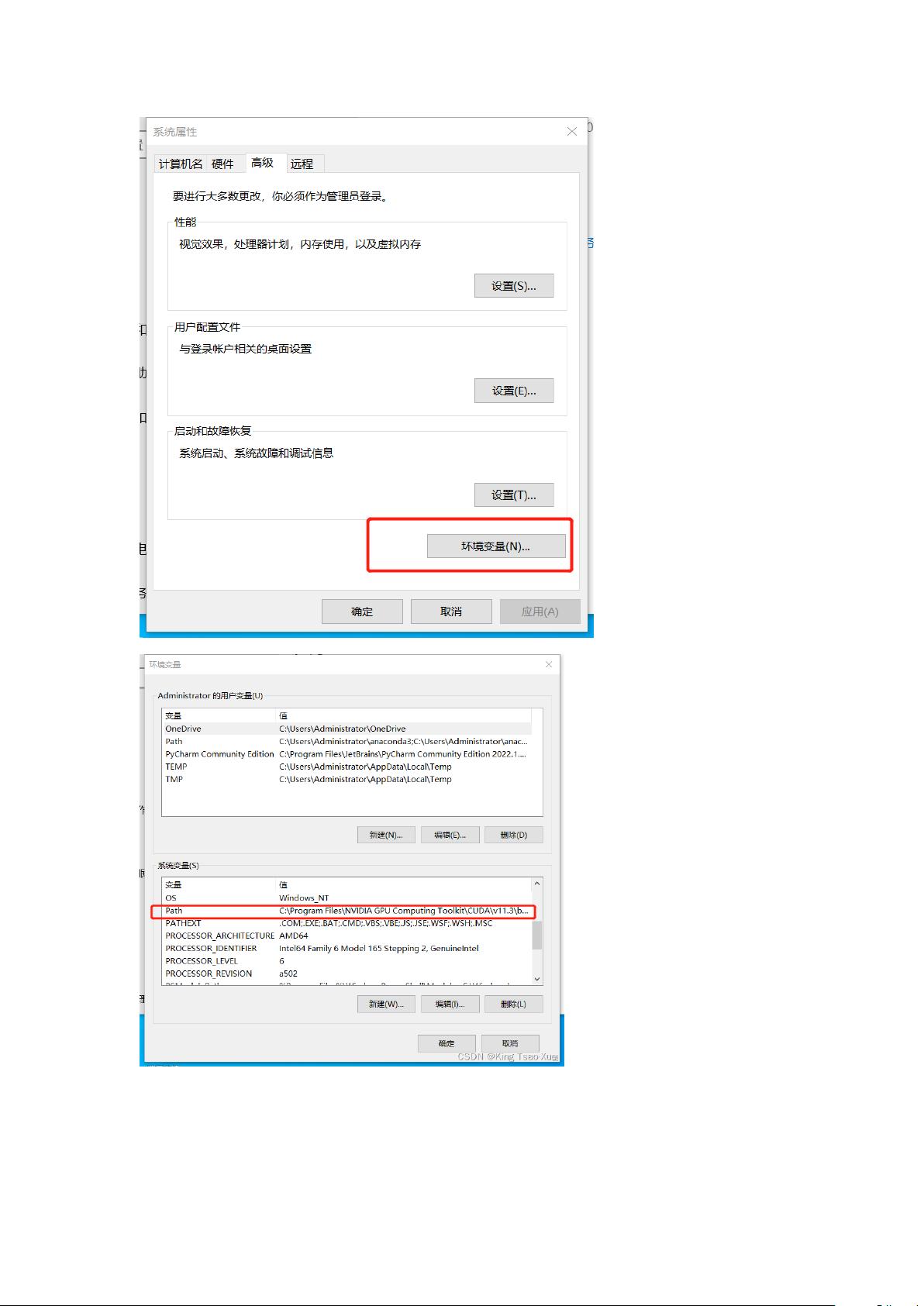

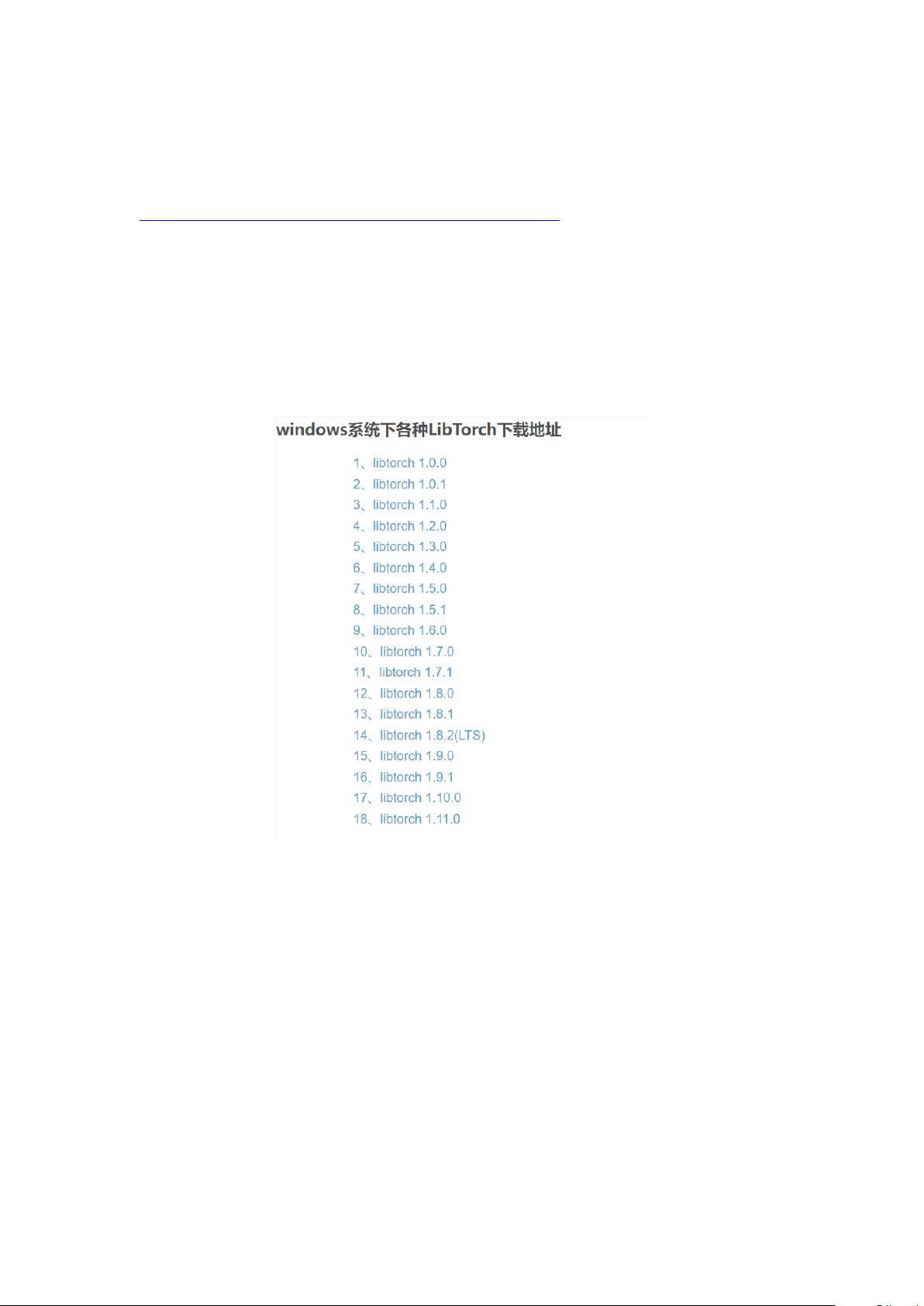

《VS + LibTorch环境配置与部署:Batch推理与FP16推理详解》 LibTorch,作为PyTorch的C++版本,为深度学习模型的部署提供了强大的支持。本篇将详细介绍如何在Visual Studio(VS)环境中配置和部署LibTorch,包括Batch推理和FP16推理的实现,适合于libtorch初学者和模型部署的实践者,特别是应用于工业缺陷检查或学术研究的场景。 我们来了解一下库的下载与环境配置。LibTorch可以从官方网站下载,但推荐通过其他途径获取,如链接中的CSDN博客。确保选择与PyTorch版本相匹配的libtorch1.11.0。下载后解压,然后进行环境变量的设置。将解压后的`lib`和`bin`目录路径添加到系统环境变量`PATH`中。同时,为了防止缺失dll文件的错误,可以选择将`lib`目录下的dll文件复制到`C:\Windows\System32`或工程目录下。 接下来是属性页的配置。在VS项目中,我们需要设置包含目录、库目录、附加库目录和附加依赖项。包含目录指向`libtorch\include\torch\csrc\api\include`和`libtorch\include`;库目录设置为`libtorch\lib`;附加库目录同样为`libtorch\lib`;附加依赖项则需要输入`libtorch\lib`下的所有`.lib`文件名。 在编译选项方面,需要注意的是禁用SDL检查(C/C++ -> 常规 -> SDL检查 -> 否 (/sdl-))和不符合模式(C/C++ -> 语言 -> 符合模式 -> 否 (/permissive-))。此外,如果遇到DLL未找到的问题,可将`lib`目录的DLL拷贝至System32或工程目录。对于某些特定错误,如“0x00007FFDC1DF4ED9”,可能需要在链接器的命令行参数中加入特定的符号引用。 模型转换是部署前的重要步骤。你需要训练模型并保存为.pth文件。这里以MobileNet_v3_large为例,通过训练和测试获取模型权重。然后,使用PyTorch的API将.pth模型转换为适用于C++部署的.pt模型,这一步通常涉及模型的移动到GPU设备(如果可用)和模型状态的加载。 一旦模型转换完成,我们就可以在C++程序中进行Batch推理和FP16推理。Batch推理允许一次性处理多个样本,提高效率。而FP16推理则通过使用半精度浮点数(FP16)来减小模型的内存占用和计算资源需求,但可能会影响精度。在C++代码中,可以通过Tensor的操作来实现这两个功能。 VS与LibTorch的结合使得深度学习模型部署变得更为便捷,通过正确的环境配置和模型转换,可以实现高效且节省资源的推理过程。无论是工业级的应用还是学术研究,理解并掌握这些步骤都是非常关键的。在实践中遇到问题时,可以参考相关博客或社区资源,以便更好地解决问题。

剩余16页未读,继续阅读

- 粉丝: 71

- 资源: 1

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜 信息提交成功

信息提交成功

评论0