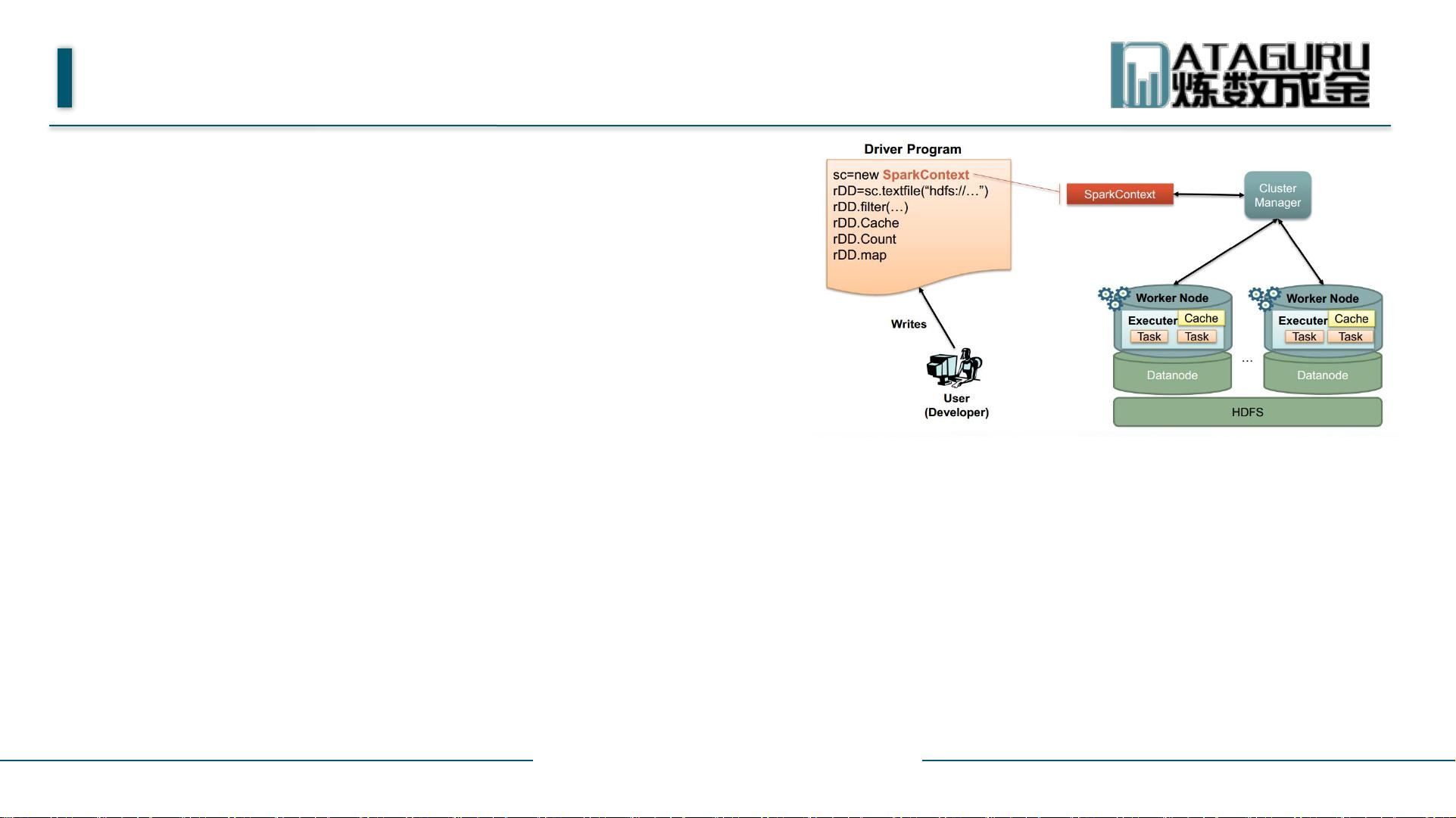

### Spark大数据分析平台知识点解析 #### 一、Spark概述与编程模型 **Spark** 是一款专为大规模数据处理设计的快速通用的计算引擎。它能够高效地支持多种类型的数据处理应用,包括批处理、流处理、机器学习以及图计算等。Spark 的核心组件包括 **Spark Core**、**Spark SQL**、**Spark Streaming**、**MLlib** 和 **GraphX**。 **编程模型**: - **Driver**: 是 Spark 应用程序的主要控制进程,负责管理应用程序的生命周期,并启动和监控 Executor 进程。 - **Executor**: 在 Worker 节点上运行的任务执行进程,负责执行 Task 并将数据缓存到内存或磁盘上。 - **Application**: 包含一个 Driver program 和若干个 Executor。它是由用户编写的 Spark 程序,可以提交到集群中执行。 - **SparkContext (SparkConf)**: SparkContext 是 Spark 应用程序的入口点,用于获取集群资源并协调 Executor 的执行。SparkConf 配置了 Spark 应用的基本属性,如应用名、主节点地址等。 - **Cluster Manager**: 在集群上获取资源的服务,例如 Standalone 模式、Apache Mesos 或 Apache YARN。 - **Worker Node**: 集群中的节点,可以运行 Executor 进程。 #### 二、Spark 的核心概念 - **Job**: 由 Action 触发的一个或多个阶段的执行流程。 - **Stage**: Job 的一个执行阶段,包含一组 Task。 - **Task**: Executor 上执行的基本工作单位。 - **RDD (Resilient Distributed Dataset)**: 弹性分布式数据集,是 Spark 最核心的数据抽象,可以通过数据集转换生成或者由其他 RDD 经过算子操作得到。 #### 三、Spark 应用程序的构建 1. **初始化 SparkContext**: - 导入必要的 Spark 类和隐式转换。 - 创建 SparkConf 对象以定义应用程序的基本配置。 - 使用 SparkConf 初始化 SparkContext。 2. **创建 RDD**: - **并行化集合**: - `sc.parallelize(Array(1 to 10))`: 将数组转化为 RDD。 - `sc.parallelize(Array(1 to 10), 5)`: 指定分区数量。 - **Hadoop 数据集**: - Spark 可以直接读取 Hadoop 支持的各种存储资源,如 HDFS、Cassandra、HBase、Amazon S3 等。 - 使用 `textFile()` 方法读取文本文件或压缩文件。 - 支持通配符读取多个文件,如 `textFile("file:///dfs/data/*.txt")`。 #### 四、Spark 的数据处理流程 - **创建 RDD**: 通过并行化集合或读取 Hadoop 数据集等方式创建。 - **执行 Transformation**: 对 RDD 进行转换操作,如 map、filter、reduceByKey 等。 - **执行 Action**: 触发计算过程,如 count、collect、saveAsTextFile 等。 #### 五、示例 - **并行化集合**: ```scala val rdd = sc.parallelize(Array(1 to 10)) val rddWithPartitions = sc.parallelize(Array(1 to 10), 5) ``` - **读取 Hadoop 数据集**: ```scala val textRDD = sc.textFile("/dfs/directory") val compressedRDD = sc.textFile("/dfs/directory/data.gz") val wildcardRDD = sc.textFile("file:///dfs/data/*.txt") ``` #### 六、总结 Spark 大数据分析平台提供了强大而灵活的数据处理能力,通过其核心的编程模型和丰富的 API,可以高效地处理各种规模的数据集。从初始化 SparkContext 到创建和操作 RDD,再到执行 Transformation 和 Action,整个过程都非常直观。此外,Spark 支持多种数据源的读取,使得开发者可以轻松地集成现有的数据存储系统。通过理解这些基础知识,开发者可以更好地利用 Spark 来解决实际问题,提高数据处理的效率和灵活性。

剩余22页未读,继续阅读

- 粉丝: 2

- 资源: 19

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功