hadoop分布式文件系统源代码详细解析.pdf

2.虚拟产品一经售出概不退款(资源遇到问题,请及时私信上传者)

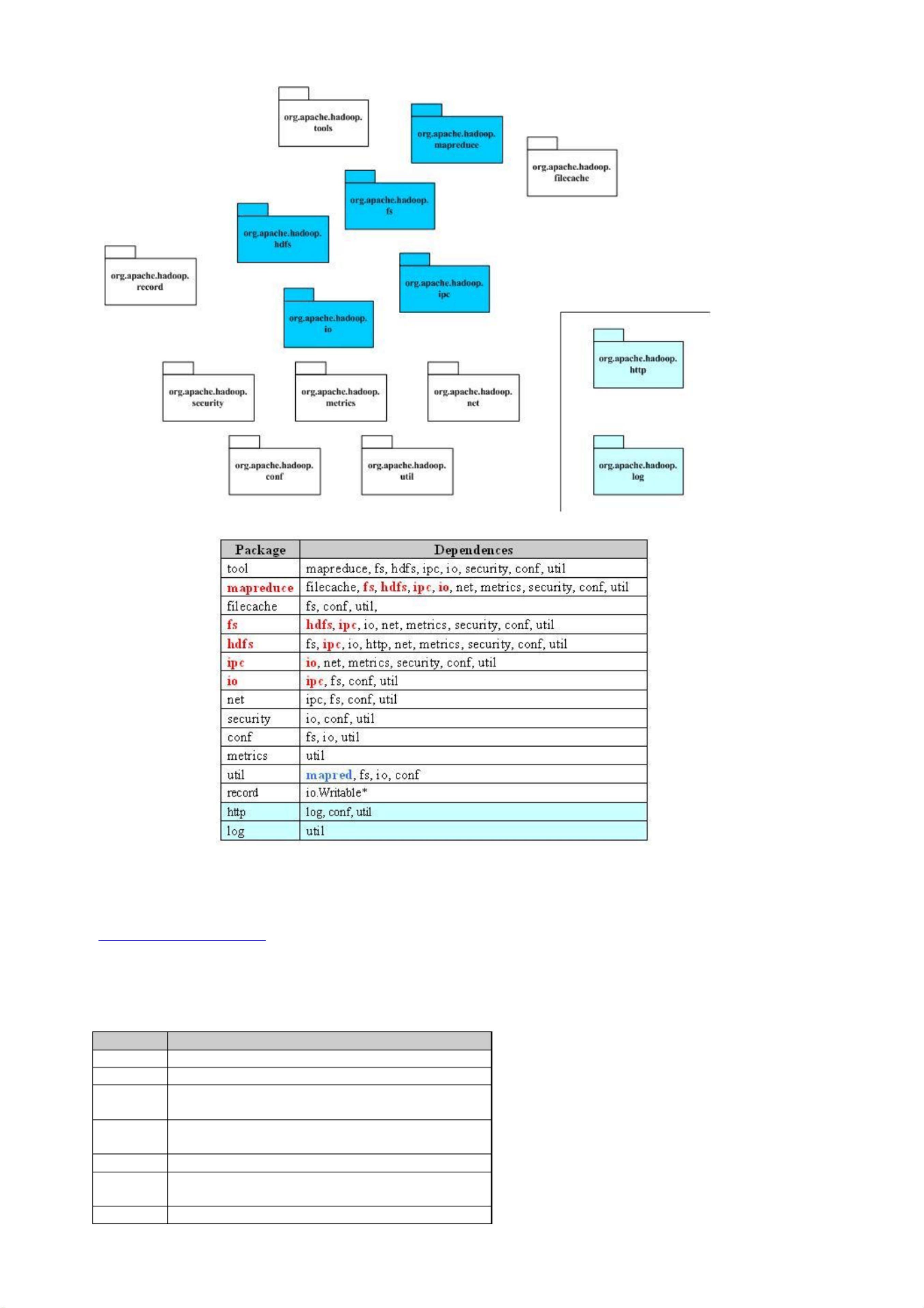

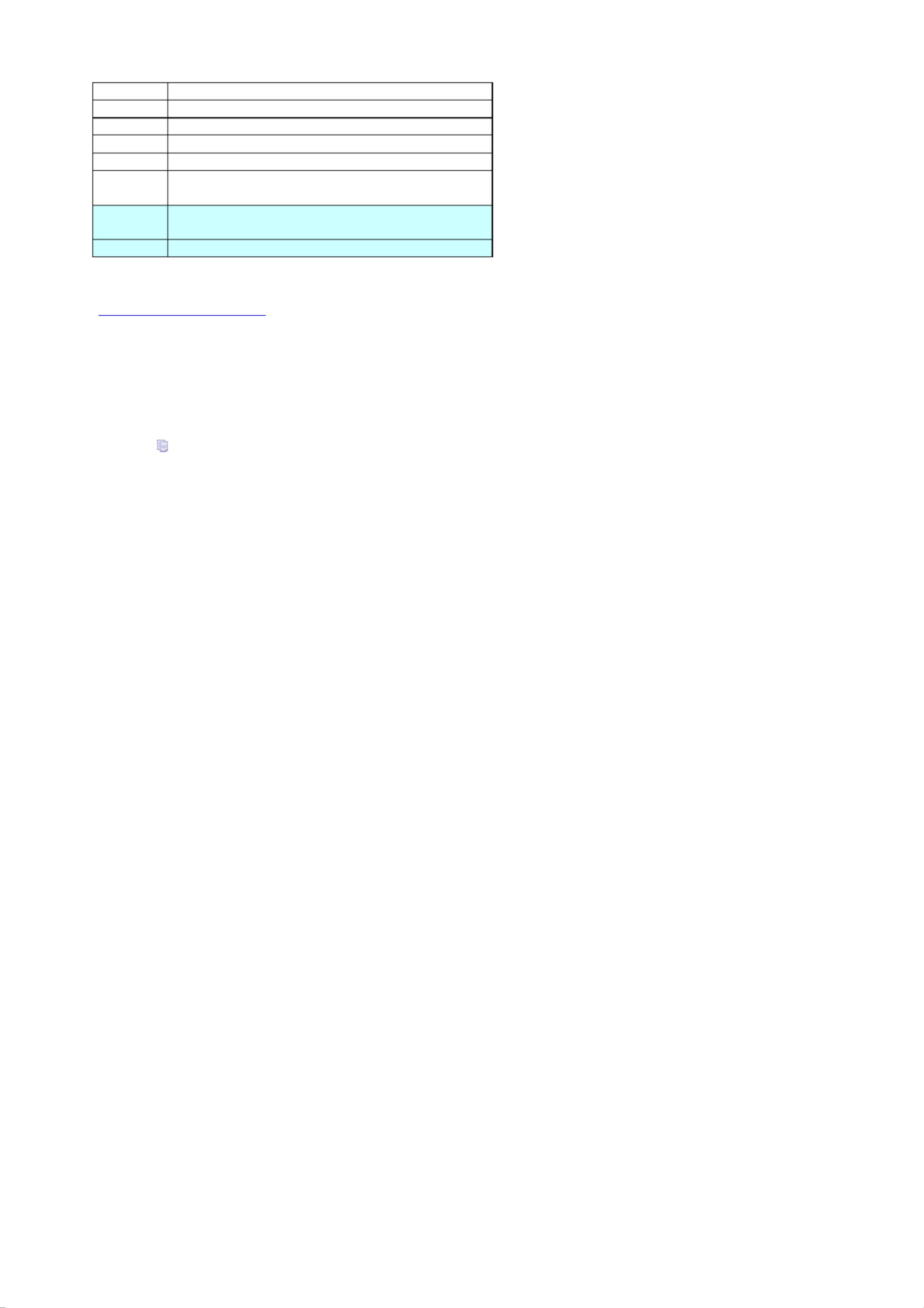

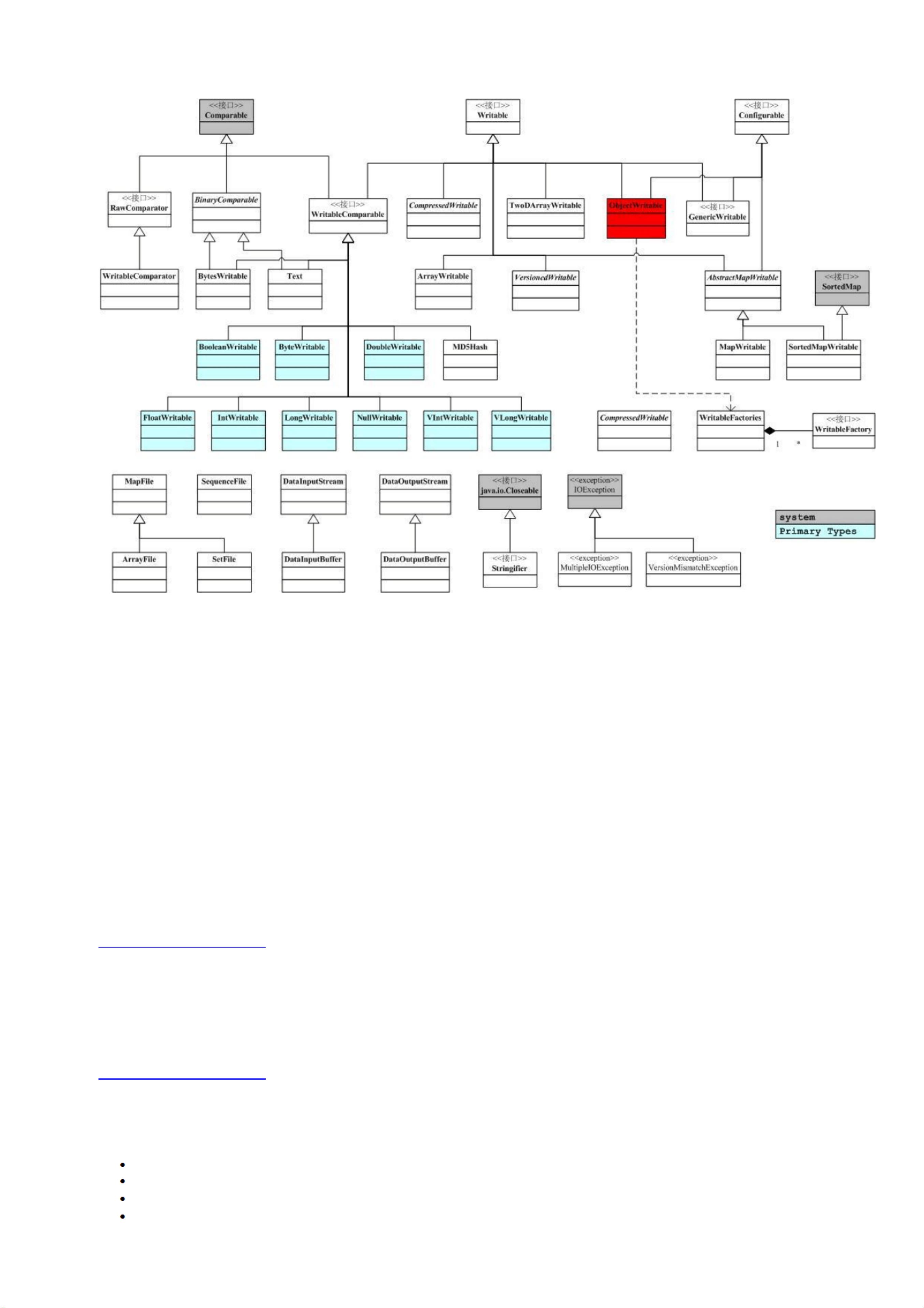

《Hadoop分布式文件系统源代码详细解析》 在IT领域,分布式计算已成为处理海量数据的核心技术,而Hadoop作为开源的分布式计算框架,其分布式文件系统(HDFS)更是其中的关键组成部分。本解析将深入Hadoop的源代码,探讨其设计理念、主要组件以及关键模块的功能。 Hadoop的诞生源于Google的五篇核心技术论文,即GoogleCluster、Chubby、GFS、BigTable和MapReduce。这些创新性的技术为Google构建了强大的计算平台。随后,Apache社区推出了Hadoop项目,将Google的技术理念转化为开源实现,包括Chubby对应的ZooKeeper、GFS对应的HDFS、BigTable对应的HBase以及MapReduce对应的Hadoop MapReduce框架。 HDFS作为Hadoop的基石,是一个高容错、高吞吐量的分布式文件系统,支持多种文件系统接入,如本地文件系统、分布式文件系统和Amazon S3等在线存储。Hadoop包之间的依赖关系错综复杂,尤其是conf包,它读取系统配置,与fs包相互依赖,形成了一种复杂的蜘蛛网状结构。Hadoop的关键部分集中在蓝色部分,主要包括HDFS和MapReduce的实现。 Hadoop的各个包有明确的功能分工: 1. tool包提供命令行工具,如DistCp,用于数据复制。 2. mapreduce包实现MapReduce计算模型。 3. filecache为MapReduce提供HDFS文件的本地缓存,提升数据访问速度。 4. fs包是文件系统接口,为不同类型的文件系统提供统一访问。 5. hdfs包实现了HDFS,提供了分布式文件系统的核心功能。 6. ipc包实现简单IPC,依赖io包的编码解码功能。 7. io包处理数据的网络传输编码和解码。 8. net包封装网络功能,如DNS和socket。 9. security包处理用户和用户组信息,确保安全性。 10. conf包管理系统配置参数。 11. metrics包收集系统统计信息,用于监控和管理。 12. util包包含通用工具类。 13. record包根据DDL生成编解码函数,支持C++和Java。 14. http包基于Jetty提供HTTP Servlet服务,用于查看系统状态和日志。 15. log包提供了HTTP访问日志的HTTP Servlet服务。 在Hadoop中,对象序列化是必不可少的,因为MapReduce和HDFS的通信需要将对象转换成可传输的形式。Hadoop并未采用Java内置的序列化机制,而是自定义了一套序列化系统,主要由org.apache.hadoop.io中的Writable接口实现。例如,一个实现了Writable接口的类MyWritable,其write方法会将counter和timestamp写入DataOutput,便于在网络中传输。 通过深入Hadoop源代码,我们可以更清晰地理解其分布式文件系统和MapReduce的工作原理,这对于理解和开发基于Hadoop的大数据应用至关重要。对于准备参加相关考试的学习者来说,掌握这些基础知识将对备考和实际工作带来极大帮助。

剩余49页未读,继续阅读

- 粉丝: 0

- 资源: 6万+

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- xxs靶机,放入vm中使用

- BLE蓝牙单片机CC2540、CC2541带OSAL操作系统的例程-LED跑马灯.zip

- BLE蓝牙单片机CC2540、CC2541裸机简易C语言程序开发之系统睡眠唤醒-中断唤醒.zip

- BLE蓝牙单片机CC2540、CC2541裸机简易C语言程序开发之系统睡眠唤醒-定时器唤醒.zip

- BLE蓝牙单片机CC2540、CC2541裸机简易C语言程序开发之温湿度传感器DHT11.zip

- BLE蓝牙单片机CC2540、CC2541裸机简易C语言程序开发之温度传感器DS18B20.zip

- 机器学习预处理-表格数据的空值处理-py工程

- 基于OpenCV的机器视觉技术,对集会中的观众场景进行光流分析

- AN11801正版标准

- 实验四-运输层协议实验.docx

信息提交成功

信息提交成功