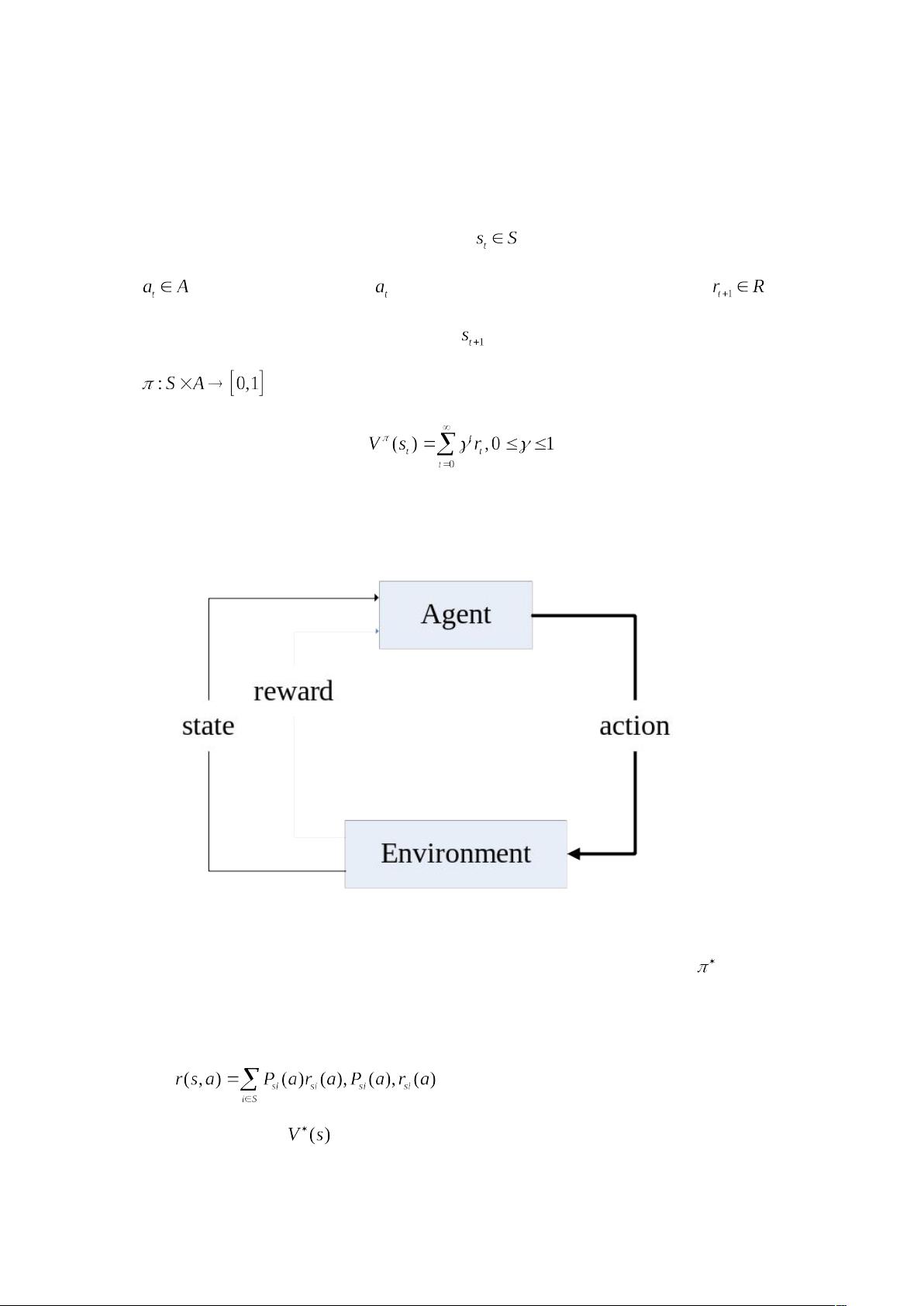

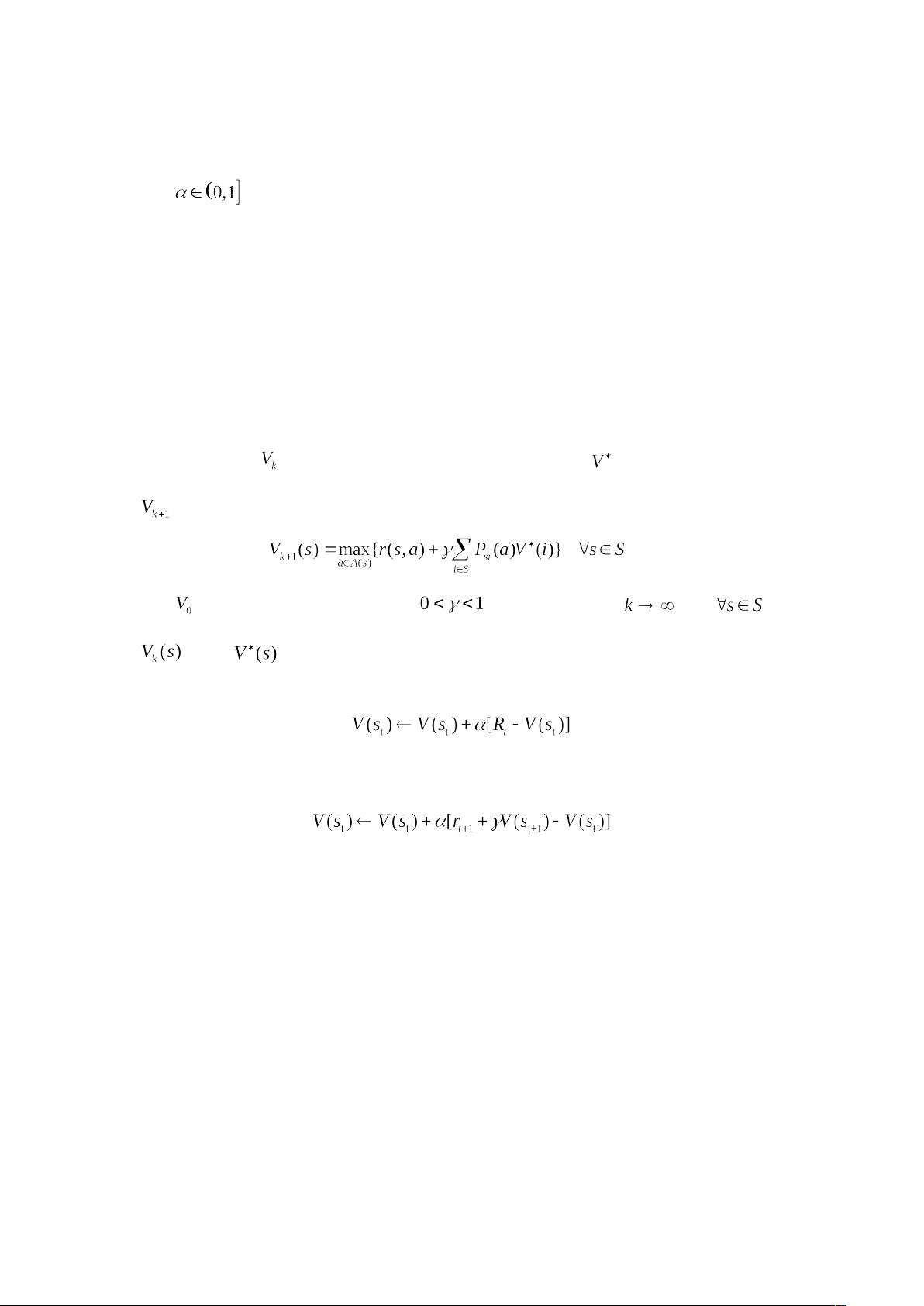

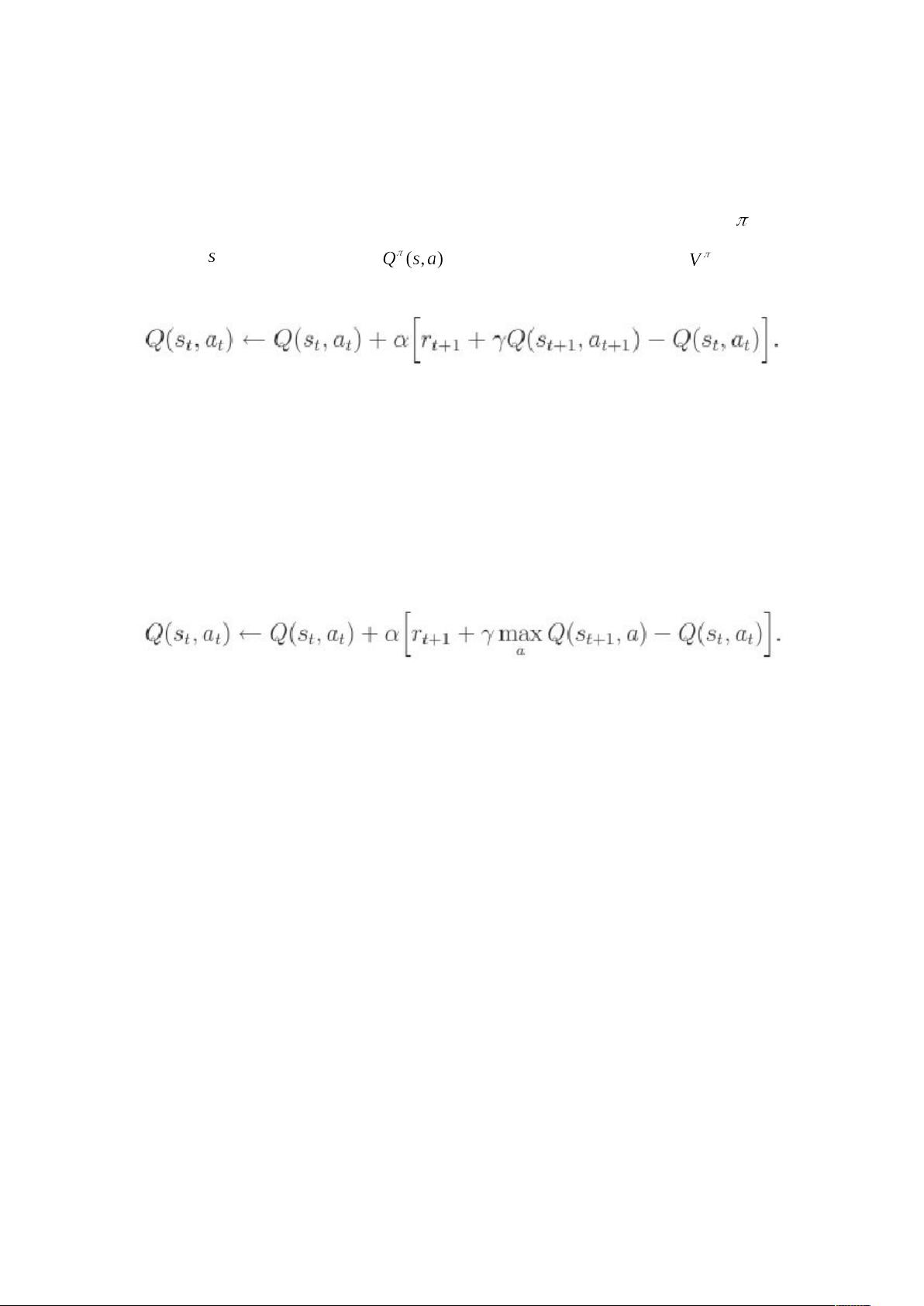

增强学习是一种机器学习的方法,它通过智能体与环境的交互来优化策略,以最大化累计奖励。在增强学习中,智能体在一系列离散的时间步(t=0,1,...)上与环境进行交互。每个时间步,智能体观察到环境的状态S,从动作集A中选择一个动作执行,并收到一个即时的奖励R,然后进入新的状态。学习的目标是找到一个最优策略,使得从初始状态开始的累计奖励最大化。 标准的增强学习模型可以用马尔科夫决策过程(Markov Decision Process, MDP)来描述。MDP是一个状态转移模型,其中P函数表示执行动作a从状态s转移到状态i的概率,R函数给出在状态s执行动作a后获得的期望奖励。最优策略π*使得系统在状态s的价值函数V(s)最大,即满足贝尔曼最优方程: (1) V(s) = max_a {R(s,a) + γ * Σ_i P(s'|s,a) * V(s')} 其中,γ是折扣因子,它平衡了即时奖励和未来奖励的重要性。如果γ接近1,那么未来的奖励会被更多地考虑。 增强学习算法通常分为基于模型的方法和模型无关的方法。基于模型的方法,如Dyna-Q,需要学习环境的动态模型P和R,从而能够预测未来状态和奖励。而模型无关的方法,如瞬时差分学习(Temporal Difference, TD),不需要学习模型,而是直接从经验中学习。TD学习结合了蒙特卡洛(Monte Carlo)方法和动态规划,它在不需要完整模型的情况下也能进行价值函数的更新。 TD学习中的贝尔曼方程迭代可以表示为: (2) V(s) = V(s) + α * [R(s') + γ * V(s') - V(s)] 其中,α是学习率,R(s')是下一个状态的即时奖励,V(s')是新状态的价值估计。这种方法允许智能体在经历每个时间步后立即更新价值函数,而无需等待整个episode结束。 与TD学习相比,蒙特卡洛方法在所有episode结束后才更新价值函数,因此它们在模型未知时能够准确估计长期回报,但更新较慢。而TD学习在每次交互后就能更新,因此在某些情况下收敛速度更快。 在增强学习中,除了智能体和环境外,还有四个关键元素:策略、奖励函数、值函数和环境模型。策略π决定了智能体在特定状态下如何选择行动。奖励函数R定义了智能体的目标,将状态或状态-行为对映射为奖励值。值函数V(s)表示从状态s开始预期能积累的总奖励。环境模型则包含了状态转移和奖励函数的详细信息,不是所有增强学习算法都需要这个模型。 马尔科夫性质是MDP的基础,它指出当前状态包含了所有对智能体未来决策有用的信息。如果一个状态满足这一性质,我们称它具有马尔科夫性。在数学上,这可以表示为: P(s'|s,a) = P(s'|s,a,history) 这意味着未来的状态只依赖于当前状态和采取的动作,而不依赖于过去的完整历史。 TD学习是结合了蒙特卡洛和动态规划思想的一种学习方法,它能够在没有环境模型的情况下从实际经验中直接学习,并通过估计值函数进行迭代更新,从而实现策略的优化。这种学习方式在许多实际应用中,如机器人控制,显示出了巨大的潜力。

剩余30页未读,继续阅读

- 粉丝: 0

- 资源: 1

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- MSCOMM控件资源WIN-ALL

- default.custom.yaml # RIme 输入法 的简体设置文件

- MT7621路由器SDK和HDK文件,MT7621无线路由器,MediaTek-ApSoC-SDK-4320-20150414.tar.bz2 AP-MT7621 MT7612E MT7603E-V4

- 广播星历位置计算,精密星历提供的坐标进行求差

- 默纳克刷机,默纳克刷协议,默纳克显示板 外呼板协议更改 烧录 默纳克各种软件各种刷机,含主板、轿顶板、外呼板刷机软件原程序、操作器刷机软件及协议一应俱全

- 连续性和可导性入门学习(微积分前置知识)

- Unistorm最新unity天气资源包

- 基于yolov5实现的AI自动瞄准的python源码+文档说明(亲测可用)

- 计算机基础知识点与前沿技术全面解析

- 课程设计javaweb的企业人事管理系统源码+数据库+实验报告(高分项目)

信息提交成功

信息提交成功