更多 IT 认证课程请访问 美河学习在线 www.eimhe.com

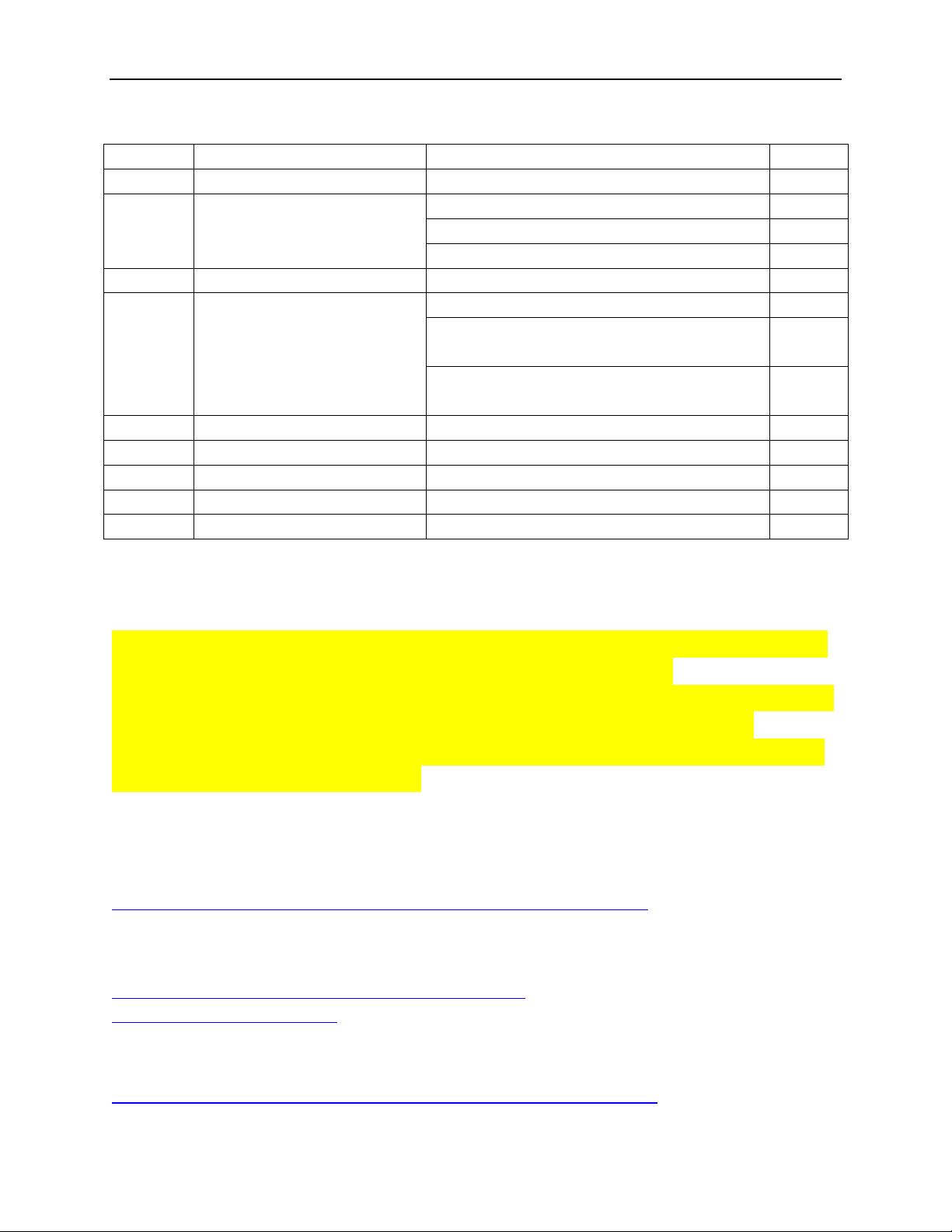

/opt/hadoop-2.6.5/sbin/start-all.sh

/opt/hadoop-2.6.5/sbin/start-dfs.sh

/opt/hadoop-2.6.5/sbin/start-yarn.sh

/opt/zookeeper-3.4.5/bin/zkServer.sh

/opt/spark-2.2.0-bin-hadoop2.6

/opt/spark-2.2.0-bin-hadoop2.6/sbin/start-all.sh

/opt/spark-2.2.0-bin-hadoop2.6/sbin/start-

master.sh

/opt/spark-2.2.0-bin-hadoop2.6/sbin/start-

slaves.sh

/opt/apache-flume-1.5.0-bin

/opt/apache-flume-1.5.0-bin/bin/flume-ng

说是 Namenode 和 ResourceManger 如果不是同一台机器,不能在 NameNode 上启动 yarn,应

该在 ResouceManager 所在的机器上启动 yarn。现在问题解决了,多谢提醒.

如果你的 Hadoop 的 NameNode 和 Yarn 的 ResourceManager 不是部署在同一个节点上,那么你

的 resourcemanager 需要单独登录到对应的 yarn 的 resourcemanager 节点上启动。在

namenode 所在的节点,通过$HADOOP_HOME/sbin/start-yarn.sh 是启动不了的。但是 yarn 的

nodemanager 可以通过上述的节点启动。

Flume 安装配置:

http://www.aboutyun.com/forum.php?mod=viewthread&tid=8917

hadoop(2.x)以 hadoop2.2 为例完全分布式最新高可靠安装文档

http://www.aboutyun.com/thread-7684-1-1.html

http://www.aboutyun.com/

about 云日志分析项目准备 6:Hadoop、Spark 集群搭建

http://www.aboutyun.com/forum.php?mod=viewthread&tid=20620

评论0

最新资源