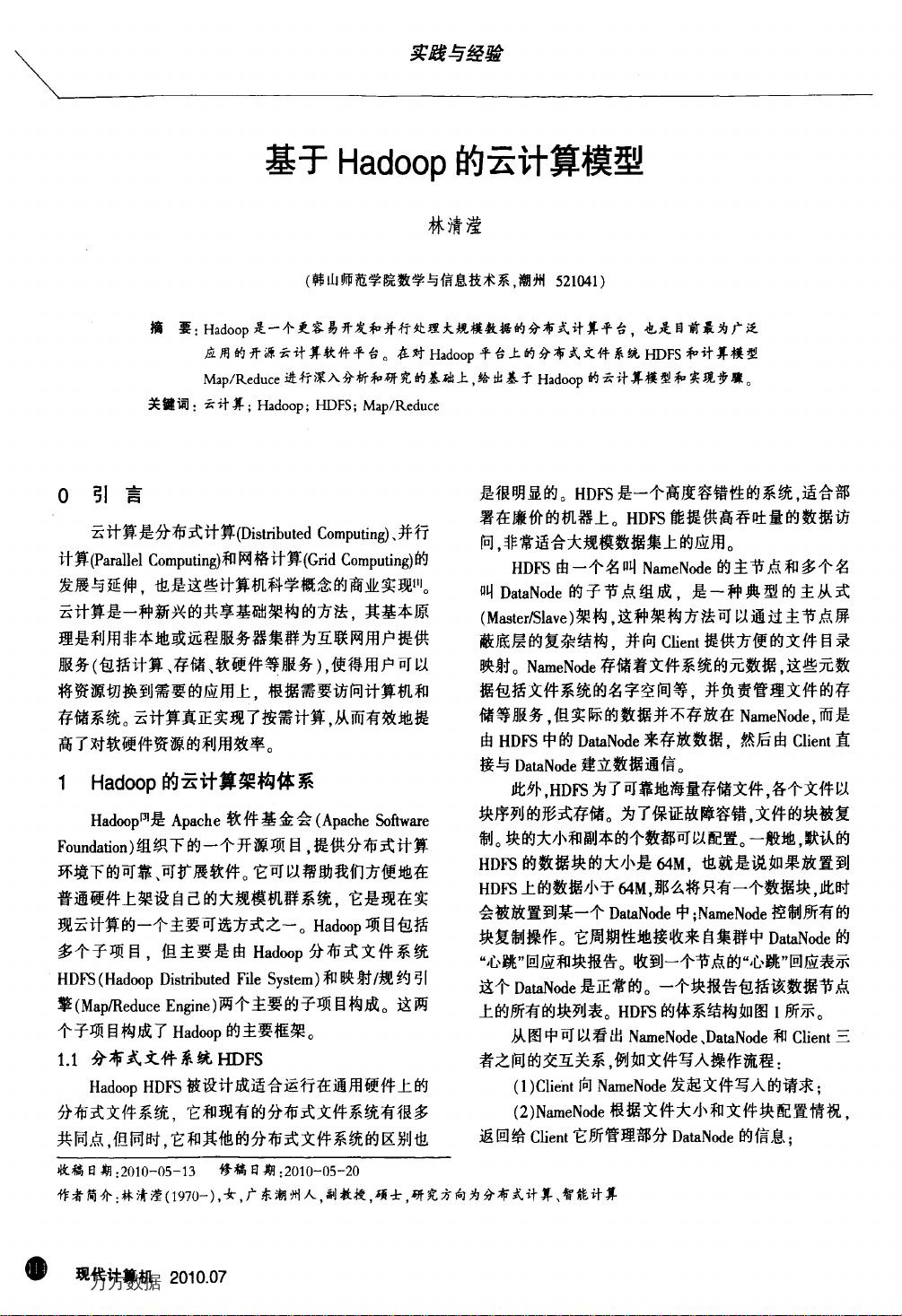

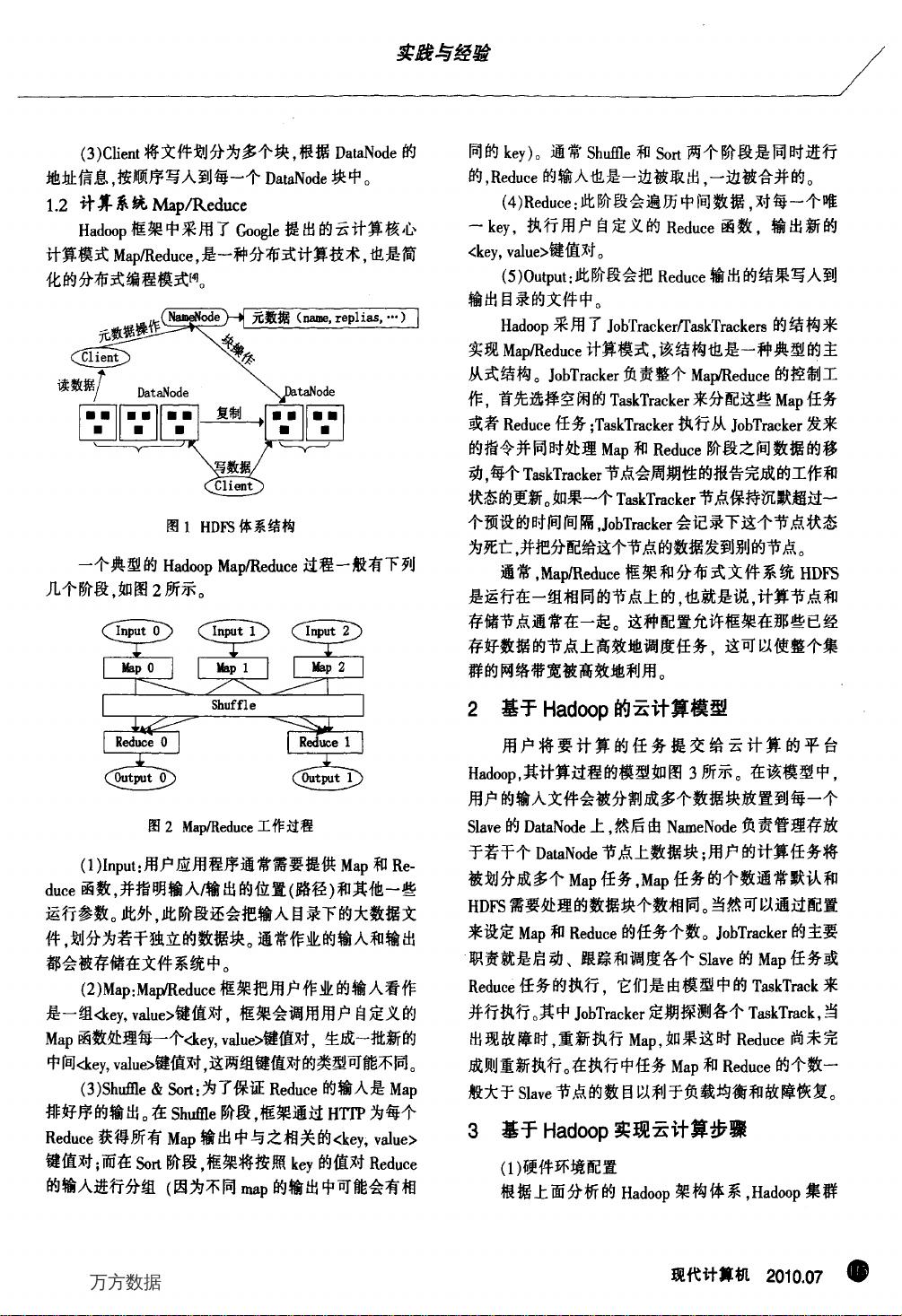

### 基于Hadoop的云计算模型 #### 引言 随着互联网的飞速发展以及大数据时代的到来,处理和存储海量数据的需求日益增加。Hadoop作为一个开源的分布式计算平台,因其能够有效支持大规模数据的开发与并行处理,成为了当前广泛应用的云计算软件平台之一。本文通过对Hadoop平台上的两大核心技术——分布式文件系统HDFS(Hadoop Distributed File System)和计算模型Map/Reduce进行了深入的分析和研究,进而阐述了基于Hadoop的云计算模型及其实施步骤。 #### Hadoop的云计算架构体系 ##### 分布式文件系统HDFS Hadoop分布式文件系统(HDFS)被设计用于运行在通用硬件之上,其目的是解决大规模数据集的存储问题。HDFS是一个高度容错的文件系统,适合部署在成本较低的硬件设备上,并且能够提供高吞吐量的数据访问能力,这对于大规模数据集的应用场景尤为重要。 HDFS采用了一种主从架构(Master/Slave),主要包括一个名为NameNode的主节点和多个名为DataNode的子节点。其中,NameNode主要负责存储文件系统的元数据,包括文件系统的名字空间、文件与块的映射关系等,并管理文件的存储等服务。而实际的数据则存储在DataNode中,客户端可以直接与DataNode进行数据通信。 为了保证数据的可靠性和容错性,HDFS采用了数据块复制机制。每个文件被分割成若干个数据块(默认大小为64MB),并且这些块会在多个DataNode之间进行复制。NameNode会定期接收来自DataNode的心跳信号和块报告,以监控整个集群的健康状态。 ##### 计算系统Map/Reduce Hadoop框架中采用了Google提出的Map/Reduce计算模式,这是一种分布式计算技术,主要用于处理非常大的数据集。Map/Reduce提供了简化版本的分布式编程接口,允许开发者专注于编写业务逻辑,而无需关心底层的分布式细节。 Map/Reduce的工作流程可以分为以下几个步骤: 1. **Input**:用户应用程序需要提供Map和Reduce函数。输入数据会被分成多个片段,每个片段由一个Map任务处理。 2. **Map**:Map函数会对输入的数据进行处理,生成键值对形式的中间结果。每个Map任务独立执行,处理一个数据片段。 3. **Shuffle**:此阶段会将所有Map任务产生的中间结果按照键进行排序和分组,准备传递给Reduce阶段。 4. **Reduce**:Reduce函数接收来自Map阶段相同键的所有值,并对它们进行合并处理,生成最终的输出结果。 #### 实现步骤 构建基于Hadoop的云计算模型主要包括以下几个步骤: 1. **部署Hadoop集群**:首先需要搭建Hadoop集群,这包括安装Hadoop软件、配置Hadoop环境变量等。集群至少包含一个NameNode和多个DataNode。 2. **配置HDFS**:配置HDFS的相关参数,如块大小、副本数量等,以满足特定的应用需求。 3. **编写Map/Reduce程序**:根据具体的业务逻辑编写Map和Reduce函数,实现数据的处理和分析。 4. **提交作业**:通过Hadoop命令或API提交Map/Reduce作业,让集群执行相应的计算任务。 5. **监控和维护**:在作业执行过程中,需要对集群的状态进行监控,确保所有任务都能顺利完成,并及时处理可能出现的问题。 通过上述步骤,可以在Hadoop平台上构建出高效的云计算模型,实现对大规模数据的高效存储和处理。随着技术的不断进步和发展,Hadoop及其相关的生态系统将继续优化和完善,更好地满足未来的大数据处理需求。

剩余6页未读,继续阅读

- 粉丝: 0

- 资源: 4

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 基于Simulink的考虑局部遮阴的光伏PSO-MPPT控制模型.rar

- 基于Simulink的最大功率点追踪MPPT功能的单相单级脉宽调制(PWM)光伏逆变器,并且支持并网运行.rar

- 基于TCN-GRU的自行车租赁数量预测研究Matlab代码.rar

- 基于TCN-GRU-Attention的自行车租赁数量预测研究Matlab代码.rar

- 基于WoodandBerry1和非耦合控制WoodandBerry2来实现控制木材和浆果蒸馏柱控制Simulink仿真.rar

- 基于变分多谐波对偶模式追踪从噪声信号中提取重复瞬态分量的方法附Matlab代码.rar

- 基于Python的智能门禁打卡系统设计与开发-含详细代码及解释

- 数电课件,数字电路与逻辑

- A Neural Probabilistic Language Model.pdf

- 基于Java的学生信息管理系统实现

- OpenCV人脸检测和识别

- 管理工具PKIManager-1.1.3.6-全算法版本-信创

- ACM程序设计经典题目与解决方案(C语言实现)

- 详细的Visual Studio安装教程及注意事项

- 手机侧面轮廓尺寸检测机3D图纸和工程图机械结构设计图纸和其它技术资料和技术方案非常好100%好用.zip

- GitHub教程:账号注册、项目创建与协同开发详解

信息提交成功

信息提交成功